Le Kookaburra est un oiseau important dans certaines sociétés aborigènes d’Australie, car c’est lui qui a réveillé les hommes pour contempler le premier lever de soleil. C’est en clin d’œil à cette légende qu’IBM a nommé le processeur quantique qu’il devrait dévoiler en 2025. Une puce de plus de 4000 qbits qui devrait « éveiller » les hommes à l’avènement du premier superordinateur quantique.

Lire aussi : IBM tient sa promesse et annonce Eagle, son processeur de 127 qubits (2021)

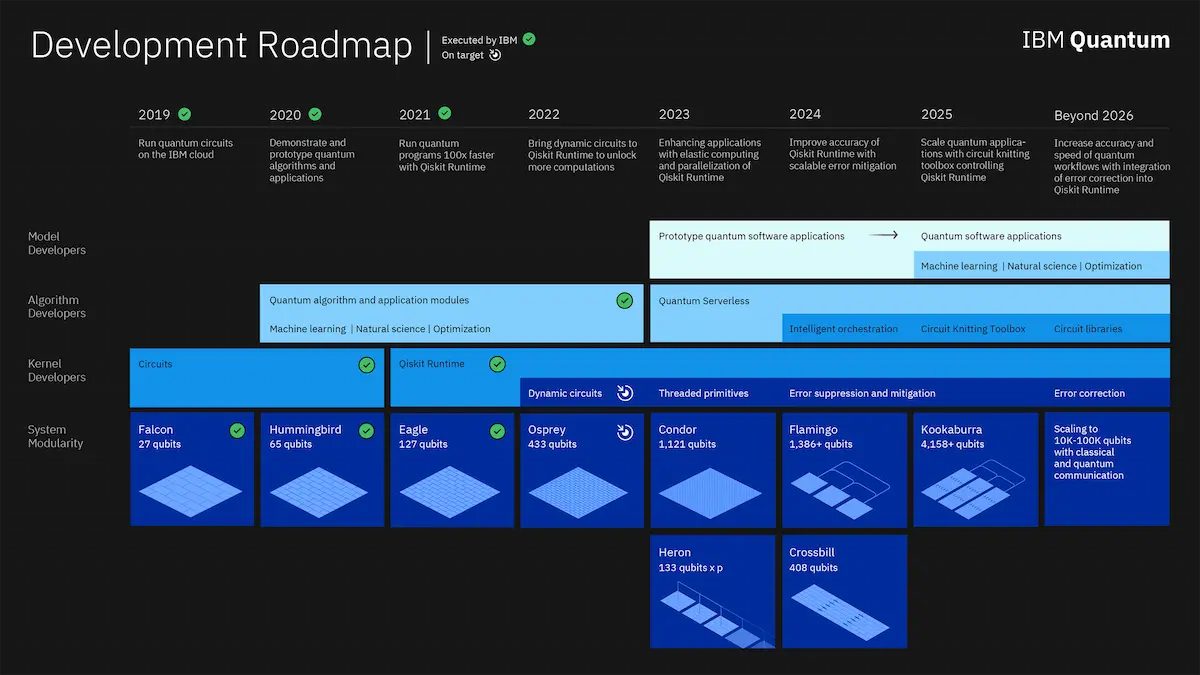

IBM vient en effet de mettre à jour sa feuille de route quantique – qui est de loin la plus précise du marché. L’Américain, qui a déjà remporté le premier contrat de vente d’ordinateur quantique en 2021 au profit de l’institut Fraunhoffer (Allemagne) avance ses pions à une cadence infernale.

Après avoir dévoilé Eagle l’an dernier (127 qbits), le géant informatique ne s’arrête pas. Cette année, ce sera le processeur Osprey (433 qbits). Puis Condor en 2023 (1121 qbits), Flamingo en 2024 (1386 qbits) pour arriver à Kookaburra en 2025 – avec 4158 qbits.

Ce qui est intéressant dans cette progression, c’est le détail de la montée en puissance. IBM ne va pas concevoir des puces plus performantes en partant de zéro à chaque fois. Non, Flamingo comme Kookaburra sont des « systèmes » quantiques composées de trois puces communiquant entre elles, un peu à la manière de nos puces multicœurs (mais en quantique).

Le système quantique « Flamingo » de 1 386 qbits sera ainsi composé de trois puces Flamingo de 462 qbits chacune capable d’échanger via un lien de communication intégré.

Même approche pour le système « Kookaburra » qui sera en réalité composé de trois puces Kookaburra de 1 386 qbits.

En clair, dans sa feuille de route, IBM considère Osprey comme la limite de la conception de puce monolithique avant de basculer vers un système d’agrégation de puces. Oui, IBM a vraiment trouvé le moyen de paralléliser la puissance de ses puces quantiques…

Une révolution dans les supercalculateurs ?

Avec cette parallélisation de puces quantiques – qui requiert une communication entre les puces en temps réel, la conception de systèmes multipuces et la parallélisation quantique nécessaire aux calculs, ce qui n’est rien ! – IBM prévoir non seulement une explosion de la puissance théorique… mais surtout son exploitation.

Lire aussi : Comment IBM devrait ouvrir la voie révolutionnaire de l’avantage quantique dès 2023 (2022)

Et l’informatique quantique étant ce qu’elle est – avec ses forces et ses faiblesses – on ne pourra pas se passer des CPUs et des GPUs. IBM prévoit donc, dès 2025, de combiner toutes ces ressources connues (et maîtrisées !) à ses QPUs (quantum processing units). L’object ? Produire une nouvelle génération de supercalculateurs, hybrides, quantiques. Des machines dont l’arrivée devrait, selon IBM, avoir la même magnitude d’impact que lorsque l’on a « remplacé les cartes en papier par les satellites GPS ».

Sans software, le hardware n’est rien

L’interconnexion et la parallélisation de puces quantiques – et ça semble déjà incroyablement difficile – mais ce n’est qu’une des briques de la révolution quantique (et de la feuille de route d’IBM). L’autre pan important est à chercher du côté du logiciel. Car pour que ces machines se popularisent, il faut pouvoir les exploiter. L’ambition d’IBM est de rendre leur programmation transparente pour les non-physiciens – autrement dit, les développeurs « normaux ».

Voilà pourquoi IBM développe en parallèle depuis des années des outils logiciels, notamment son environnement Qiskit. Un programme gratuit, qui permet de développer du code de manière classique et de le voir « traduit » automatiquement en langage quantique.

L’outil étant assez mature, IBM va lui ajouter dès 2023 le multitâche (les threads) afin de coller à la parallélisation du développement matériel (de plusieurs puces).

Lire aussi : Ces chercheurs ont conçu une puce quantique incroyablement fiable et moins coûteuse à fabriquer (2022)

Puis viendra la suppression des erreurs, inévitables quand un système travaille sous forme de probabilités comme les puces quantiques. Pour arriver, au-delà de 2026, à des systèmes quantiques de plus de 10 000 qbits. Ils seront alors non seulement suffisamment puissants pour faire la différence théorique dans certaines applications, mais bénéficieront surtout de librairies et d’outils logiciels plus matures, particulièrement dans les domaines de l’apprentissage machine, des sciences naturelles ou des problèmes d’optimisation.

IBM devant tout le monde ?

Une fois encore, aucun membre de la rédaction de 01net.com n’est un physicien spécialiste des particules quantiques et il est très difficile de juger de la pertinence du modèle d’IBM (qbits à supraconducteurs) sur la seule foi de ses publications. Mais on peut discerner, dans le fond et la forme de sa communication, que l’Américain a les reins solides.

Outre le fait qu’il soit l’unique acteur à publier une telle feuille de route, il a pour l’heure toujours livré ses puces et ses briques logicielles en temps et en heure. Personne d’autre dans l’industrie ne semble avoir trouvé la martingale de la montée en puissance par la parallélisation ni ne s’engage aussi clairement à livrer des systèmes à plus de 10 000 qbits à l’horizon 2026.

À découvrir aussi en vidéo :

Si IBM fournit effectivement ses systèmes avec la régularité métronomique à laquelle il nous a habitué ces dernières années, l’Américain pourrait réitérer sa domination passée du monde de l’informatique classique dans celle du quantique…

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.