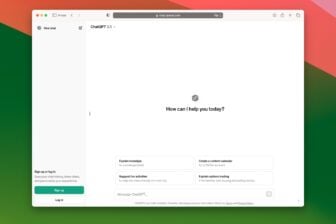

Il y a quelques jours, Rob Morris, fondateur de Koko, une plate-forme en ligne conçue pour venir en aide aux individus souffrant de problèmes de santé mentale, a fait une révélation étonnante. Le dirigeant révèle avoir utilisé ChatGPT, l’intelligence artificielle d’OpenAI, pour fournir « un soutien en santé mentale à environ 4 000 personnes ».

We provided mental health support to about 4,000 people — using GPT-3. Here’s what happened 👇

— Rob Morris (@RobertRMorris) January 6, 2023

Conçu en 2015, Koko permet à des utilisateurs lambda d’offrir une assistance psychologique aux personnes avec des troubles dépressifs. Ces bénévoles sont mis en relation à l’aide d’un chatbot rudimentaire par le biais d’un serveur Discord, Koko Cares. Après avoir répondu à une série de questions basiques, une personne en difficulté peut échanger avec un bénévole. Celui-ci offre alors gratuitement un accompagnement sur mesure.

À lire aussi : N’installez pas cette fausse application ChatGPT sur iPhone, c’est une arnaque

L’empathie « bizarre » deChatGPT

Dans le cadre de l’expérimentation, Koko a proposé à ses bénévoles de se servir des réponses générées par ChatGPT pour dialoguer avec les usagers. L’utilisation de l’intelligence artificielle était purement optionnelle. Si la réponse de ChatGPT était jugée mal adaptée, le bénévole prenait le relais. Pour le test, le chatbot a été intégré directement dans le serveur Discord de la start-up.

« Nous avons utilisé une approche “copilote”, avec des humains supervisant l’IA au besoin. Nous l’avons fait sur environ 30 000 messages », précise Rob Morris.

Dans un premier temps, l’expérimentation a donné des résultats encourageants. D’après Rob Morris, les messages rédigés par ChatGPT ont été plus appréciés que les textes écrits par les bénévoles eux-mêmes :

« Les messages composés par l’IA (et supervisés par des humains) ont été évalués nettement plus mieux que ceux écrits par les humains seuls ».

Cerise sur le gâteau, l’intégration de ChatGPT au Discord de Koko a permis de réduire le temps de réponse de moitié, ce qui est indispensable dans les cas les plus urgents. Malheureusement, les résultats ont complètement changé dès que « les gens ont appris que les messages ont été cocréés par une machine ». Une fois que l’utilisation de l’intelligence artificielle a été éventée, « l’empathie simulée semblait bizarre, vide ». C’est pourquoi Koko a préféré désactiver ChatGPT.

« Les machines n’ont pas d’expérience humaine vécue, alors quand elles disent “ça a l’air dur” ou “je comprends”, cela semble inauthentique. […] Ils ne prennent pas le temps de leur journée pour penser à vous. Une réponse de chatbot générée en 3 secondes, aussi élégante soit-elle, semble en quelque sorte bon marché », explique le fondateur de Koko, diplômé en psychologie de l’université de Princeton et ancien chercheur au MIT Media Lab.

ChatGPT se retrouve au cœur d’une controverse

L’annonce de Morris a rapidement provoqué une controverse. Sur Twitter, les internautes estiment que Koko aurait dû informer ses utilisateurs de ce programme d’expérimentation. C’est notamment l’avis de plusieurs juristes et spécialistes de l’éthique, qui rappellent que les États-Unis surveillent de près ces pratiques. Il est en effet interdit de mener des recherches sur des sujets humains sans avoir obtenu un consentement explicite sur le sol américain. La loi prévoit qu’un document juridique soit signé par tous les participants d’un programme de recherche.

En réponse au thread Twitter, Daniel Shoskes, l’ancien président comité d’éthique de la recherche des États-Unis, l’Institutional Review Board (IRB), recommande même à Morris de prendre contact avec un avocat :

« vous avez mené des recherches sur des sujets humains sur une population vulnérable sans l’approbation ou l’exemption de l’IRB (VOUS ne pouvez pas décider seul) ».

Outre l’aspect légal, certains experts pointent du doigt la dangerosité de l’expérimentation. Interrogée par Vice, Emily M. Bender, professeur de linguistique à l’Université de Washington, estime que les risques de « suggestions nuisibles » dans le cadre des situations les plus explosives sont bien réels :

« Les modèles linguistiques n’ont pas d’empathie, ni aucune compréhension du langage qu’ils produisent, ni aucune compréhension de la situation dans laquelle ils se trouvent. Mais le texte qu’ils produisent semble plausible et les gens sont donc susceptibles d’y attribuer un sens ».

De plus, l’utilisation de ChatGPT pourrait contrevenir aux promesses explicites formulées par Koko dans ses conditions d’utilisation. Sur son Discord, l’organisme assure en effet que l’internaute est mis en contact avec « de vraies personnes qui vous comprennent vraiment », qui ne sont pas « des thérapeutes, pas des conseillers, juste des gens comme vous ».

Pour se défendre, Rob Morris précise que les utilisateurs de Koko Cares n’étaient jamais mis en relation avec ChatGPT. Comme promis, l’internaute qui recherche de l’aide pouvait dialoguer avec un être humain. Par contre, les réponses de celui-ci étaient potentiellement générées par l’intelligence artificielle. Dans ce cadre, ChatGPT servait plutôt d’assistant aux bénévoles afin d’améliorer leur efficacité. Le fondateur de Koko ajoute que la start-up n’était pas tenue de se plier aux règles en vigueur en matière de recherche, arguant qu’aucune donnée personnelle n’a été exploitée et que la publication des résultats n’est pas prévue.

Notez que Koko n’est pas un novice en matière d’intelligence artificielle. Depuis ses débuts, la plate-forme utilise l’IA pour s’organiser et catégoriser les différents types d’utilisateurs en quête de soutien. Koko s’appuie notamment sur l’apprentissage automatique pour identifier les individus à risque. Koko met alors en place des ressources adaptées en fonction de la détresse perçue par l’IA.

C’est uniquement grâce à l’intelligence artificielle que la start-up est parvenue à tirer son épingle du jeu et à obtenir des financements. En 2016, Fraser Kelton, cofondateur de Koko, expliquait d’ailleurs que Koko Cares était conçu pour associer « l’intelligence collective à l’intelligence artificielle pour améliorer le bien-être émotionnel des gens ». Au vu de ses objectifs initiaux, on ne s’étonnera pas que Koko se soit promptement penché sur l’intégration de ChatGPT à sa plate-forme.

Ces derniers mois, les intelligences artificielles génératives ont suscité un engouement colossal, aussi bien du côté des géants de la tech, des utilisateurs lambda et des cybercriminels. La révolution menée par ChatGPT mène par ailleurs la vie dure aux enseignants et aux professeurs, confrontés à une explosion de devoirs rédigés par IA.

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.

Source : Vice

Les dindons déprimés ont trouvés que les réponses étaient mauvaises SEULEMENT après qu’on leur ai dis que ca venait d’un bot.

De la a penser qu’ils sont complètement cons, il n’y a qu’un octet.

Si on s’intéresse au niveau moyen d’intelligence déployé sur les réseaux (a)-sociaux, on peut imaginer que l’intelligence artificielle ne soit pas larguée.