La planète tech n’a presque plus que ce mot à la bouche : « métavers ». Au point d’ailleurs que Facebook est devenu Meta pour montrer à quel point la société de Mark Zuckerberg était sérieuse au sujet de cet univers virtuel qui nous promet monts et merveilles.

Quoi qu’il en soit, il y a évidemment d’autres acteurs de la tech qui misent beaucoup sur le métavers. Nvidia en fait partie fort logiquement, puisque la société de Jensen Huang produit des cartes graphiques, est en pointe sur la 3D, et travaille depuis un petit moment sur un outil dédié. Baptisé Omniverse, il est pour l’instant surtout destiné aux professionnels, mais le grand public n’est bien sûr pas exclu, comme l’ont rappelé différents porte-parole de l’entreprise en amont de la conférence d’ouverture de la GTC la semaine dernière.

Peupler, croître et multiplier…

Au vu des enjeux pour Nvidia, il n’est pas étonnant de voir la société de Santa Clara investir lourdement dans le domaine. Et le fruit de ses investissements a pris récemment une tournure impressionnante qui pourrait grandement faciliter l’immersion des utilisateurs dans ce futur monde virtuel.

Pour qui a fréquenté un MMORPG ou même Second Life, il est évident qu’un des grands enjeux des univers virtuels est la présence de personnages, d’animaux, et parfois même tout simplement d’une grande variété d’objets inanimés. Or, la modélisation d’objets 3D est coûteuse et chronophage.

Voilà sans doute pourquoi les ingénieurs du Nvidia Research se sont attelés à une tâche simple en apparence, mais complexe en réalité : développer une intelligence artificielle capable de « peupler les mondes virtuels avec des objets 3D et des personnages ».

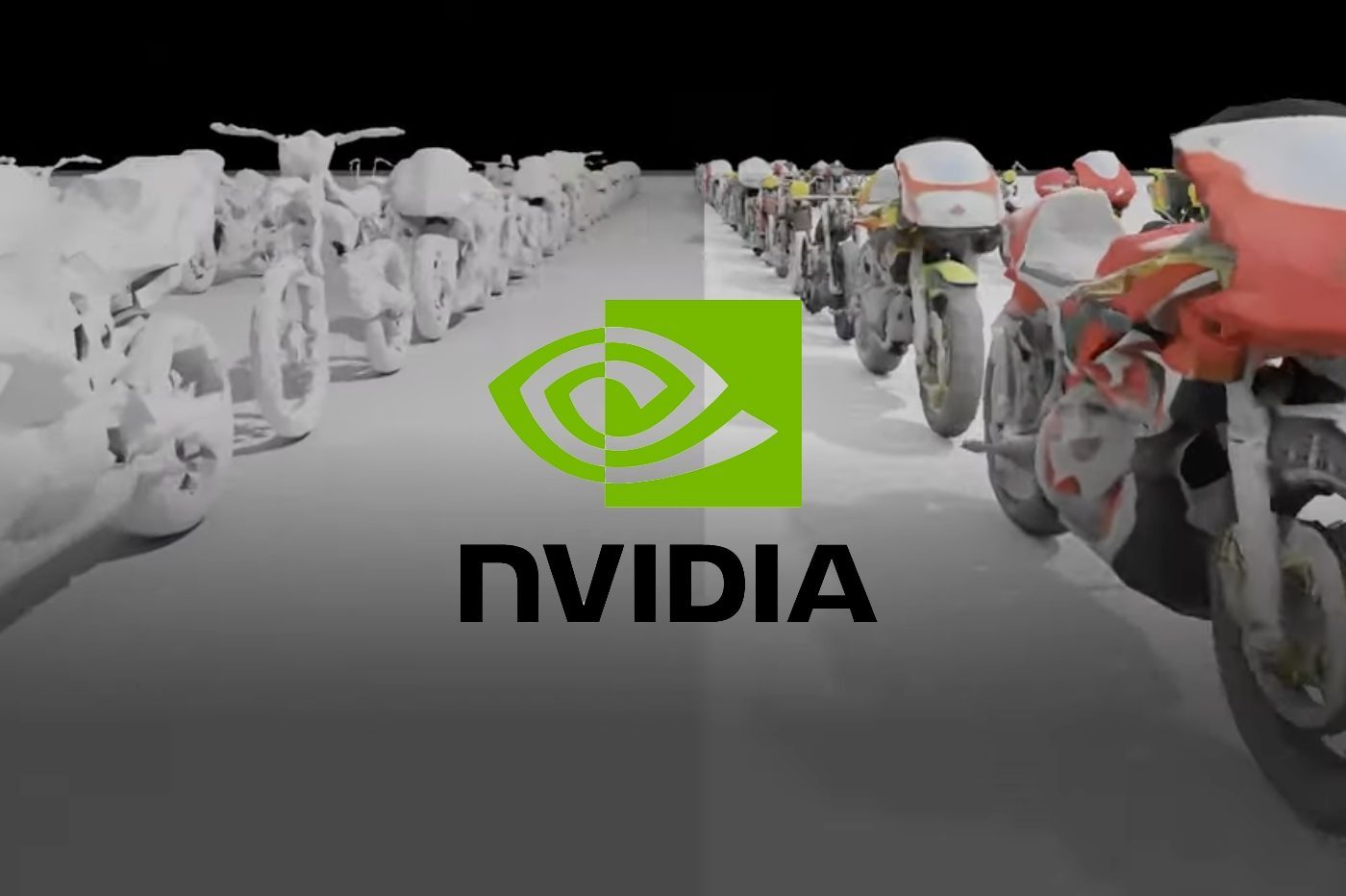

Pour cela, ils ont créé GET3D : c’est le nom de l’IA et elle la tient de sa capacité à générer des maillages en 3D texturés – Generate Explicite Textured 3D. Elle est capable de produire des rendus 3D qui pourront être utilisés directement par des moteurs 3D. Mieux encore, contrairement aux modèles précédemment développés pour ce genre de tâche, GET3D réussit à produire des éléments 3D détaillés géométriquement, tout cela en produisant des textures de haute qualité.

Le plus impressionnant est que les réseaux antagonistes génératifs (GAN) utilisés sont capables d’aboutir à ces résultats à partir de simples images de synthèse. Autrement dit, l’IA est capable à partir d’un cliché en deux dimensions de produire des objets en 3D. Cela fonctionne aussi bien avec une chaise qu’une maison, ou un chien. Habituellement, les IA avaient besoin de photos d’un objet sous plusieurs angles pour être ensuite capables de produire un rendu en 3D. Ce qui prenait davantage de temps et limitait le potentiel de ce genre d’outil.

Mais avec GET3D cette limitation semble être de l’histoire ancienne. Mieux, plus l’ensemble de données utilisé pour entraîner le réseau neuronal est varié (par exemple des photos de nombreuses races de chiens), plus il sera capable de produire des résultats 3D différents. Ainsi, s’il est entraîné avec des images de voitures, il pourra produire des rendus 3D pour des limousines, des berlines, des pickups, etc.

Selon Nvidia, GET3D est capable de générer jusqu’à 20 formes par seconde en utilisant un seul GPU Nvidia. Il fonctionne alors « comme s’il était un réseau antagoniste génératif pour des images 2D, alors qu’il génère des objets 3D », explique l’entreprise dans un billet de blog. De même, la société de Santa Clara souligne qu’il n’a fallu que deux jours et un million d’images pour entraîner l’algorithme.

Et Nvidia voit grand et loin. Il veut que son GET3D soit capable de s’inscrire dans une chaîne de production de contenus 3D. Ainsi, les modèles créés par cet IA peuvent être importés dans un outil d’édition de fichiers 3D et peuvent ensuite être modifiés facilement, de la forme aux textures proposées.

Il est également possible d’exporter le fichier et d’y appliquer des effets de lumière réalistes, de façon à ce que l’objet paraisse plus vrai que nature quand une caméra tourne autour de lui, par exemple.

Il est possible d’aller encore plus loin, et en utilisant un autre outil développé par Nvidia Research, appelé StyleGAN-NADA. À partir de mots-clés, un graphiste pourra alors modifier l’apparence de l’objet. Par exemple, faire en sorte qu’un rendu de voiture en 3D devienne un taxi ou une épave brûlée.

À court terme…

Dans un futur plus ou moins proche, les chercheurs qui ont mis au point GET3D pensent qu’il sera possible de l’utiliser directement avec de véritables clichés. Cela signifie que l’IA sera capable d’extrapoler les informations de prise de vue pour déterminer la forme en 3D de l’objet photographié.

Mieux encore, alors que pour l’instant, GET3D doit être entraîné pour chaque type d’objets ou d’animaux séparément, il pourrait bientôt être possible de lui soumettre en même temps des photos de voitures, chiens, chats, humains, bateaux, etc. Tout cela sera ingéré à la fois et l’IA pourra ensuite produire des objets issus de chaque catégorie. Une fois encore, un véritable gain de temps, et la possibilité de peupler encore plus rapidement des univers virtuels.

Demain, nos visites dans le métavers seront donc plus réalistes, ou en tout cas plus emplies de la multitude de petites choses qui nous entourent et font notre quotidien. Vous pourrez entrer dans une pièce décorée comme une vraie. Ce pourra même être la « jumelle numérique » de votre appartement, mais avec le lit à baldaquin de vos rêves… Et vous voulez savoir la meilleure ? Puisque vous n’aurez toujours pas de jambe dans le métavers, il sera impossible de vous cogner le gros orteil contre le pied de lit en vous levant le matin. Quand on vous dit que le métavers, c’est l’avenir..

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.

Source : Blog de Nvidia