La photographie est une discipline soumise aux strictes lois de la physique qui imposent de nombreuses limites – taille des optiques, etc. Ce sont ces limites que les géants de l’informatique comme Nvidia veulent faire voler en éclat avec la puissance des processeurs et des algorithmes. Une équipe de chercheurs de Nvidia, en partenariat avec l’université de Santa Barbara en Californie (UCSB), s’est attaquée aux problèmes de perspective et de distance focale.

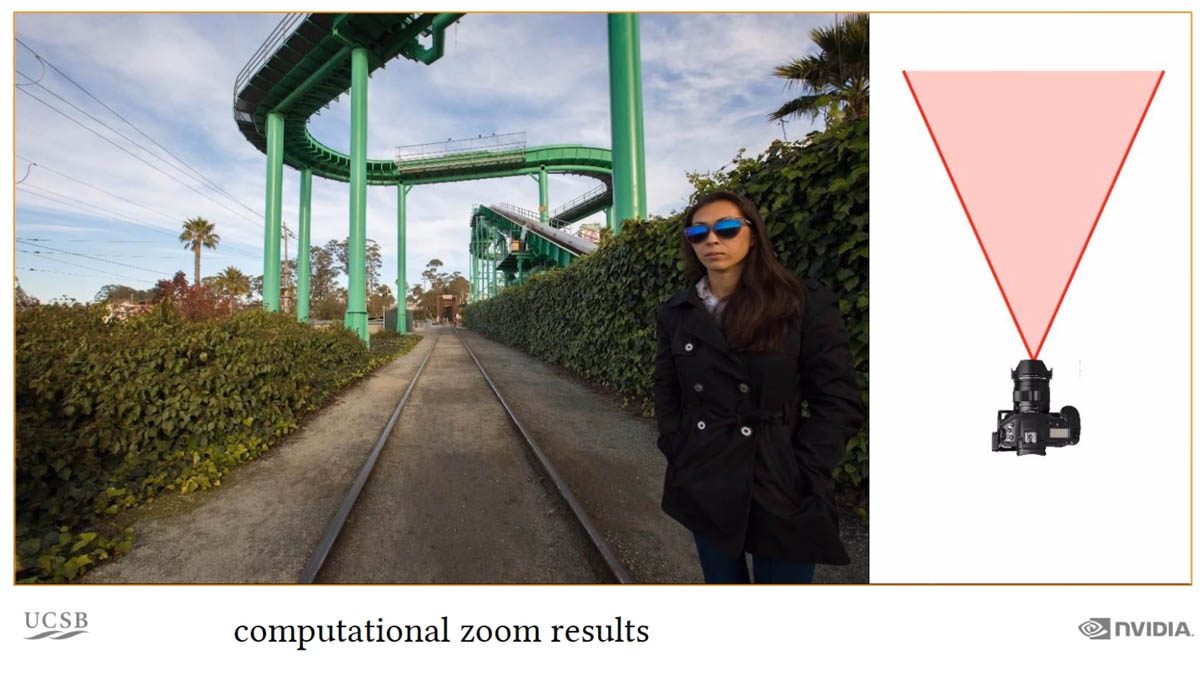

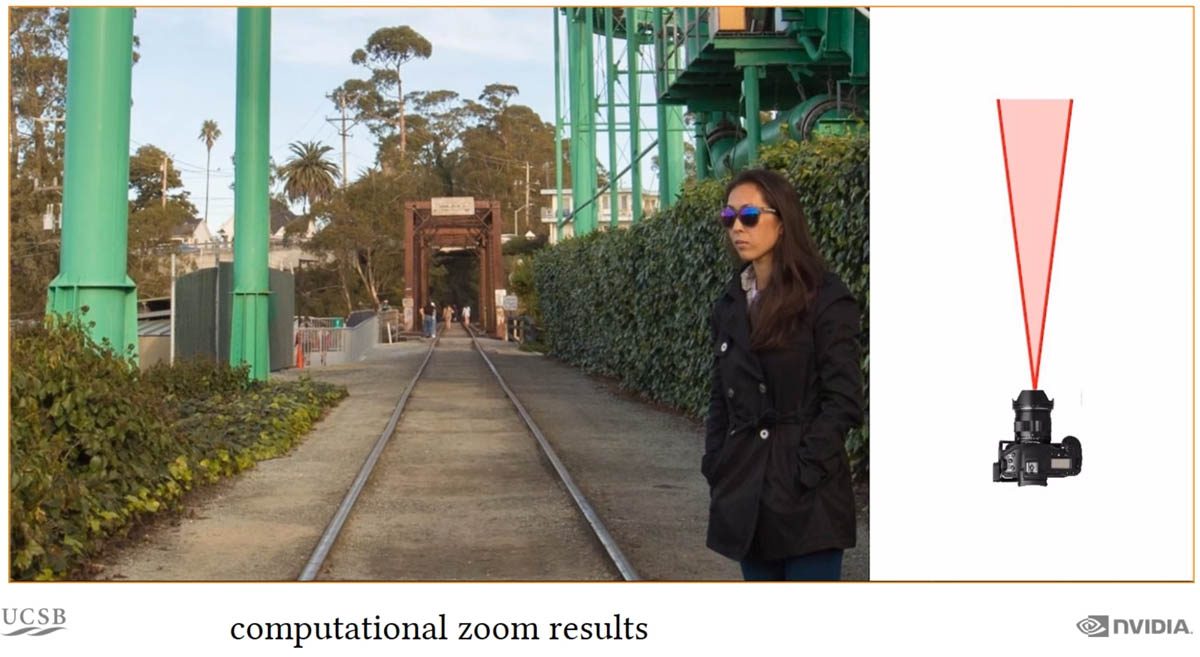

Lors de la prise de vue, la distance entre les sujets -c’est-à-dire la perspective- dépend de la focale (la couverture angulaire) choisie. Comme le montre très bien la vidéo de présentation de leur article scientifique, pour un sujet donné capturé à taille constante, un ultra grand angle capture plus d’informations mais éloigne l’arrière-plan et déforme le sujet. A contrario, un petit téléobjectif capture moins d’éléments de la scène mais préserve l’aspect naturel des perspectives et met en valeur l’arrière-plan.

Combinaison d’image et calcul de la profondeur

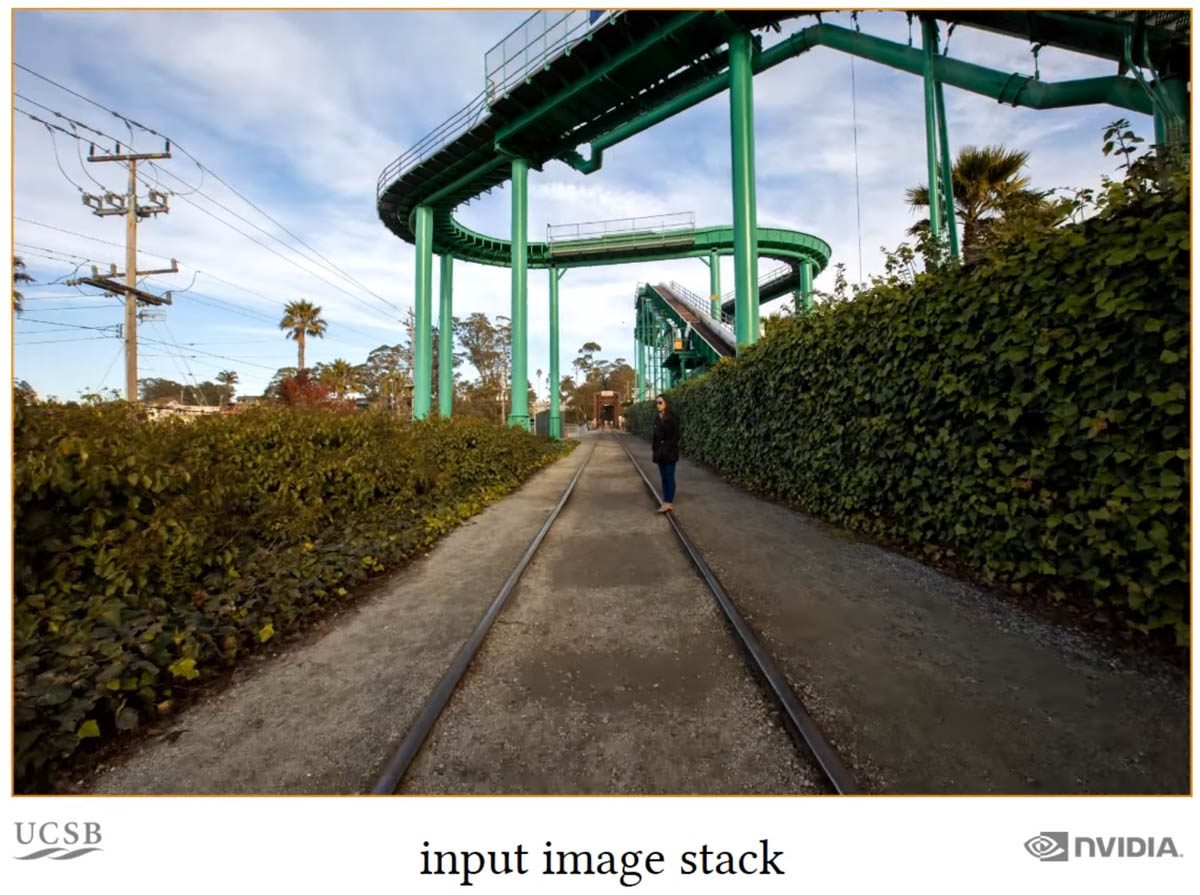

Le « zoom calculé » (computational zoom) est un système qui se base, comme souvent dans la photographie basée sur le calcul, sur une série de clichés. Mais il ne s’agit pas ici de combiner des images capturées au même endroit pour améliorer la définition, simuler un flou ou limiter le bruit numérique : le photographe doit bouger vers son sujet pendant que l’appareil capture une séquence d’image fixes pour calculer des distances.

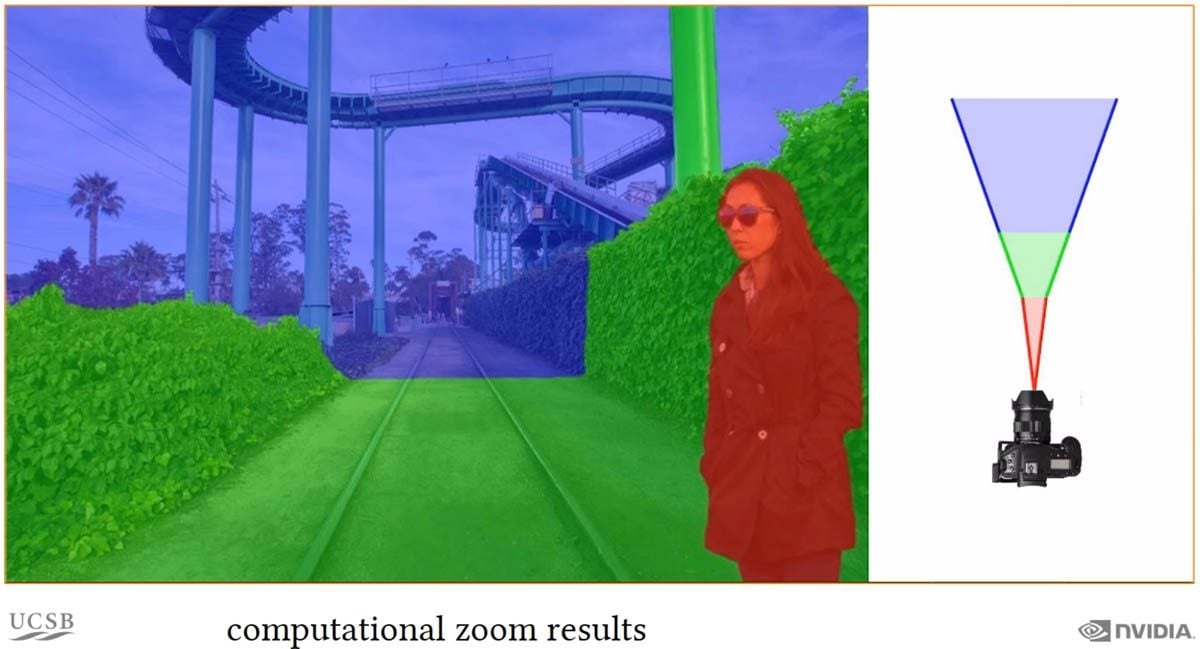

De cette séquence, les algorithmes vont récupérer une grande quantité d’informations, notamment la profondeur qui est établie par le calcul de variation de distance des points entre les différentes images. En moulinant ces données, le logiciel de Nvidia découpe intelligemment l’image et permet, comme le montre la vidéo et nos captures d’écran, de faire varier à postériori, la distance entre les plans.

Ainsi, on peut conserver l’orthogonalité d’un premier plan – aspect naturel – tout en la combinant avec un plan moyen très large – quantité d’information et champ de vision large – et en rapprochant un élément de l’arrière-plan. L’image finale est une image à l’aspect « réaliste » selon les chercheurs mais impossible à reproduire avec des optiques soumises aux lois de la physique.

Des progrès techniques, des défis éthiques

Ces technologies sont pour l’heure des expériences « de laboratoire » mais la puissance sans cesse grandissante des puces, couplée à la soif d’améliorations photographiques dans le segment des smartphones rend inéluctable l’arrivée des technologies de « compute photography », seules à même de dépasser les limites physico-techniques.

Mais si ces progrès seront célébrés par le grand public, les techniques d’amélioration d’image – « d’invention » d’image pourrait-on dire – vont soulever des problèmes, notamment dans le photojournalisme : avec Photoshop, il est déjà difficile de garantir l’authenticité des images, comment va-t-on faire quand le Jpeg original de l’appareil photo sera déjà manipulé par le processeur ?

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.