La nouvelle génération d’iPhone embrasse pleinement la « computational photography ». Littéralement « photographie calculée », il s’agit d’une évolution de la photo classique où le processeur central (CPU) joue un rôle encore plus important que les composants traditionnels que sont l’optique ou le capteur. Les promesses photo d’Apple reposent en effet moins sur la puissance et la qualité pure de ces derniers mais sur la grande puissance du CPU et du processeur neuronal du (théoriquement) très puissant SoC A12 Bionic.

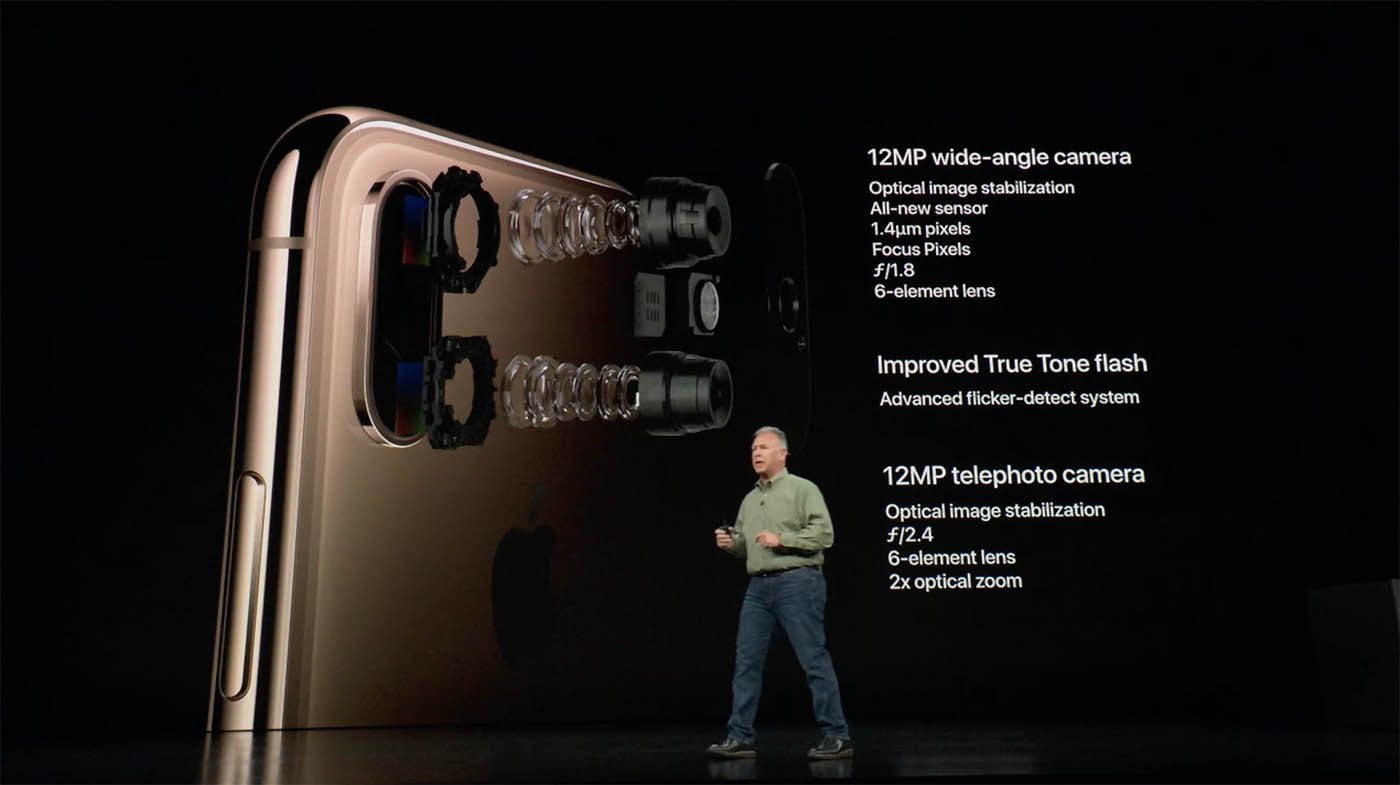

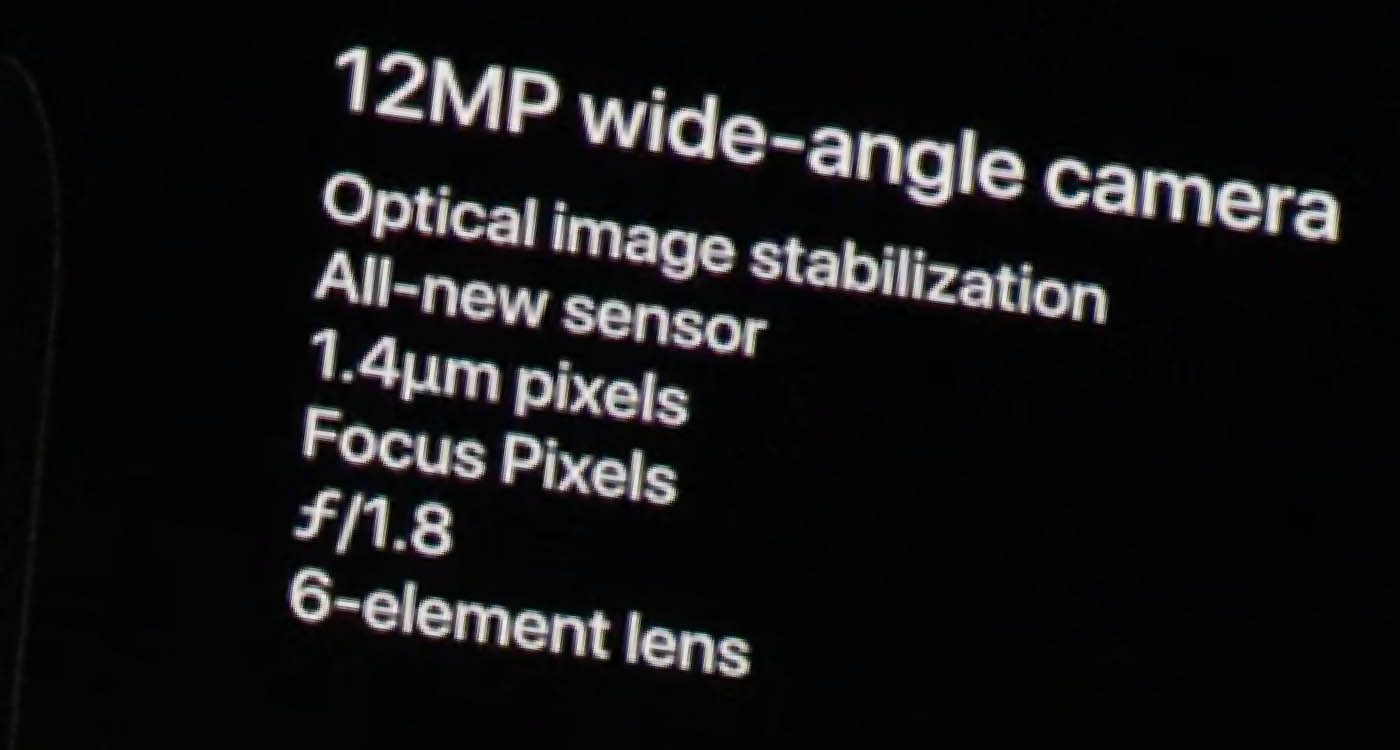

Les iPhone XS et XS Max ont, de prime abord, une partition photographique similaire à l’iPhone X : deux modules caméra de 12 Mpix, le premier étant le traditionnel grand angle (sans doute l’équivalent 28 mm f/1.8) et le second un téléobjectif offrant le classique zoom x2 que l’on retrouve sur les iPhone haut de gamme depuis l’iPhone 7 Plus (sans doute l’équivalent 56 mm f/2.8 de la génération précédente).

Côté construction optique, on retrouve la stabilisation optique (lentille flottante) et des constructions en 6 lentilles – les formules ont peut-être évolué, mais Apple ne communiquant jamais ses formules optiques précises, c’est difficile à dire. Les focales fixes ont la même ouverture que celles l’iPhone X : peu de gains sont attendre en termes de luminosité ou de précision de l’image.

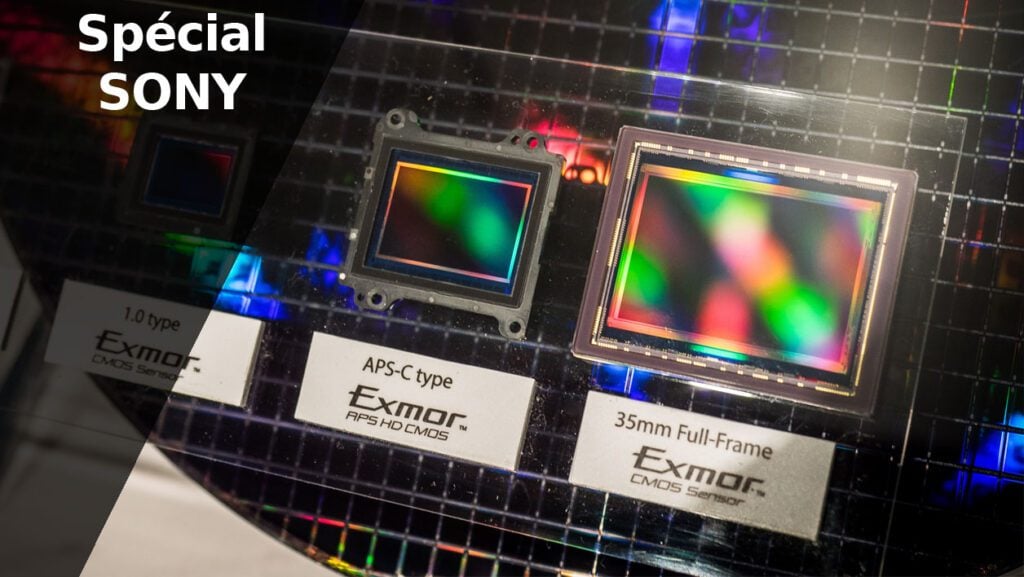

Du point de vue du capteur du module principal grand-angle, le composant est un poil plus grand : les photosites passent de 1,22 micron (iPhone X) à 1,4 micron. Le gain logique sera une meilleure sensibilité dans les basses lumières, chaque « pixel » disposant d’un peu plus de surface utile. A cette première évolution affichée sur la fiche technique s’ajoute une autre amélioration lisible entre les lignes : en mettant en avant la capacité du capteur de prendre en rafale plusieurs expositions d’une même scène dans le but de calculer et « d’assembler » un cliché « parfait » (lire plus loin), on comprend que le capteur principal dispose d’une vitesse de lecture ultra rapide. Vitesse qui n’est, à l’heure actuelle, atteinte que par les capteurs de génération « CMOS stacked sensors ». Des capteurs CMOS dits « empilés » ou la circuiterie est entièrement placée à l’arrière du composant et qui sont accompagnés, en leur dos, d’une puce de mémoire vive (RAM) qui leur permet de rapidement décharger leurs informations.

Appelée par Sony « Exmor RS », cette conception de capteur n’est plus l’unique apanage du japonais – Samsung a lancé la production de composants à conception similaire – mais le spécialiste de la photo dispose à l’heure actuelle de la technologie la plus mature. Apple ne donnant jamais le nom de ses fournisseurs, il faudra donc attendre le désossage de ses composants par les fous de Chipworks pour savoir s’il s’agit toujours d’un capteur Sony – ce dernier livre ses capteurs à Apple depuis l’iPhone 4 !

La puissance de calcul pour transcender les limites techniques

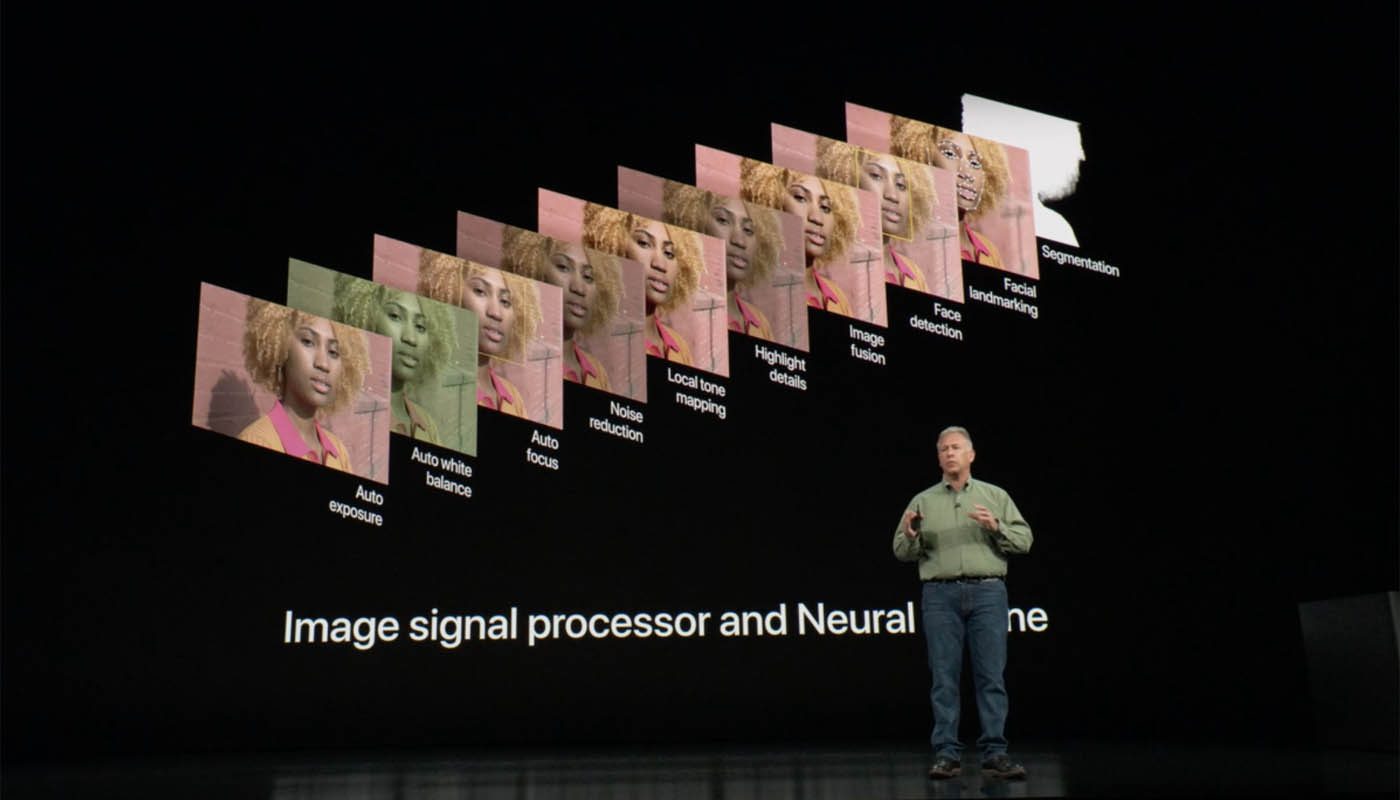

Dans sa présentation, Phil Schiller a annoncé la couleur : « si la photo est bien sûr influencée par le capteur et l’optique, la puissance logicielle est de plus en plus importante ». Voire même prédominante : selon les spécifications annoncées par Apple, sa puce A12 Bionic pourrait, avec les efforts conjugués de son processeur d’image (ISP) et de son processeur neuronal, calculer jusqu’à 1000 milliards d’opérations par photo.

Une débauche de puissance qui, appliquée à de solides algorithmes et un capteur suffisamment rapide (d’où notre suspicion de capteur Exmor RS), permet à Apple d’offrir à ses iPhone XS et XS Max un temps de déclenchement nul (« zero shutter lag »). Ou encore de gérer non seulement les opérations « classiques » des processeurs d’image – calcul de l’AF, de la balance des blancs, de la réduction du bruit numérique, etc. – mais aussi des informations plus fines telles que la segmentation de l’image (visage humain, ciel, décors, etc.), la caractérisation volumétrique d’un visage ou encore la fusion de plusieurs images. Car (sans doute) doté de mémoire vive, le capteur d’image est capable de capturer ultra rapidement jusqu’à 8 images simultanées : 4 images normalement exposées et 4 images intermédiaires (intertrames) pour récupérer, selon le type de scène, des détails dans les hautes ou basses lumières.

La composition d’une image finale de grande qualité (exposition, HDR, détails, etc.) à partir de plusieurs images de qualité « standard » est au cœur du futur de la « computational photography » et, Huawei l’a bien prouvé avec son P20 Pro, l’axe majeur de l’amélioration de la qualité d’image des smartphones, les capteurs et les optiques étant des technologies matures qui progressent (beaucoup) moins vite que les processeurs. Les iPhone XS et XS Max arriveront-ils à reprendre le leadership de la qualité d’image perdu par Apple depuis la génération 7 ? Les tests parleront bientôt !

L’art du bokeh pour simuler les reflex

Le bokeh, mot japonais qui caractérise un flou d’arrière-plan, est un graal pour les petits capteurs d’image des smartphones. Ce n’est pas la première fois qu’Apple, par la voix de Phil Schiller, promet des portraits avec des flous d’arrière-plan « digne des reflex » : depuis l’arrivée du mode portrait et du processeur A10 de l’iPhone 7 Plus, Apple travaille intensément dessus.

Les iPhone XS et XS Max disposent, grâce à leur puce A12 Bionic, d’un nouveau mode portrait enrichi d’une fonctionnalité que nous avons déjà vue dans plusieurs terminaux Android (notamment Huawei) : un simulateur d’intensité de flou d’arrière-plan. Concrètement il s’agit, dans le mode « Portrait » de l’application caméra, d’une roue qui permet de faire varier une ouverture simulée de f/1.4 à f/16.

A f/1.4, les nouveaux iPhone simulent donc le diaphragme grand ouvert (simulation de capteur Micro 4/3 ? APS-C ? 24×36 ?) ou la zone de netteté est très fine et l’arrière-plan intensément flou. A f/16 on se retrouve avec une image entièrement nette de l’avant à l’arrière-plan. Il s’agit ici encore de « computational photography » où les capteurs d’image et de profondeur jouent de concert pour découper l’image en plusieurs plans que le processeur est à même de fusionner en temps réel pour simuler le rendu d’une optique… plus lumineuse que la « vraie » optique, qui n’ouvre qu’à f/1.8 !

iPhone X R : un seul module caméra mais presque les mêmes performances

Dépourvu de second module caméra téléobjectif, le petit frère « moins cher » qu’est l’iPhone XR dispose cependant du même module grand angle – même optique ouvrant à f/1.8, même capteur 12 Mpix avec pitch de 1,4 micron. Il est non seulement capable d’offrir le rendu « Smart HDR » issu de de la combinaison de plusieurs images mais aussi les mêmes modes « Advanced bokeh » et « Depth Control ». Le mode portrait est limité au module grand-angle mais on profitera quand même du même outil de contrôle d’intensité du flou d’arrière-plan – mais avec une focale moins saisissante que le téléobjectif des iPhone XS et XS Max.

Ce que l’on peut retenir de la partition photo de cet iPhone XR ? Tout simplement que mis à part le rendu téléobjectif, Apple propose une offre photo haut de gamme sur la base d’un seul capteur – façon HTC avec ses excellent U11 et U11+. Prouvant par-là que c’est bien le processeur qui fait toute la différence.

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.