Saviez-vous qu’un rice cooker ou un thermostat étaient considérés, à une époque, comme de l’intelligence artificielle, au même titre que ChatGPT et DALL-E aujourd’hui ? Que le terme, utilisé à toutes les sauces depuis la dernière révolution de l’IA, n’a pas le même sens aux Etats-Unis et en Europe ? Et que loin d’être une question rhétorique, le législateur européen s’échine depuis des mois à s’accorder sur ce qu’est l’intelligence artificielle. L’enjeu pour les 447 millions d’Européens et toutes les sociétés de la tech ? Ni plus ni moins que l’application du futur règlement sur l’intelligence artificielle – appelé « AI Act ».

Comme en 2016 lorsque l’exécutif européen a adopté le règlement sur les données personnelles (le RGPD), la Commission européenne a souhaité fixer des règles dans un secteur qui n’en a pas ou peu. Le futur AI Act déterminera quel type d’IA peut être déployé en Europe, par quelle procédure et quel coût les entreprises devront passer pour accéder au marché de l’Union européenne (UE).

Réglementer non pas l’algorithme, mais son usage

Et comme un algorithme peut autant permettre de détecter de manière précoce un cancer que de faire de la reconnaissance faciale massive dans la rue, l’exécutif européen a opté pour une approche particulière. Il a choisi de réglementer non pas la technologie en elle-même (les algorithmes), mais l’usage que ces entreprises en font. Concrètement, plus une IA représente un risque pour nos libertés ou nos vies privées, et plus elle sera soumise à des contraintes réglementaires – qui peuvent aller jusqu’à l’interdiction.

Mais de quelle intelligence artificielle parle-t-on ? Et comment la définir dans le texte de loi pour qu’elle englobe l’IA actuelle, comme l’IA future ? Pour trancher la question, les auteurs de l’AI Act ont dû d’abord se tourner vers les premiers concernés : les informaticiens.

« En sciences, il y a une ambigüité terrible sur le terme IA »

« En sciences, il y a une ambigüité terrible sur le terme IA », explique Vincent Guigue, professeur en informatique à AgroParisTech. « Dans les années 50, époque où ce mot, IA, a été créé, n’importe quel programme, n’importe quelle petite portion algorithmique permettant d’optimiser, d’automatiser une tâche relevait de l’intelligence artificielle », rapporte-t-il. « Dans un rice cooker, on a pu dire qu’il y avait de la logique floue, de l’IA, car pour que le riz arrête de cuire, il fallait que le mode cuisson s’arrête de manière un peu maligne, qui allait au-delà d’un simple changement de température. En fait, c’est une petite formule de rien du tout, une ligne de code », poursuit-il.

Jusque dans les années 80/90, le courant majoritaire dans cette branche d’activité était l’intelligence artificielle symbolique, qui a été à l’origine des premiers systèmes experts. Concrètement, il s’agit de modéliser dans des programmes informatiques un ensemble de symboles qui reproduisent le raisonnement de l’Homme. Et « quand on arrivait avec des méthodes statistiques d’analyse de données, du machine learning qui est aujourd’hui le courant majoritaire de l’IA, on nous disait, “vous êtes un peu dans l’IA, mais l’IA, c’est pas ça” », se remémore Vincent Guigue.

À compter des années 2012 commence l’ère du deep learning dans lequel les machines vont intégrer des connaissances et apprendre par elles-mêmes grâce à des données, sous l’impulsion de Yoshua Bengio, Yann Le Cun et Geoffrey Hinton, les trois pères fondateurs de cette branche de l’IA. Et « petit à petit, le terme « intelligence artificielle » a désigné le machine learning. Mais cette récupération du terme n’a pas été uniforme partout dans le monde. Aux États-Unis, si on dit « IA » aujourd’hui, c’est le machine learning. En France, dans la communauté scientifique, si on dit « IA » aujourd’hui, c’est extrêmement ambigu, parce que la communauté symbolique est encore très forte. Et donc les gens restent sur la position précédente de dire, « Non, non, l’IA c’est nous. Et le machine learning, c’est une toute petite portion, c’est autre chose », relève le professeur.

À lire aussi : Intelligence artificielle : le machine learning, comment ça marche ?

Quand la question arrive sur la table du législateur…

Et si cette querelle de clochers n’a pas des conséquences importantes en sciences, elle est devenue une question essentielle lorsque le sujet de l’IA est arrivé sur la table du législateur européen. Que fallait-il entendre par intelligence artificielle, où commence-t-elle, et où se termine-t-elle ? Trouver une définition commune est d’autant plus complexe que le processus législatif européen nécessite l’alignement de trois organes pour qu’un « règlement » soit voté – un type de loi immédiatement applicable au sein de l’UE. La proposition de la Commission doit être adoptée par le Conseil et par le Parlement européen – ce qui peut prendre plusieurs mois, voire plusieurs années.

Une définition large mais technologique pour la Commission

La Commission européenne s’est, la première lancée, dans l’arène, il y a près de deux ans. C’est elle qui est à l’origine d’une proposition de l’AI Act, ce règlement qui date du 21 avril 2021. Elle a opté pour une définition large de l’IA. Un « système d’intelligence artificielle » était désigné comme « un logiciel qui est développé au moyen d’une ou plusieurs des techniques et approches énumérées à l’annexe I et qui peut, pour un ensemble donné d’objectifs définis par l’homme, générer des résultats tels que des contenus, des prédictions, des recommandations ou des décisions influençant les environnements avec lesquels il interagit ».

L’annexe I listait trois catégories de techniques algorithmiques : les systèmes auto-apprenants (le fameux machine learning), les systèmes logiques et les systèmes statistiques. Dans le texte initial, la Commission pouvait mettre à jour ces technologies dans l’annexe, via une procédure bien plus rapide qu’un changement de règlement. Cela lui permettait d’avoir la possibilité d’inclure toutes les nouvelles IA, et d’éviter que la loi ne devienne obsolète trop rapidement.

La particularité de cette définition, c’est qu’« elle est fondée sur la technologie, avec des références au machine learning, et aux systèmes logiques et statistiques », commente Arnaud Latil, maître de conférences de droit privé à Sorbonne Université et membre du Sorbonne Center for Artificial Intelligence (SCAI).

Le Conseil choisit une définition plus restreinte

Deuxième étape : le texte est ensuite arrivé au Conseil (représentant les 27 Etats membres). Après moultes discussions, ce dernier a publié une proposition de compromis en novembre dernier. Premier changement substantiel : l’annexe n’existe plus, et l’ensemble de la définition a été réintégrée dans le corps du règlement. Exit donc la possibilité pour la Commission de mettre à jour rapidement cette définition en cas de nouvelles technologies.

Deuxième changement : le mot “logiciel” a été supprimé et remplacé par “système”. Beaucoup craignaient en effet qu’en incluant ce mot, tous les logiciels sans exception soient soumis au IA Act, avec des nouvelles exigences qui auraient été étendues à des produits qui ne nécessitent pas une réglementation aussi rigoureuse.

Enfin, si on ne trouve plus la référence aux trois technologies de l’annexe, l’IA doit désormais se distinguer « des systèmes logiciels et des approches de programmation plus simples », écrit le Conseil. Autres éléments ajoutés : pour être qualifiée d’IA, il faut que « le système conçu fonctionne avec un certain niveau d’autonomie », qu’il utilise « l’apprentissage automatique et/ou des approches fondées sur la logique et la connaissance ».

Avec ces nouvelles conditions, la définition de l’IA est donc « beaucoup plus restreinte » que la première, écrit le think tank européen CEPS dans un rapport de février 2023. Elle se limite plus strictement à l’apprentissage automatique et aux approches similaires de l’IA. La référence à une certaine autonomie « pourrait réduire encore le champ d’application de la définition à des modèles capables de prendre des décisions adaptatives », ajoute-t-il. Le think tank défend une définition large de l’IA qui n’exclut aucune technique de l’IA, car « les algorithmes d’apprentissage automatique, qui agissent avec des éléments d’autonomie » ne sont pas les seuls qui « créent des risques significatifs pour les droits fondamentaux et la sécurité ».

Une définition plus générique – et plus large pour le Parlement ?

Ont-ils été entendus par le Parlement européen, qui a, à son tour, étudié le texte et discuté âprement de cette définition ? La question reste entière. Car si aucune position officielle n’a été pour l’instant publiée, on sait que certains députés conservateurs du Parti populaire européen (PPE) ont milité pour que l’IA soit limitée au machine learning. Les parlementaires européens de la gauche et du centre défendent, eux, une définition plus large, pour ne pas exclure des champs entiers de l’IA. Et selon nos confrères d’Euractiv, les lignes ont, ces dernières semaines, bougé.

Le Parlement se serait finalement mis d’accord sur une définition bien plus générique, proche de celle de l’OCDE – un mois plus tôt, c’était celle de l’Institut national des normes et de la technologie américain qui était sur la table. Une définition d’un organisme international a l’avantage d’être déjà acceptée par la communauté scientifique et donne un gage de légitimité, auraient expliqué les députés. Cette fois, rapporte Euractiv, le 8 mars dernier, l’IA serait définie comme « un système automatisé qui, pour un ensemble donné d’objectifs définis par l’homme, est en mesure d’établir des prévisions, de formuler des recommandations, ou de prendre des décisions influant sur des environnements réels ou virtuels ».

« En droit, on parle souvent du principe de neutralité technologique, qui signifie en fait qu’il faut le moins possible faire référence aux techniques ou aux technologies dans la réglementation », explique Arnaud Latil. « Dans la version de l’OCDE, le principe de neutralité technologique est là. Et on voit bien la différence par rapport à la toute première définition d’avril 2021 qui était très orientée, avec la référence aux trois technologies de l’IA. Dans la version de novembre du Conseil, elle se rapproche de la neutralité technologique, mais ce n’est pas tout à fait ça. La définition reste au milieu du gué. Et si c’est bien celle de l’OCDE qui est finalement choisie dans le texte final, on n’a plus aucune référence à la technologie », poursuit le professeur.

Le spectre de la surréglementation

À côté de la question de la neutralité, on voit que cette définition de l’OCDE, assez générique, est aussi plus large que celle du Conseil – on ne retrouve plus la distinction entre systèmes complexes et simples, ni les références à l’autonomie ou aux techniques d’apprentissage. Reste à savoir quelle vision de l’IA l’emportera dans la version finale du texte. Quel est l’enjeu ? Si la définition est trop étroite : le risque est de voir des pans entiers de l’IA échapper à la réglementation. Les concepteurs d’IA pourraient aussi choisir volontairement des approches plus simples pour éviter d’être soumis à cette réglementation.

Si elle est trop large : cela pourrait revenir à surrèglementer le secteur et à multiplier les coûts pour les entreprises, craignent certaines sociétés de la tech. Lors de l’adoption du RGPD déjà, les Gafam avaient émis les mêmes craintes. Ils avaient même menacé l’UE de quitter la zone une fois que ce texte serait entré en vigueur. Selon eux, ces règles auraient été trop contraignantes et auraient détruit le commerce électronique européen. Mais cela n’est pas arrivé : le RGPD a au contraire créé une interface juridique unique pour l’ensemble du marché numérique de l’UE.

À lire aussi : Pourquoi le transfert de vos données personnelles aux Etats-Unis est un incroyable casse-tête

Et avec l’AI Act, le même malentendu a refait surface : le spectre de la surréglementation, qu’une définition large de l’IA impliquerait, est à nouveau brandi. Pourtant, avec son approche fondée sur les risques, le texte impose des exigences réglementaires poussées pour seulement une partie d’entre eux : les systèmes d’IA qui créent des risques élevés pour la santé, la sécurité et les droits fondamentaux. Pour le reste – comme l’IA des jeux vidéo, des aspirateurs et des app de nos smartphones, il s’agit surtout de « due diligence », explique Joanna Bryson, professeur d’éthique et de technologie à la Hertie School, chez nos confrères de Wired.

Le danger d’une définition trop étroite

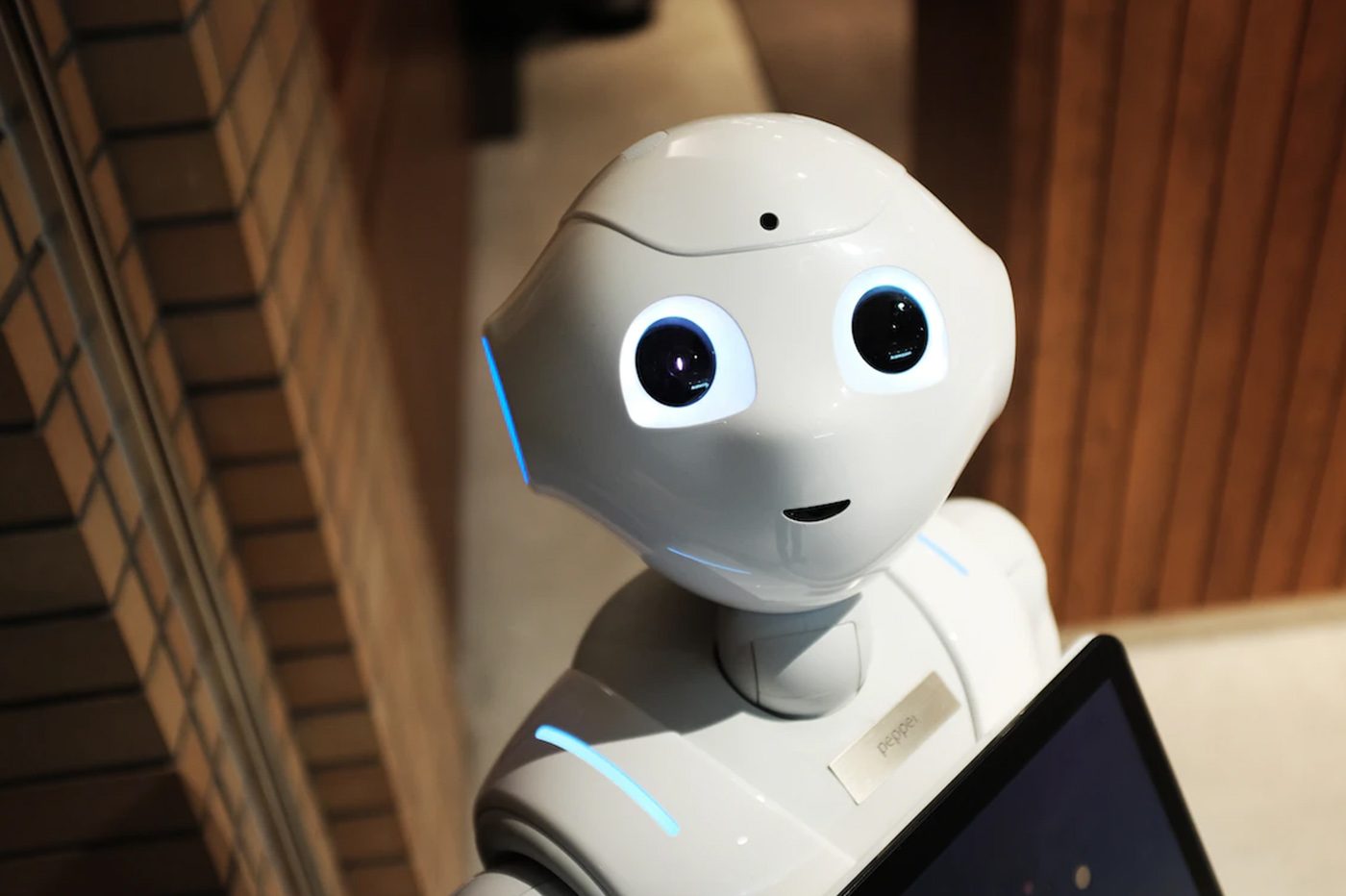

Le texte n’impliquerait pas pour ces derniers, ce qui représente la majorité des cas, de nouvelle charge réglementaire. Il n’exigerait que des obligations de transparence de base ; par exemple, un chatbot devrait indiquer qu’il s’agit d’une IA et non d’une interaction avec un véritable être humain.

Si au contraire, on essaie de séparer l’IA complexe d’une IA simple – ce qui pourrait entraîner des litiges sans fin – ou qu’on exclut certaines branches de l’IA pour ne limiter l’AI Act qu’au deep learning, toutes les garanties prévues par le texte ne s’appliqueraient pas à ce qui en serait exclu. Exit donc les garde-fous que doivent respecter les gouvernements et les entreprises, censés éloigner le risque de surveillance généralisée.

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.