Lecture automatique de chèques, reconnaissance d’image, reconnaissance de parole, assistance vocale, pilotage automatique de voiture, jeux de stratégies, analyse financière, détection de fraude, moteurs de recherche, aide au diagnostic médical, etc.

L’intelligence artificielle s’immisce désormais presque partout et nous simplifie la vie. Les technologies qui ont actuellement le plus de succès sont celles de l’apprentissage automatique, ou « machine learning » (ML).

Quand on voit passer une voiture autonome, quand on observe un logiciel d’échecs ou quand on écoute un assistant vocal, il y a de quoi être impressionné. Et pourtant, ces systèmes ne sont pas très intelligents. Ils permettent d’accomplir des tâches très spécialisées, dans lesquelles ils vont battre l’humain à plate couture. Mais ils ne pourront pas faire autre chose, car ils ne disposent pas d’intelligence générale.

En vérité, ces systèmes ne comprennent rien à ce qu’ils accomplissent, car tout ce qu’ils font est avant tout le résultat de calculs statistiques. Les ouvrages de ML sont remplis de techniques de « probabilités », d’évaluation de « distances », de « régression » linéaire ou polynomiale, de « gradient stochastique », etc. C’est pour cela, d’ailleurs, que le ML est également appelé apprentissage statistique.

Big data et cartes graphiques ont mis le feu aux poudres

Il existe trois principales formes de ML : supervisé, non-supervisé et par renforcement. Mais c’est clairement la première qui a le vent en poupe, et notamment grâce l’une de ses sous-catégories qui est l’apprentissage profond, ou « deep learning ». Le but de l’apprentissage automatique supervisé est de créer un système informatique qui soit capable de reconnaître des choses.

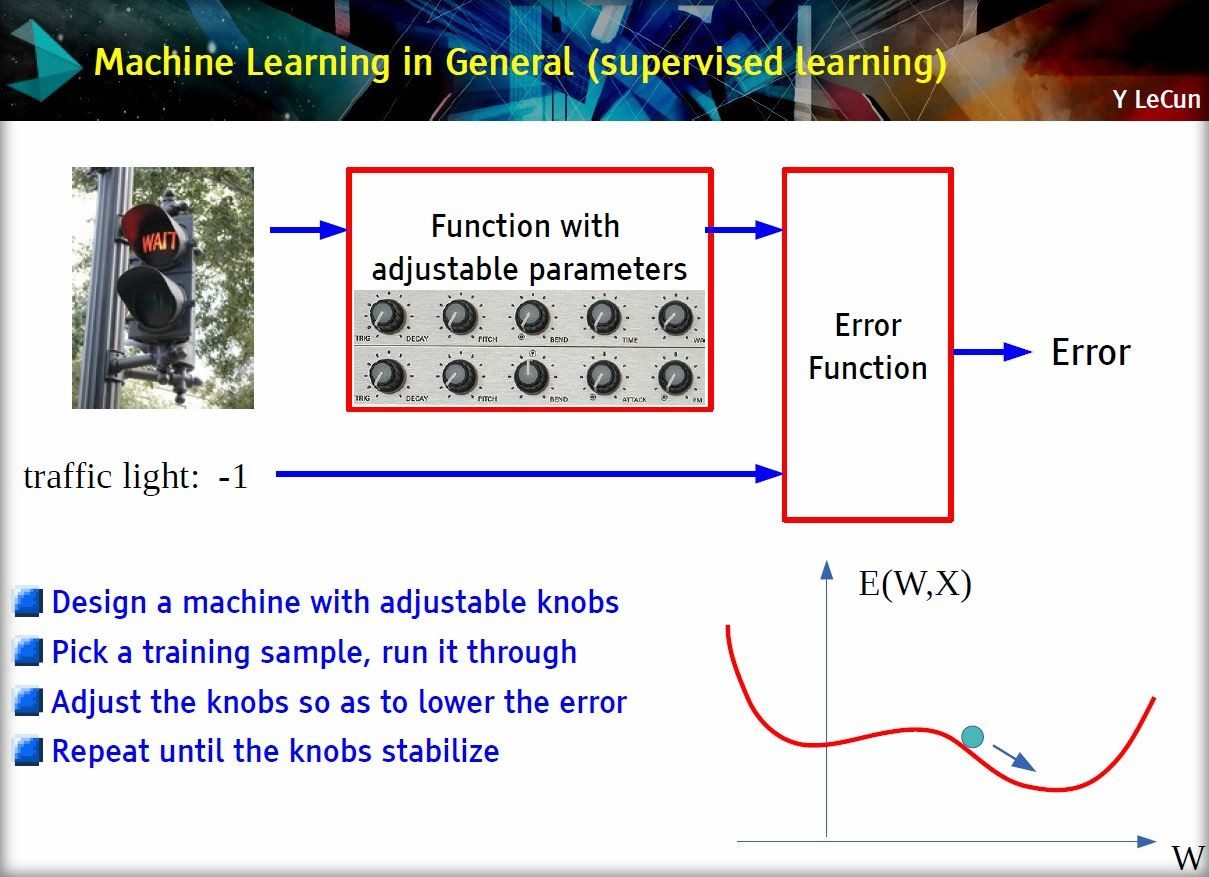

Pour y arriver, on modélise ces éléments sous forme de « caractéristiques » (features), on se dote d’une grande masse de choses étiquetées et d’un algorithme d’apprentissage. On associe alors à ces différentes caractéristiques des « poids » qui vont permettre, par exemple, de différencier une chaise d’une pomme. Pour trouver les bons poids, on demande à l’algorithme de reconnaître une chose connue. S’il se trompe, on ajuste un peu les poids et on recommence, jusqu’à ce que l’erreur soit minimale. Et si tout se passe bien, le système va se créer une matrice de poids, une espèce de filtre de vision qui lui permettra de bien reconnaître les choses, même s’il ne les a jamais vues auparavant.

Mais la modélisation initiale des choses, la définition de leurs caractéristiques, est compliquée. Et c’est là que le deep learning va apporter une solution. Créée dans les années 80, cette technologie consiste à subdiviser l’apprentissage en plusieurs modules entraînables et à les arranger en couches successives. Le résultat est appelé un réseau neuronal multicouche.

L’avantage avec un tel système, c’est qu’il va créer automatiquement une représentation hiérarchique des choses et faire émerger les caractéristiques. Plus besoin d’une modélisation à la main. Parmi les réseaux neuronaux multicouches se distingue les réseaux convolutifs. Inventés par Yann Lecun, ils s’inspirent du fonctionnement du cortex visuel des mammifères et sont particulièrement adaptés à la reconnaissance d’image.

Mais le deep learning n’a pas décollé tout de suite. Ce n’est qu’en 2011-2012, lorsque les chercheurs pouvaient s’appuyer, d’une part, sur de larges banques de données (1,2 million d’images réparties dans 1 000 catégories dans la base ImageNet) et, d’autre part, sur des processeurs graphiques abordables (GPU Nvidia Cuda) que cette technologie a vraiment commencé à s’imposer.

« La diminution des taux d’erreurs était telle qu’une véritable révolution d’une rapidité inouïe s’est déroulée. Du jour au lendemain, la majorité des équipes de recherche en parole et en vision ont abandonné leurs méthodes préférées et sont passées aux réseaux convolutifs et autres réseaux neuronaux », explique Yann Lecun au Collège de France, en 2016.

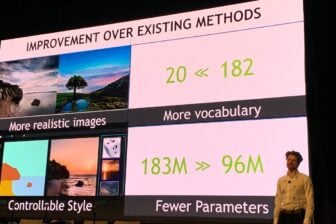

Aujourd’hui, les systèmes d’apprentissage supervisés sont devenus ultra-complexes. Ils sont capables de gérer des milliers de catégories et des centaines de millions de caractéristiques. Certains réseaux neuronaux dépassent désormais les 150 couches. Parmi les développements les plus prestigieux de l’apprentissage supervisé figurent notamment les pilotes automatiques de Tesla ou de MobileEye.

L’apprentissage par la récompense

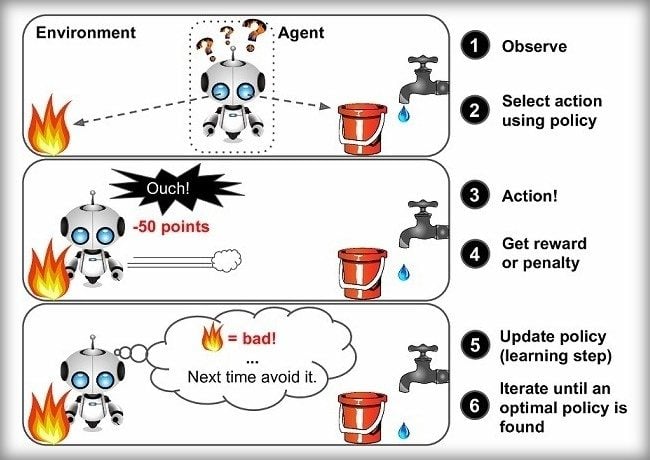

Mais les autres formes d’apprentissage n’ont pas dit leur dernier mot. L’apprentissage par renforcement, en particulier, connaît aussi ses moments de gloire. Cette technique ne s’appuie pas sur l’évaluation de données étiquetées, mais fonctionne selon un procédé de récompense par l’expérience. Celle-ci est évaluée et réinjectée dans l’algorithme d’apprentissage pour améliorer les règles de décision et trouver une meilleure issue au problème.

Cette technique est très utilisée dans les jeux. En 2017, la société DeepMind, une filiale de Google, a réussi à créer le programme AlphaGo Zero qui, en connaissant seulement les règles du jeu de Go, est devenu invincible dans cette discipline en l’espace de 40 jours. Il a appris le jeu en jouant contre lui-même, sans ajout de données extérieures. La même année, Maluuba, une filiale de Microsoft, a présenté un système d’apprentissage par renforcement qui a été capable non seulement de pulvériser le record humain à Ms. Pac-Man (266.330 points), mais aussi d’atteindre le score maximal possible (999.990 points).

Le problème, c’est que l’apprentissage par renforcement prend beaucoup de temps. Comme il n’y a pas de données étiquetées, l’évaluation de l’erreur est plus difficile à faire. Il faut donc répéter les actions de nombreuses fois. La difficulté de cette évaluation est également amplifiée par la complexité de l’environnement. Comment interpréter l’issue d’une expérience quand beaucoup d’éléments peuvent y influer ? Dans le cas de Ms. Pac-Man, les chercheurs ont contourné ce problème en déployant 150 agents différents, chacun focalisant sur un problème spécifique : récupérer un maximum de pac-gommes, éviter les fantômes venant de la droite, ceux qui viennent de la gauche, etc. Chaque agent va donner son avis sur la prochaine action à faire. La décision finale est la résultante de tous ces avis.

Une autre façon de maîtriser la complexité de l’environnement est d’intégrer des réseaux convolutionnels. Cette piste est notamment explorée par Google qui, en 2016, a montré que les techniques de deep learning permettait de mieux corriger les mouvements de bras robotiques industriels. Au final, ces derniers arrivaient à saisir les objets de manière beaucoup plus fluide qu’avant.

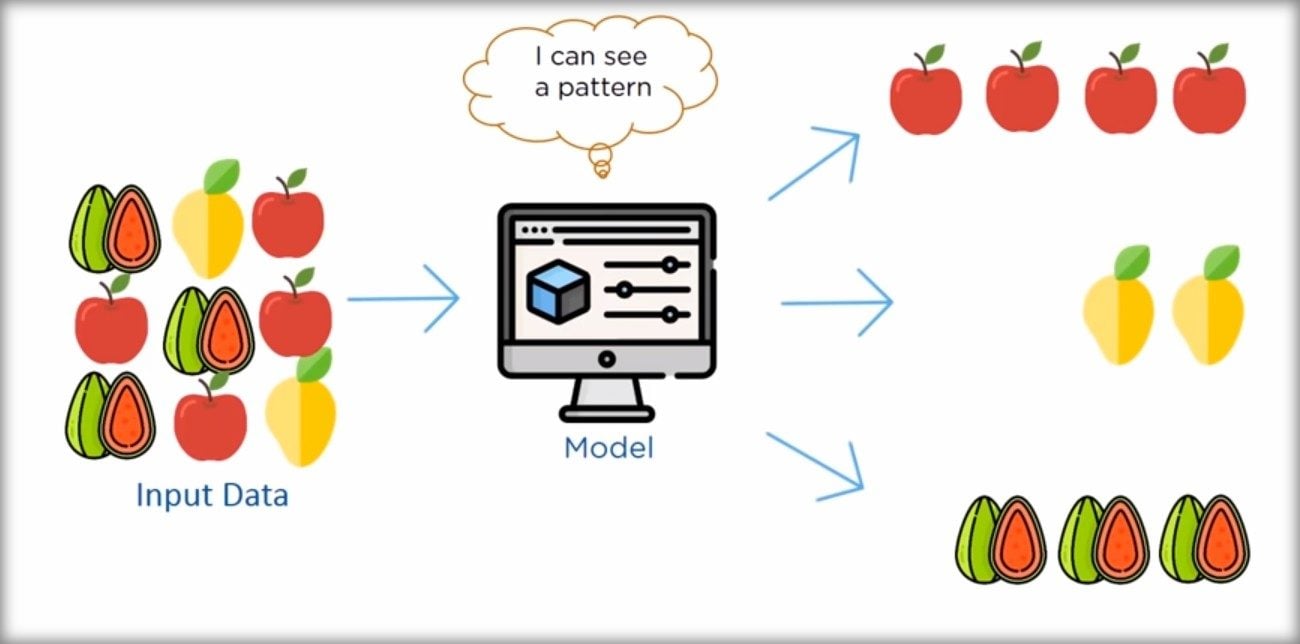

En ligne de mire, l’exemple ambitieux de l’homme

Mais le Graal reste quand même l’apprentissage non-supervisé, qui est le mode d’apprentissage naturel des hommes et des animaux. Il ne nécessite pas de données étiquetées et permet au logiciel d’identifier lui-même les choses auxquelles il est confronté. Appliqué à des problèmes simples, il permet par exemple d’évaluer les goûts musicaux des utilisateurs de Spotify ou de proposer des ouvrages aux clients d’Amazon.

L’apprentissage non-supervisé s’appuie sur différentes techniques, dont les réseaux neuronaux et les algorithmes de clustering. Dans ce dernier cas, l’idée est souvent de calculer des distances statistiques entre les données et d’identifier des groupes d’éléments qui se ressemblent.

Malheureusement, les chercheurs ne savent pas encore comment aborder l’apprentissage non-supervisé dans le cas de problèmes complexes.

C’est un vaste domaine encore inexploré. « Les chercheurs en intelligence artificielle sont dans la même situation embarrassante que les physiciens ; 95 % de la masse de l’univers est de nature complètement inconnue : matière noire et énergie noire. La matière noire de l’intelligence artificielle, c’est l’apprentissage non-supervisé », explique Yann Lecun au Collège de France. Bref, ce n’est pas encore demain que les machines prendront le pouvoir.

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.