Annoncées lors de la GamesCom, les nouvelles cartes GeForce de Nvidia arriveront dès la semaine prochaine dans le commerce. Et les deux premières à ouvrir le bal sont les les GeForce RTX 2080 Ti, l’ultra haut de gamme, et la RTX 2080, le très haut de gamme. Adieu GTX et bienvenue aux RTX, de nouveaux monstres de puissance 3D qui ont pour mission de sublimer nos jeux mais qui sont, aussi, tournés vers l’avenir.

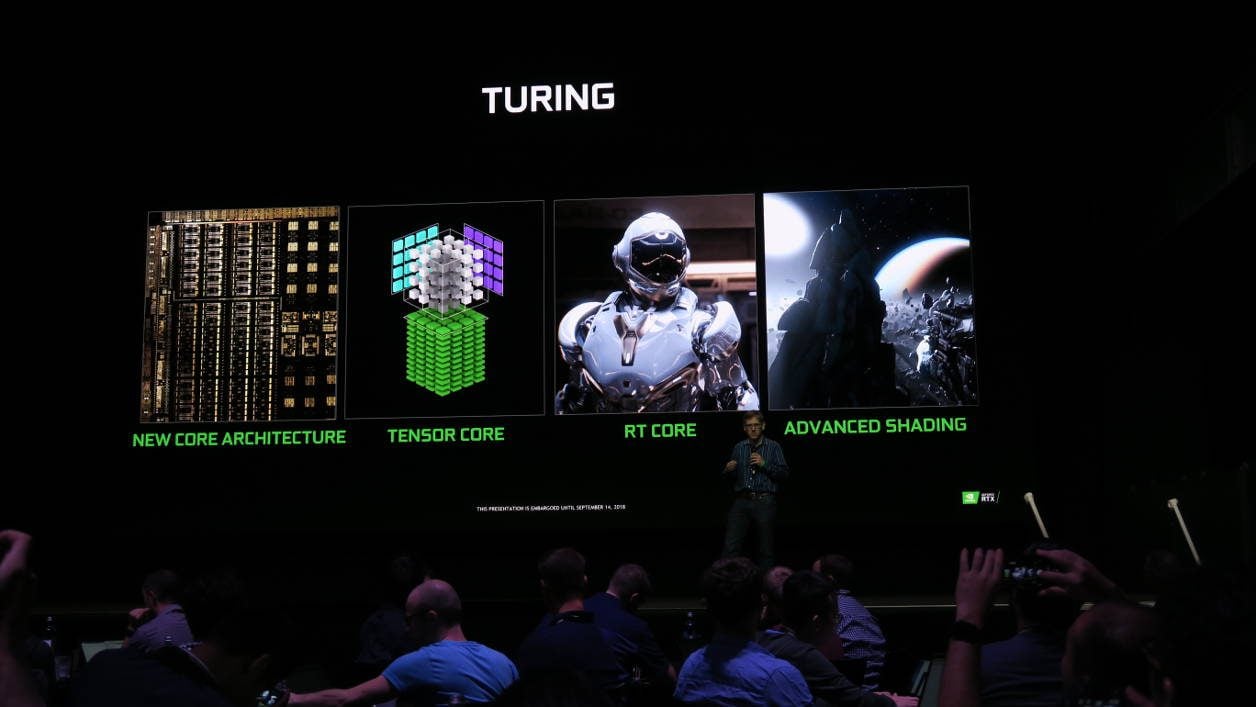

Oui, Nvidia a conçu les RTX de sorte à ce qu’elles puissent répondre à de nouveaux besoins, de nouveaux usages qui, pour beaucoup, ne seront pas d’actualité au moment du lancement. Mais qui devraient arriver à grand pas dans les mois et les années qui viennent. On pense notamment au rendu ultra réaliste ray tracing (le RT de RTX) ou encore à l’utilisation de l’intelligence artificielle au service du rendu graphique de nos jeux. Et la liste des possibilités ne s’arrête pas là. Des cartes graphiques « intelligentes » qui ne se cantonneraient plus qu’au seul calcul de nos triangles mais qui seraient capables de bien d’autres prouesses, de quoi nous donner des frissons. Avant d’aller plus loin, dressons un panorama global de ce qu’apportent ces nouvelles RTX par rapport aux GTX.

RTX et GTX : les grosses différences

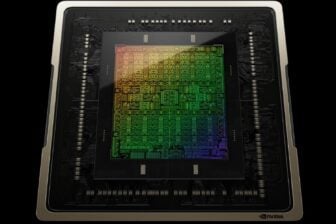

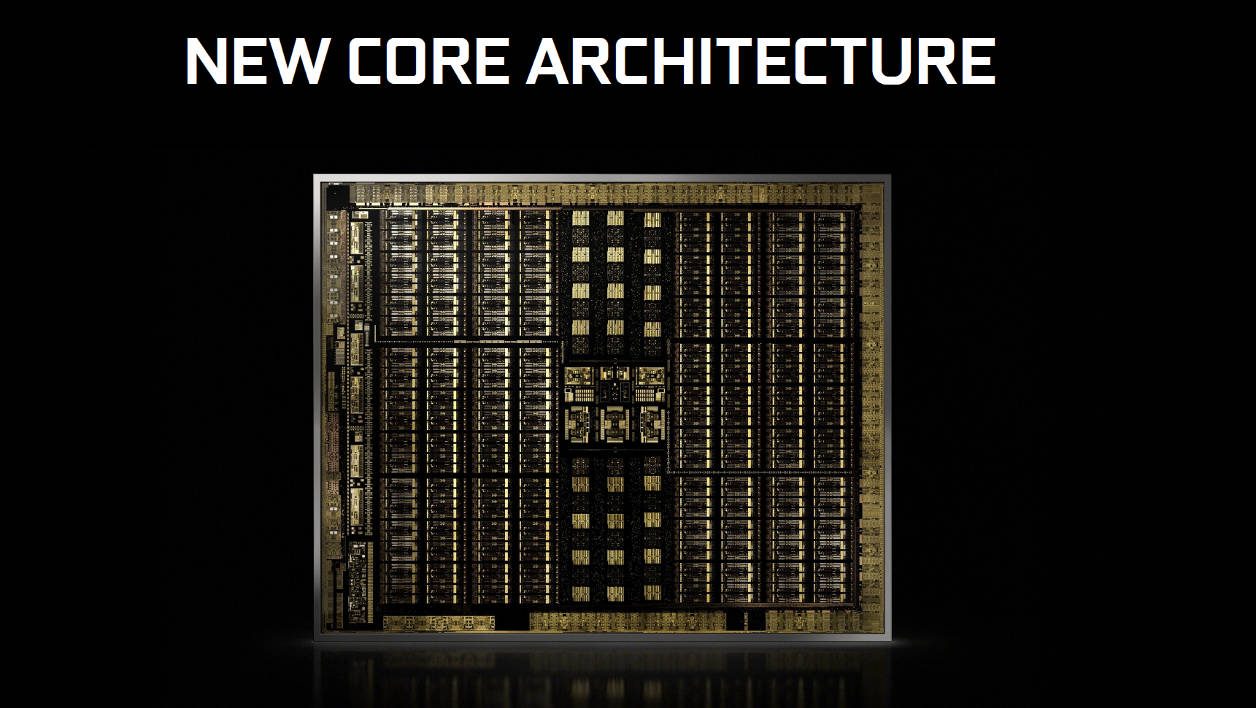

Tout comme les Quadro RTX, les GeForce RTX embarquent une puce graphique Turing (nom de code TU10x), gravée en 12 nm FFN (FinFet Nvidia). La précédente génération d’architecture grand public avait pour nom Pascal et était gravée soit en 16 nm, soit en 14 nm suivant les modèles.

La nouvelle puce Turing est composée au mieux de 18,6 milliards de transistors (contre 12 milliards max. sur les GTX série 10) et mesure 545 mm2 (contre 314 mm2 pour Pascal). Le fait de réduire la finesse gravure et d’augmenter la taille de la puce permet à Nvidia d’ajouter encore plus d’éléments sur le circuit.

La seconde évolution majeure est à chercher au cœur de la puce. Il n’y a plus un, mais trois types d’unités de calcul, toutes spécialisés dans une activité différente mais pouvant opérer de concert dans certains cas. Nous les détaillerons ci-après, mais sachez qu’aucune carte graphique GTX n’avait à ce jour réuni autant d’unités différentes en un seul et même circuit. Seuls les modèles professionnels à base de puce Volta pouvaient se targuer d’en avoir autant.

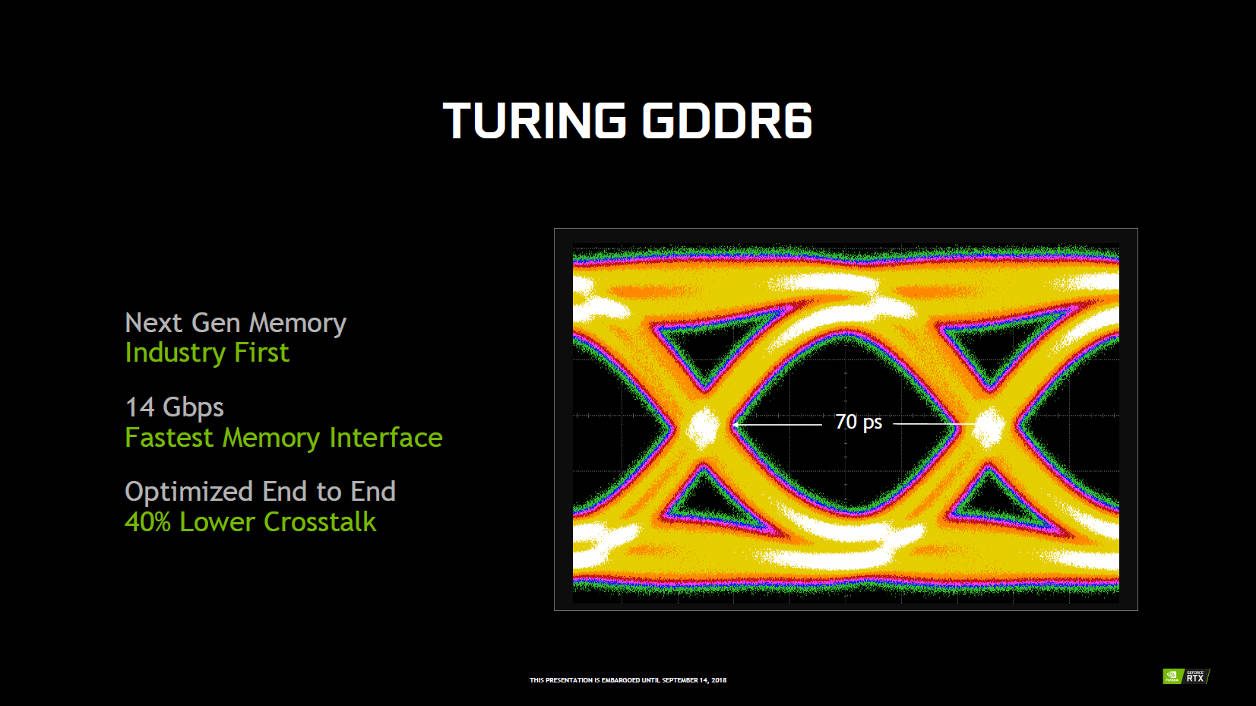

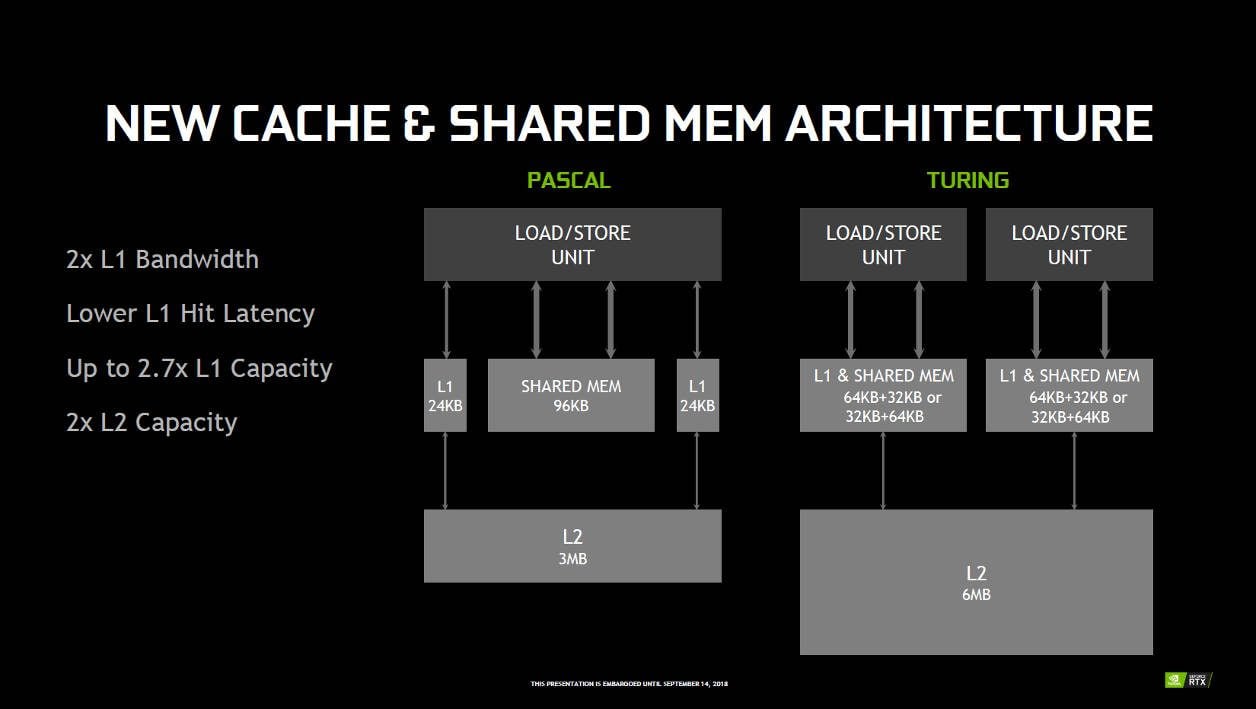

Troisième gros changement, l’abandon de la mémoire GDDR5X et de la GDDR5 au profit de la GDDR6. Cette migration permet d’accroître significativement la vitesse des échanges entre la puce et les modules mémoire. Tout comme la possibilité de stocker encore plus de textures et de données, utiles pour afficher les jeux en 4K, voire… 8K. Et comme Nvidia a encore amélioré les algorithmes qui compressent les données dans les tuyaux mémoire mais aussi la manière dont les instructions sont conservées dans différentes parties de la puce (cache), tout va plus vite. Ainsi, la GDDR6 offrirait jusqu’à 20% de performances de mieux que la GDDR5X des cartes Pascal (GTX 10) les plus puissantes.

Parmi les autres changements visibles, on mentionnera la ventilation qui est dorénavant confiée à un système à double ventilateur à 13 pales chacun et d’une chambre à vapeur de grosse capacité, traversée par des caloducs. Selon Nvidia, là où la GTX 1080 pouvait occasionner jusqu’à 36 dB de nuisance sonore, la RTX 2080, elle, n’en produirait que 29. Et le mercure serait également moins prompt à atteindre certains sommets, surtout lorsqu’on overclocke la carte. A vérifier lors de nos prochaines évaluations.

En matière de sortie vidéo, Nvidia a définitivement relégué la sortie vidéo DVI au placard. Toutes les RTX n’embarquent plus qu’une sortie HDMI (2.0b), trois DisplayPort (1.4a compatible 8K à 60 Hz) et, nouveauté, une prise USB Type-C compatible VirtualLink (le prochain standard de la VR ?).

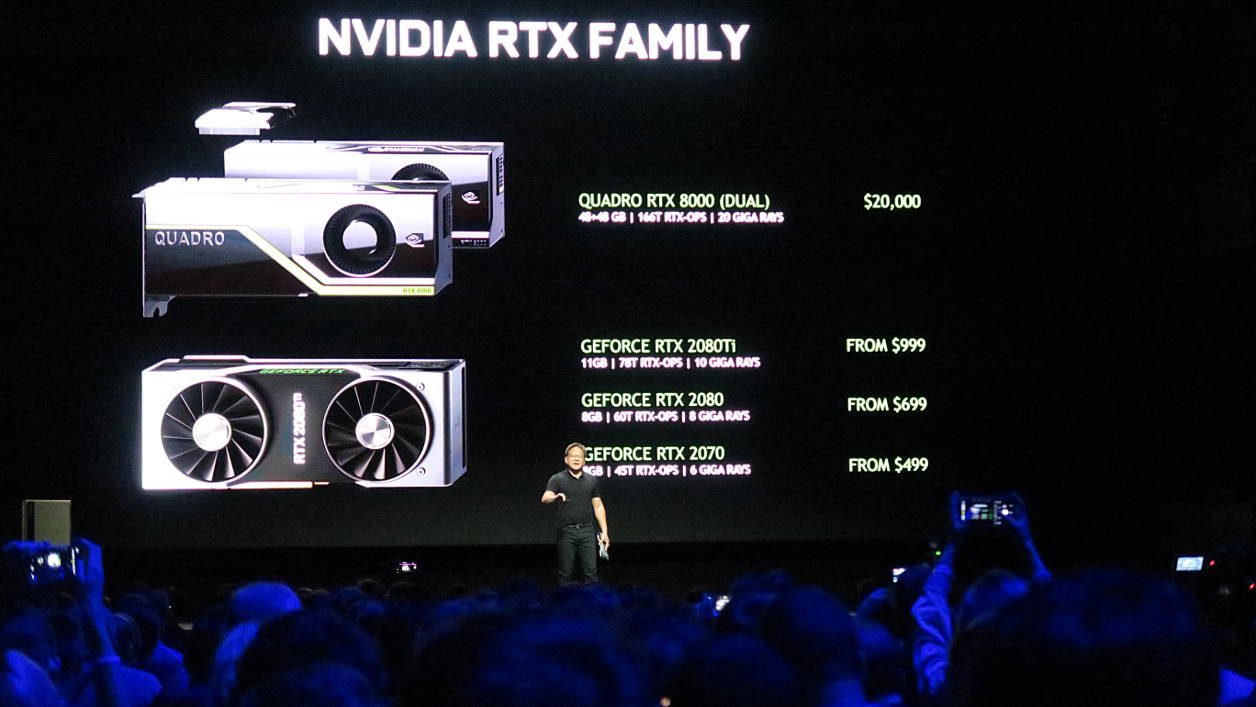

Enfin, viennent les prix. Les RTX sont plus chères que les GTX à leur sortie, il y a deux ans. En outre, comme l’a annoncé Nvidia, entre une version Founders Edition vendue par ses soins et une carte commercialisée par ses partenaires, il y aura des différences sur l’étiquette et la fiche technique. Pour le justifier, le concepteur invoque les composants électroniques sélectionnés qui permettent une meilleure montée en fréquence de la puce en GPU Boost, le système de ventilation maison, etc. Il n’en demeure pas moins qu’à ce jour, à quelques jours de la mise en vente des cartes, tous les modèles de GTX 2080 Ti, pourtant annoncés à partir de 999 dollars sont, dans les faits, vendus entre 1250 (le prix de la Founders Edition) et 1300 euros et peuvent même atteindre jusqu’à 1500 euros. Soit le prix d’un très bon PC de jeu, complet !

Organisation du processeur Turing

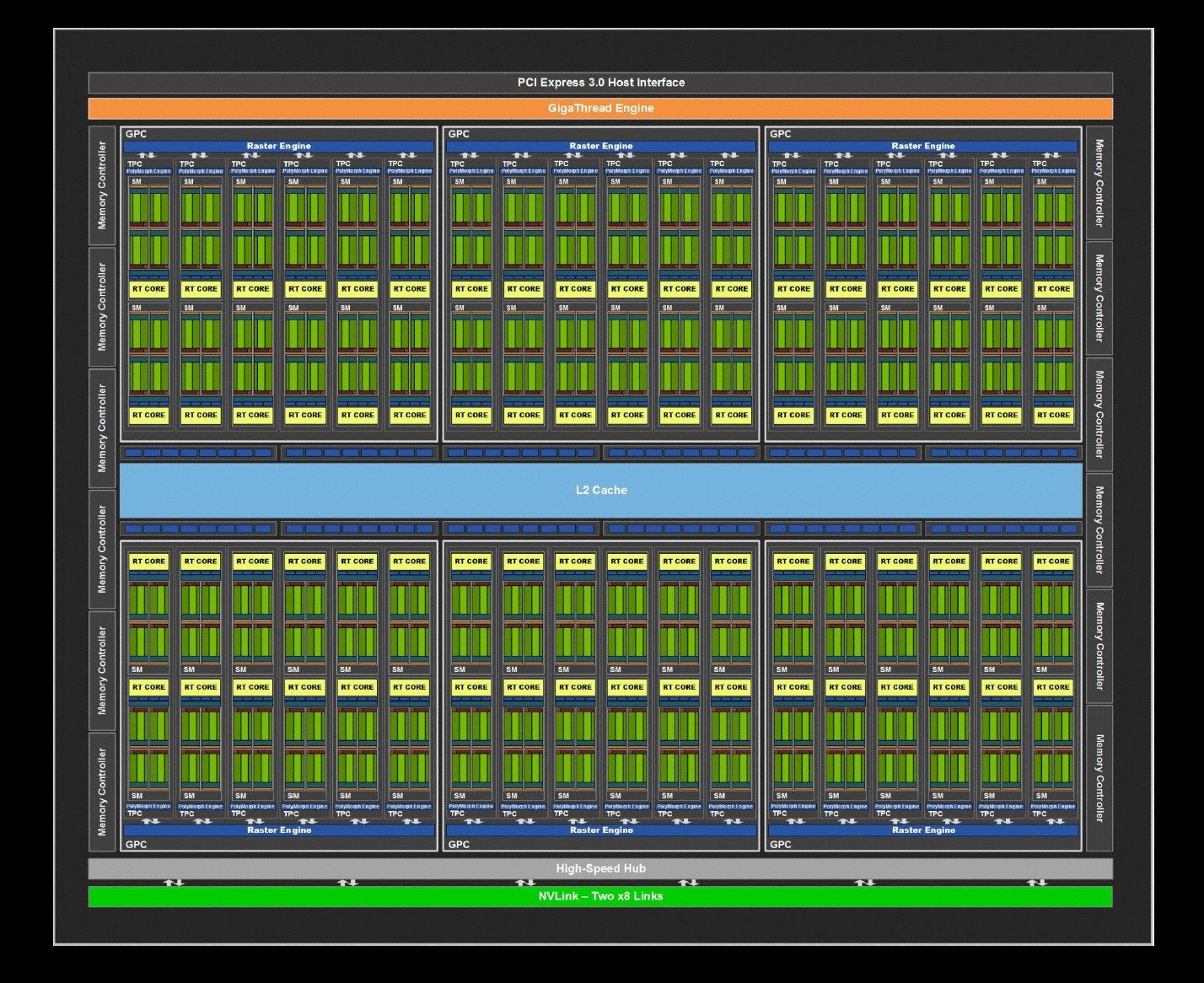

Voici à quoi ressemble le diagramme du plus évolué des processeurs 3D de la gamme Turing, le TU102, présent sur certaines cartes professionnelles de Nvidia.

C’est une itération légèrement modifiée du TU102 qui motorise la RTX 2080 Ti et, sur la 2080, c’est le TU104 qui est à l’œuvre. Enfin, sur la RTX 2070, ce sera le TU106.

A chaque déclinaison, et comme c’est la coutume dans le monde du GPU, des éléments du processeur graphique sont désactivés ou purement et simplement supprimés afin d’atteindre les paliers techniques et de puissance voulus (et donc segmenter l’offre).

Pour les plus aguerris, on remarque que la puce Turing est – comme Pascal – toujours organisée comme une poupée gigogne.

Les éléments principaux sont les ensembles GPC (Graphic Processing Cluster). Six sont présents sur les 2080 et 2080 Ti contre 4 et 6 sur les 1080 et 1080 Ti.

Chacun renferme les blocs TPC (Texture Processing Cluster). On en compte 23 et 34 sur les deux nouvelles RTX alors que les GTX 1080 et 1080 Ti n’en possédaient que 23 et 28.

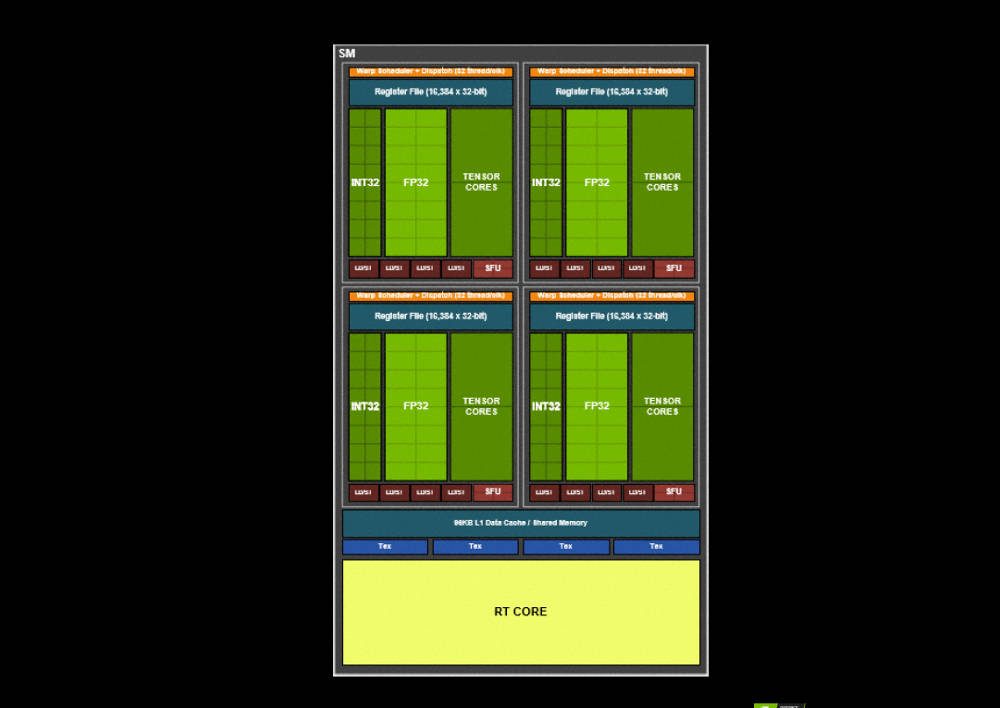

Enfin, au sein des TPC sont hébergées les unités SM (Streaming Multiprocessors) qui se divisent elles-mêmes en 4 parties identiques. En tout, il y a 68 SM sur la 2080 Ti, 46 sur la 2080 contre 28 sur la 1080 Ti et 20, sur la 1080.

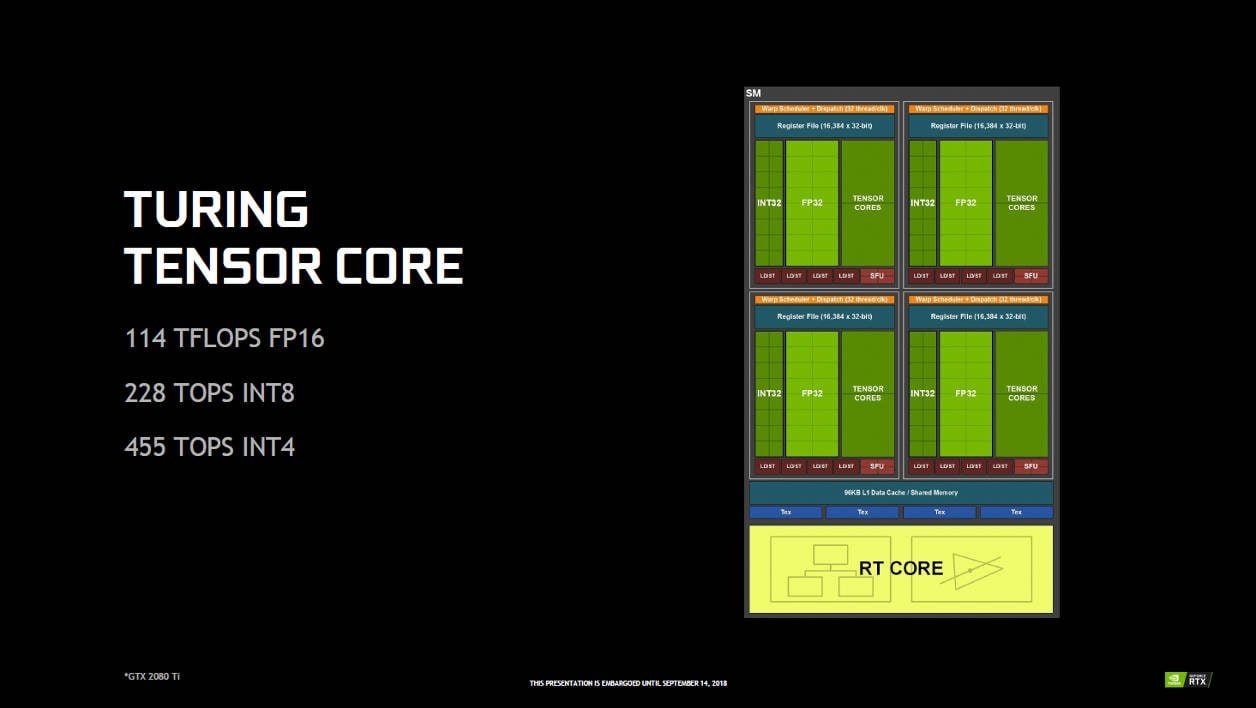

Chaque unité SM se compose de quatre parties. Celles-ci abritent deux des trois familles d’unités d’exécution de la puce (ainsi que d’autres éléments) : les CUDA Core (64) et les Tensor Core (8). Les RT Core, pour leur part, sont présents à raison de 1 par unité SM.

A la périphérie des blocs GPC se trouvent les contrôleurs mémoire, plus ou moins en nombre suivant la quantité de modules GDDR6 présents sur la carte graphique. Cela fait varier la taille de l’interface mémoire et – par extension – la vitesse de la bande passante. Viennent ensuite le GigaThread Engine, l’interface PCI-Express 3.0 et enfin, le NVLink. Hérité du monde professionnel, c’est une interface de communication, directement implantée dans la puce (à l’inverse du SLI qui utilise le PCI-Express) permettant à deux ou plusieurs cartes de fonctionner ensemble, de mettre leur mémoire vive en commun. Le NVLink a surtout la particularité d’être plus véloce que la précédente interface mais, selon les puces, les débits offerts varient (100 Go/s au mieux sur la TU102 des Quadro, 300 Go/s sur le GV100).

Turing : l’architecture « hybride » de Nvidia

Nous le disions ci-dessus, l’architecture Turing innove car elle est construite sur trois piliers majeurs, les CUDA Cores, les Tensor Cores et les RT Cores, ses trois grandes unités de calcul, comme les cartes à base de puce Volta en fait.

Les CUDA Cores :

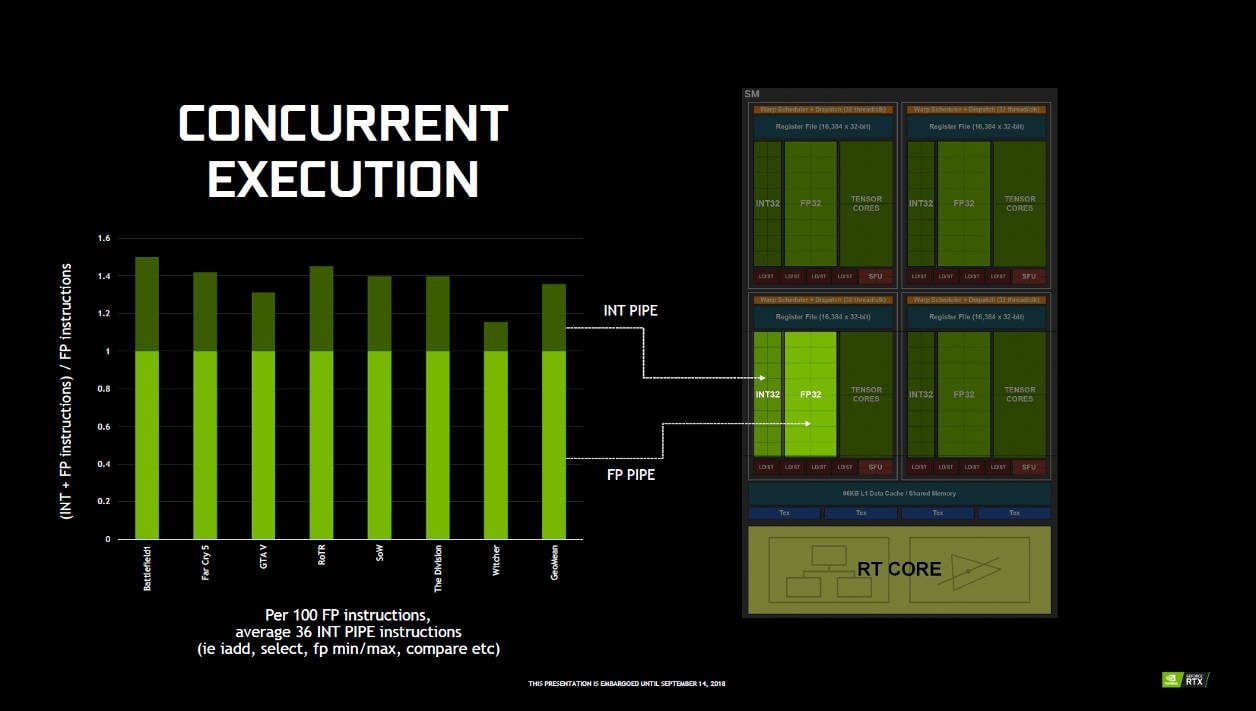

Les première unités et plus nombreuses restent les unités de calcul CUDA, chargées des calculs (Shaders, données graphiques) et des rendus 3D tels que nous les connaissons depuis longtemps. Elles sont héritées des anciennes générations de cartes GeForce mais, bien sûr, ont évolué. Elles sont maintenant de deux types (INT32, FP32 et, une troisième minoritaire, les FP64) et leur fonctionnement a été amélioré voire repensé à tous les niveaux. De l’organisation à l’exécution de tâches en parallèle en passant par la fusion et les réorganisations de la mémoire partagé et du cache L1, etc. tout a changé par rapport aux GeForce de génération 10.

C’est majoritairement grâce aux changements apportés aux unités CUDA que Nvidia peut avancer que les RTX pourraient être jusqu’à 50% plus performantes que les cartes de génération précédente dans les jeux actuels.

Précisons que, selon nous, ces évolutions-ci constituent l’un des plus gros changements techniques que les cartes Nvidia grand public aient connu depuis les séries 400. Notons aussi que c’est grâce à ces unités toutes neuves que le concepteur peut proposer de nouveaux moyens d’améliorer encore le rendu traditionnel de nos jeux vidéo (Shading/Rasterizing).

Tensor Cores :

Ensuite viennent les unités Tensor Core. Elles ont été introduites avec l’architecture professionnelle Volta, sont spécialisées dans tout ce qui attrait à l’intelligence artificielle et exploitent l’écosystème d’outils Nvidia NGX. Sur Turing, elles fonctionnent principalement « en inférence » c’est-à-dire qu’elles savent interpréter, adapter et mettre en œuvre les fruits d’un entraînement réalisé précédemment sur des réseaux neuronaux extérieurs.

Nvidia assure avoir repris et amélioré les unités présentes dans Volta et, dans le cas des RTX, fait en sorte que leur potentiel soit d’abord mis au service des graphismes et des jeux vidéo. La première application concrète est le DLSS (Deep Learning Super-Sampling).

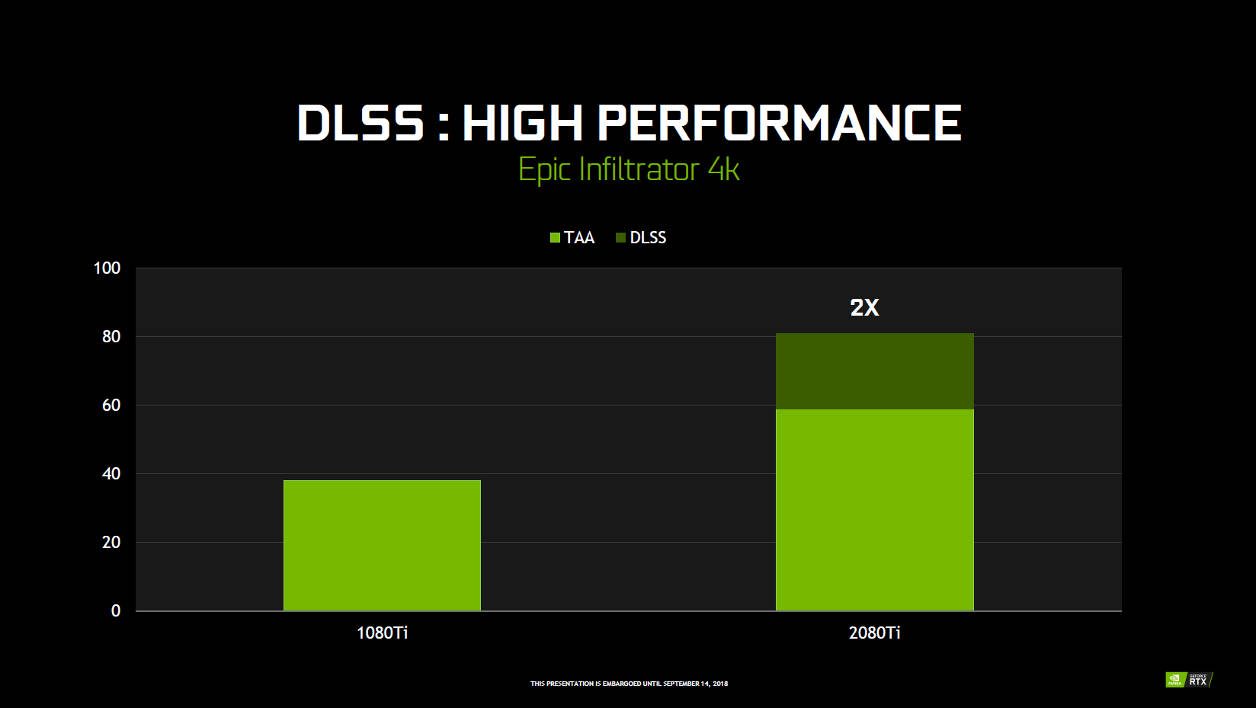

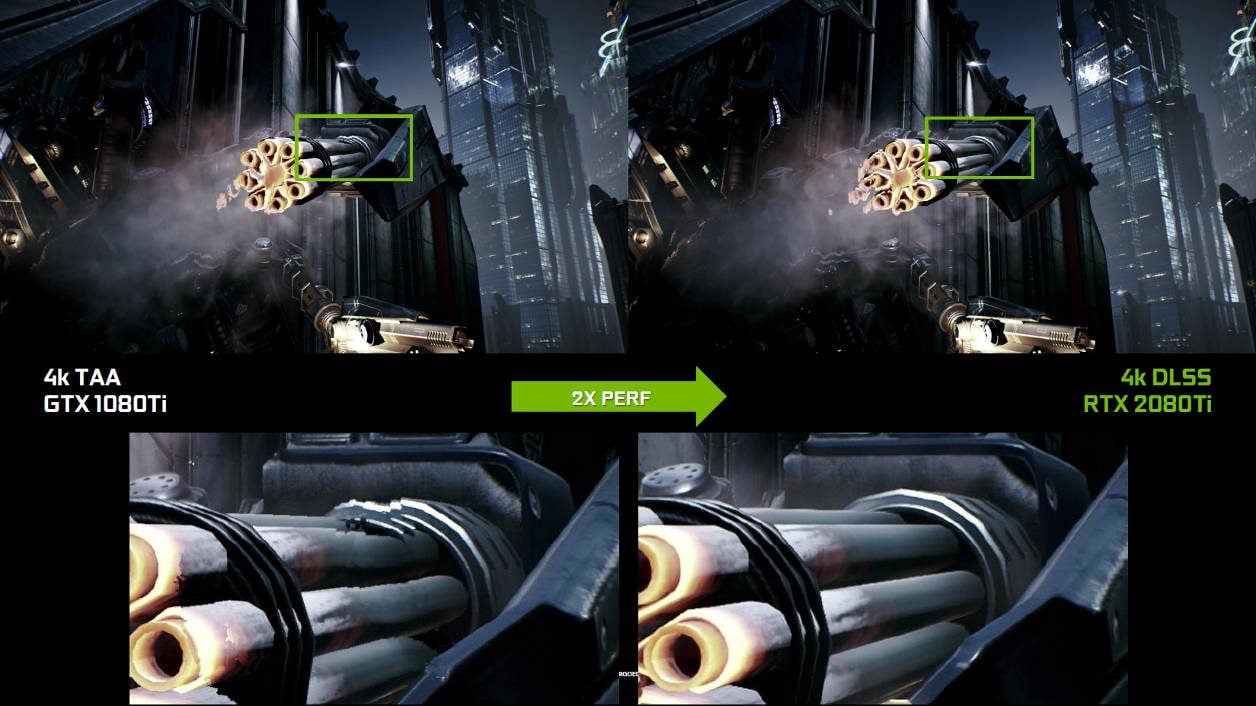

C’est un procédé d’amélioration de l’image, dopé à l’IA, qui offre une qualité de rendu supérieure et qui permettrait à une RTX 2080 Ti de générer jusqu’à deux fois plus d’images par seconde qu’une GTX 1080 Ti qui exploite – elle – un traitement antialiasing temporel (TAA) de la même image.

RT Cores :

Parlons maintenant des RT Core des GeForce (et Quadro) RTX. Ces unités ont la lourde charge de faciliter, de prendre en charge et d’accélérer le rendu du Ray Tracing en temps réel dans les jeux compatibles, faisant appel à DirectX Ray Tracing (à venir dans la mise à jour d’Octobre de Windows 10), la prochaine mouture de Vulkan ou encore en utilisant l’actuel Nvidia OptiX.

Une opération qui, jusqu’à présent, était quasi impossible à réaliser par les cartes 3D grand public.

Seuls les modèles professionnels en étaient capables, pas toujours en temps réel, et à condition, en plus, de focaliser toute leur puissance sur cette tâche.

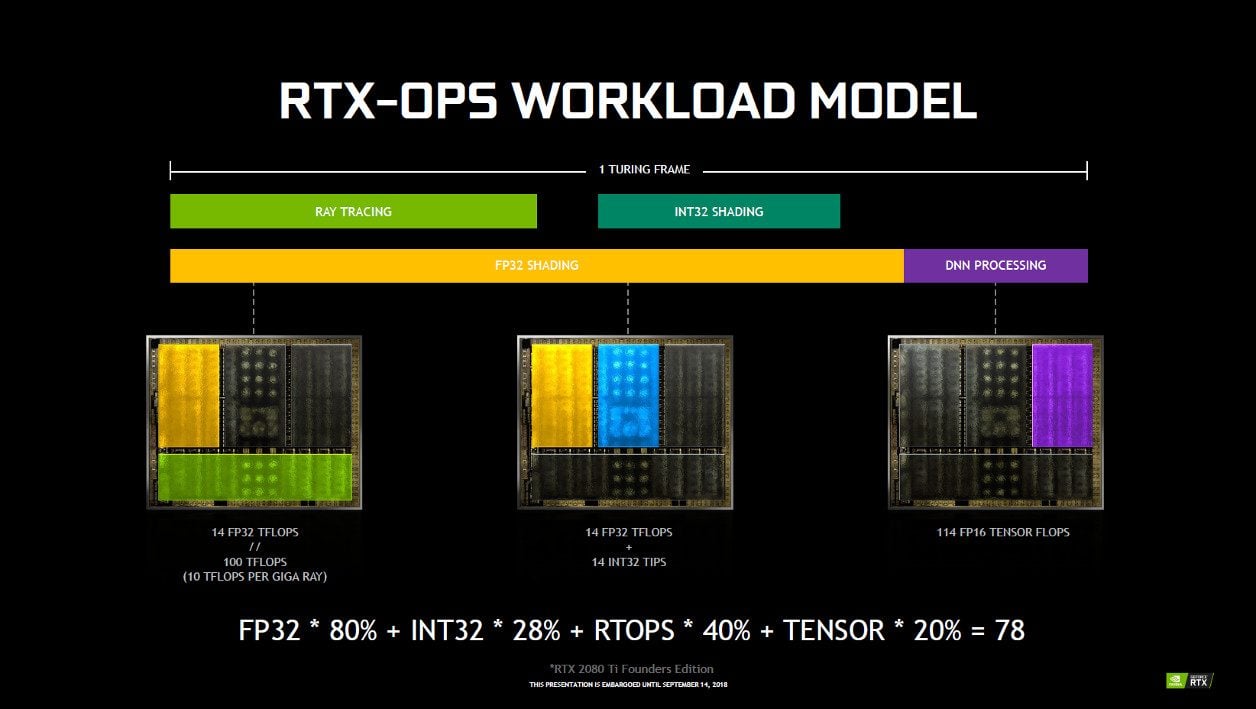

CUDA Cores + RT Cores + Tensor Cores = RTX-OPS

Pour quantifier la puissance globale développée par une GeForce RTX lorsque l’on mobilise les différentes familles d’unités, Nvidia a créé l’indice RTX-OPS. On le trouve sur les fiches techniques des nouvelles GeForce, aux côtés des traditionnelles données (fréquences, nombre de cœurs, consommation, etc.). A titre indicatif, Nvidia l’a aussi calculé sur les Séries 10 afin de montrer l’ampleur du fossé entre les deux générations.

Etabli par Nvidia, le RTX-OPS est le fruit de plusieurs heures de tests et de longues analyses du comportement de la puce Turing. Il est calculé, comme on le voit sur le schéma ci-dessus, selon un certain pourcentage moyen d’occupation des unités quand celles-ci travaillent sur une image complexe faisant appel aux CUDA Cores (INT32 et FP32), aux RT Cores et aux Tensor Cores.

Par exemple, le RTX-OPS de la 2080 Ti est donné pour 76 sur les modèles de base, 78 sur les Founders Edition (FF). Une différence qui s’explique par la fréquence en GPU Boost atteint par la puce, plus élevée sur les modèles FF que sur les autres, on le rappelle. En comparaison, la GeForce GTX 1080 Ti obtient, elle, un score RTX-OPS de 11,3.

La RTX 2080 se voit attribuer l’indice 57 pour les modèles classiques, 60 pour les cartes FF (contre 8,9 pour la GTX 1080) et, enfin, la RTX 2070 culmine à 42/45 quant à la GTX 1070, elle doit se contenter de 6,5.

Le futur de la 3D est en marche

L’arrivée de Turing marque clairement un nouveau départ dans le monde de la 3D grand public pour Nvidia. Le concepteur GPU n’est toutefois pas parti d’une page blanche pour concevoir son architecture Turing : elle est très largement inspirée par Volta, fruit d’années de recherches sur l’IA et le ray tracing conjuguées à celles passées à concevoir des puces pour satisfaire les besoins de puissance, sans cesse croissants, du juteux marché du gaming sur PC.

Turing incarne toutefois une nouvelle base, forte, dont découleront les prochaines générations de puces pour GeForce, comme l’ont été – en leur temps – les architectures Tesla (GeForce 8000) ou Fermi (GTX 400).

Grâce aux RTX et à Turing, Nvidia espère aussi creuser un peu plus le fossé qui sépare actuellement les GeForce et les Radeon d’AMD et ainsi conserver sa position de leader sur le marché des cartes graphiques. Surtout que les rouges ne sont plus les seuls dont il faut observer les progrès et avancées en la matière ! Intel a en effet son intention de revenir sur le marché du GPU dédié d’ici 2020.

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.