Et de deux ! Après avoir longtemps résisté, Google a fini par ajouter un second module caméra à ses téléphones. Outre le traditionnel grand-angle hérité du modèle précédent, qui conserve sa focale et sa définition d’origine (éq. 28 mm, 12 Mpix), les Pixel 4 et Pixel 4 XL reçoivent un nouveau module caméra téléobjectif. Plus riche en photosites – 16 Mpix – il est équivalent à un 45 mm, ce qui confère à l’appareil un coefficient de zoom de x2… selon les équipes de Google (en vrai, le coefficient est de x1,6). Dans les faits, le zoom est plus puissant que cela, puisque Google fait appel à la photographie computationnelle pour améliorer tout cela (lire plus loin).

Le module caméra principal profite toujours d’un capteur Dual Pixel (Samsung ?) aux spécifications similaires à celui de la génération précédente. Le module est toujours stabilisé optiquement – en plus des algorithmes de stabilisation électronique –, fait les mêmes dimensions (format 1/2.55’’, photosites de 1,4 micron). Si le capteur ne bouge pas, l’optique semble avoir été un poil améliorée puisque son ouverture (fixe) passe de f/1.8 sur les Pixel 3 à f/1.7.

SuperRes Zoom : faire d’un zoom x2 un zoom x8

Le nouveau module caméra téléobjectif équivaut à un 45 mm ouvrant à f/2.4 stabilisé optiquement. Son capteur est plus petit et ne profite pas de la même structure Dual Pixel ultra rapide à faire le point, même s’il intègre des pixels de détection de phase à sa surface. Les photosites sont plus petits que ceux du module principal – 1 micron –, ce qui limiterait la qualité des résultats dans un usage « standard ».

Mais Google ne fait jamais un usage « standard » de ses modules. Le Pixel 4 embarque une palanquée d’algorithmes à la sauce « Mountain View » pour dépasser certaines limites, comme le zoom. Un zoom que Google promet extraordinaire grâce à la combinaison d’images. Le téléobjectif assemblerait plusieurs images à chaque prise de vue pour proposer un zoom x8 « de qualité ». Sur les premières images partagées par Google, il faut bien avouer que le rendu semble excellent, compte tenu de la focale initiale. Il faudra cependant comparer à des champions du zoom – comme le P30 Pro de Hauwei – pour savoir si le logiciel a fini par triompher du matériel.

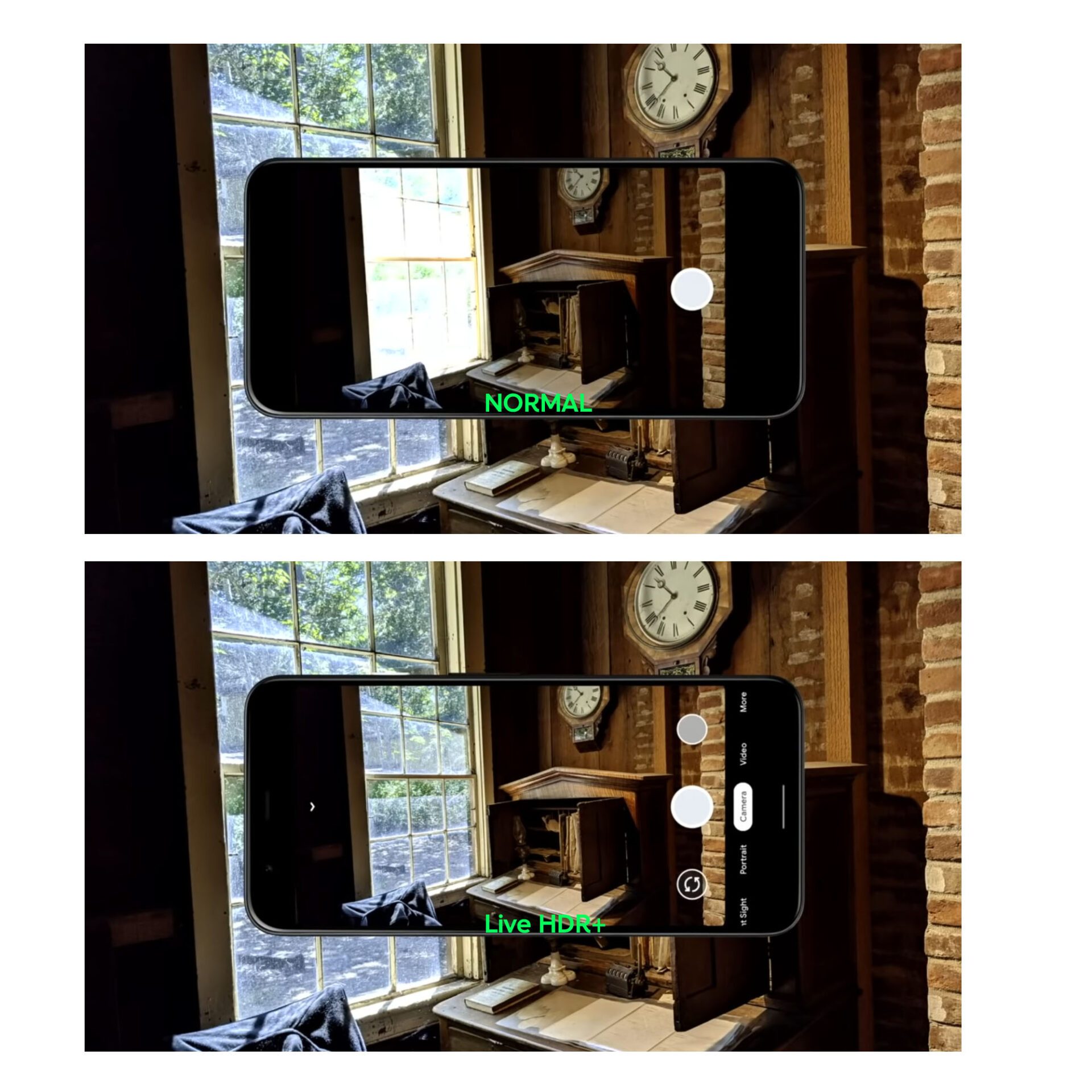

Live HDR+ : meilleure prévisualisation du rendu final

Les Pixel 3 faisant déjà largement appel à la photographie computationnelle pour délivrer des clichés de qualité, avec des ombres débouchées et des hautes lumières aux détails préservés – un mode appelé HDR+. Ce mode s’appelle désormais « Live HDR+ », la mention « live » faisant référence à la qualité de la prévisualisation. Par le passé, l’appareil photo des Pixel 3 affichait une image non améliorée, shootait ses images, les assemblait, les enregistrait sur la mémoire interne et l’image ainsi produite était différente de l’image perçue.

Le gain de puissance apporté non seulement par le Snapdragon 855 mais aussi par le Neural Core maison de Google permet aux Pixel 4/4XL d’afficher en temps réel ce à quoi l’image finale ressemblera, ce qui évite les surprises au moment du shoot.

Google a aussi peaufiné l’ergonomie et la souplesse d’utilisation du HDR+. On a enfin la possibilité, pendant la prise de vue, de modifier la luminosité et les ombres pour éviter d’être cantonné à un rendu d’image surnaturel. Ici, Google donne plus de latitude d’interprétation personnelle de l’image au photographe qu’Apple ou Huawei.

Night Sight : photographier la Voie lactée

La vision de nuit (Night Sight) du Pixel 3 était l’une des meilleures de l’industrie et elle s’améliore encore avec les Pixel 4. La promesse est ici rien de moins que de pouvoir faire des photos de ciels étoilés. Là encore grâce à la photographie computationnelle, le Pixel 4 assemble de très nombreux clichés à des valeurs d’exposition différentes pour produire de belles images.

Un procédé plus complexe que le simple empilement de photos: outre l’aspect purement combinatoire, le Pixel 4 analyse les portions d’image pour faire varier les expositions, créer une cartographie des pixels chauds (phénomène causé par la montée en sensibilité qui fait exploser le bruit numérique), analyse les couleurs, maintient les zones d’ombre, etc.

L’ancien professeur de Stanford qui dirige les équipes de Google, Marc Levoy, a au passage fait la promesse que le mode Night Sight pourrait aller encore plus loin via de prochaines mises à jour logicielles. En montrant une scène où la lune, aux blancs cramés, brille intensément plus que les zones d’ombres – il parlait de 19 stops soit un différentiel d’illumination de 1 pour 524288 ! – il a invité l’audience à « rester à l’écoute ». Sous-entendant que ses équipes sont sur la voie d’offrir, un jour, à ses Pixel 4 le moyen d’exposer correctement tous les éléments d’une telle scène. Là encore, pour Google, tout est affaire de software.

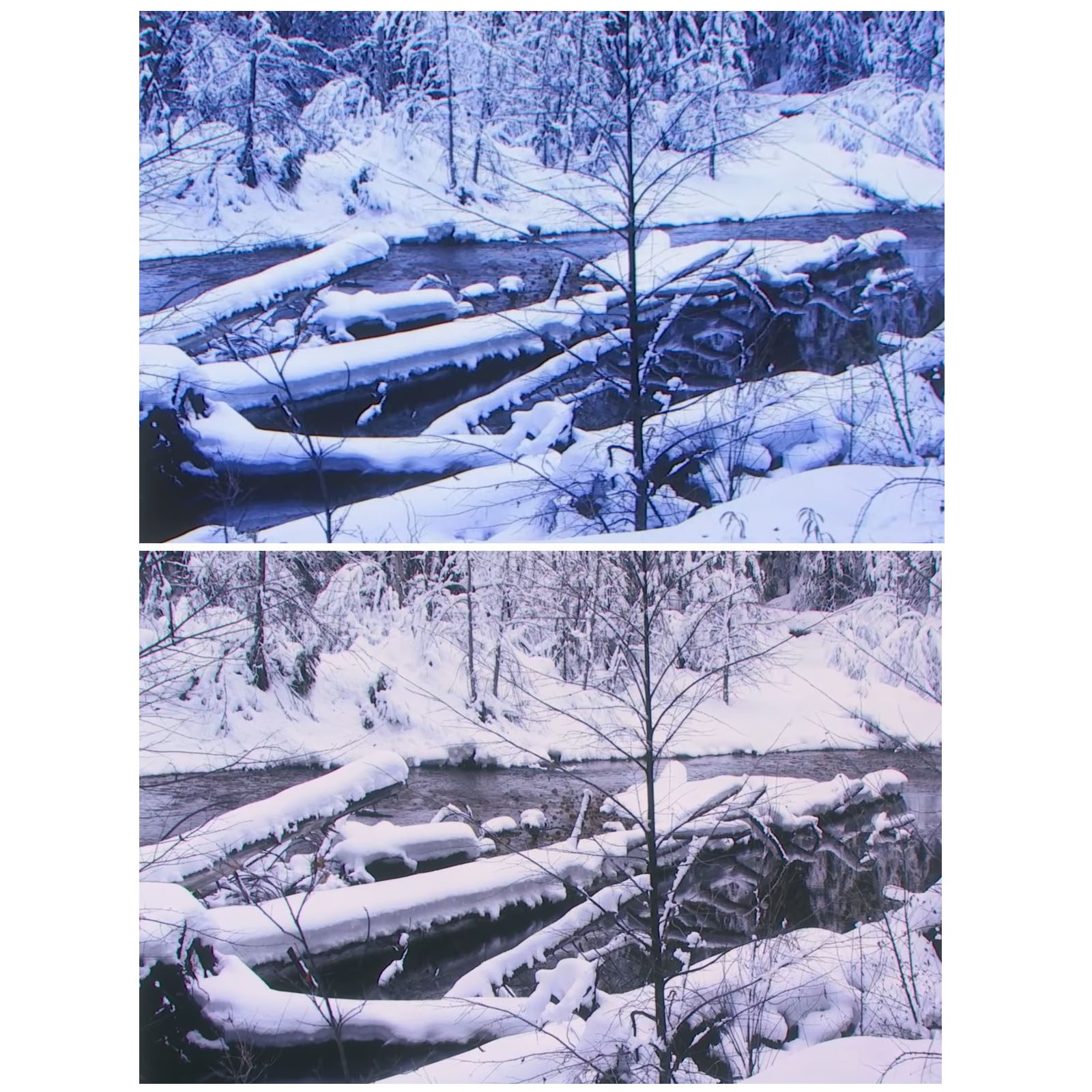

Des couleurs encore meilleures de nuit comme de jour

Le premier mode Night Sight avait contraint les ingénieurs de Google à se pencher sur la balance des blancs de manière très approfondie, afin de trouver des moyens d’évaluer la nature des couleurs en très basses lumières. Ce savoir-faire a été étendu à la photo de jour : en identifiant la nature des scènes (apprentissage profond) et leur contenu (sémantique), les Pixel 4 savent qu’ils sont en train de photographier un paysage enneigé (par exemple), et qu’ils doivent ainsi retirer le voile bleu qu’une balance des blancs traditionnelle fait apparaître. Dans un autre exemple, on voit la carnation d’une femme photographiée dans une grotte de glace passer du bleu à une couleur naturelle.

Il faudra cependant attendre un vrai test afin de savoir si les algorithmes ont toute la finesse requise, le risque étant que l’interprétation techniquement juste des couleurs gomme l’ambiance des éclairages.

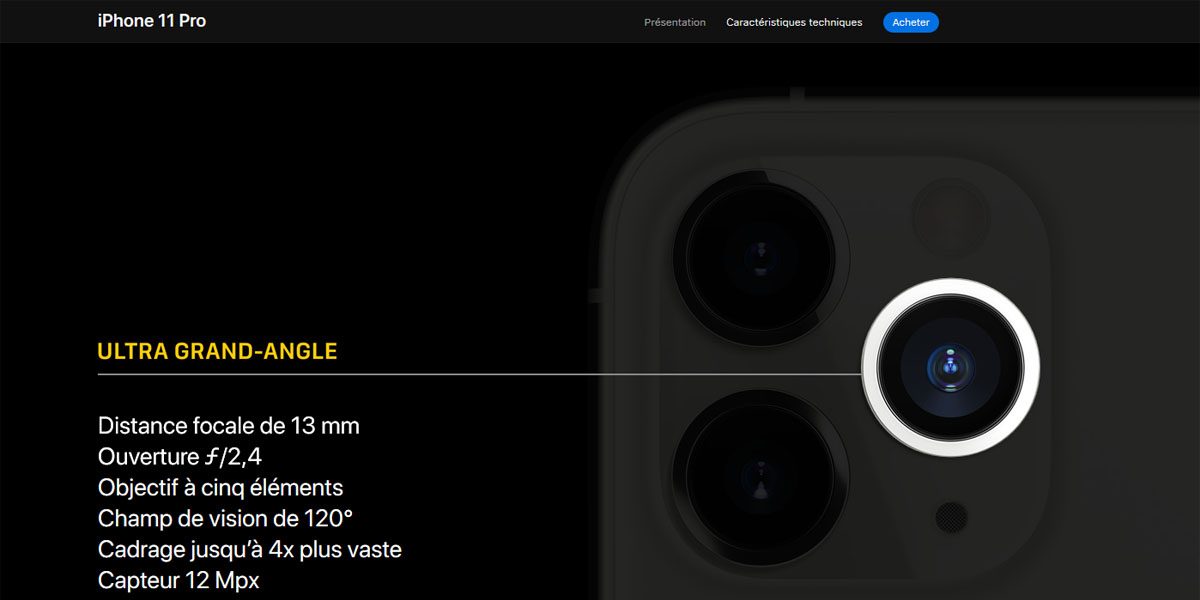

Ultra grand-angle : le grand absent

Une phrase de la conférence nous a fait bondir : pour justifier l’absence de module ultra grand-angle, le Pr Levoy a affirmé que « si le grand-angle peut être fun, nous pensons que le téléobjectif est plus important ». Que Google et ses équipes le pensent, c’est une chose (le problème étant au passage que les géants de la Silicon Valley ont une fâcheuse tendance à vouloir penser à notre place).

Le hic pour Google cette fois, c’est que si c’est leur droit le plus strict que de le penser, le marché leur donne tort. De Samsung jusqu’à Apple, qui a longtemps résisté à cette focale, tout le monde ou presque propose de l’ultra grand-angle en 2019. Et pour une bonne raison : s’il peut être « fun » pour de nombreuses personnes, l’ultra grand-angle est aussi utile. Que ce soit dans la petite cuisine de mémé pour faire une photo de famille lors de son anniversaire, ou face au paysage lunaire des Badlands, la couverture angulaire de l’ultra grand-angle peut produire des images uniques.

Si LG a longtemps fait cavalier seul dans le domaine (rappelez vous du LG G5 en 2016), les progrès technologiques des fournisseurs d’optiques – ainsi que ceux des algorithmes de correction des défauts – font qu’il est aujourd’hui facile de proposer un module caméra ultra grand-angle qui produise des images de qualité sur un téléphone.

Dernier argument qui contredit Google : les promesses du Night Sight paraissent limitées par la focale. Car les ultra grand-angles, en embrassant une plus large portion du ciel, produisent des images encore plus saisissantes de la Voie lactée que « simples 7 grand-angles. Le duo Night Sight et ultra grand-angle avait de quoi faire saliver plus d’un amateur de la voûte céleste, mais ça ne sera pas pour cette année.

Annie Leibovitz, caution photographique

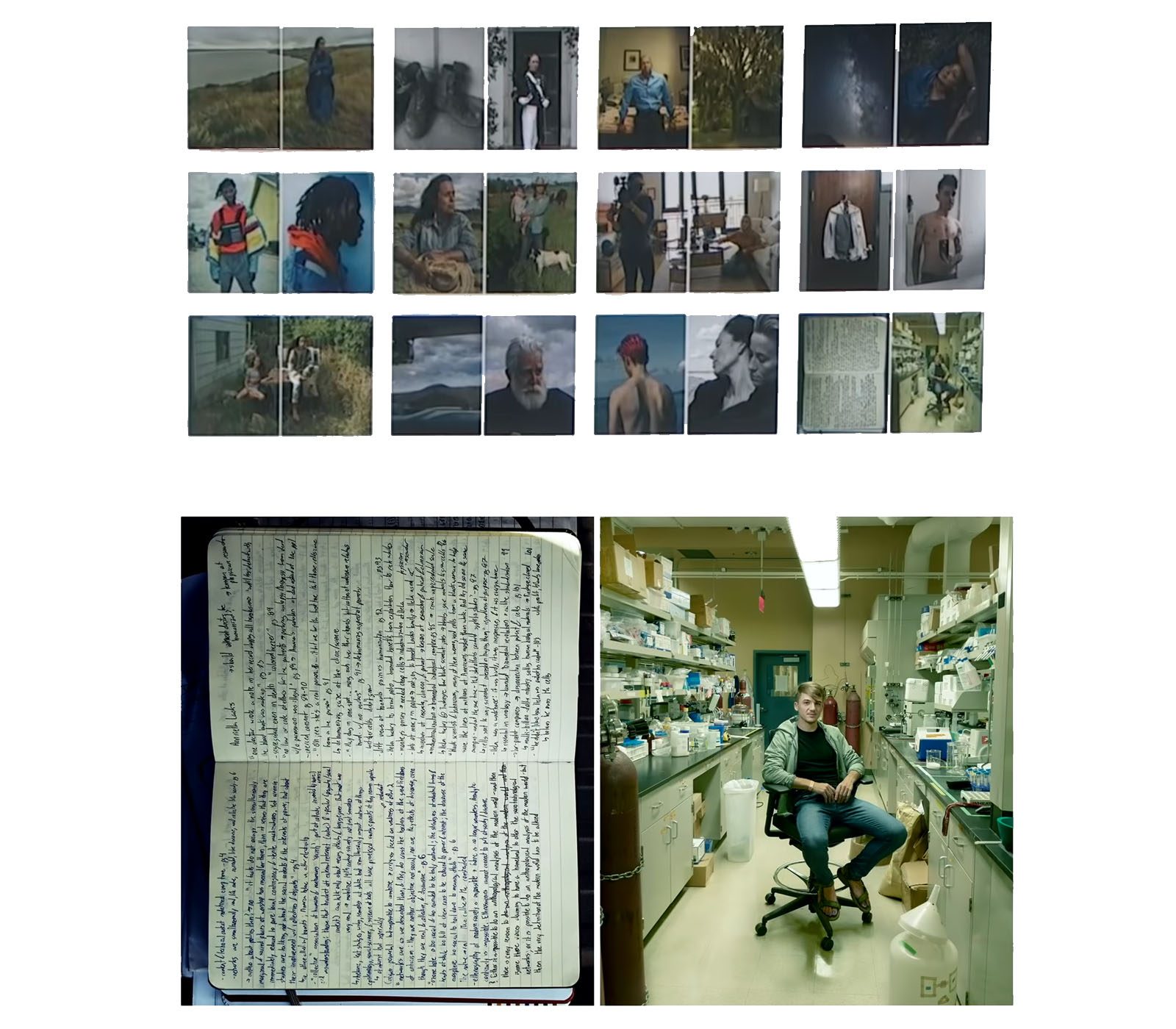

La portraitiste américaine Annie Leibovitz a été à nouveau invitée par les équipes de Google Pixel à venir parler de photographie. L’artiste américaine, connue pour ses portraits glamours – et ses shootings à plusieurs dizaines de milliers de dollars – est venue parler des qualités photographiques du Pixel 4. Un terminal avec lequel elle s’est sentie « en totale confiance » contrairement à un Pixel 3 envers lequel elle était « suspicieuse », tout du moins au début. Le travail que l’artiste a présenté était de qualité, notamment son approche des portraits en diptyque.

Le choix d’une portraitiste comme caution photographique a du sens pour un terminal qui préfère le téléobjectif à l’ultra grand-angle. Doublement du sens, puisque le travail de l’esthétisation des corps de Mme Leibovitz – qui lui a parfois valu des controverses, comme le portrait de Demi Moore nue enceinte – colle à la génération Instagram.

Mais photographes du dimanche attention : Annie Leibovitz travaille avec de nombreux assistants, souvent en lumière contrôlée (spots, flashes, etc.) et a plus de 50 ans d’expérience dans la photo. Aussi doué soit-il, le Pixel 4 ne fera pas de vous un artiste du jour au lendemain. Mais son potentiel notamment logiciel semble lui promettre une belle place dans notre prochain Top 10 !

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.