Fort du bon accueil fait à ses processeurs Ryzen, AMD a décidé de battre le fer tant qu’il était chaud en relançant les hostilités dans le monde de la 3D fin juillet. Deux cartes graphiques haut de gamme ont donc vu le jour (enfin!) chez les rouges : les Radeon RX Vega 56 et RX Vega 64.

Ces deux cartes ont d’abord pour objectif de garnir le haut du panier, bien désert depuis deux ans chez AMD. Il y a bien eu les sorties des Radeon RX 500 il y a quelques mois mais, tout comme les RX 400 qu’elles remplacent, ces puces ne constituent que l’entrée et le milieu de gamme d’AMD.

Si AMD souhaite maintenant regagner le cœur des gamers les plus exigeants, c’est surtout l’omniprésence de Nvidia dans les PC gaming de bureau que le père des Radeon veut ébranler. Bref, les cartes graphiques Radeon RX Vega 56 et 64 vont avoir du pain sur la planche !

Pour ce faire, AMD n’a eu de cesse d’entretenir le mystère autour des Vega, laissant filtrer quelques informations de temps à autre, tout en donnant l’impression de ne pas être inquiété par les cartes concurrentes, pourtant encensées par les spécialistes et les joueurs. Pour rappel, les Vega sortent plus d’un an après les GeForce GTX Série 10 ! AMD affirme avoir mis ce temps supplémentaire à profit et assure que Vega va remettre les compteurs à zéro.

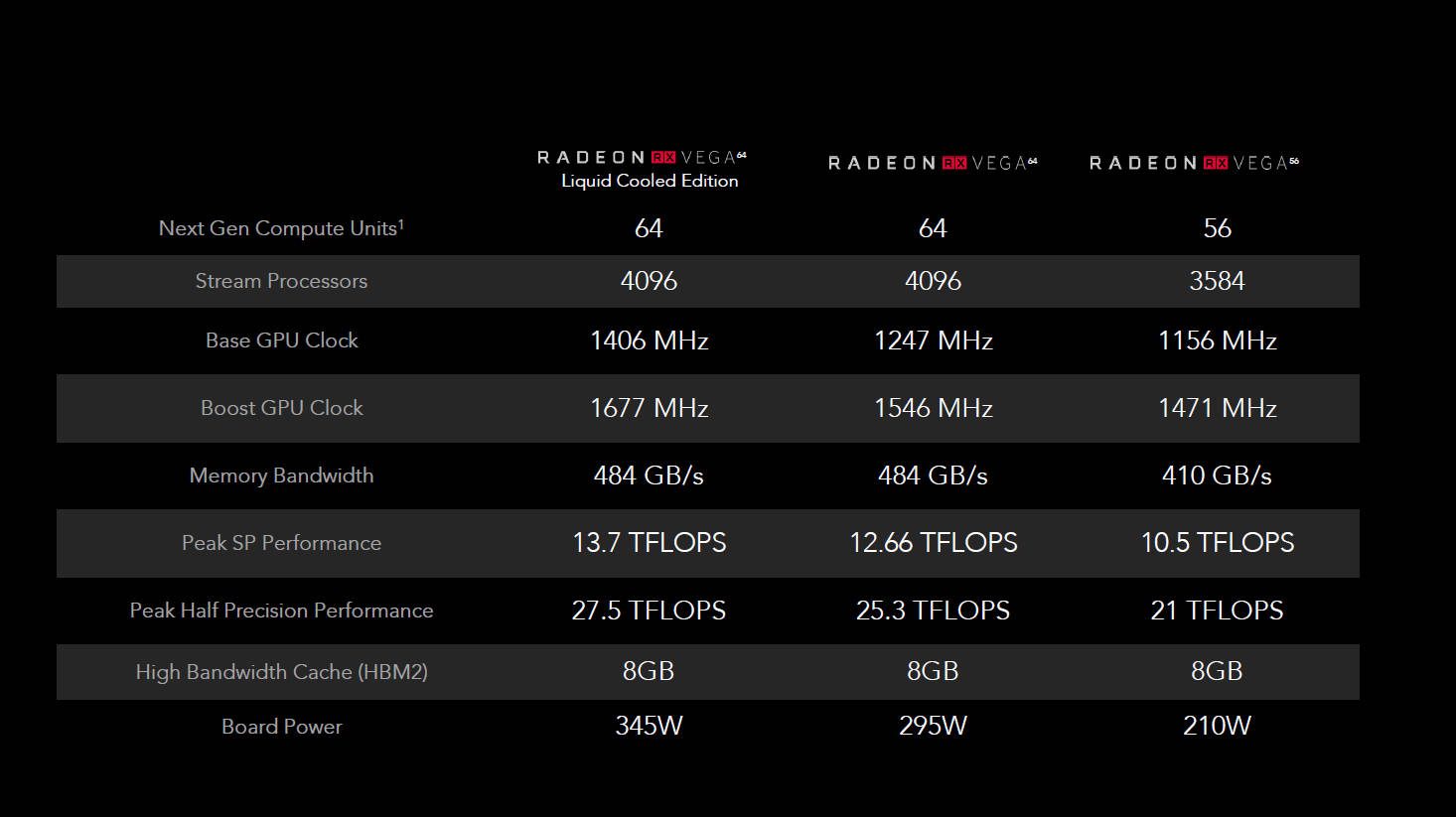

Problème, dès la présentation officielle, les premiers chiffres et graphiques avancés par AMD sont assez surprenants. Surtout du côté de la consommation, le nerf de la guerre entre AMD et Nvidia depuis des années. Sur le papier, les RX Vega avaleraient entre 210 (V56) et 295 watts (V64) !

Des données très élevées en comparaison de celles annoncées par Nvidia (180 watts maximum) ! Une consommation qui s’expliquerait par la puissance démesurée des GPU selon ses concepteurs. Allez, on y croit ! Voyons voir quelle est donc la sauce secrète qu’AMD a utilisé pour cuisiner ses Vega.

Radeon RX Vega : AMD utilise toujours la même (vieille) architecture

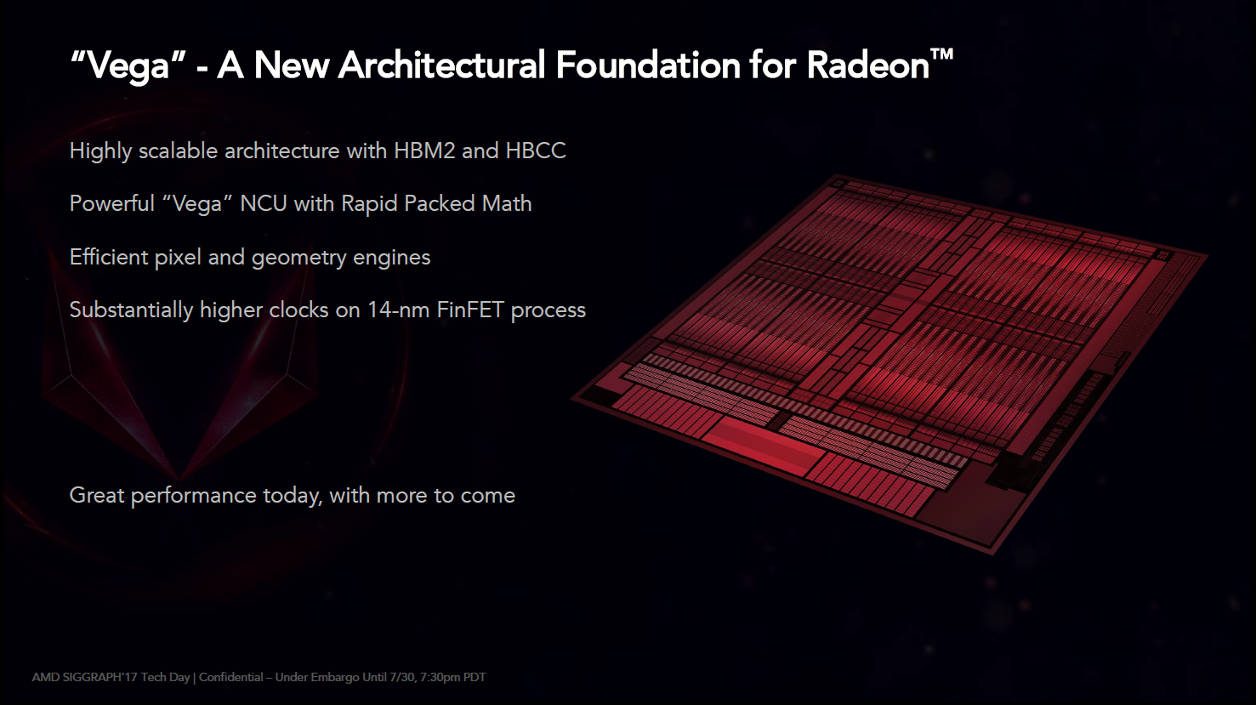

Bien qu’AMD claironne que Vega soit son plus gros changement d’architecture depuis 5 ans, il faut bien avouer que, pour notre part, nous sommes bien moins catégoriques.

Pour créer Vega, AMD utilise encore et toujours ses unités GCN (Graphic Core Next), ici dans leur cinquième itération. Le concepteur n’en fait nulle mention dans ses présentations mais la réalité est bien là ! Pour rappel, le GCN a été introduit lors du lancement des Radeon HD 7900, au tout début de l’année 2012.

En clair, depuis tout ce temps, AMD affine et peaufine son architecture. La finesse de gravure – à l’origine de 28 nm, 14 nm LPP aujourd’hui – lui permet d’incorporer plus d’unités de traitements et de nouveaux éléments relatifs à la génération de pixels et de textures (stockage de données 16 et 32 bits). C’est elle aussi qui ouvre la porte à une meilleure prise en charge de fonctionnalités DirectX 12 (notamment au niveau de la « rasterisation », la transformation d’un triangle en unité pixel). Mais objectivement, c’est tout. Pas de révolution sur le die (circuit imprimé).

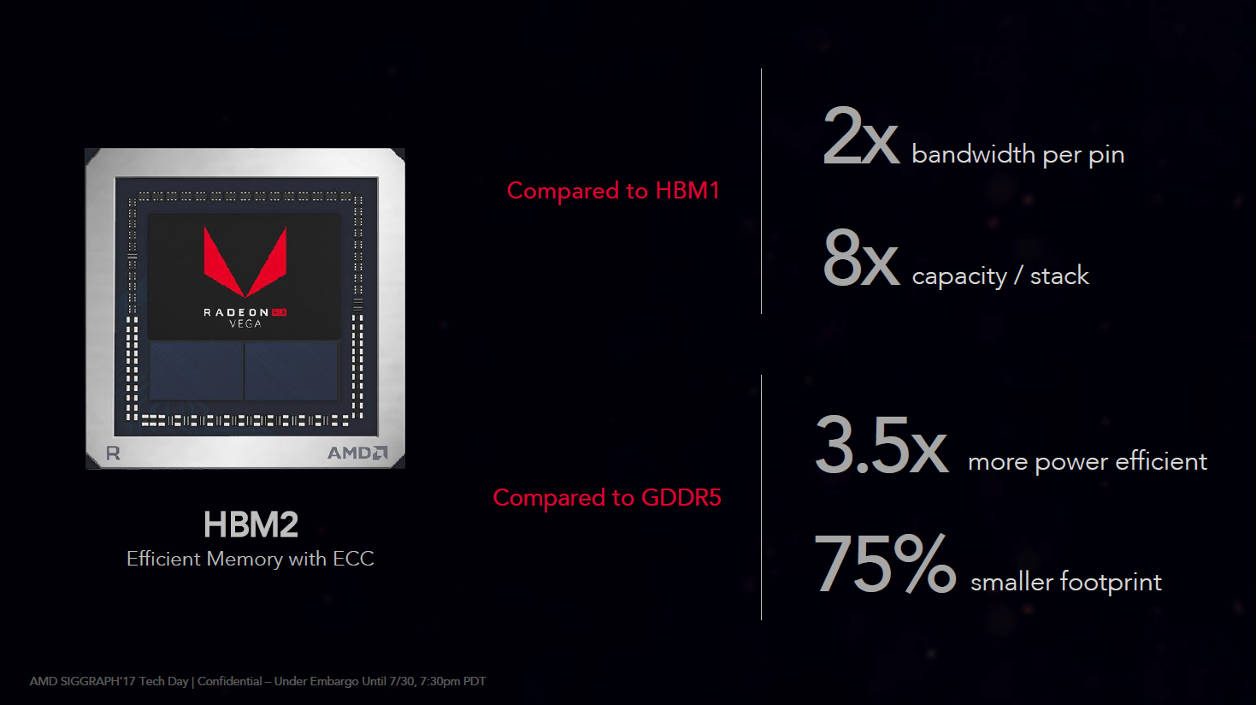

Les Radeon sont les seules à utiliser la mémoire HBM2

Là où Vega fait toutefois preuve d’originalité c’est sur le plan de la mémoire vive graphique. Pas de GDDR5 ici mais de la HBM, de la High Bandwith Memory. Introduite dans sa première génération sur les Radeon Fury X (2015), AMD réutilise cette mémoire, dans sa seconde version, sur les Vega. Gravée sur le même morceau de silicium que la puce graphique et accolée à cette dernière, la HBM2 offre des débits théoriques et une bande passante mémoire très alléchants sur le papier.

En outre, la HBM2 s’organise sous forme de couches successives, sur le même circuit et de fait, elle prend moins « de place » tout en offrant un rendement énergétique bien plus intéressant que la classique GDDR5 (3,5 fois plus économe selon AMD).

Dans le cas de nos RX Vega 56 et 64, AMD fait le choix d’accoler deux gros blocs de HBM2 de 4 Go chacun avec une bande passante de 484 Go/s pour la 64 et 410 Go/s pour la 56. Des bandes passantes supérieures à celle de la GTX 1080, donnée pour 320 Go/s par Nvidia. Dans l’écurie de ce dernier, seule la GeForce GTX 1080 Ti (utilisant de la GDDR5X) atteint 484 Go/s, une carte proposée à plus de 750 euros.

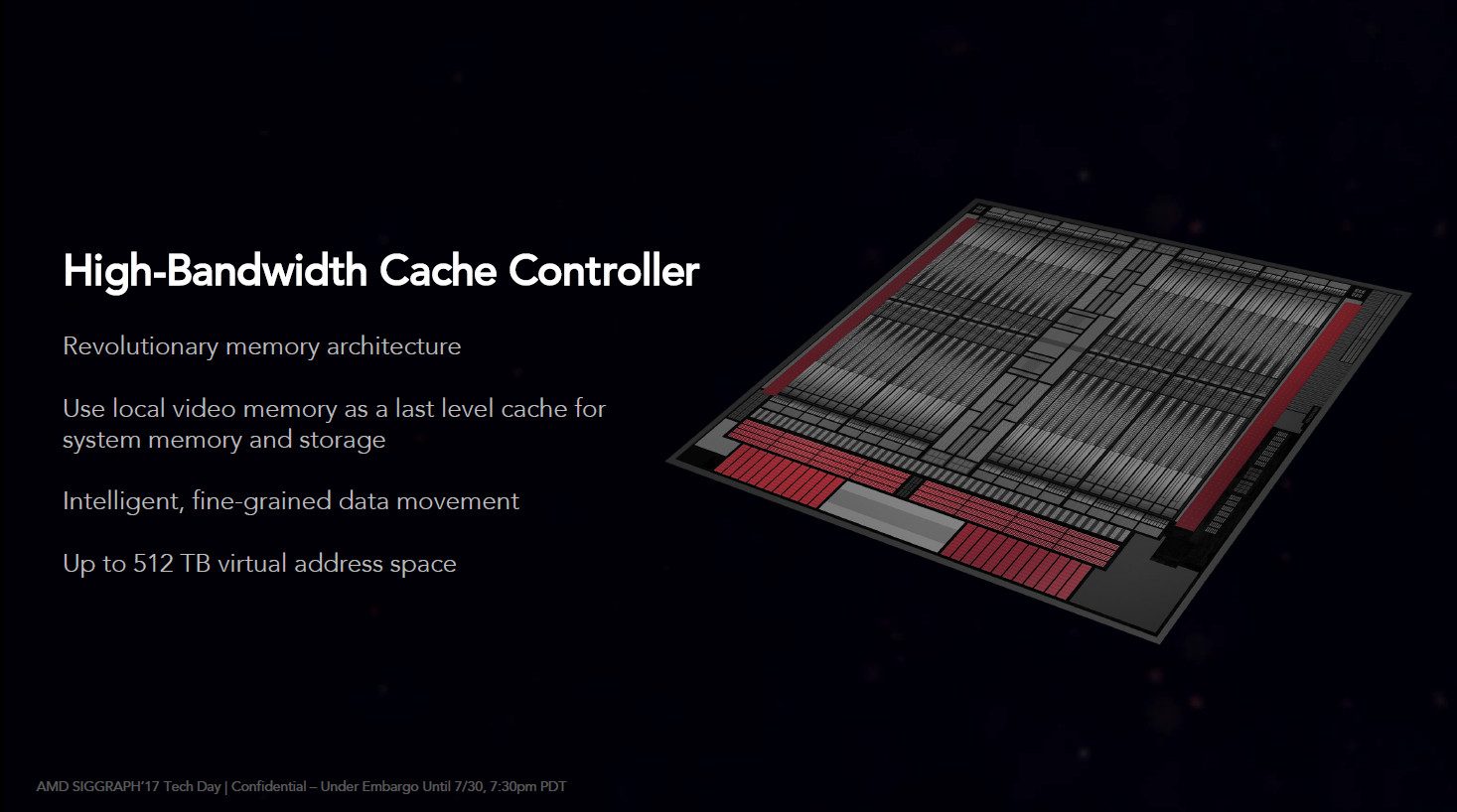

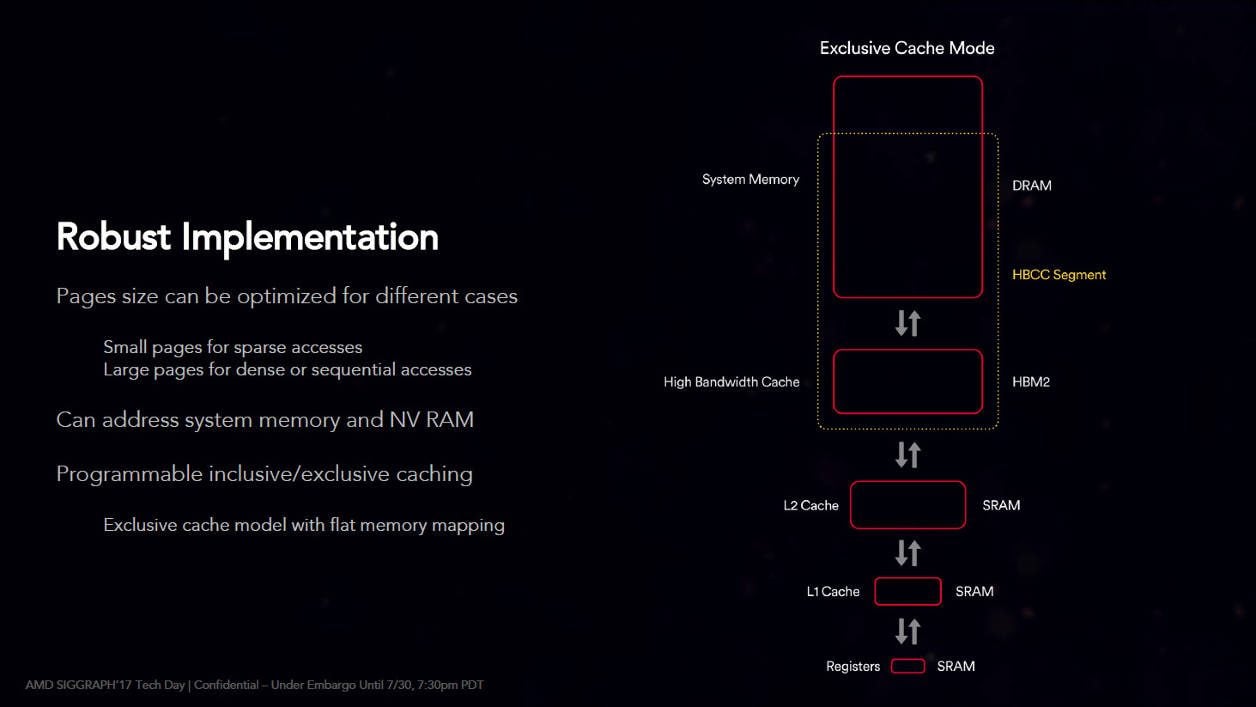

Un contrôleur mémoire polymorphe

Autre élément un peu exotique des Vega, la gestion de la mémoire par le contrôleur. Pour faire très simple, ce dernier peut se comporter de deux manières.

La première, comme celui d’une carte graphique « normale », par lequel transitent les informations envoyées par le jeu. Ce dernier se lance, envoie toutes les informations graphiques dans les tuyaux. Le contrôleur mémoire de la carte se charge alors d’allouer l’espace nécessaire requis. Il range et s’assure de placer tous les éléments dont le GPU risque d’avoir besoin par ordre d’importance et de priorité.

Deuxième manière de fonctionner : comme un contrôleur mémoire qui communiquerait avec un processeur classique (un CPU). Cela ne peut toutefois se produire qu’à condition d’activer le HBCC dans le pilote AMD.

Le HBCC (High Bandwith Cache Controler) est une technologie qui permet de « virtualiser » de la mémoire supplémentaire. Ainsi, en théorie, lorsque le jeu se lance, il se voit signifier qu’il peut stocker les informations non plus sur la quantité de mémoire physique (8 Go par exemple) mais sur celle de la mémoire virtuelle (plus importante, à définir dans le driver). C’est ensuite le GPU qui s’occupe de dispatcher les informations mais surtout de paginer la mémoire comme le ferait un duo mémoire-processeur qui communique avec un système d’exploitation.

Par exemple, prenons le cas d’un jeu très gourmand capable de saturer 8 Go de mémoire en mode « Elevé » en 1440p. Avec le HBCC, il serait possible de faire tourner ce dernier, en « Ultra » et en 4K, deux paramètres qui monopoliseraient 16 Go selon les calculs faits par les développeurs et implantés dans le code source du jeu.

Plus fort, toujours grâce au HBCC, le GPU peut à la fois stocker les données dans la mémoire de la carte graphique mais aussi, dans la mémoire (RAM) de l’ordinateur. Très intéressante et novatrice, cette technologie requiert toutefois que les développeurs de jeux s’en servent ! Oui, pour que le HBCC soit efficace, cela demande une très bonne optimisation en amont. Cependant, comme la carte graphique ne discute pas directement avec la mémoire vive du PC, il est probable que ces échanges – devant transiter par le CPU – entraînent de petits ralentissements dans les jeux non-optimisés.

Les concurrents dans l’arène

Après ces quelques éléments architecturaux et théoriques, il est temps de passer à la pratique. Comme nous le disions en introduction, nous avons comparé les dernières RX Vega d’AMD à leurs « ennemies » désignées dans l’écurie Nvidia.

Pour cela, nous avons utilisé notre plate-forme de test de référence (détaillée dans le test de la Titan X), des GeForce GTX Série 10 en version Founder’s Edition et, chez AMD, une Radeon RX Vega 56 envoyée par ce dernier. La RX Vega 64 (de marque MSI) nous a été prêtée gracieusement par l’enseigne Materiel.net, car AMD n’en avait tout simplement pas à nous fournir.

Signalons aussi que la sortie récente de la GeForce GTX 1070 Ti a rebattu les cartes. Nous avons donc choisi de l’incorporer dans notre protocole de test car sa raison d’être se résume à « contrer la Vega 56 », rien de plus.

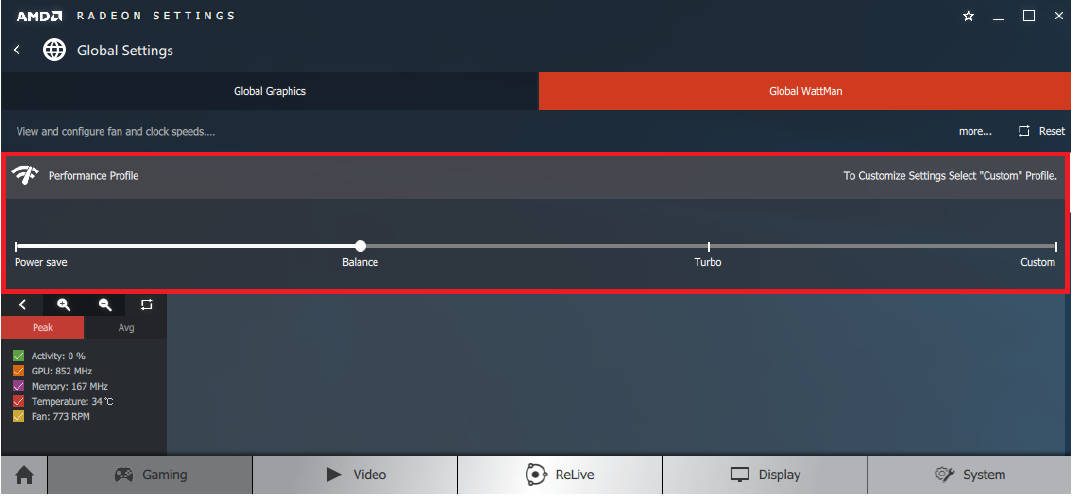

Enfin, comme pour tous nos tests, nous avons laissé le profil d’alimentation des GeForce sur « Optimisé ». Sur les Vega, nous avons utilisé le BIOS primaire et le profil « Balanced » dans les pilotes des cartes AMD Radeon.

Car, oui, d’une part, AMD embarque deux microprogrammes sur ses cartes graphiques qui s’activent en poussant un petit switch présent sur le haut de la carte.

Chacun d’eux fait appel à un algorithme de gestion de montée en charge (et donc de consommation). Le premier reste celui activé par défaut et mobilisant toutes les ressources de la carte.

D’autre part, dans le pilote Crimson d’AMD, via l’onglet « Global Wattman », il est également possible de pousser encore la carte en jouant sur différents profils voire même d’en créer un « Custom » pour agir sur différentes courbes (et donc algorithmes).

GeForce en tête, Radeon pas loin derrière

Les graphiques ci-dessous représentent des extraits choisis de nos résultats de tests.

Les moyennes évoquées ci-après et données en pourcentage sont calculées à partir de tous nos résultats, tant sur les jeux que sur les logiciels applicatifs.

- GeForce GTX 1080 vs Radeon RX Vega 64 :

Venue bouter la GeForce GTX 1080 hors de nos PC, la Vega 64 n’a pas ce qu’il faut pour y parvenir.

Dans tous les jeux de notre panel, la carte Nvidia reste en moyenne 10% plus rapide que l’AMD en Full HD et en 1440p. Sur le logiciel applicatif Heaven, la GTX 1080 se révèle même 35% plus véloce !

Il n’y a que dans Rainbow Six : Siege que la Radeon RX Vega 64 parvient presque à faire jeu égal, voire à très légèrement dépasser la carte Nvidia.

En 4K, les deux cartes graphiques sont déjà beaucoup plus au coude-à-coude. La GeForce fait tout de même la différence, à hauteur de 3,6%.

Reste que l’une comme l’autre offrent de bons niveaux de débits d’images par seconde (plus de 40 images par seconde) pour jouer en 3840 par 2160 pixels à condition de savoir raison garder sur les niveaux de graphismes et plus particulièrement sur certains filtres (Anticrénelage ou Motion Blur par exemple).

- GeForce GTX 1070 vs Radeon RX Vega 56 :

Comparons maintenant la GeForce GTX 1070 à la Radeon RX Vega 56. Ici, la tendance s’inverse, la carte Nvidia est, reconnaissons-le, un peu malmenée. En moyenne (jeux et logiciels applicatifs), celle-ci accuse un retard de 8% environ sur la Vega 56.

Dans le détail, en Full HD, les écarts tiennent dans un mouchoir de poche. La Vega 56 se révèle presque 1,3% plus rapide que la 1070 dans les jeux (toujours en moyenne).

En 1440p, la Radeon RX Vega 56 parvient, là encore, à surclasser la 1070 de… 2,2% en moyenne. AMD enfonce un peu plus le clou. A noter, dans certains (rares) jeux (DirectX 9 notamment), la Vega 56 parvient à proposer plus de 15 à 20% d’images par seconde de plus que la 1070 !

C’est en 4K que les écarts sont les plus prononcés : 5,6% à l’avantage d’AMD. Précisons toutefois que la Radeon RX Vega comme la GTX 1070 n’ont pas la prétention d’être les « références » en UHD. Elles laissent normalement ce soin à leurs grandes sœurs mentionnées ci-dessus et, dans l’écurie Nvidia, la GeForce GTX 1080 Ti demeure la meilleure carte pour afficher 3840 par 2160 pixels. Reste que, dans les faits, la RX Vega 56 pourra plus facilement s’aventurer sur le chemin de l’UHD que la GeForce GTX 1070.

Avant de clore cette analyse, impossible de ne pas mentionner l’existence de la GeForce GTX 1070 Ti et, surtout, de ses compétences en matière de 3D. Et, pour connaître nos conclusions à son propos, nous vous invitons à aller lire notre test. Nous nous contenterons simplement de teaser en mentionnant que la balance se rééquilibre en matière de « performances » pures sans que la consommation s’envole. (Oh, la belle transition).

Radeon RX Vega : des éponges à watts

Nous le mentionnions en introduction, les premiers chiffres avancés par AMD concernant la consommation nous avaient surpris. Et pas de façon positive. Sur le papier, les nouvelles Radeon partaient déjà avec un désavantage certain face aux GeForce mais rien ne vaut la vérification par un test in situ.

Nous avons donc utilisé notre wattmètre de référence, relié à notre plate-forme. Les prises de consommation ci-dessous correspondent à celles de l’ensemble notre machine. Pas des cartes seules.

Précisons aussi que nous avons ajouté un second test de montée en charge dans notre protocole. Une évaluation qui fait appel au jeu Tom Clancy’s : The Division d’Ubisoft et imaginée suite aux différents essais de réglages effectués dans les pilotes des Radeon.

Est-il besoin de commenter les résultats obtenus ? Les Radeon RX Vega 56 et 64 sont de véritables gouffres à watts. De fait, leur rapport « performance/watt consommé » est assez mauvais par rapport à celui des GeForce, n’ayons pas peur des mots.

Ainsi, avec la GeForce GTX 1080, notre plate-forme consomme jusqu’à 36% de moins qu’équipée de la Vega 64. On note aussi qu’au repos, la GeForce reste 21% plus économe. Un camouflet total pour le nouveau haut de gamme d’AMD.

Notre autre couple de duelliste réalise quasiment la même prestation. Avec la Vega 56, la plate-forme de test consomme jusqu’à 31% de plus que lorsque la 1070 officie à sa place. Un tiers de watts consommé en plus pour seulement 8% de performances supplémentaires en moyenne, c’est décevant !

Et si l’on compare, pour terminer, la GeForce GTX 1070 Ti à la Vega 56, la carte Nvidia conserve son avance (d’une courte tête) sur sa concurrente AMD, en consommant jusqu’à 19% de moins en jeu et 15% de moins au repos.

Nous entendons déjà les porte-paroles d’AMD nous dire que « les joueurs ne sont pas très attachés à la consommation. Ce qu’ils veulent, ce sont des performances époustouflantes dans les jeux ». Peut-être. Nous avons toutefois une conscience écologique chez 01net.com, ne vous en déplaise !

Alors, quand on peut avoir un très bon débit d’images par seconde sans avoir à réinvestir dans une alimentation ni revoir toute la ventilation de sa tour pour en profiter – sans parler de craindre une petite augmentation de la facture d’électricité -, c’est quand même, selon nous, bien mieux !

Du bruit et de la chauffe

Lors de nos tests, nous avons découvert que les Radeon RX Vega 56 et 64 étaient loin d’être des modèles de discrétion. Leur ventilateur a tendance à s’affoler dès qu’un jeu est lancé et monte très rapidement dans les tours. D’ailleurs, en parlant de tour, mieux vaut que celle qui héberge les Radeon soit bien ventilée.

Les cartes chauffent vite et fort. Les sondes internes à la carte montent en flèche et la température fluctue au rythme du ronron des ventilateurs. D’autre part, dès que l’on place la main à portée du circuit, la chaleur est omniprésente. Moins sur la 56 que sur la 64 toutefois. Cela reste toutefois une preuve tangible que les calories sont présentes en nombre et que le système de ventilation doit se donner à fond pour éviter que la puce ne throttle à cause de la chaleur.

Affirmer que les GeForce ne produisent aucun bruit serait inexact. Elles ronronnent mais toutes restent quand même bien plus discrètes que les Radeon, même lorsqu’on les stresse énormément.

Et, côté mercure, l’ensemble du circuit de la GTX 1080 dégage aussi de la chaleur mais cela se ressent moins, et les valeurs relevées par les sondes internes font moins le yo-yo dans les jeux.

Plus chères, les GeForce restent le meilleur choix

Parlons prix. Au lancement, le positionnement tarifaire d’AMD se tenait : 399 dollars pour la 56 et 499 dollars pour la 64. Mais, à leur sortie respective (le 14 août pour la 64, fin août pour la 56), la disponibilité était très faible et plusieurs offres promotionnelles venaient un peu fausser la donne. Il a fallu attendre la toute fin septembre pour que les magasins commencent à avoir quelques pièces en stock et donc y voir un peu plus clair.

Les prix actuels sont de l’ordre de 460 à 540 euros pour la Radeon RX Vega 56 suivant les marques et les boutiques.

La Radeon RX Vega 64, elle, voit les chiffres de son étiquette varier entre 570 à 700 euros, voire 710 à 720 euros pour la version watercoolée. Et toutes les cartes sont des modèles de référence !

Aucun partenaire d’AMD n’a encore pris (le risque ?) sur lui de sortir un modèle customisé sur le marché. Deux hypothèses à cela : soit parce que les puces ont du mal à sortir des usines de fabrication ; soit parce qu’elles demandent beaucoup d’optimisation de fréquence et de travail au niveau des étages d’alimentation et de la ventilation dès que l’on veut les overclocker. De fait, si de tels modèles venaient à sortir, leur prix pourrait crever le plafond… sauf si AMD consent à casser le prix de ses puces pour récompenser ses partenaires aventureux.

Quoi qu’il en soit, ces cartes Radeon sont chères. Bien trop chères pour ce qu’elles ont à offrir. Et encore aujourd’hui, la disponibilité demeure vraiment aléatoire. Difficile de se poser en concurrent sérieux quand les produits manquent à l’appel.

Chez Nvidia, la GeForce GTX 1070 est proposée à 430 euros sur le site de Nvidia. Les prix s’échelonnent entre 430 et 570 euros suivant les modèles customs dans le commerce.

La GeForce GTX 1070 Ti – sortie il y a quelques jours – affiche un prix de départ de 470 euros sur le site de Nvidia et coûte jusqu’à 600 euros en modèle customs.

Quant à la GTX 1080, Nvidia la propose à 600 euros sur son propre site. En matière de modèles personnalisés, le premier prix est de 550 euros, et certains montent jusqu’à 700 euros (en air cooling).

Alors oui, les prix sont plus élevés chez Nvidia. Surtout sur les modèles customs, ceux qui se vendent majoritairement en magasin. Mais comme les cartes sont plus performantes, plus silencieuses et consomment moins, cela vaut le coup d’investir quelques (dizaines) d’euros de plus selon nous.

Bilan, à l’heure actuelle, craquer pour une Radeon RX Vega s’envisage difficilement. Sauf si l’on est un fan absolu de la marque ou que l’on possède un écran AMD FreeSync (le pendant du Nvidia G-Sync).

AMD doit vraiment changer d’architecture une fois pour toutes pour espérer faire la différence et passer devant Nvidia. Et le concepteur rouge aurait plutôt intérêt à ce que sa prochaine génération de puces (Navi) soit une vraie rupture technologique. Car, Nvidia, de son côté, a déjà prévu de présenter ses nouvelles GeForce l’année prochaine, basées sur l’architecture Volta.

En attendant la relève, privilégier les cartes Nvidia reste le mieux à faire si vous deviez changer une carte graphique vieillissante. Les GeForce GTX 1070/1070 Ti proposent le meilleur rapport performance/prix/consommation que ce soit pour jouer en 1080p ou 1440p. Si vous souhaitez vous faire plaisir et vous aventurer – à court ou moyen terme – sur les sentiers de la 4K dans des conditions correctes et sans exploser votre tirelire (avec une 1080 Ti), alors la GTX 1080 reste toujours un excellent choix.

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.