Voitures autonomes, jeux de stratégie, reconnaissance faciale, traductions de langues… L’intelligence artificielle a fait d’énormes progrès durant ces dix dernières années. Deux voies ont particulièrement été couronnées de succès, à savoir l’apprentissage automatique profond, avec ses réseaux neuronaux multicouches et l’apprentissage par renforcement. Les premiers ont particulièrement fait des étincelles dans la reconnaissance d’image, le second s’est imposé dans l’univers des jeux. Mais ces techniques commencent déjà à montrer leurs limites.

Ainsi, l’apprentissage profond repose sur la disponibilité d’une grande masse de données étiquetées. Ça tombe bien : la multiplication des capteurs permet de générer beaucoup de données pour certains problèmes.

Mais il existe des cas pour lesquels les données sont rares ou difficiles à générer. Inversement, si les données sont vraiment très nombreuses, l’étiquetage devient compliqué. Celui-ci, en effet, est toujours fait à la main. Or, « on ne peut pas transformer notre population en étiqueteurs de données pour les machines », a justement souligné Joëlle Pineau, co-directrice du laboratoire en intelligence artificielle Facebook FAIR, à l’occasion d’une conférence organisée à Paris.

La voie de l’apprentissage par renforcement a également ses limites. Pour arriver à de bons résultats, cette technique nécessite un très grand nombre de cycles d’essais/erreurs.

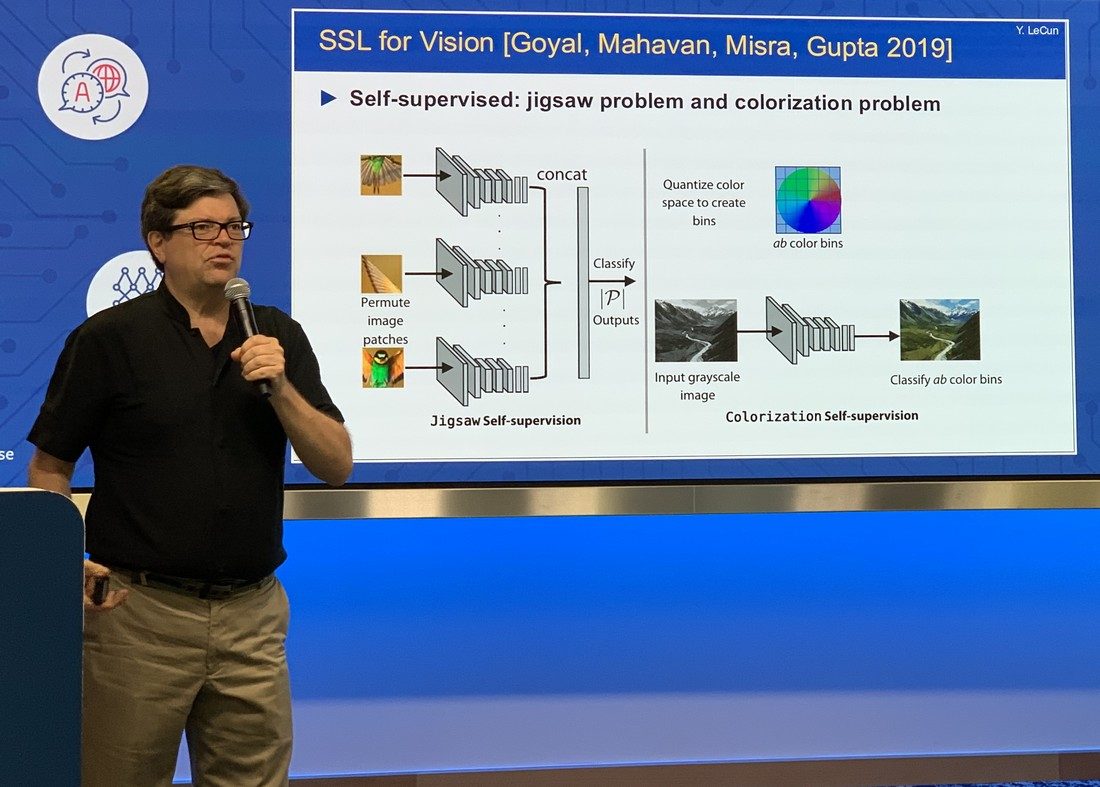

« Les travaux de Google DeepMind sur le jeu StarCraft montrent qu’il faut l’équivalent de 200 ans pour atteindre le niveau d’un joueur humain. Evidemment, ces calculs peuvent être accélérés dans le cas d’un jeu vidéo. Mais pour des applications dans le monde réel, comme la robotique, ce n’est pas possible », explique Yann Le Cun, scientifique en chef chez Facebook.

C’est pourquoi le chercheur français fait, depuis environ cinq ans, l’apologie du principe d’apprentissage auto-supervisé (Self Supervised Learning, SSL).

Selon lui, il pourrait mener le secteur informatique – et Facebook en particulier – vers une prochaine « révolution de l’intelligence artificielle ». L’idée est de prendre une masse de données et d’en occulter une partie. L’algorithme SSL est chargé d’analyser la partie visible et d’en déduire la partie occultée. De ce fait, il va créer lui-même les étiquettes qui lui permettront d’accomplir son apprentissage.

Un traducteur qui n’a jamais vu de traductions

Cette technique a déjà remporté un certain succès dans le domaine des langues. En analysant le contexte des mots dans des textes, elle permet de transformer un corpus linguistique en un champ de vecteurs. Or, ces champs de vecteurs peuvent ensuite être facilement corrélés entre eux, quelles que soient les langues sous-jacentes. On peut alors créer un service de traduction entre deux langues sans avoir à s’appuyer sur des textes traduits, ce qui est particulièrement utile pour les langues rares ou régionales. Ces représentations vectorielles peuvent également servir à prédire les mots qui vont arriver dans une conversation, une fonctionnalité très utile pour les éditeurs de texte dans les messageries par exemple.

Les chercheurs de Facebook tentent maintenant d’appliquer le SSL à d’autres domaines, comme la reconnaissance de la parole ou la reconnaissance d’image. Mais ce n’est pas si simple en raison de la complexité. Les mots d’une langue constituent un ensemble fini d’éléments, ce qui n’est pas le cas pour le son ou l’image. Prédire un son ou une image dans une séquence reste un défi.

« Avec du texte, il est facile de représenter l’incertitude, de créer une distribution de probabilités des mots qui vont suivre. Dans le cas d’une vidéo, par exemple, on n’a pas de bon moyen pour représenter la liste de toutes les trames possibles », explique Yann Le Cun. Résultat : les prédictions dans ces domaines sont floues.

Evidemment, Facebook n’est pas le seul à explorer la voie du SSL. Google et les autres géants de l’informatique se penchent également sur cette technique. Elle ne pourra être, par ailleurs, qu’une étape vers des systèmes d’intelligence artificielle réellement évolués.

Le SSL se rapproche un peu plus du mode d’apprentissage humain, qui s’appuie beaucoup sur l’observation. Mais le chemin à parcourir est encore long. Fondés sur des calculs statistiques, les systèmes supervisés, auto-supervisés ou par renforcement n’ont pas de sens de causalité qui leur permettrait de déduire les faits d’une action (Exemple : un vase tombe par terre, donc il casse). C’est un raisonnement que n’importe quel animal est capable de faire, mais qui est inaccessible pour une machine. « On est vraiment au tout début de cette question. On n’a même pas encore de véritable représentation mathématique », explique Joëlle Pineau.

De même, les algorithmes d’apprentissage ne peuvent pas conceptualiser les choses. Nourris avec des images de trafic, un ordinateur pourra rapidement identifier des voitures sur une route. Mais elle aura du mal à reconnaître une voiture immergée dans une piscine. « Ce sont des concepts qu’un nouveau-né apprend au bout de quelques mois, mais on ne sait pas encore comment cela fonctionne. C’est un mystère », confie Yann Le Cun.

C’est aussi un peu pour cette raison qu’il est possible de flouer un système d’apprentissage automatique avec des procédés qu’un humain n’aurait aucun problème à déceler.

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.