Avec le capteur 48 Mpix de ses iPhone 14 Pro, Apple se convertit au « suréchantillonnage ». Il ne s’agit pas d’une religion, mais d’une approche de la photographie qui convient parfaitement aux smartphones. Bloqué depuis l’iPhone X à un capteur 12 Mpix, Apple n’avait pour axe d’amélioration que de faire grandir ce capteur – ce que la marque fait depuis des années.

Deux visions s’affrontaient encore jusqu’il y a peu : sur une surface donnée, intégrer peu de photodiodes mais de grande taille, ou préférer des photodiodes plus petites, mais bien plus nombreuses. La première approche fut celle d’Apple, de Google et de Sony (qui persiste un peu, parfois). Mais la concurrence asiatique et les capteurs ultra-définis de Sony et Samsung, les deux géants du secteur, ont changé la donne grâce à la puissance de calcul galopante des SoC des smartphones.

Apple se convertit au suréchantillonage

Le module caméra principal des iPhone 14 Pro est donc la plus grande amélioration photographique entre deux générations d’iPhone depuis un moment. Car avec jusqu’à 4 000 milliards de calculs photographiques réalisables par cliché, ils ont le jus pour exploiter au maximum ces 48 millions de photosites de ce nouveau capteur « 65% plus grand que celui de la génération précédente » – ce qui ne nous donne pas vraiment la taille, vivement le désossage d’iFixit !

Toutes les annonces Apple en vidéo

Si la qualité d’image des iPhone s’améliore fort logiquement d’une génération à l’autre, le suréchantillonnage de ce capteur 48 Mpix permet à Apple de beaucoup promettre. Exploité en 12 Mpix par défaut, ce n’est pas du côté de la définition d’image au quotidien qu’il joue : mais sur sa capacité à révéler les détails et à travailler en basses lumières.

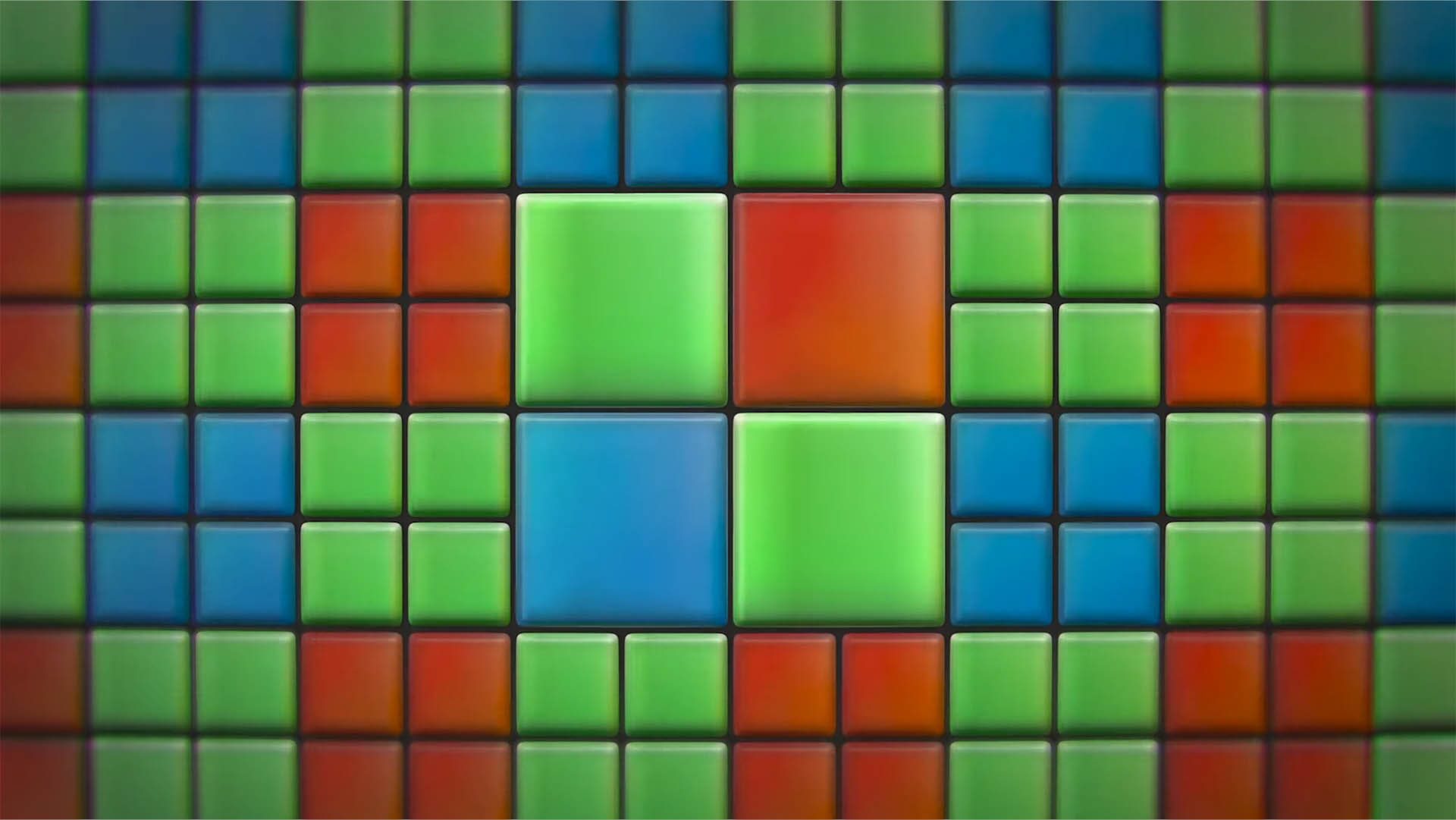

Les promesses d’Apple dans ce dernier domaine – « jusqu’à x3 moins de bruit » – ne sont pas du ressort de la science-fiction. Échantillonner sur 48 millions de points donne plus d’informations au processeur d’image du A16 Bionic pour réaliser des « moyennes » pertinentes, pour appliquer les algorithmes avec plus de finesse. Le capteur réunit les photodiodes de 1,22 micron en groupe de quatre (quad bayer sensor, 2,44 micron) qui vont, pour chaque pixel final, offrir quatre informations de couleurs (x2 verts, x1 rouge, x1 bleu) ainsi que quatre informations distinctes de chrominance (lumière). À titre de comparaison, les photodiodes de l’iPhone 13 Pro mesurent 1,9 micron – l’iPhone 14 Pro capture donc plus de lumière et plus d’informations de couleur pour chaque pixel rendu.

Cette approche que l’on retrouve chez les terminaux Android depuis des années pourrait, si elle est bien implémentée, corriger LE défaut dont souffrent les iPhone depuis des années. Dès que l’on zoome sur les clichés des générations précédentes, on constate un manque de finesse, des aplats causés par le manque d’information des capteurs peu définis. Alors que les iPhone ont toujours brillé pour leurs couleurs et ont repris la tête de la course en matière d’autofocus, ce bonus de précision d’image pourrait permettre à Apple de frapper un grand coup.

Nouvelle optique principale : plus large, plus lumineuse

Photographie signifiant « écrire avec la lumière », Apple a non seulement fait grandir son capteur, mais a aussi réussi à améliorer la valeur d’ouverture de son optique – et réaliser les deux opérations de concert est une prouesse. Pour cela, la marque d’ailleurs changé la focale pour la première fois depuis des années : le sempiternel équivalent 26 mm est devenu un 24 mm. Un 24 mm f/1.78 , soit un tiers de diaph plus lumineux que son aïeul (26 mm f/1.9 dans l’iPhone 13 Pro).

Sous ce bloc optique en 7 éléments (c’est-à-dire constitué de 7 lentilles), se trouve une seconde génération de stabilisation mécanique du capteur. Stabilisation clé pour ce « grand » capteur, puisque la lentille de stabilisation optique semble avoir disparu. Ce qui n’est pas un mal, moins il y a d’éléments mobiles, meilleure la qualité optique est. Et les couples stabilisation mécanique + électronique font désormais des merveilles jusque dans les « vrais » appareils photo.

Du côté des deux autres modules caméra en revanche, ça bouge moins. Les focales comme les ouvertures sont conservées : un ultra grand angle toujours équivalent 13 mm, qui profite d’un capteur 12 Mpix un peu plus grand. Et le même téléobjectif que la génération précédente, à savoir un équivalent 77 mm f/2.8 qui sert un capteur toujours de 12 Mpix.

Le nouveau capteur du module ultra grand-angle a forcé Apple à redessiner l’optique. Si elle perd deux tiers de diaph en luminosité (on passe de f/1.8 à f/2.2), Apple promet quand même de grosses améliorations en basses lumières, ainsi qu’en macro.

Notez aussi qu’Apple a bien pris en compte ses différentes focales dans la conception de son nouveau flash. Composées de plusieurs sous-LED, il dispose désormais de modes adaptés à chaque couverture angulaire. Une mise à jour discrète, mais qui pourrait changer pas mal de chose pour les amateurs de portraits éclairés.

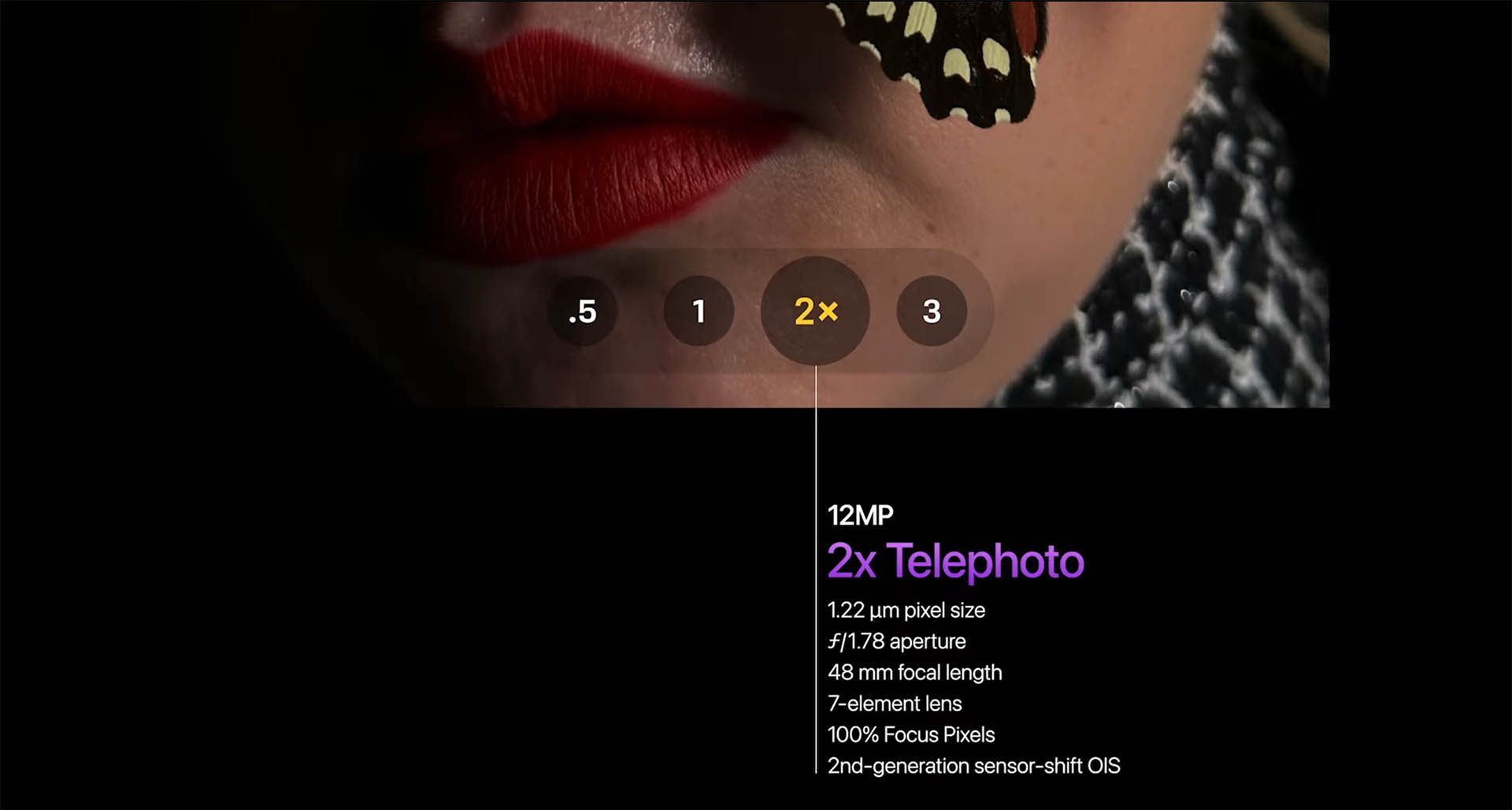

Cœur de capteur = quatrième focale

Outre l’intérêt du suréchantillonnage dont nous vous avons parlé, les 48 millions de photodiodes du capteur du module caméra principal ont aussi un usage intéressant. Celui d’un zoom « numérique » sans retravail des informations colorées. Outre le coefficient de zoom x3 que procure le module caméra téléobjectif, les 12 Mpix au cœur du capteur principal servent de zoom x2.

Ce qui permet aux iPhone 14 Pro d’afficher un zoom x2 « natif » entre le mode x1 et x3. Une pirouette technique qui offre une focale supplémentaire. Ce qui est toujours bon à prendre : l’écriture photographique passe avant tout par le choix de la focale. Élargir ce choix, c’est donner plus de moyens d’expression. Et la focale n’est ici pas anodine : la focale de 24 mm recadrée en son cœur donne un cadrage (mais pas les rendus de perspective, attention) d’un équivalent 48 mm, très proche du « classique » 50 mm du temps de l’argentique.

48 Mpix pour donner plus de sens à ProRAW

Le suréchantillonnage pour produire de belles images en 12 Mpix c’est bien, mais un supplément de définition ça peut être très pratique pour élargir des tirages. C’est ici qu’Apple pourrait bien faire parler sa maîtrise logicielle au travers de son format ProRAW.

Tous les smartphones Android haut de gamme équipés de « supers » capteurs de 48, 50 voire 108 Mpix permettent de débrayer manuellement le terminal pour shooter en RAW. Le problème étant que ce format très brut ne bénéficie de pas (ou peu) de routines d’améliorations logicielles. Or, le signal non interprété d’un capteur 50 Mpix de si petite taille n’est généralement pas de très bonne qualité.

Or, Apple est le seul acteur à notre connaissance à disposer d’un format RAW profitant quand même des améliorations logicielles (réduction du bruit, élargissement de la plage dynamique qui est forcément limitée avec les petits capteurs, etc.). Autant vous dire que nous aurons à cœur de comparer ce que l’on peut faire avec un RAW « basique » d’un terminal concurrent d’une définition native équivalente face à un fichier Apple ProRAW de 48 Mpix. Là encore, Apple pourrait faire mal à la compétition Android. Ce alors même qu’il est arrivé (vraiment très) en retard sur les capteurs très définis.

Vidéo : échange couverture angulaire contre stabilisation de GoPro

Du côté de la vidéo, la plus grande taille ainsi que les nouvelles spécifications du nouveau capteur 48 Mpix permettent quelques progrès. Le premier, modeste, est celui d’une disponibilité du mode « Cinematic » en 4K30p en plus du 4K24p de la génération précédente. Un bon plus pour les productions qui sont destinées au web/TV et non au cinéma.

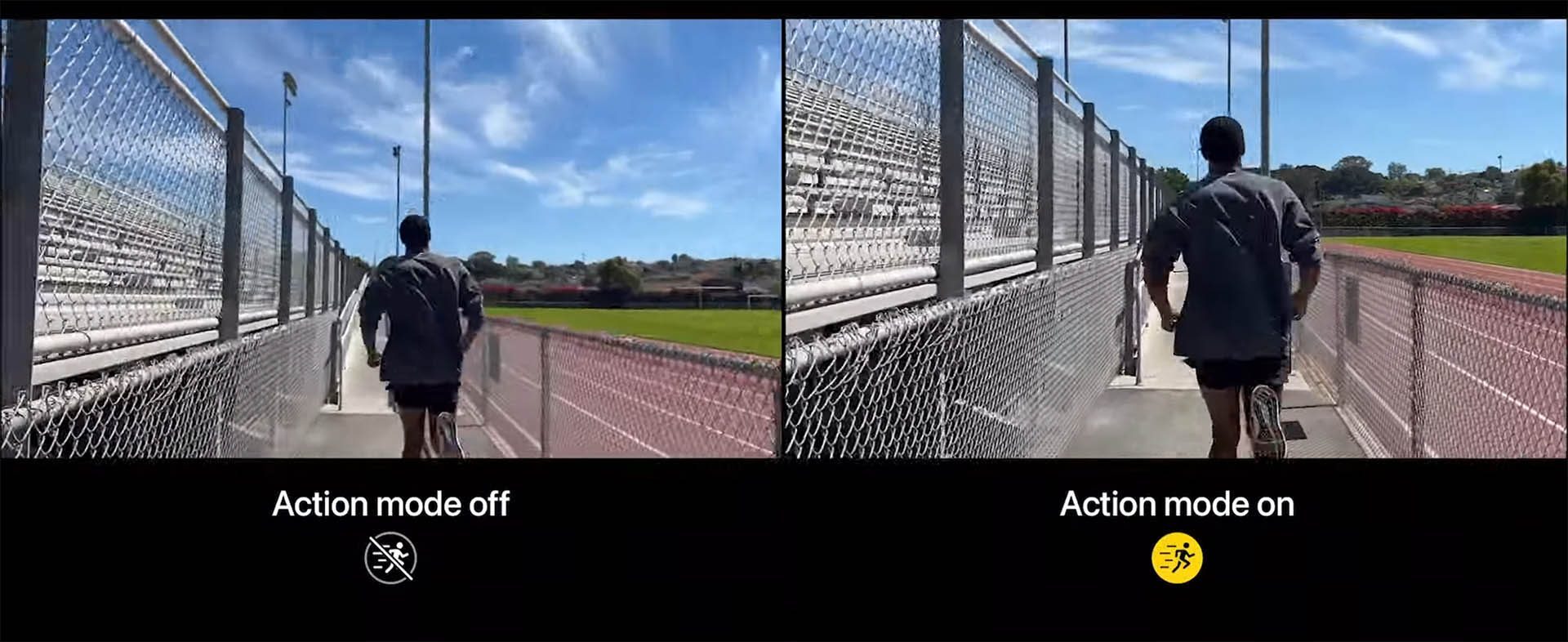

L’autre bonus est à chercher du côté de la stabilisation. L’« Action Mode » tire parti de la super définition d’image du capteur pour produire un flux vidéo 4K très bien stabilisé – un genre d’HyperSmooth de GoPro, ce qui permet de se passer de gimbal dans certaines scènes. La seule réserve que l’on a à ce sujet est l’important recadrage qu’impose cette stabilisation électronique – perceptible sur la vidéo diffusée pendant la conférence. Ce recadrage est logique, puisqu’il s’agit de capter le plus large possible avec la définition la plus importante possible pour « tailler » une image à l’horizon maintenu de manière logicielle. Mais la perte de focale est généralement importante (resserrage important), voilà pourquoi ce genre de fonction est encore plus utile avec des couvertures angulaires ultra grand-angle comme sur les GoPro.

La quête des basses lumières

Dans une diapositive, Apple affiche crânement une promesse assez impressionnante : un doublement (caméra en façade, ultra grand-angle et téléobjectif) et même un triplement (module principal grand-angle) de la qualité d’image en basses lumières. Côté physique, il y a le redesign des optiques, qui ont un fort impact sur la quantité de lumière (et la qualité d’image, qui sont parfois décorrélées, notez bien). Ainsi que, évidemment, l’agrandissement de la taille des capteurs – et le suréchantillonage pour le module principal – qui permet de collecter toujours plus de photons.

Mais il y a aussi la puissance de calcul de son SoC. Une puce tout en un dont deux parties sont clés pour le traitement de l’image : le processeur d’image (ISP pour « Image Signal Processor ») ainsi que Neural Engine qui s’occupe des algorithmes « IA ». Ces deux sous-parties de l’A16 Bionic nouveau qui n’équipe que les versions « Pro » de cette fournée iPhone 14 seraient à même de réaliser 4 000 milliards d’opérations par photo.

Grâce à la gravure 4 nm, Apple a pu caser quasiment 16 milliards de transistors dans sa puce, ce qui permet de gonfler la puissance de tous les éléments qui la compose (CPU, GPU, ISP, NE, etc.). C’est aussi grâce à cette puissance de calcul, couplée à la qualité des algorithmes, qu’Apple peut prétendre à de tels progrès dans le domaine des basses lumières. Qui lui permettront, sans doute, de gommer les derniers défauts persistants de ses terminaux. Et de reprendre, qui sait, sa domination totale dans le domaine de l’imagerie.

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.