45 000 000 000 000 000 000 octets. 45 exaoctets, c’est une estimation du trafic mensuel sur internet fixe et mobile. Les textes, les films, les sons, tout notre univers est entraîné dans l’océan numérique. Le Nuage informatique, en multipliant les occasions de partage et de contacts alimente cette croissance à 30 % l’an : 40 000 requêtes Google par seconde, 500 millions de twitts et 2 700 millions de Likes par jour… Demain, les capteurs intégrés à d’autres objets connectés que les téléphones ajouteront au flux leurs indications de pression atmosphérique, de prix, d’accélération.

Depuis longtemps, les états, les entreprises utilisent des statistiques. Les premiers arrivent à savoir de l’apprentissage ou du lycée professionnel, lequel assure le mieux l’obtention d’un diplôme. Les secondes peuvent savoir le coût de l’émission d’une facture ou le temps moyen d’attente d’un client au téléphone. Mais les données sont en général homogènes, bien choisies et en quantité limitée.

Un défi aux statistiques

Les données entrent dans le « Big Data » lorsque leur masse pousse à leur extrémité les bases de données classiques, lorsque leur hétérogénéité appelle à la conception de nouveaux algorithmes, lorsque elles ne peuvent être décrites par des modèles simples, linéaires, et qu’elles imposent de nouveaux outils statistiques pour livrer des prédictions. Le Big Data, c’est l’art de tirer de l’utilité du déluge.

Les applications sont déjà nombreuses et les possibilités donnent le vertige. Depuis quelques années, Google Flue Trend établit des corrélations entre certains motifs de requêtes et les statistiques passées de grippe pour décrire la progression de l’épidémie en temps réel, avant même que les malades soient décomptés par les médecins. Plus récemment les requêtes sur plusieurs moteurs ont été utilisées pour débusquer des effets secondaires encore inconnus d’associations de médicaments.

On pourrait par exemple prédire les embouteillages en croisant les données des divers senseurs (GPS, accéléromètre, microphone) des smartphones des usagers de la route. Beaucoup d’entreprises s’intéressent à la génomique, en relation avec la susceptibilité aux maladies.

Chères prédictions

Ce qui frappe, c’est la capacité prédictive des applications du Big Data. En analysant les termes employés dans quelques millions de twitts, des chercheurs ont montré en 2010 qu’on pouvait prévoir avec plusieurs jours d’avance les cours de la bourse. Une autre équipe a montré comment déduire de vos « Likes » sur Facebook avec une probabilité élevée vos origines, votre consommation de drogues ou votre orientation sexuelle. Les acteurs du Cloud dont le modèle économique est la diffusion de publicité l’utilisent pour prédire ce que vous allez acheter.

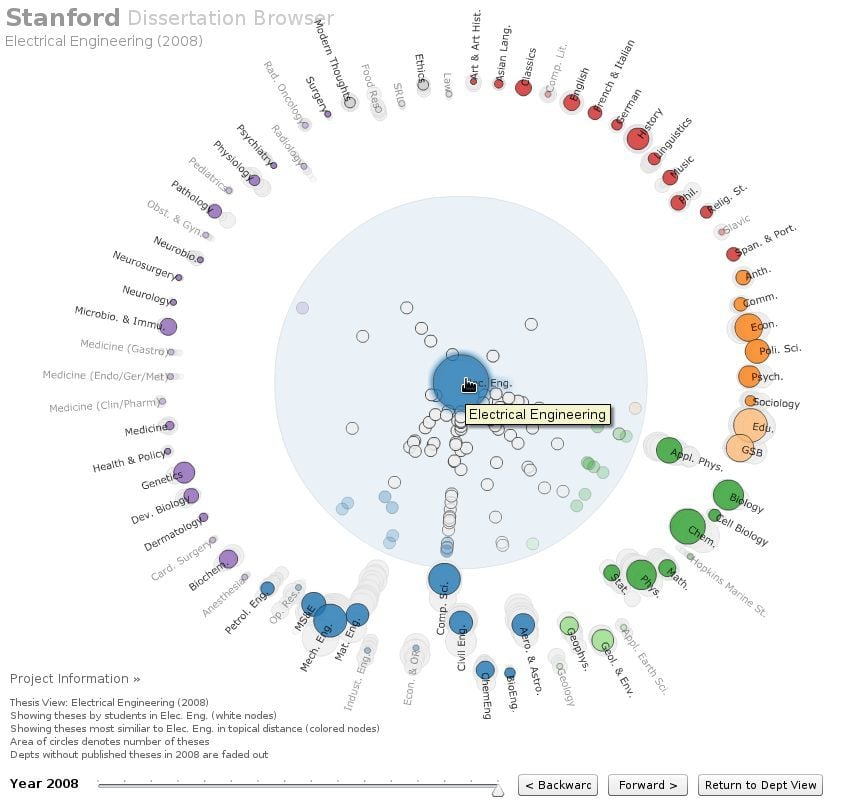

Parmi les outils, certains assez simples, pour s’initier aux données en grand, on a remarqué BigQuery, Fusion Tables, Trend et Refine pour Google, Graph Search de Facebook, DataWrangler de l’université Stanford. Openstreetmap donne un exemple de données collectées par la foule et rendues accessibles par des outils simples.

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.