Faut-il accepter cette offre d’emploi, tout lâcher et vous lancer dans une reconversion professionnelle, quitter votre conjoint pour recommencer une nouvelle vie ailleurs ? Face à des choix difficiles, nous pourrions bientôt avoir un nouveau réflexe : demander conseil à l’intelligence artificielle (IA). C’est ce vers quoi tend DeepMind, la branche spécialisée dans l’IA d’Alphabet. La maison mère de Google travaille depuis des mois sur une version « coach de vie » de ses outils d’intelligence artificielle. Cette dernière pourrait être capable de répondre à des questions particulièrement intimes et personnelles sur la vie des utilisateurs, comme le ferait un psychologue ou un ami proche.

Selon le New York Times, une centaine de chercheurs de la société Scale AI, sous contrat avec DeepMind, aurait testé ce projet, parmi 20 autres tâches. Nos confrères donnent ainsi l’exemple d’un internaute qui doit annoncer à l’un de ses meilleurs amis qu’il ne pourra pas assister à son mariage, faute de pouvoir payer son billet d’avion pour rejoindre le lieu des festivités. L’IA proposerait alors différentes manières de présenter cette mauvaise nouvelle pour qu’elle soit mieux acceptée.

Des risques éthiques et juridiques

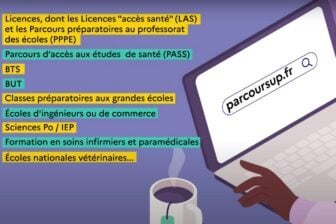

Cette version coach de vie comporterait, en plus de cette capacité à répondre à certaines questions personnelles, d’autres fonctionnalités allant de la création de budgets à des programmes d’entraînement sportif.

Ces possibilités inquiètent certains chercheurs, qui pointent du doigt une potentielle perte d’autonomie dans la réflexion des utilisateurs, en plus de la dangerosité de certaines réponses des chatbots, sujets aux hallucinations. Ces outils peuvent en effet donner des réponses très convaincantes tout en étant totalement fausses, voire préjudiciables.

Il y a plusieurs mois, une ONG américaine, qui soutient les victimes de troubles de l’alimentation, a dû retirer son robot conversationnel – appelé Tessa. Le système donnait des conseils d’alimentation inappropriés, voire dangereux pour la santé de ceux qui l’interrogeaient. Au sein de Google, des experts ont aussi averti, en décembre dernier, que ce type d’outils présentait bien des risques quant au bien-être des utilisateurs. Les internautes pourraient notamment trop s’investir émotionnellement dans les chatbots, rapportent nos confrères du New York Times.

Comment s’assurer de la confidentialité et de la qualité des conseils ?

Cette nouvelle fonctionnalité en développement, qui est loin d’être surprenante au vu de la course à l’IA, devra surmonter plusieurs défis : d’abord, comment s’assurer que tous les éléments personnels que vous donneriez, pour solliciter un conseil, ne finissent pas sur la place publique ou dans une autre conversation ? Bard, l’outil d’IA générative de Google, préconise pour l’instant à ses utilisateurs de ne pas donner d’informations personnelles.

Ensuite, comment s’assurer que les conseils donnés par l’IA sont de bons conseils ? Christian Guttmann, spécialiste de l’IA au sein de Pegasystems cité par le Guardian, préconise par exemple la mise en place d’une « approche responsable pour établir ces relations entre les humains et les systèmes d’IA ». L’objectif est de « s’assurer que les conseils donnés à une personne sont sûrs, solides et conformes à ce qu’un professionnel conseillerait », rapporte-t-il à nos confrères.

D’un outil généraliste à un outil personnalisé

Autre défi de taille : techniquement, mettre en place un tel système serait particulièrement complexe, souligne Fortune. Jusqu’à présent, Bard comme ChatGPT est capable de donner des réponses généralistes à la manière d’un Wikipédia, sur un très grand nombre de sujets. Mais créer des interactions uniques et personnalisées serait particulièrement difficile. Pour être capables de donner des « conseils de vie », ces outils devraient s’adapter à la situation de chaque personne, en plus d’être en capacité de fournir des réponses pertinentes et éthiques.

Pour toutes ces raisons, Google ne serait pas près de déployer ce type d’outils. Il pourrait se limiter à certaines fonctionnalités particulières – comme la création d’un budget – plutôt que de proposer un outil de coaching de vie bien plus ambitieux. Selon le New York Times, Google n’aurait, pour l’instant, pas encore arrêté sa stratégie de lancement. Si cet outil finit réellement sur le marché, il constituerait un changement d’approche du géant du numérique. La firme de Mountain View préconise en effet aux utilisateurs de Bard de ne pas solliciter « des conseils médicaux, juridiques, financiers ou autres conseils professionnels ».

Interrogé par le New York Times, DeepMind a, de son côté, insisté sur son processus actuel d’évaluation de ce projet, déclarant qu’il s’agissait d’une « étape essentielle dans la mise au point d’une technologie sûre et utile ».

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.

Source : le New York Times