Lors du salon dédié à l’intelligence artificielle qui se tient en ce moment à Montréal, Nvidia a montré les muscles en annonçant la Titan RTX, une carte graphique à cheval entre le monde des gamers et celui des professionnels de la création, des chercheurs en IA, etc.

A cette occasion, le concepteur s’est également livré à une démonstration bluffante d’une nouvelle façon de modéliser des environnements ultra réalistes pour des applications virtuelles comme le jeu vidéo, les simulations de parcours pour l’automobile, etc. Celle-ci est en cours de développement mais les premiers résultats sont plus qu’encourageants.

Cartographier, identifier et appliquer

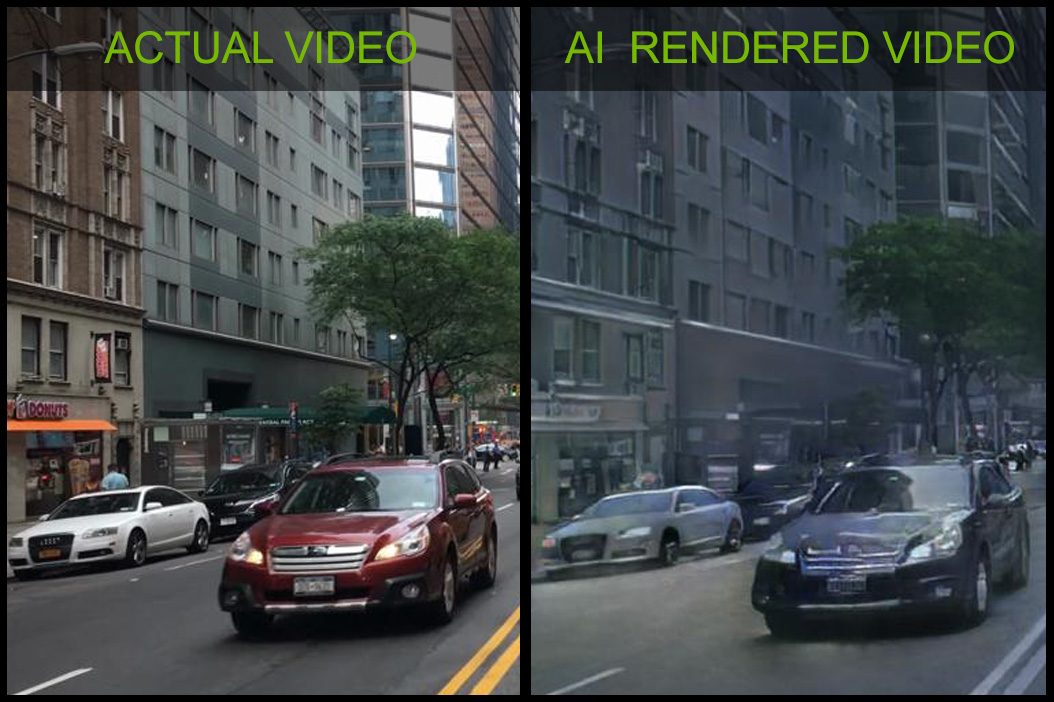

Pour faire simple, il s’agit d’utiliser la puissance de calcul d’un réseau neuronal afin de créer une modélisation réaliste d’une ville. Pour y arriver, les chercheurs de Nvidia ont utilisé les données capturées par des dashcams (caméras embarquées) disposées dans des voitures ayant sillonné des quartiers de villes américaines. Ils les ont ensuite calqué sur des squelettes en trois dimensions de répliques des environnements filmés (une carte sémantique colorisée) reproduits en 3D grâce à un moteur de jeu vidéo, l’Unreal Engine 4.

Le tout est généré en temps réel, en fonction des déplacements de l’utilisateur au coeur de la simulation et grâce à la puissance des Tensor Core, les unités dédiées à l’IA qui se trouvent sur les puces Volta V100 ou encore celles à base d’architecture Turing des cartes graphiques GeForce RTX et autres Quadro RTX.

Bien entendu, pour que la magie opère, il faut tout de même aider l’IA à repérer « qui est quoi ». Ainsi, les chercheurs de Nvidia ont défini quels types/groupes de pixels correspondaient à un véhicule, un immeuble, une route, un arbre, des piétons, etc. dans l’environnement 3D d’Unreal Engine.

Ensuite, l’IA – entraînée et capable d’identifier ces éléments – s’applique à calquer les modèles repérés dans les vidéos sur les objets 3D et ainsi reproduire de façon très probante ce que les dashcams ont filmé. Ou, à défaut, à adapter et insérer des éléments qui auraient pu s’y trouver, sans le moindre souci et à la volée.

Si la vidéo montre clairement que la qualité de rendu n’est pas encore celle d’un jeu 3D AAA ou même l’exacte reproduction de la réalité, il faut tout de même reconnaître que la ressemblance entre les deux milieux urbains est très frappante. Le fait que tout soit calculé et réalisé en temps réel rend l’ensemble d’autant plus impressionnant.

Comme le montre la seconde partie de la vidéo, il est aussi possible de créer des deepfakes très probants avec cette technique. Ainsi, le chercheur que l’on voit reproduire les mouvements de la chorégraphie du gangnam style est une pure création de l’IA, entraînée à analyser les vidéos et gestes de personnes se déhanchant sur la musique puis appliqués à un modèle 3D ultra réaliste de la personne, dans un lieu a priori réel. Gare aux détournements.

Source :

Nvidia

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.