Comme un air de déjà vu, avec le métavers ? Mercredi 10 avril, la presse était invitée à une matinée dédiée à l’intelligence artificielle chez Meta France, la maison mère d’Instagram, de Facebook et de WhatsApp. L’heure n’était pas aux annonces grandiloquentes, mais plutôt à la pédagogie sur sa stratégie en matière d’IA. Et comme il l’a déjà fait pour le métavers, misant envers et contre tous sur cet univers parallèle jusqu’à changer de nom en devenant Meta, le groupe de Mark Zuckerberg joue aussi, en matière d’IA, la carte de l’outsider.

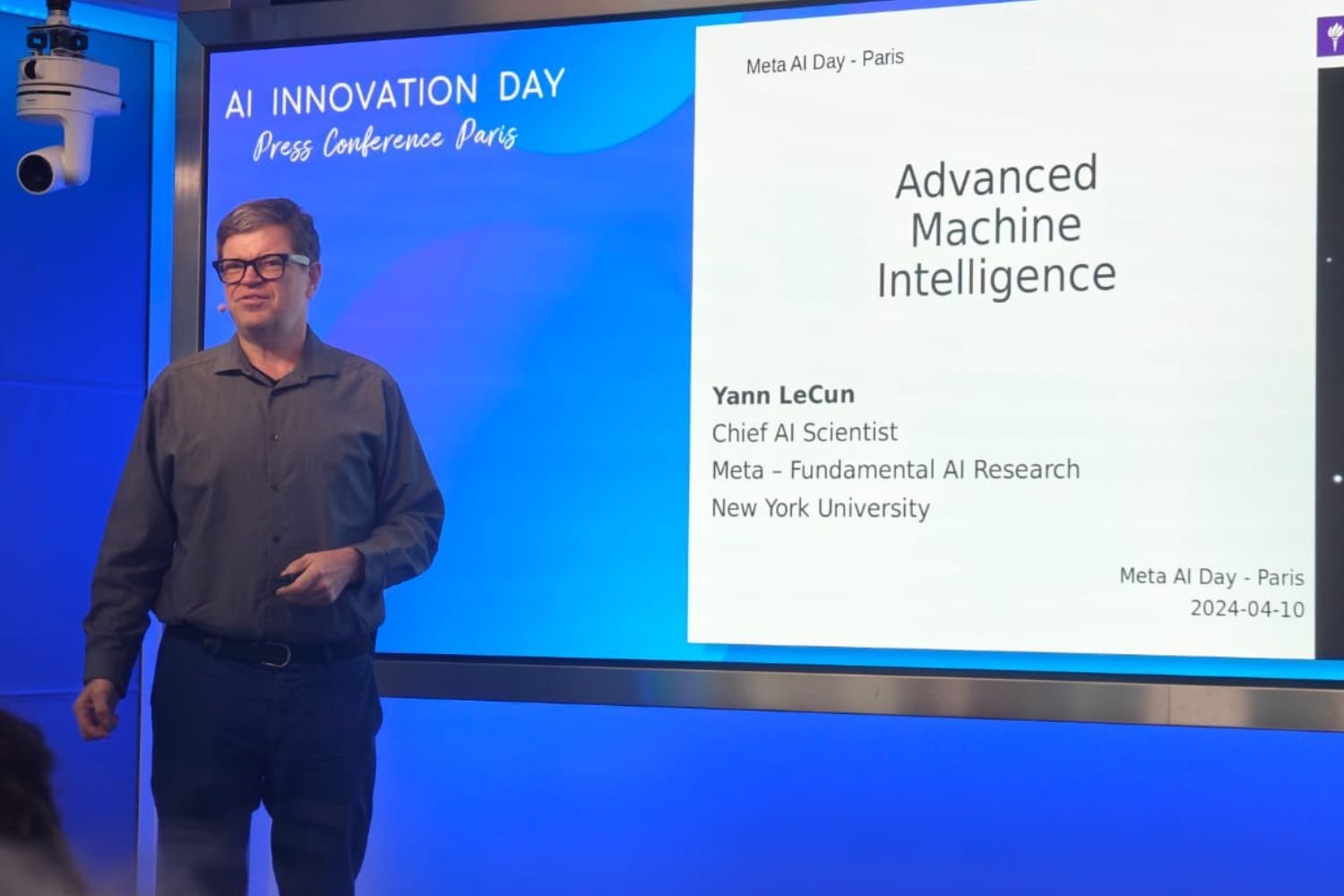

Il faut dire que l’entreprise a, comme les autres, été dépassée et surprise par la vague ChatGPT en novembre 2022. « On ne s’attendait clairement pas à un tel engouement du public, en particulier sur une technologie qui datait de deux ans », a reconnu pendant la conférence Yann LeCun, la star française de l’IA qui pilote aujourd’hui la politique scientifique en IA de Meta. De quoi faire réagir le groupe qui a pris, les mois suivants, le virage de l’IA générative, cette technologie qui permet de générer du texte, du code ou de la vidéo. Il a d’abord lancé son grand modèle de langage Llama 2 en juillet dernier. Il a aussi regroupé ses activités de recherche en IA fondamentale et en IA générative, de quoi passer de la recherche à l’industrie plus rapidement, a expliqué Joëlle Pineau, la vice-présidente pour la recherche en IA, pendant la conférence. Mais fondamentalement, l’entreprise américaine aurait choisi une « trajectoire » différente de celles adoptées par ses concurrents, a ajouté la chercheuse québécoise.

Meta aurait pris une « trajectoire » différente

À court terme, la stratégie de Meta, qui vit principalement de ses revenus publicitaires, ne change pas, a-t-elle précisé pendant une des tables rondes qui était organisée après la conférence. L’entreprise reste focalisée sur ses plateformes (Facebook, Instagram, WhatsApp) et ses deux produits de réalité virtuelle et augmentée que sont le Quest et les Ray-Ban Meta – des lunettes d’ailleurs portées par le chercheur français Yann LeCun pendant cette matinée. L’idée est d’appliquer des fonctionnalités d’IA à ses réseaux sociaux. « Si vous allez sur Facebook ou Instagram, une bonne partie de ce que vous verrez est recommandé par nos algorithmes, construits sur des systèmes d’IA ». Mais à plus long terme, les choses évolueront, a lancé Joëlle Pineau, interrogée sur ce point.

Comment ? En jouant – comme elle l’a fait pour le métavers – la carte de l’outsider. Pour ce faire, le groupe mise encore et toujours sur son approche open source – « dans l’ADN » du groupe – même si l’accès en question a été critiqué par une partie de la communauté, parce qu’il serait soumis « à conditions ». Et Llama 3, la 3e version multimodale de LLM (grand modèle de langage) qui « sortira très prochainement », devrait être publiée en open source. « C’est notre objectif », a avancé prudemment Chris Cox, le directeur des produits de Meta, pendant la conférence – une approche devenue rare dans le monde de l’IA, où la majorité des entreprises proposent des modèles fermés et propriétaires comme le GPT-4 d’OpenAI ou le Gemini (anciennement Bard) de Google.

Mais le groupe a surtout mis en avant ses investissements dans la recherche fondamentale – Meta « investit depuis des années dans l’écosystème d’IA ». Elle a créé un réseau de centres de recherche en IA, FAIR, en 2013 – à commencer par un centre à Paris. Et elle compte bien continuer à le faire. Ce choix de l’IA pour le long terme n’est pas sans rappeler celui fait pour le métavers. Car voilà, l’objectif n’est pas, ici, de lancer un ChatGPT plus performant, ou plus sexy. C’est même l’inverse : « il faut s’éloigner des modèles génératifs », a lancé Yann LeCun avant de se lancer dans une longue explication sur les IA génératives actuelles.

Les LLMs aujourd’hui incapables de raisonner

Ces « systèmes peuvent manipuler le langage très rapidement, et cela nous donne l’impression qu’ils sont intelligents, mais en réalité, ils ne le sont pas tant que ça », a taclé le lauréat du prix Turing de 2018. Le sexagénaire rappelle ainsi que les LLM « commettent des erreurs stupides. Ils hallucinent. Il leur manque le bon sens, et quatre tâches essentielles : comprendre le monde physique, avoir une mémoire persistante, donc se souvenir des choses importantes, être capable de planifier des séquences d’actions complexes pour atteindre un objectif particulier, et être capable de raisonner ».

« Les LLM ne peuvent pas, par exemple, planifier et raisonner. Lorsqu’on leur demande de produire un plan, comme de planifier des vacances au Costa Rica, ils vous donneront une liste d’endroits à visiter, parce qu’ils régurgitent ce sur quoi ils ont été entraînés ». Mais ils ne peuvent pas vraiment programmer un trajet de A à Z, a martelé le vice-président qui pilote l’IA au sein de la société américaine.

Aujourd’hui, on n’en est même pas au stade du chat domestique

Meta mise-t-il alors aussi sur ce qu’on appelle « l’IA générale », un concept mal défini qui renverrait à l’idée d’une super intelligence dépassant l’intelligence humaine ? En janvier dernier, Mark Zuckerberg avait expliqué, chez nos confrères américains de The Verge qu’il comptait bien atteindre cet idéal – comme d’autres PDG du secteur avant lui. Ce Graal reste très lointain, a reconnu Yann Lecun qui lui préfère l’idée « d’Advanced Machine Intelligence » ou AMI.

Car aujourd’hui, « nous n’avons pas la capacité de construire des systèmes dotés d’une intelligence surhumaine. » « Nous ne savons pas comment construire des machines intelligentes au même niveau que… – oubliez les humains – au même niveau qu’un chat domestique », a insisté le chercheur français. L’occasion pour celui qui est considéré comme l’un des pionniers de l’IA de rappeler que le spectre d’une technologie qui anéantirait l’humanité reste un scénario de science-fiction.

« C’est comme si chacun de nous allait un peu devenir le patron d’un tas de gens virtuels intelligents qui travaillent pour nous »

À la place de ce « phénomène imaginaire », Yann LeCun a expliqué pendant de longues minutes, son « approche par les objectifs », qui permettra à terme de développer un super assistant personnel avec lequel on communiquera en portant des lunettes connectées ou d’autres « appareils de ce type, qui tiendront peut-être dans votre poche. Et éventuellement, ces systèmes deviendront aussi intelligents que nous. Nous avons besoin qu’ils soient intelligents, parce qu’il serait très frustrant de parler à un système stupide, qui ne pourrait pas répondre à une question. En fait, nous voulons qu’ils aient une intelligence surhumaine si nous voulons vraiment qu’ils nous aident dans notre vie quotidienne. Donc, c’est comme si chacun de nous allait un peu devenir le patron d’un tas de gens virtuels intelligents qui travaillent pour nous. Et ils ne vont pas nous remplacer parce que nous allons leur fixer des objectifs », a-t-il développé.

Pour construire ces futurs modèles « qui ne ressembleront pas du tout à ceux que nous avons actuellement », Yann LeCun explique se baser sur une « architecture d’IA axée sur les objectifs ». Une partie de ce travail a donné JEPA (Joint Embedding Predictive Architecture) – un modèle rendu public en 2022, et dont une 2e version a été publiée l’année dernière.

Il ne s’agit pas de prédire « tous les détails », mais l’essentiel

Concrètement, il s’agirait « développer des modèles qui ne tentent pas de prédire chaque détail imprévisible d’une scène, comme le mouvement des feuilles ou des mouvements de l’eau sur un lac ». À l’inverse, ces derniers se concentreraient sur l’essentiel, en ne retenant que ce qui est « prévisible et pertinent ». Cette technologie se baserait « sur une représentation abstraite des données vidéo ».

En attendant ce travail de très long terme, Meta compte investir dans son infrastructure, ses semi-conducteurs, tout en continuant son exploration dans la recherche fondamentale. « Nous nous attendons à ce que notre feuille de route ne soit pas linéaire. Si nous visons trop de prévisibilité, nous perdons de vue la possibilité de prendre des risques plus importants. Et je pense que nous aurons besoin de faire de grands sauts pour arriver à l’intelligence artificielle générale » », a concédé Joëlle Pineau.

Ces ambitions connaitront-elles le même sort que celles, pour l’instant avortées, du métavers ? Pas si sûr. Pour Meta, nous passerons tous, dans le futur, par des intermédiaires, des agents avec lesquels nous discuterons, pour se rendre sur le Web ou dans un monde virtuel. Mais la route pour atteindre ce Graal sera longue, voire très longue, a prévenu Yann LeCun. Et si « beaucoup de gens pensent que d’un coup, on aura cette intelligence artificielle générale », ils se trompent. Le processus sera continu, on aura des modèles « de plus en plus intelligents », à l’image de l’histoire de l’évolution. Et ça tombe bien : pendant cette lente progression, Meta a de quoi tenir, grâce à ses recettes publicitaires. Le géant a fait un excellent 4e trimestre, a rappelé Joëlle Pineau… De quoi avoir les caisses remplies pour plusieurs années, le temps d’avancer dans ces mille et une recherches et qui sait, de trouver l’IA et l’application qui sera adoptée par tous ?

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.

Bien sûr qu’un LLM est capable de raisonner, du moins d’en donner l’illusion, ce qui revient au même.

Non, ils sont très mauvais et débitent n’importe quoi avec une assurance problématique. On n’a aucune idée de la pertinence du résultat sauf si on connait la réponse à l’avance. C’est marrant 2s, c’est éventuellement intéressant pour de la traduction mais pour du code, au secours…

Ça débile de jolies phrases qui se tiennent mais à la longue on y voit le schéma de la répétition. Pour le code, j’ai testé avec Python que je découvre. Il faut détailler chaque étape en langage naturel pour obtenir le bon code. J’avoue y être parvenu après plusieurs reprises sur les explications. Bref, on découvre un outil pseudo intelligent qu’il faut dompter pour un usage quotidien. Tarek

Donnez l’illusion de et faire, c’est pareil pour vous ?

Le simple concept d’illusion semble vous dépasser.

Pas étonnant, dans ce cas là, de croire qu’une IA sait raisonner.

Et bon, venir contredire LeCun avec un tel aplomb, sans même avoir réussi à comprendre un concept pourtant basique, il n’y a bien que sur internet qu’on voit ça…

Les modèles mathématiques ne sont pas encore tous exploité. Les utiliser et les informatiser fera naître des intelligences plus performantes.