En mars dernier, Google a marqué les esprits en présentant Bristlecone, un processeur quantique avec 72 qubits. Personne n’a fait mieux à ce jour, c’est un record. Mais quand on entend parler les experts du géant du web, le sentiment de fierté auquel on pourrait s’attendre reste très limité. Et pour cause : le domaine de l’informatique quantique reste encore largement inexploré et les défis techniques sont gigantesques. « On est un peu comme aux débuts des microprocesseurs, lorsqu’on fabriquait les premières puces sans réellement savoir comment elles allaient se comporter. On a encore beaucoup à apprendre », confie Kevin Kissell, directeur technique cloud chez Google, à l’occasion du Forum Teratec. « L’informatique quantique est une approche radicalement différente et on est seulement au début du début », souligne de son côté Bob Sorensen, analyste spécialisé en informatique quantique chez Hyperion Research, un cabinet qui réalise des études de marché.

Certes, le principe du calcul quantique est désormais bien maîtrisé. Comme nous l’avions expliqué dans un précédent article, l’utilisation de « bits quantiques » ou « qubits » ouvre la voie à des méthodes de calcul dont la puissance augmente de manière exponentielle avec le nombre de qubits utilisés. On dispose même déjà d’algorithmes qui pourraient en bénéficier, comme celui de Shor (factorisation de grands nombres en nombres premiers) ou celui de Grover (recherche d’un élément parmi beaucoup d’autres). Le grand problème auquel font face les chercheurs aujourd’hui, c’est la fabrication de qubits physiques, ainsi que leur intégration et leur manipulation dans des systèmes informatiques.

Les règles de la mécanique quantique font que l’architecture d’un ordinateur quantique est fondamentalement différente de ce que l’on connaît jusqu’à présent. Dans un ordinateur classique, les bits peuvent être copiés et transférés en permanence. Dans un système quantique, ceci n’est pas possible car une lecture de qubit entraîne automatiquement l’évanouissement des ses états quantiques superposés. Or, cette superposition (voir article précédent) fait tout l’intérêt de l’informatique quantique car il apporte la possibilité d’un calcul massivement parallèle. Bref, les qubits sont condamnés à rester statiques.

Le temps de cohérence quantique est le nerf de la guerre

Pour créer un qubit, il faut avoir un dispositif matériel permettant de créer et contrôler une particule et son état quantique. Plusieurs techniques sont actuellement explorées, mais toutes sont confrontées au même problème, à savoir l’instabilité des états quantiques superposés. Cette situation de superposition – que les physiciens appellent cohérence quantique – est extrêmement difficile à maintenir car elle est très sensible aux influences extérieures. Au mieux, les qubits que l’on fabrique actuellement arrivent à tenir une petite minute, ce qui est largement insuffisant pour réaliser des calculs intéressants.

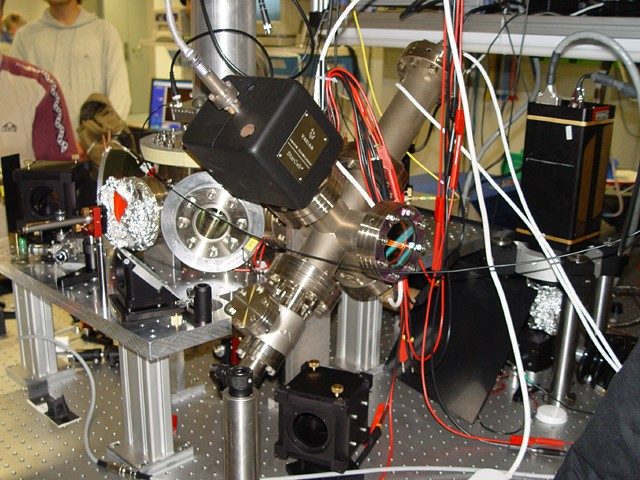

L’une des technologies de qubit qui s’en sort le mieux de ce point de vue est celle de l’ion piégé par un champ électromagnétique, un principe connu depuis les années 1950. L’état de cohérence d’un tel qubit peut aller jusqu’à 50 secondes. C’est pourquoi la société IonQ, l’un des principaux acteurs dans ce domaine, pense tenir le bon bout. Mais les temps de calcul sont assez lents – de l’ordre de le microseconde – et le passage à l’échelle difficile. Le record est actuellement de 14 qubits, et celui-ci date de 2011.

Les qubits supraconducteurs attirent les grandes marques

C’est peut-être pour cette raison que les trois géants informatiques Google, IBM et Intel se sont lancés dans une autre voie, celle des qubits supraconducteurs. Ils sont créés à partir d’un circuit supraconducteur qui produit un effet quantique quand il est amené à une température proche du zéro absolu, de l’ordre de quelques millikelvins (0 kelvin = -273,15 degrés Celsius). Ce qui est nettement plus contraignant qu’avec les ions piégés qui peuvent être manipulés à une température de quelques kelvins. Les qubits supraconducteurs ont un autre défaut, c’est le faible temps de cohérence, inférieur à 100 microsecondes. Mais leur gros avantage, c’est qu’ils sont mille fois plus rapides que des qubits basés sur des ions piégés. Leur assemblage est également plus simple, la contrôle et la lecture des unités se faisant avec des ondes radiofréquence.

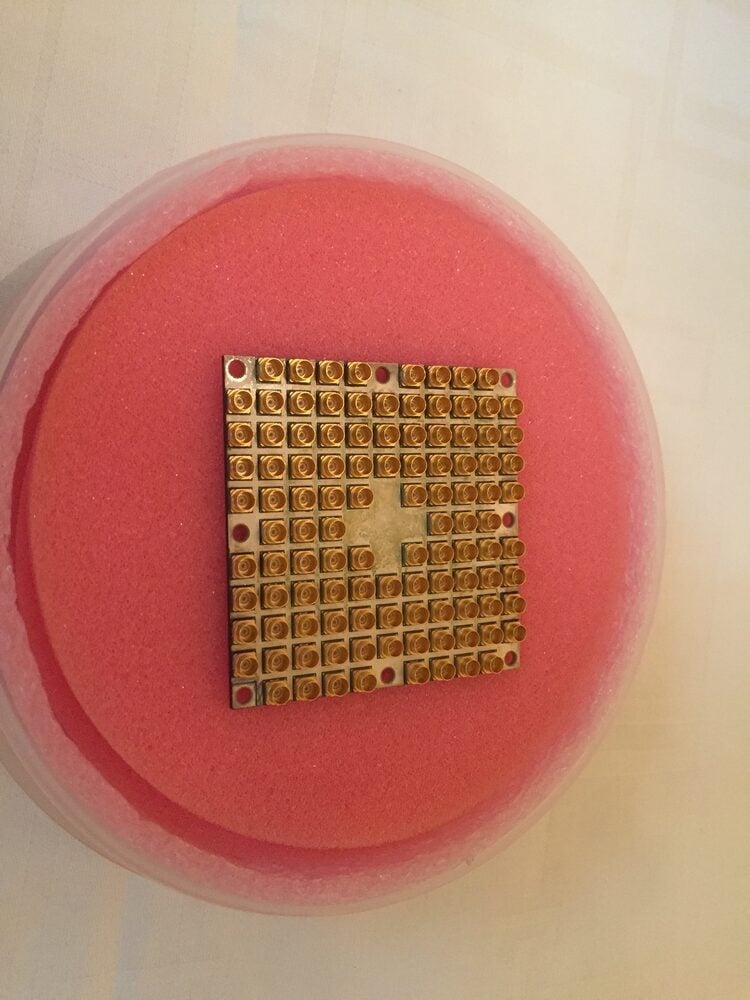

Jusqu’à présent, les résultats sont plutôt prometteurs. Les adeptes de cette voie ont produit les systèmes quantiques les plus larges à ce jour. Les puces de Google, Intel et IBM atteignent ainsi respectivement 72, 49 et 20 qubits.

Malheureusement, tous ces qubits comportent toujours un taux d’erreurs trop grand pour pouvoir être assimilés ne serait-ce qu’à un seul vrai qubit ou « qubit logique », c’est-à-dire un qubit dont le comportement est fidèle à la théorie mathématique du calcul quantique. Pour espérer obtenir l’équivalent d’un qubit logique, les constructeurs appliquent des techniques de redondance et de correction d’erreur, notamment en multipliant les qubits physiques. Ainsi, les ingénieurs de Google revendiquent désormais un taux d’erreur de moins de 1 %, ce qui reste toujours assez grossier. Les autres travaillent aussi d’arrache-pied pour améliorer la situation. « Nous pensons que nous aurons bientôt les premiers qubits logiques », estime Stefan Filipp, expert en chef du calcul quantique chez IBM Research Zurich, sans toutefois donner un délai précis.

Mais même lorsqu’on aura l’équivalent d’un premier qubit logique, il faudra surmonter le passage à l’échelle pour pouvoir obtenir un ordinateur quantique doté d’une véritable tolérance aux fautes et réellement utile. Intel et IBM estiment que pour atteindre ce cap, il faudrait avoir… plus d’un million de qubits physiques. A ce niveau-là, le refroidissement devient un vrai problème car les qubits supraconducteurs sont quand même relativement gros, de l’ordre de quelques millimètres. Les dimensions deviennent alors ingérables.

La densité des qubits en silicium donne un nouvel espoir

Face à cette perspective, Intel a décidé récemment d’investir en une seconde voie technologique, celle des qubits en silicium. C’est également un domaine sur lequel se concentre le CEA, la société Silicon Quantum Computing et diverses universités dans le monde. Les qubits, dans ce cas, se matérialisent par le spin d’un électron figé dans le canal d’un transistor CMOS. Pour y arriver, il faut – là encore – réfrigérer le matériel autour de quelques millikelvins. « Mais nous avons bon espoir de pouvoir nous contenter à terme d’une température d’un kelvin », souligne Anne Matsuura, directeur applications et architecture quantiques chez Intel Labs.

Les partisans de cette technologie misent sur le fait que le transistor est une technologie très bien maîtrisée et pour laquelle il existe d’ores et déjà des processus et des infrastructures de fabrication. Ce qui pourrait simplifier le passage à l’échelle. « En utilisant l’isotope purifié 28 du silicium, on peut obtenir un spin électronique relativement bien protégé, et donc un temps de cohérence plutôt intéressant. L’autre avantage du silicium, c’est qu’on peut en mettre beaucoup au centimètre carré », explique Maud Vinet, chef du laboratoire d’intégration des composants pour la logique au CEA/Leti. Créer et refroidir des millions de qubits pourrait donc ne pas poser un grand problème.

Là où le bât blesse pour l’instant, c’est la manipulation de ces qubits en silicium. Le record en la matière est détenu par l’université de Princeton qui a conçu une puce avec deux qubits. Au CEA, on vient de démontrer la fabrication et le contrôle d’un qubit. Un deuxième devrait le rejoindre « d’ici un an », précise Maud Vinet. Intel, de son côté, n’a encore rien annoncé.

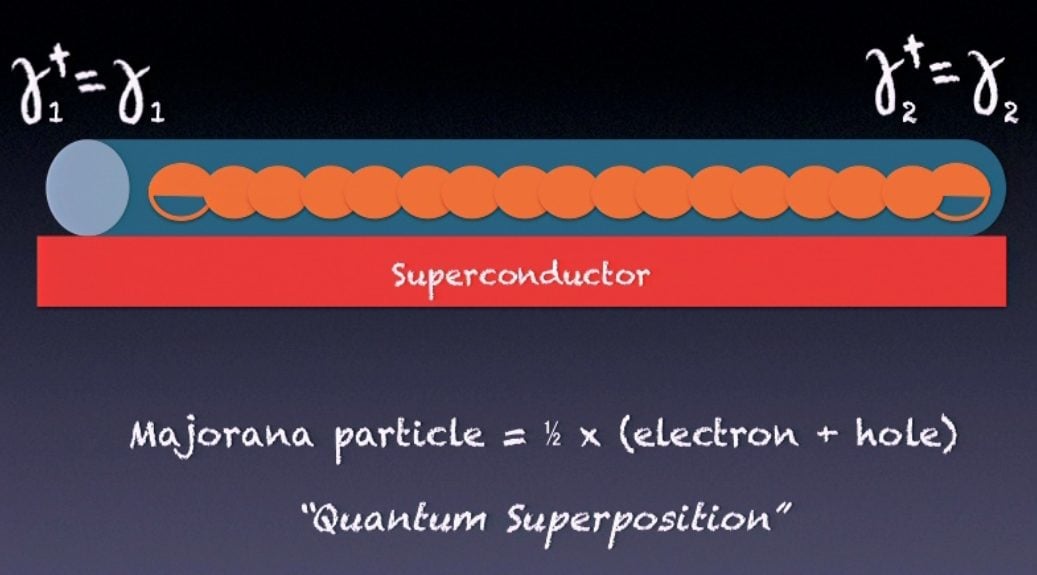

Microsoft mise tout sur les fermions de Majorana

Tous ces acteurs pourraient toutefois se faire doubler sur la voie quantique par Microsoft, qui a opté pour une technologie encore plus récente et plus exotique, à savoir les qubits basés sur les fermions de Majorana. Il s’agit là de particules quantiques théorisées en 1937 par le physicien Ettore Majorana et qui ont été détectées pour la première fois en 2012 par un groupe de chercheurs de l’université TU Delft. Pour les faire apparaître, il suffit de prendre un collier d’électrons dans un fil supraconducateur nanométrique, tout en laissant une place libre à occuper. La magie de la superposition quantique permet, dans ce cas, de fractionner l’un des électrons pour créer deux fermions de part et d’autre.

L’avantage d’une telle paire de fermions réside dans sa structure topologique qui rend l’état de superposition particulièrement stable et permet d’envisager un temps de cohérence de l’ordre de la minute. La vitesse de calcul, quant à elle, serait équivalente à celle des qubits supraconducteurs. Enfin, les partisans du qubit topologique estiment que les techniques de correction d’erreur seraient mille fois plus efficaces que pour les autres types de qubits.

Microsoft est sur le point de finaliser son premier qubit. Il s’agira ensuite de les multiplier. « D’un point de vue théorique, nous pensons que tout est résolu. Nous avons les algorithmes, nous avons le design des circuits de contrôles, nous savons comment créer le fil nanométrique. Nous sommes maintenant dans la phase de l’ingénierie et pensons pouvoir obtenir très bientôt des centaines voire des milliers de qubits logiques », estime Bernard Ourghanlian, directeur de la technologie et de la sécurité chez Microsoft France.

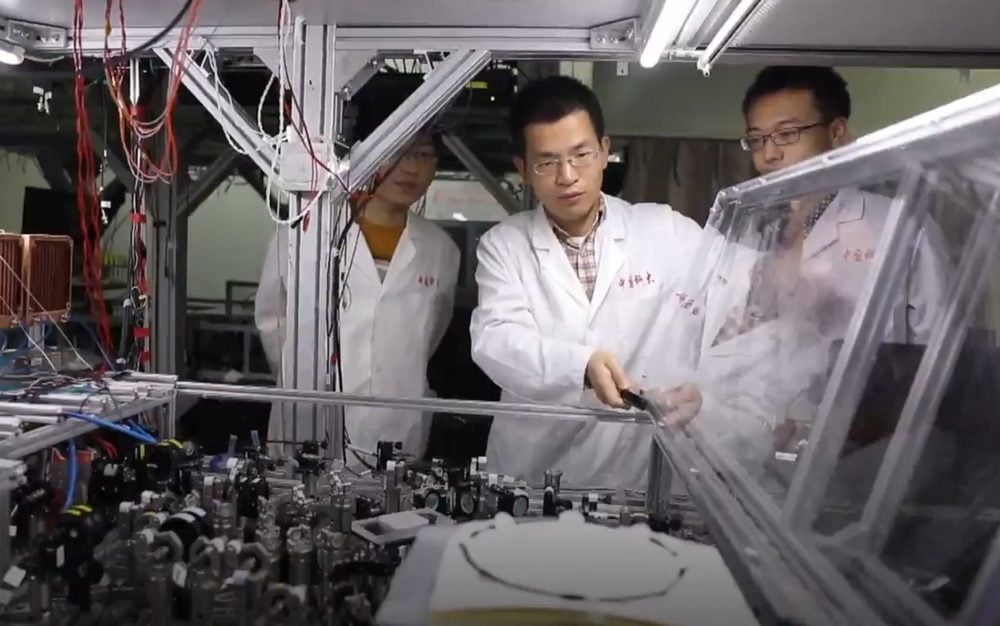

L’Empire du milieu est le royaume des photons

Mais au final, il se pourrait bien que le premier ordinateur quantique provienne d’un tout autre endroit. La Chine investit également beaucoup de temps et d’argent dans ce domaine et l’un de leurs groupes de chercheurs vient d’annoncer la création d’un système quantique à 18 qubits reposant sur encore une autre technologie, à savoir les qubits photoniques. La particularité de ce dernier démonstrateur est qu’il n’utilise que six photons. En effet, les scientifiques arrivent à exploiter trois états quantiques différents de manière indépendante et pour chaque photon. D’où les 18 qubits.

Et ce n’est pas tout. Ces 18 qubits auraient également atteint un niveau d’intrication maximal, ce que personne n’aurait réussi jusqu’à présent, quel que soient les technologies de qubits utilisées. Or, l’intrication est une propriété fondamentale dans le calcul quantique car elle permet de lier les qubits les uns aux autres et de faire des calculs intéressants. En tous cas, cette voie de recherche n’est pas à prendre à la légère, car elle est pilotée par le physicien Jan-Wei Pan, le premier à avoir réussi à créer un système permettant de chiffrer des communications de manière quantique sur des milliers de kilomètres. Un exploit inégalé jusqu’à aujourd’hui.

Bref, on le voit, l’informatique quantique est un domaine en ébullition totale. Les axes de recherches sont nombreux et chacun acteur pense – à tort ou à raison – d’avoir trouvé la bonne voie. Mais tous sont d’accord sur un point : les premiers ordinateurs quantiques dignes de ce nom ne verront pas le jour avant 10 ans.

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.