Avec la généralisation de la commande vocale et des assistants personnels, une nouvelle ombre menaçante plane sur notre intimité, à savoir l’analyse de notre état émotionnel. Les intonations de notre voix peuvent, en effet, trahir nos sentiments ou révéler notre humeur : joie, tristesse, tonicité, fatigue, lassitude, déprime, colère, etc. Il pourrait être tentant de détecter ces intonations chez l’utilisateur au moyen d’un algorithme d’intelligence artificielle, histoire de mieux le connaître et de mieux répondre à ses besoins.

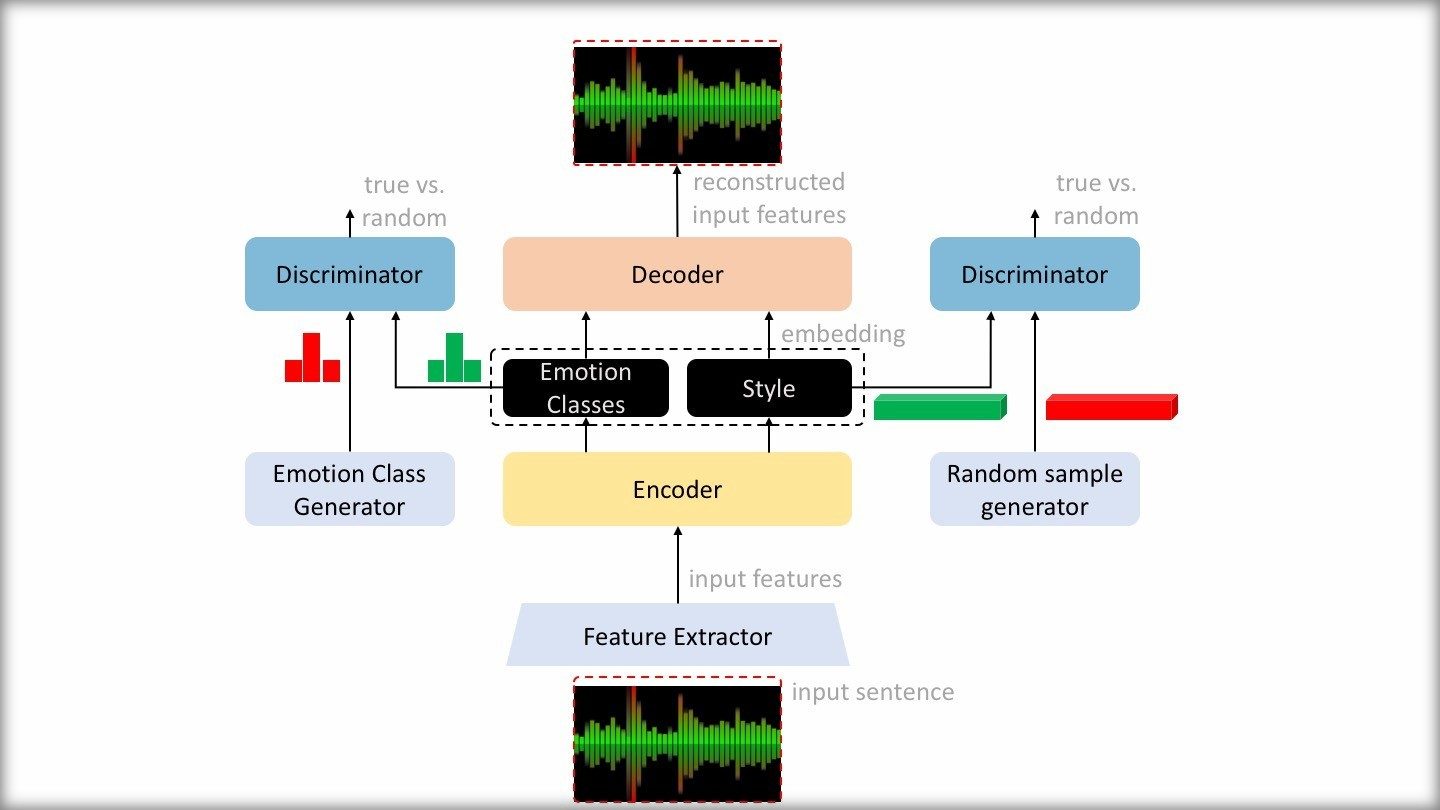

Vous pensez que c’est de la science-fiction ? Erreur, c’est exactement ce qui est en train de se passer. « La reconnaissance émotionnelle est un sujet de recherche de plus en plus populaire dans le domaine de l’intelligence artificielle dédiée à la conversation », estime Viktor Rogzik, chercheur au sein de la division Alexa Speech Group d’Amazon. Il a écrit cette phrase en mai dernier, à l’occasion d’une note de blog qui détaille une nouvelle technologie de détection émotionnelle. Basée sur deux réseaux neuronaux antagonistes (« adversarial neural networks »), elle serait plus performante que celles qui existaient jusqu’à présent.

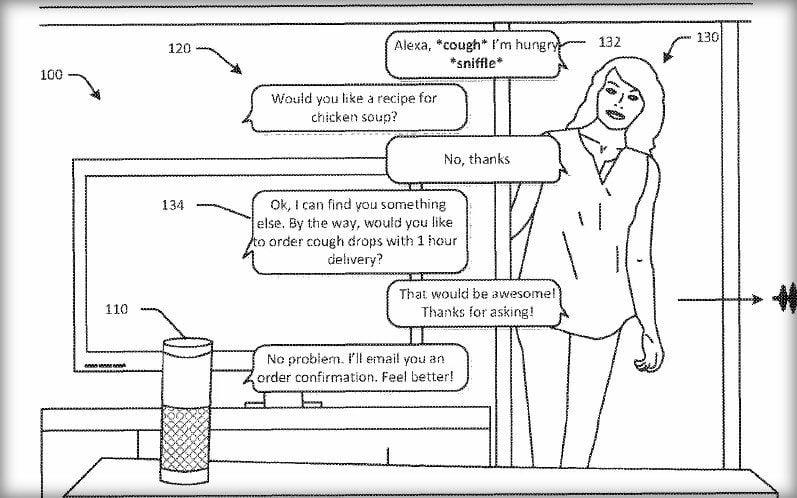

Dans leur publication scientifique, le chercheur et ses collègues décrivent des scénarios d’usage assez nobles, comme l’éducation, la santé ou la sécurité. Mais on pourrait également imaginer un usage plus mercantile, surtout pour une entreprise comme Amazon. Justement, selon The Telegraph, le géant du commerce en ligne a déposé en 2017 une demande de brevet pour un appareil capable d’analyser des émotions telles que « la joie, la colère, la tristesse, la peur, le dégoût, l’ennui, le stress », dans le but d’améliorer ses recommandations. Par exemple : proposer une brique de soupe de poulet pour quelqu’un qui est enrhumé et qui renifle.

Plus récemment, on a appris qu’Amazon planchait sur un bracelet connecté au nom de code « Dylan », destiné à « la santé et le bien-être ». Doté de microphones intégrés, il serait capable de reconnaître les émotions de l’utilisateur à partir du son de sa voix.

Mais Amazon n’est pas la seule entreprise à s’intéresser à ce domaine. En 2018, Huawei a dit qu’il souhaitait prochainement doter son assistant vocal, qui n’est pour l’instant que disponible en Chine, d’une capacité de détection émotionnelle. « Nous pensons qu’à l’avenir, tous nos utilisateurs voudront interagir avec [cet] assistant sur un mode émotionnel. C’est la tendance que nous voyons sur le long terme », a expliqué Felix Zhang, vice-président de l’ingénierie logicielle chez Huawei, auprès de CNBC.

Une IA pour contrer l’IA

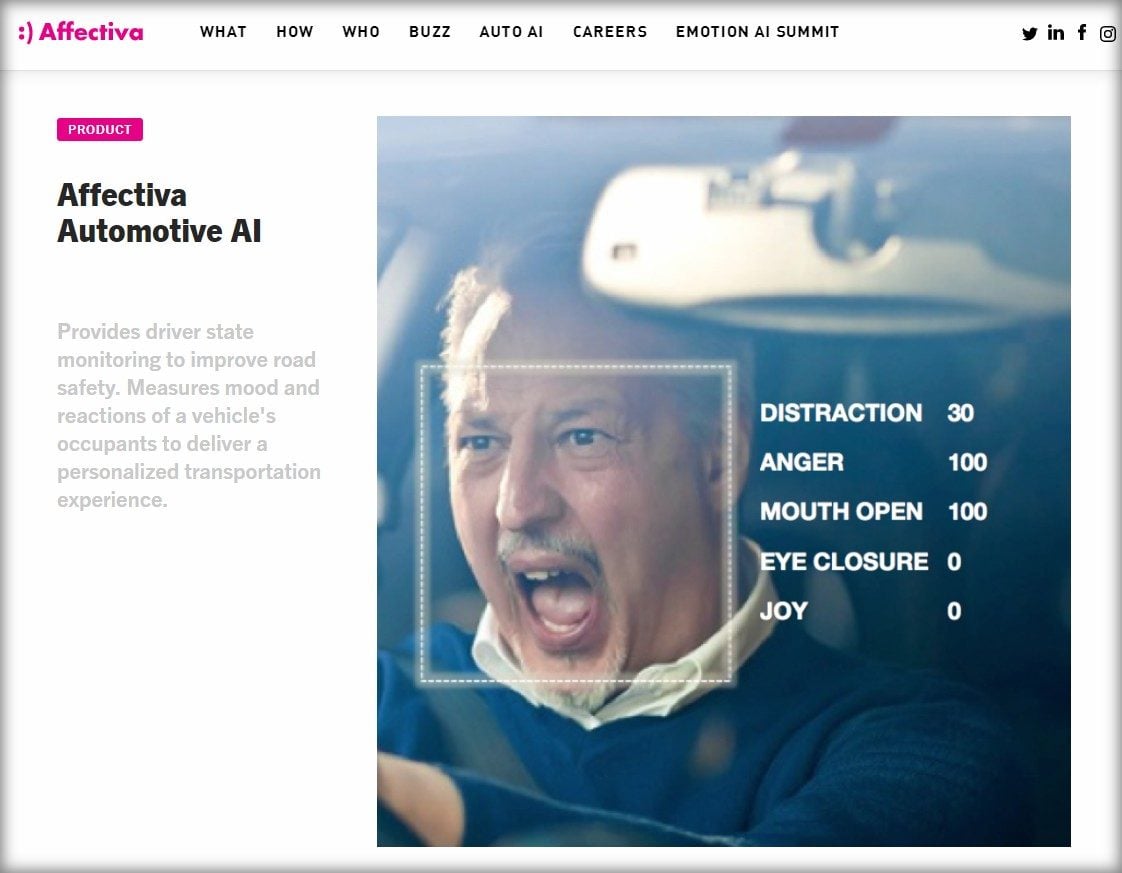

Certaines entreprises ont également décidé de se spécialiser sur le créneau de la détection émotionnelle. C’est par exemple le cas d’Affectiva, qui analyse le son de la voix et les expressions du visage. Elle propose sa technologie aux constructeurs automobiles, afin d’analyser l’état émotionnel du conducteur, mais aussi aux publicitaires, pour connaître les réactions des consommateurs face aux publicités. Dans ce dernier cas, toutefois, seules les expressions du visage sont prises en compte. Pour l’instant.

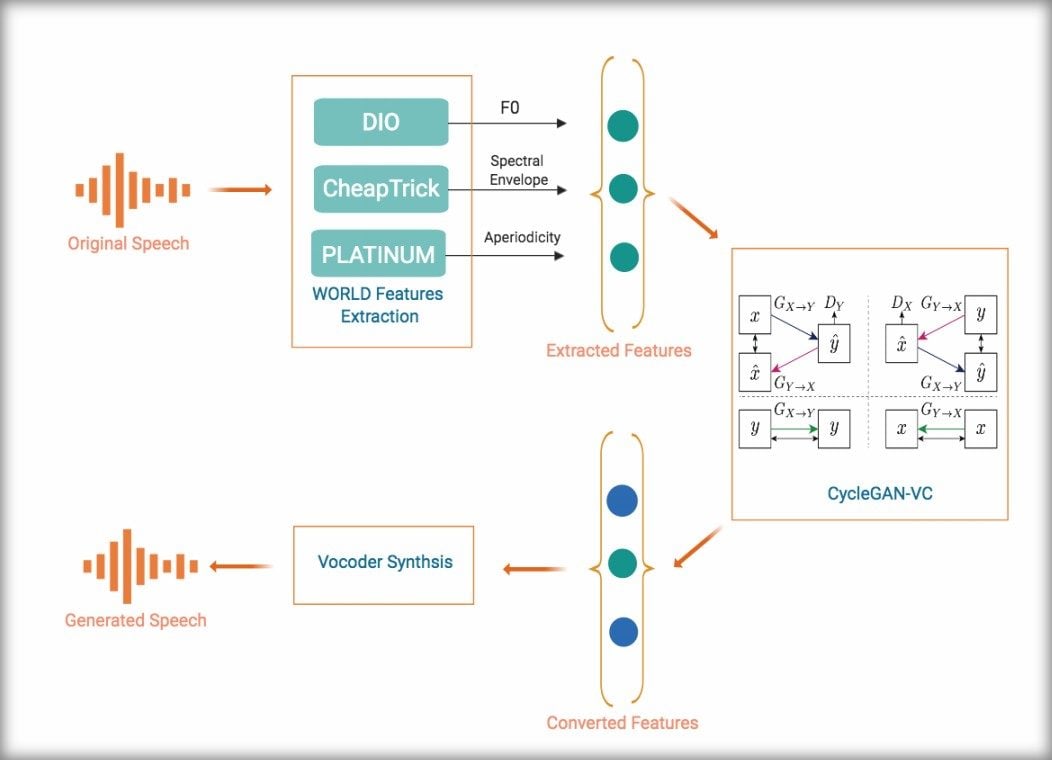

Cette nouvelle tendance provoque d’ores et déjà des résistances. Afin de préserver l’intimité des utilisateurs face aux assistants vocaux, trois chercheurs de l’Imperial College de Londres viennent de créer une intelligence artificielle capable de gommer les émotions dans la parole. Leur système est capable d’analyser en temps réel un flux vocal, d’en extraire les caractéristiques émotionnelles et, dans la foulée, de générer par synthèse vocale une version froide de cette même parole. Pour y arriver, les chercheurs s’appuient, entre autres, sur des réseaux neuronaux antagonistes pour l’analyse du flux vocal et sur « WORLD », un système de synthèse vocale à haute performance développé un 2016 par des chercheurs japonais.

Les chercheurs ont publié sur le web des exemples de phrases avant et après traitement. On remarque effectivement une très nette diminution de la charge émotionnelle, mais aussi une dégradation de la qualité de l’élocution. Cela est confirmé par les mesures réalisées par les chercheurs. Ainsi, si la qualité de reconnaissance de l’utilisateur reste assez stable, celle de la reconnaissance du contenu vocal décroît de 35 %. Avec ce système, l’assistant continuera de bien identifier l’utilisateur, mais il comprendra moins bien ce que celui-ci lui dit.

Enfin, même si les chercheurs arrivent à augmenter les performances de leur système, il n’est pas certain que les fournisseurs seront prêts à l’intégrer dans leurs appareils. Dans ce cas, peut-être faudra-t-il alors, pour parler à son assistant vocal, utiliser des amplificateurs vocaux portatifs dotés cette nouvelle technique d’anti-tracking. Un peu comme porter un masque devant une caméra de surveillance.

Source : Vice

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.