Si vous avez suivi l’actualité ces derniers jours, vous n’êtes certainement pas passé à côté de Google Duplex. C’est sans doute l’annonce la plus marquante de la Google I/O, tant l’intelligence artificielle présentée lors de la conférence semble avoir fait un bond dans le temps.

Le futur, c’est maintenant ?

Elle est désormais capable de communiquer dans un langage naturel… A tel point qu’elle a même la capacité d’entretenir une conversation téléphonique avec une personne réelle. Difficile à croire ? Pourtant, dans la démonstration, il est vrai enregistrée au préalable, Google Duplex a réussi à prendre rendez-vous tout seul chez un coiffeur, après négociation de la date et de l’horaire. La conversation, fluide et pleine d’intonations variées, paraît très éloignée de ce qu’on entend habituellement quand on a affaire à une voix de synthèse.

Mais comment est-ce possible (si ça l’est) et que pouvons-nous espérer faire avec Google Duplex ?

Le défi de la voix et du contexte

Premier casse-tête : la voix. Comme l’explique Google, imiter langage et comportement naturels n’est pas chose aisée. Car une conversation est aussi faite de silences, de phrases interrompues, reprises, de questions diverses, de petits “hmmm mmm” pour signifier qu’on est à l’écoute, sans oublier les variations d’intonation, d’accents, et les expressions propres à chacun… Modéliser tout cela est extrêmement complexe.

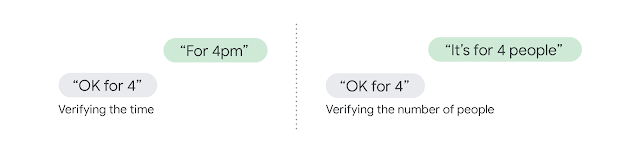

Vient ensuite un autre problème, celui de la compréhension. Toute personne qui a utilisé un assistant vocal comme Siri, le sait bien : pour se faire comprendre d’une IA, l’on est obligé de simplifier ses phrases… Et plus qu’une conversation, c’est surtout un question/réponse et souvent laborieux qu’il faut mener. Difficile en effet pour une IA de tenir la cadence et de prendre en compte le contexte, élément central d’une conversation entre deux humains.

Spécialiser pour donner le change

Dans son billet de blog, Google explique comment ses ingénieurs sont arrivés au résultat bluffant de la keynote de Google I/O. Premier point : pour interagir avec un coiffeur ou avec un restaurateur, Google Duplex est entraîné spécialement pour reconnaître les phrases types, les questions et mots utilisés, leur sens et le contexte d’utilisation. Autrement dit, Duplex n’est pas capable de discuter à bâtons rompus de tout et de rien avec un tel niveau de précision et de compréhension.

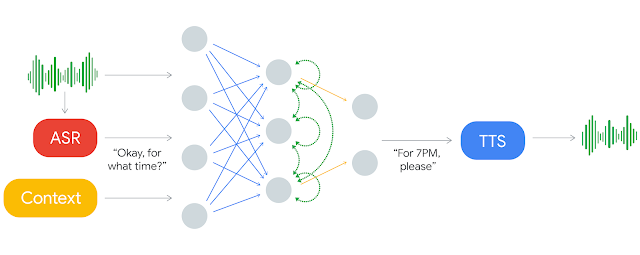

Pour proposer une conversation naturelle dans un thème précis, Duplex fonctionne avec un réseau de neurones récurrents auquel ont été soumis des ensembles de communications téléphoniques anonymisés. Ce sont ces données qui ont servi à son entraînement et qui lui ont permis de comprendre le sens des mots utilisés en fonction d’un contexte donné.

Pendant l’entraînement, les propos des interlocuteurs humains ont été passés au crible d’une technologie de reconnaissance vocale automatique. Les données ont été ensuite transmises au réseau neuronal avec des informations provenant de la piste audio, l’historique et d’autres paramètres de la conversation.

A terme, pour chaque domaine (coiffure, pédicure, etc.), Google a créé un modèle de compréhension puis l’a ensuite fusionné avec les éléments commun appris dans chaque secteur.

Deux outils pour une voix

Dès lors que l’IA a compris ce qu’il lui a été dit, elle doit répondre. C’est là qu’interviennent deux outils de synthèse vocale. Le premier est un moteur concaténatif de text to speech (TTS), un texte lu par une voix de synthèse. Le second est également un moteur TTS, composé lui de deux éléments présentés par Google en décembre dernier : Tacotron 2 et Wavenet. Schématiquement, le premier énonce la phrase et le second contrôle l’intonation en fonction des circonstances.

Enfin, pour rendre la conversation encore plus naturelle, Google a intégré des disfluences, ces petits “hmm” qu’on lâche sans s’en rendre compte pour signifier qu’on est toujours à l’écoute. Des petits signes, des conventions qui évitent que l’interlocuteur se demande si on est toujours en ligne. Quoi de plus humain que cette petite paresse ?

L’expérience va s’améliorer et s’enrichir

Ouf, si jamais Google Duplex est dans l’incapacité de répondre à une réponse complexe, il le signale à un opérateur pour que celui-ci reprenne le flambeau. De quoi éviter les bourdes et les situations embarrassantes !

Mais au fil du temps, Duplex devrait progresser et étendre sa sphère de compétences. Pour se former à un nouveau domaine, les progrès du système sont surveillés tandis que de nouveaux ensembles de données lui sont soumis en temps réel. Une fois un niveau de qualité satisfaisant atteint, la surveillance de l’entraîneur humain est arrêtée et Google Duplex gère alors les conversations dans ce nouveau domaine de façon autonome.

Google Duplex est encore au stade expérimental. Néanmoins CNet a eu le privilège de le tester en exclusivité avant la Google I/O et rapporte que Google entend le déployer progressivement. Le but est de proposer une intelligence artificielle assistant les utilisateurs tout au long de la journée, sans raté. Voilà pourquoi l’intégration à Google Assistant devrait se faire en douceur à partir de l’été prochain.

Vu la difficulté et les multiples nuances de la langue française, il est peu probable que ce service débarque dans l’Hexagone prochainement. Que ce soit en anglais ou en français, nous attendons de pouvoir tester cette fonctionnalité ou de la voir à l’ouvrage pour vraiment y croire.

Source :

Google

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.