La nouvelle RTX 4090 de Nvidia est-elle un désastre énergétique ou au contraire un champion de l’efficacité ? La réponse tient dans la manière dont cette carte graphique très haut de gamme est utilisée, comme l’ont démontré des bidouilleurs. Rappelons le contexte : dans la nouvelle génération de puces graphiques RTX 4000 présentée par Nvidia, tout au sommet trône la RTX 4090.

A lire aussi : Nvidia annonce les GeForce RTX 4090 et 4080 : elle explosent les performances… et les prix ? (septembre 2022)

Cette carte est un monstre à tous les égards. En consommation énergétique tout d’abord : avec un TGP de 350 W et des pointes possibles à 450 W, la carte a de quoi faire trembler de nombreuses alimentations milieu de gamme. Elle a même fait fondre de nombreux connecteurs ! C’est cette soif de puissance qui a déterminé son format, proprement gigantesque. La carte de référence est tellement grande qu’elle nécessite trois emplacements PCIe dans les PC ! Et transforme toutes ses concurrentes en naines à cause de son imposant dissipateur thermique. Et puis il y a le prix finalement : à plus de 2 000 € en moyenne, c’est la carte gaming la plus chère de l’histoire. Pourtant, Nvidia aurait pu écrire l’histoire autrement.

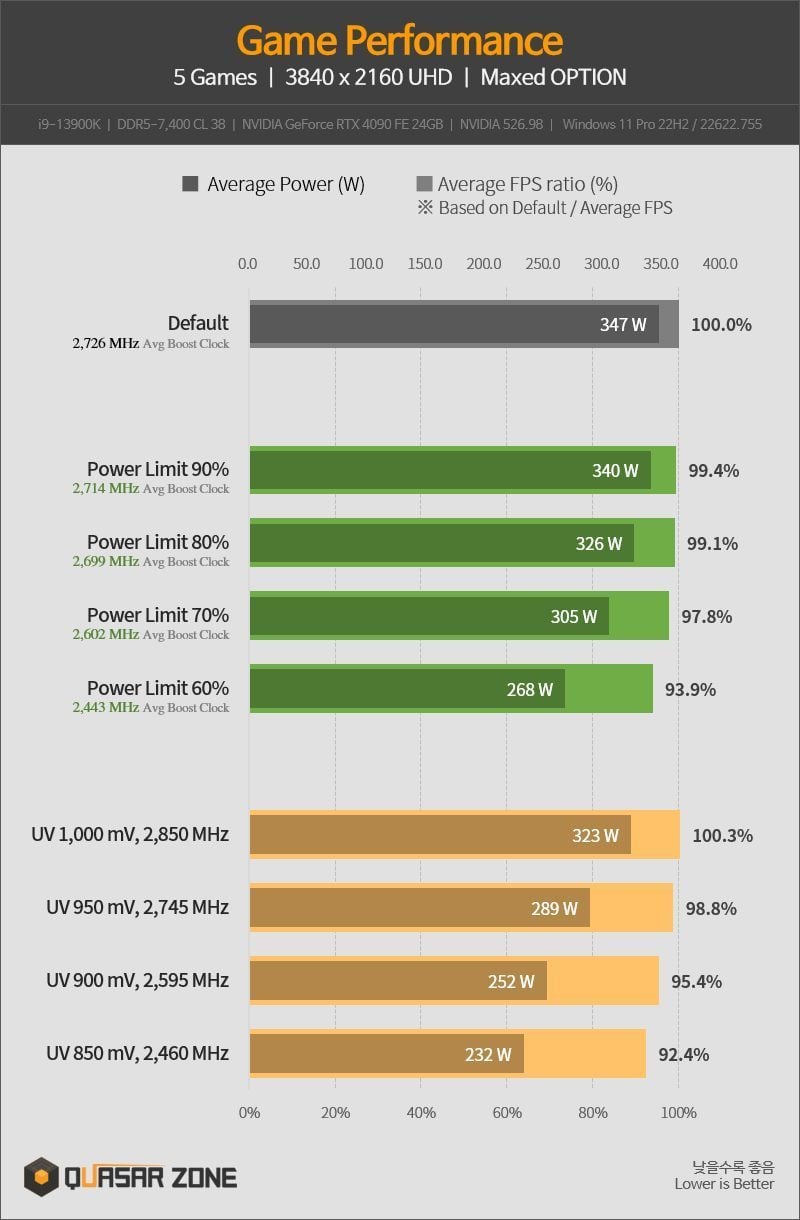

C’est ce que démontre un bidouilleur coréen qui a effectué une opération de sous-voltage de sa carte – une version Nvidia Founders Edition. En limitant le voltage de sa carte, notamment la fréquence de boost moyenne, le Coréen a démontré que des pertes minimes de performances permettent d’abaisser massivement la consommation de pointe de la carte. Plus précisément, en passant de 1 V (1 000 mV) à 850 mV, la carte développe déjà 92,4% de sa puissance, mais sa consommation moyenne passe de 347 Watts à seulement 232 W ! Vous allez me dire que l’opération de sous-voltage est potentiellement risquée et que les ingénieurs de Nvidia ont bien fait de faire attention à ces tensions.

A lire aussi : Nvidia RTX 4090 : les câbles peuvent fondre si vous les avez mal branchés (nov. 2022)

Oui, mais notre bidouilleur a aussi pensé à cela et a utilisé un outil permettant simplement d’abaisser la limite de puissance énergétique de boost de la carte en la faisant passer à 60%. Dans ce mode, la RTX 4090 développe 93,9% de sa puissance initiale dans les jeux et ne consomme plus que 268 W (contre 347 Watts). En clair : les 6,1 points performances supplémentaires « coûtent » 79 Watts. Une dépense énergétique qui semble clairement déraisonnable.

A lire aussi : Radeon RX 7900 XT et XTX : AMD attaque les GeForce sur la taille, l’énergie et… le prix ! (nov. 2022)

On pourrait utiliser l’argument que la RTX 4090 n’est pas une carte « normale » et qu’en tant que mètre étalon de la puissance, elle peut tout se permettre pour être « la plus rapide du monde ». Les RTX 4080 et descendantes étant là pour les « vrais » joueurs. Mais le fait est qu’en 2022, avec le contexte climatique et énergétique actuel, on a presque envie de dire « chaque watt compte » et que l’efficacité énergétique devrait être le Graal absolu – c’est déjà le cas dans les puces mobiles, souvent limitées à 4-5 W ! C’est d’autant plus stupide pour Nvidia que, une fois abaissé aux alentours de 250 W, sa carte devient alors la championne de l’efficacité énergétique en fps/watt. La compétition de la course à la puissance a du bon pour la concurrence, mais elle pousse malheureusement certains à des comportements extrêmes dont on pourrait clairement se passer. Vivement les tests des cartes à 250 W de chez Nvidia pour que ce bad buzz se transforme en justes récompenses de sa nouvelle architecture GPU.

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.

Source : Quasar Zone

Article qui me semble un peu à côté de la plaque si je puis me permettre … Car il s’applique en fait à la quasi totalité des cartes, mais dépend aussi et surtout de la qualité du die processeur. Les constructeurs de processeur comme de cartes graphiques appliquent souvent des voltages un peu au dessus et des fréquences un peu de dessous de ce qui est possible pour s’assurer que tous les modèles seront stables malgré les différences de qualité à la production des die. Après il appartient à chacun de tester ses composant pour voir s’il a ou non tiré le bon numéro qui permet de downvolter et/ou d’overclocker le composant selon sa qualité.

En effet, le downvoltage fonctionnera de façon plus ou moins stable d’un modèle à l’autre, car chaque die est un peu plus ou moins quali que son voisin !

Ca a toujours été, tant en downvoltage qu’en overclocking, toutes les puces ne se valent pas, on le sait. Les overclocker “officiels” ont d’ailleurs toujours des composants réservés par les marques, passés au crible, pour s’assurer qu’ils sont le plus possible proche de la perfection, afin de garantir la plus grande stabilité possible pour décrocher un nouveau record.

Par exemple, j’ai un 5950X sur ma machine qui monte allègrement à 4.9Ghz, stable, sur tous les coeurs, alors qu’il est downvolté à 1.25V max seulement. Ce qui fait qu’il consomme moins en offrant plus de perfs, et oui !

Mais celui d’un pote n’arrive pas à passer les 4.5GHz. J’ai eu de la chance, lui moins …

Idem pour ma 3080Ti, qui est largement downvoltée pour ne consommer plus “que” 310W en burn, alors que ma version SuprimX en consommait allègrement 420 en burn avec les paramètres stock, pour un GAIN de puissance d’environ 12% par rapport à quand elle consommait 360W. Là encore, un peu de chance et beaucoup de temps pour trouver les bons réglages.

Bref, cet article ne dit rien de nouveau, je dirais même qu’il enfonce des portes ouvertes en grand depuis au bas mot 10 ans … Et je dirais aussi que notre ami coréen n’a pas eu de chance ou un bon modèle, car on peut facilement brider la conso de bon nombre de 4090 (et 4080 et autres) sans amputer le moindre % de perf, et même réussir à les OC un peu pour avoir plus de perfs pour moins de watts !

Et donc pour conclure, je suis surpris que 01, média normalement spécialisé, s’engouffre dans ce genre de news sans prendre le moindre recul sur ce point ni en parler de près ou de loin. J’ai un peu l’impression que si le rédacteur est tout bonnement excellent sur les sujets photo, il l’est un peu moins sur les sujets hardware informatique pures.

Bonjour Eddy,

Je soulève bien ce point du souci du downclocking dans l’article si vous le relisez bien.

Je sais bien que la qualité des dies ne permet pas de baisser le voltage en masse, la première manipulation citée ici est donnée pour montrer le potentiel de l’architecture.

Ce qui est VRAIMENT regrettable, c’est que Nvidia pousse si loin les fréquences : au-delà de certaines fréquences, le rapport perf/watts s’effondre. L’opération ne sert donc qu’à “avoir la plus grosse” et nuit à la perception de la qualité de l’archi de Nvidia. De plus, si AMD et Nvidia ont TOUJOURS eu cette attitude par le passé, je ne pense pas enfoncer des portes ouvertes en pointant les 450W de pointe et la carte qui demande 3 slots complets dans un boîtier !

Merci de votre lecture et bonne journée.