C’est l’histoire d’une société qui d’un côté, ne cesse de répéter qu’il faut réglementer l’intelligence artificielle. En tournée européenne le mois dernier, Sam Altman, le PDG d’OpenAI, a déclaré à qui voulait l’entendre qu’il fallait de toute urgence édicter des règles pour ce secteur. C’est cette même société qui, de l’autre, tente en toute discrétion de réduire la portée de ces futures règles, en militant pour alléger « le fardeau réglementaire » prévu par le futur Règlement européen sur l’IA, rapporte le Time, ce mardi 20 juin. Nos confrères montrent comment la start-up à l’origine de ChatGPT a approché les législateurs européens pour leur suggérer des modifications du Règlement sur l’intelligence artificielle, ces douze derniers mois.

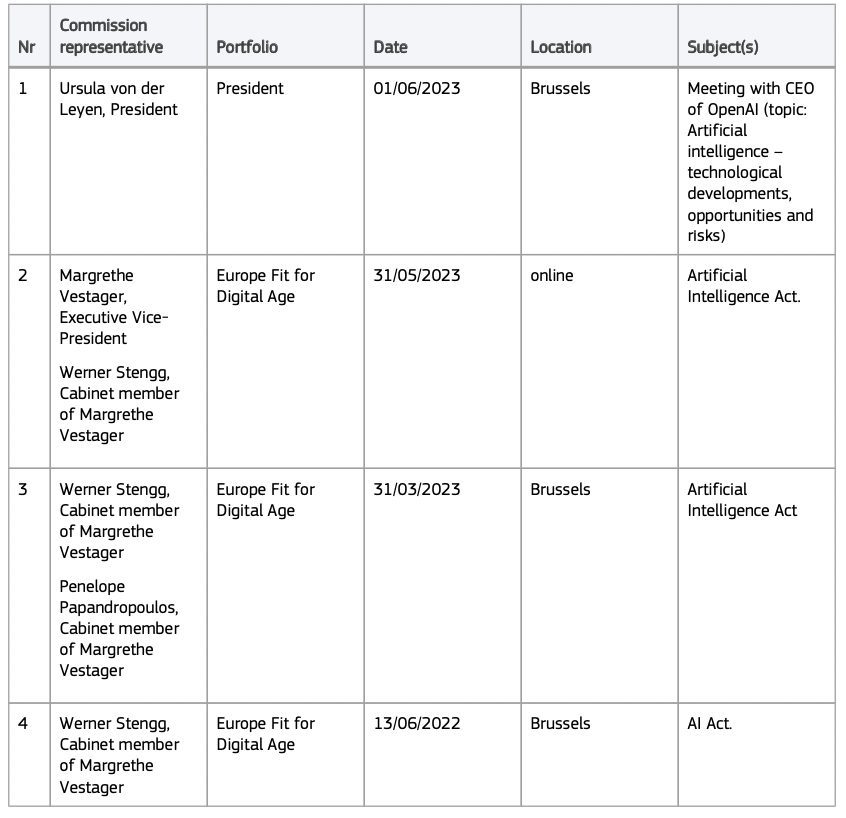

Et ces opérations de lobbying, qui sont tout à fait licites, auraient été efficaces. Certains des arguments émis ont tellement convaincu les Eurodéputés qu’ils ont été adoptés, comme on peut le voir dans leur version votée en assemblée plénière le 14 juin dernier. Tout aurait commencé il y a près d’un an, en juin 2022, bien avant le lancement de ChatGPT, rapportent nos confrères. Sur le registre de transparence des législateurs européens, une base de données en ligne accessible à tous qui répertorie les groupes et les organisations de lobbying tentant d’influencer les législateurs européens, on trouve en effet un premier rendez-vous, le 13 juin 2022, avec un membre du cabinet de Margrethe Vestager, la vice-présidente de la Commission européenne, à Bruxelles.

Au cours de cette première réunion, les représentants d’OpenAI auraient exprimé leur préoccupation à l’égard des systèmes d’IA à usage général – comme GPT3 – qui seraient inclus dans les systèmes à haut risque, une catégorie définie dans le Règlement européen sur laquelle pèse de nombreuses obligations de transparence et de surveillance.

Si ChatGPT est classé dans cette catégorie, il devrait en théorie passer par des procédures d’évaluation préalable, et de contrôle de conformité avant de pouvoir être accessible aux Européens. OpenAI aurait aussi l’obligation de mettre en place un système de gestion du risque, une politique contraignante de gouvernance des données utilisées pour l’entraînement, un contrôle humain du système, en plus de respecter des obligations d’exactitude, de robustesse et de cybersécurité. Déjà, le spectre de la surrèglementation et de son impact sur l’innovation aurait été brandi par la start-up lors de cette première réunion, selon une source du Time qui a souhaité garder l’anonymat. Cette fois-là, les représentants d’OpenAI ne seraient pas allés plus loin. Ils n’auraient pas demandé de manière explicite des règles plus souples.

Le partage d’un livre blanc, avec des demandes de modifications du texte

Mais en septembre 2022, ces derniers sont revenus à la charge, en envoyant un livre blanc aux représentants de la Commission et du Conseil de l’UE, un document de sept pages publié par nos confrères. On peut y lire les arguments d’OpenAI qui décrit les différents garde-fous mis en place pour éviter que ses systèmes d’IA générative ne soient utilisés à mauvais escient, selon la start-up. L’ensemble de ces mesures devrait suffire à ne pas classer leurs IA génératives dans les outils à haut risque, plaide la société. « En soi, GPT-3 n’est pas un système à haut risque. Mais [il] possède des capacités qui peuvent potentiellement être employées dans des cas d’utilisation à haut risque », écrivent les auteurs du livre blanc.

« Ce qu’ils disent, en gros, c’est : faites-nous confiance pour nous autoréguler », commente Daniel Leufer, analyste politique spécialisé dans l’IA au sein de Access Now, interrogé par le Time. « C’est très déroutant parce qu’ils s’adressent aux politiciens en leur disant “S’il vous plaît, réglementez-nous”, ils se vantent de toutes les mesures [de sécurité] qu’ils prennent, mais dès que vous leur dites “Eh bien, prenons-les au mot et fixons un plancher réglementaire”, ils disent non », poursuit-il. En mai dernier, le PDG d’OpenAI avait prévenu qu’il pourrait« cesser ses activités » en Europe s’il se jugeait incapable de se conformer au Règlement européen sur l’IA, un texte sur lequel il avait « beaucoup » de critiques… avant de faire machine arrière.

Certaines demandes reprises dans le texte des Parlementaires européens

Le livre blanc va ensuite plus loin, en « suggérant des amendements » : OpenAI souhaite par exemple que les mises à jour des systèmes pour des raisons de sécurité n’aient pas à repasser par une nouvelle évaluation de l’UE pour être sur le marché. La société a aussi plaidé pour que certaines utilisations de l’IA dans l’éducation et l’emploi ne soient pas considérées comme à haut risque, comme le fait de générer des offres d’emploi. Ses arguments ont-ils fait mouche ?

Oui, pour certains, car plusieurs mois plus tard, le Parlement européen finit par publier une version du Règlement sur laquelle les 705 Eurodéputés se sont mis d’accord. La phrase présente dans les versions précédentes de la Commission et du Conseil, qui suggère que les systèmes d’IA à usage général doivent être considérés comme intrinsèquement à haut risque, a disparu. À la place, le texte adopté par le Parlement évoque les développeurs de « modèles de base », ou de systèmes d’IA entraînés sur de grandes quantités de données. Ces derniers ne devraient se conformer qu’à quelques obligations, comme le fait de mentionner que le système a été entraîné sur des données protégées par le droit d’auteur, ou le fait d’éviter de générer des contenus illicites.

Les succès d’OpenAI pourraient ne pas être repris dans la version définitive du texte

Autre succès pour OpenAI : dans le livre blanc, la start-up s’oppose à une proposition d’amendement des Eurodéputés qui classerait les systèmes d’IA générative comme ChatGPT et Dall-E dans la catégorie « à haut risque », à partir du moment où le texte ou les images générés passent pour avoir été faits par un humain – ce qui aurait conduit à classer automatiquement ces IA comme présentant un risque élevé. OpenAI explique que l’obligation de mentionner « contenu généré par l’IA » serait suffisant. Et finalement, l’amendement en question n’a pas été retenu par les parlementaires européens.

Enfin, lors d’une dernière réunion en date du 31 mars dernier bien listée dans le registre, OpenAI a présenté aux fonctionnaires européens travaillant sur la loi les fonctions de sécurité de ChatGPT, rapportent nos confrères. Elles permettraient d’éviter d’avoir des recettes de fabrication de substances dangereuses émises par ChatGPT. Mais le garde-fou mis en place est facilement contournable, souligne le Time, ChatGPT pouvant être amené à écrire des courriels d’hameçonnage ou générer des consignes pour fabriquer des substances illicites.

Si OpenAI a réussi à faire valoir son point de vue, les choses pourraient encore changer, puisque le Règlement sur l’IA n’a pas encore été voté, il doit désormais être discuté en trilogue. La version finale sur laquelle le Parlement européen, le Conseil et la Commission européenne s’accorderont pourrait comprendre des règles encore plus strictes pour les systèmes d’IA à usage général comme ChatGPT… pour le plus grand malheur de Sam Altman.

À lire aussi : Drogues, meurtres, vols : on a testé un « ChatGPT » non censuré… et ça fait peur

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.

Source : Time