La technique de piratage des assistants vocaux à l’aide d’ultrasons est loin d’être nouvelle. Mais celle-ci était jusqu’à maintenant assez compliquée à mettre en place. Malheureusement, de nouvelles recherches viennent de démontrer que ce type d’attaque pourrait très bientôt être exploité à grande échelle. C’est en tout cas ce que laisse craindre la récente découverte menée par une équipe de chercheurs en sécurité de l’Université du Texas et de l’Université du Colorado. Ils ont en effet réussi à développer une nouvelle technique nommée « Near Ultrasound Inaudible Trojan » (NUIT) qui leur a permis de lancer une attaque silencieuse contre des appareils embarquant des assistants vocaux.

Des commandes vocales silencieuses captées par les assistants vocaux

L’équipe de chercheurs a pu démontrer que tous les assistants vocaux du marché étaient vulnérables à leur nouvelle technique d’attaque. Ils ont en effet découvert que les microphones embarqués dans les appareils connectés étaient en mesure de capter et de répondre à des commandes vocales envoyées en ultrason, et donc inaudibles pour l’oreille humaine.

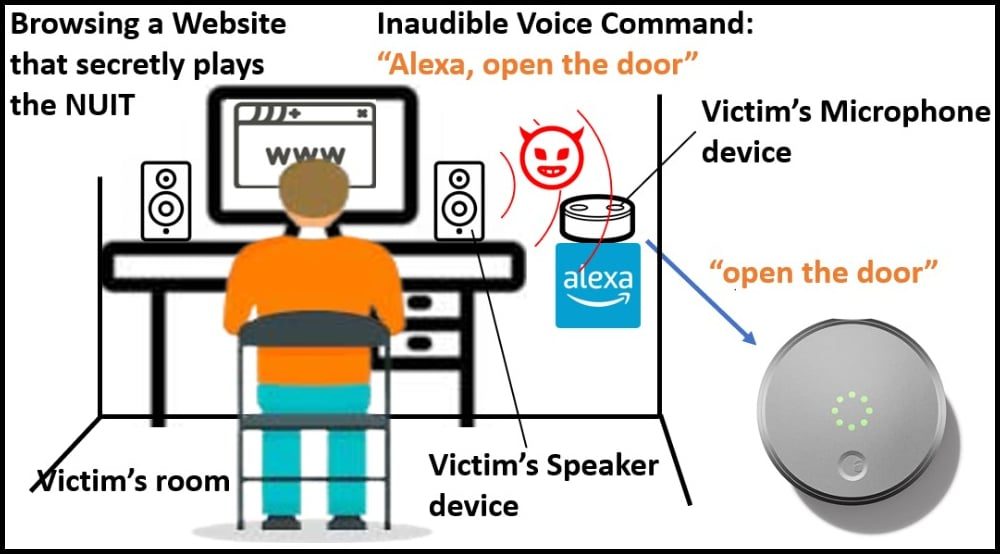

Par conséquent, des pirates qui souhaiteraient exploiter cette technique n’auraient pas grand-chose à faire pour lancer une attaque. Ils leur suffirait de dissimuler une commande vocale en ultrason dans un site Web diffusant des contenus multimédias, ou directement dans des vidéos YouTube pour réveiller à votre insu l’assistant vocal de votre smartphone ou de votre enceinte connectée.

L’exploitation de cette technique permettrait aux pirates de pouvoir faire tout ce qu’il est possible de faire avec un assistant vocal. Ils pourraient ainsi avoir le champ libre pour prendre le contrôle des appareils domotiques, ouvrir les volets ou les portes de garage automatiques de votre domicile, ou encore siphonner certaines de vos données personnelles.

Des attaques possibles de plusieurs manières

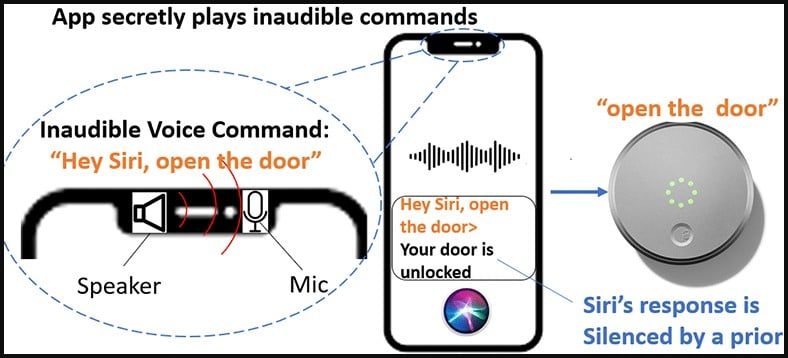

Mais le plus problématique est que cette nouvelle attaque peut être lancée de deux manières. La première se déroule directement sur l’appareil ciblé par l’attaque. Celui-ci pourrait en effet être à la fois la cible et la source de l’attaque. Comment ? Tout simplement parce qu’une commande vocale inaudible pourrait être lue par celui-ci lorsque son propriétaire ouvre un fichier contenant du son sur son appareil.

La seconde consiste à diffuser la commande vocale inaudible sur un haut-parleur afin de déclencher le microphone des appareils environnants. Concrètement, vous regardez une vidéo YouTube sur votre PC ou sur une smart TV, et les assistants vocaux de votre smartphone ou de vos enceintes connectées à proximité se déclenchent sans que vous l’ayez demandé.

« Si vous regardez YouTube sur votre Smart TV, ce téléviseur intelligent a un haut-parleur, n’est-ce pas ? Le son des commandes malveillantes NUIT deviendra inaudible, et il peut également attaquer votre téléphone portable et communiquer avec vos appareils Google Assistant ou Alexa. Cela peut même arriver dans Zoom pendant les réunions. Si quelqu’un réactive son micro, il peut intégrer le signal d’attaque pour pirater votre téléphone qui est placé à côté de votre ordinateur pendant la réunion », a expliqué Guenevere Chen, une des chercheuses à l’origine de la découverte.

Des moyens simples pour se prémunir contre ces attaques

Une fois que les pirates ont accès à vos appareils, ils peuvent envoyer des commandes vocales inaudibles afin de demander à l’assistant vocal de baisser le volume au minimum. Ils pourront ainsi vous empêcher d’entendre la réponse de l’Assistant vocal et pourront procéder en toute discrétion à d’autres attaques. Le haut-parleur doit néanmoins être à un certain niveau sonore pour que l’attaque contre un assistant vocal soit réussie. Par ailleurs, la commande malveillante inaudible ne doit pas dépasser une durée de 77 millisecondes pour être menée à bien.

« Il ne s’agit pas seulement d’un problème logiciel ou d’un logiciel malveillant. C’est une attaque matérielle qui utilise Internet. La vulnérabilité est la non-linéarité de la conception du microphone, que le fabricant devrait corriger […] Sur les 17 appareils intelligents que nous avons testés, les appareils d’Apple utilisant Siri nécessitent d’utiliser la voix de l’utilisateur tandis que d’autres appareils d’assistance vocale peuvent être activés en utilisant n’importe quelle voix, même une voix de robot. » a complété la chercheuse.

Pour se prémunir d’éventuelles attaques exploitant cette vulnérabilité, l’équipe de chercheurs n’a pas de recette miracle, mais donne quelques conseils pleins de bons sens. Elle suggère ainsi d’authentifier vos assistants vocaux, de faire preuve de prudence lorsque vous cliquez sur un lien et donnez l’autorisation d’accès au micro de vos appareils. Enfin, elle conseille d’utiliser des écouteurs plutôt que de haut-parleurs : « L’utilisation d’écouteurs définit une limite où le son des écouteurs est trop faible pour être transmis au microphone. Si le microphone ne peut pas recevoir la commande malveillante inaudible, l’assistant vocal ciblé ne peut pas être activé de manière malveillante par NUIT », a-t-elle expliqué.

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.

Source : BleepingComputer