L’architecture Ampere de Nvidia arrive sur le marché mais, malheureusement, pas sous la forme de carte graphique GeForce RTX pour nos beaux PC de bureau.

Dans un premier temps, la puce A100 – un beau bébé du 826 mm2 – va prendre place dans les serveurs, supercalculateurs et autres super structures informatiques pour les professionnels, le monde de la recherche, de l’intelligence artificielle, etc.

Bilan : les GeForce RTX (et Quadro RTX) actuelles peuvent souffler, elles vont rester en rayon encore quelque temps, et dans nos PC également.

La Nvidia A100 à la loupe

En quelques chiffres et quelques mots, l’A100 est une déclinaison de la grosse puce mère de la génération Ampère, la GA100. Oui, il y a toujours un plus gros poisson, même dans le monde la tech. L’A100, donc, est une version un peu allégée mais qui a de lourds arguments à faire valoir, autre que sa taille.

- La puce A100 est gravée en 7 nm contre 12 nm pour la puce Turing actuelle. C’est TSMC qui se charge de la fabriquer, selon un processus mis au point en partenariat avec Nvidia.

- Il y a 54 milliards de transistors gravés sur le circuit (contre 18,6 milliards pour la RTX 2080 Ti par exemple).

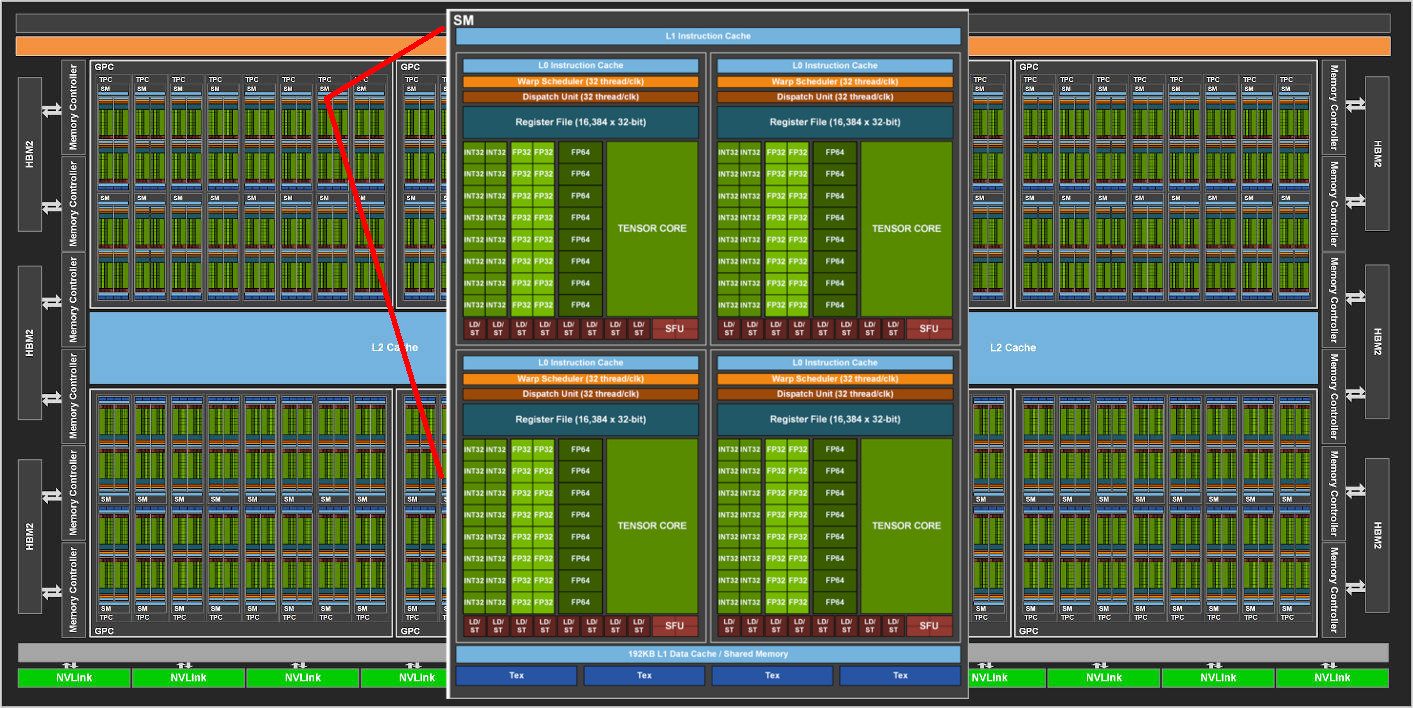

- L’A100 embarque 6912 CUDA Core (les unités de calcul) pour faire du calcul de simple précision (FP32) et 3456, pour les opérations en double précision (FP64). En comparaison, la 2080 Ti possède 4352 CUDA Core (FP32).

- Le nombre de Tensor Core, les unités spécialisées dans le traitement de l’IA et de toutes les opérations d’apprentissage, s’élève à 422. Etonnamment, la Volta V100 en avait 640 et l’actuelle RTX 2080 Ti, le plus haut de gamme des cartes 3D, en embarque 544.

- Pas de RT Core pour le ray tracing, ce qui est logique puisque son objectif n’est pas le rendu de graphismes en 3D ultra-réalistes.

- Sur le circuit se trouve une grosse mémoire cache de 40 Mo, soit presque 7 fois plus que la V100.

- En revanche, cinq ensembles de modules mémoire HBM2 de 8 Go chacun (40 Go donc) sont accolés à la puce et la taille du contrôleur mémoire atteint 10512 bits. Pour rappel, la puce Volta n’avait que 16 Go à se mettre sous les cœurs lors de sa sortie, en 2017.

Forte de tout cela, l’A100 serait jusqu’à 20 fois plus efficace que la V100 lorsqu’il s’agit d’entraîner une intelligence artificielle selon Nvidia. Il est même possible de virtuellement morceler la puce en plusieurs morceaux, afin de les allouer à des tâches différentes. C’est ce que Nvidia appelle le MIG, le Multi-Instance GPU.

Pour faire simple, si on devait utiliser une seule A100 pour faire du cloud computing, on pourrait lancer jusqu’à seot opérations de calcul différentes sur une puce. Chaque opération serait cloisonnée des autres et aurait accès à une certaine quantité de cœurs et de mémoire (cache et vive) allouée à ses besoins pour mener sa tâche à bien.

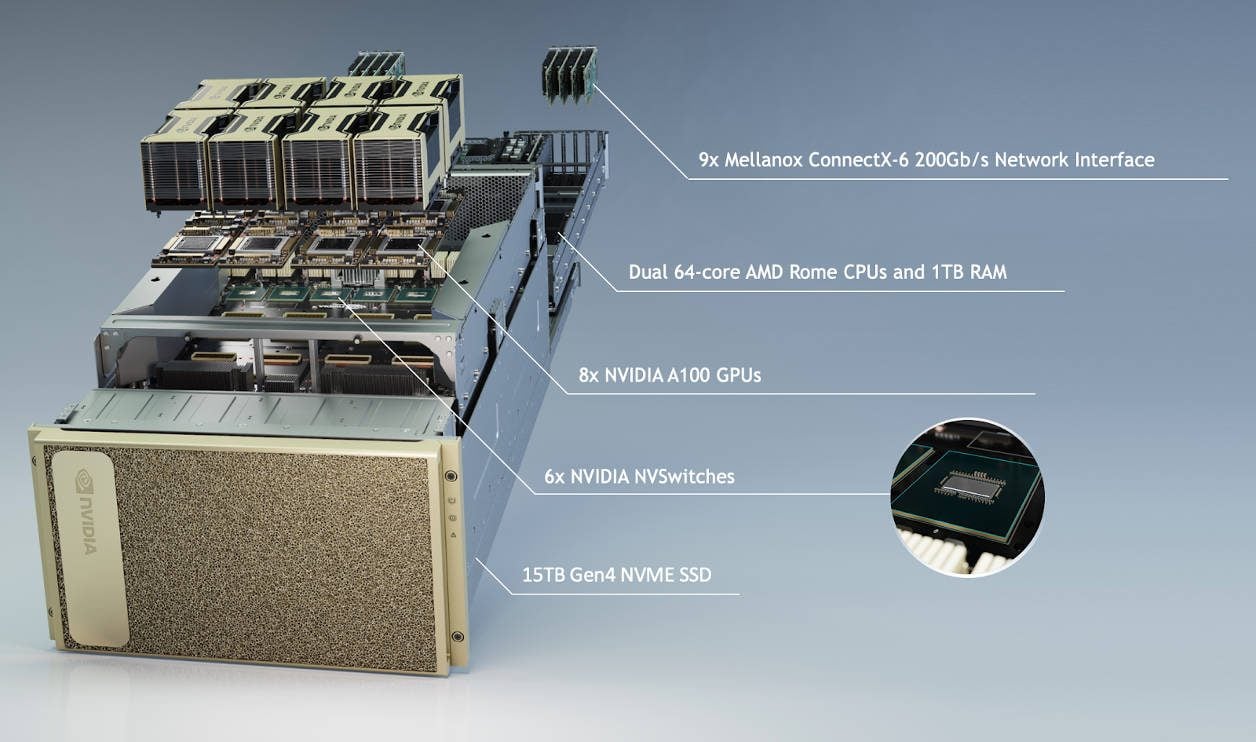

Mise à prix : 200 000 dollars

L’A100 est proposé au sein de plusieurs super structures de calcul, comme le DGX A100 de Nvidia, qui constitue l’offre d’entrée de gamme. Pour la bagatelle de 200 000 dollars, une lame de serveur est motorisée par huit puces A100, deux processeurs AMD à 64 cœurs, 1 To de mémoire vive et 15 To de SSD au format NVMe. Rien que ça. La question que nous nous posons avec plusieurs de nos confrères : est-ce que le DOOM originel tournerait dessus ? Nous avons un doute.

Source : Nvidia

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.