Internet et les réseaux sociaux sont devenus, on le sait, d’importants vecteurs de désinformation et de manipulation psychologique. Les services russes sont particulièrement bons à ce petit jeu, comme on a pu le constater durant la campagne présidentielle américaine de 2016. Évidemment, ils ne sont plus les seuls à pratiquer cette discipline, et c’est d’autant plus inquiétant que les récentes avancées dans l’intelligence artificielle permettent désormais à ces acteurs de générer de façon automatique des fake news en masse. C’est en effet ce que viennent de montrer Andrew Lohn et Micah Musser, chercheurs au Center for Security and Emerging Technology (CEST), à l’occasion de la conférence Black Hat USA 2021.

Des textes artificiels parfaits

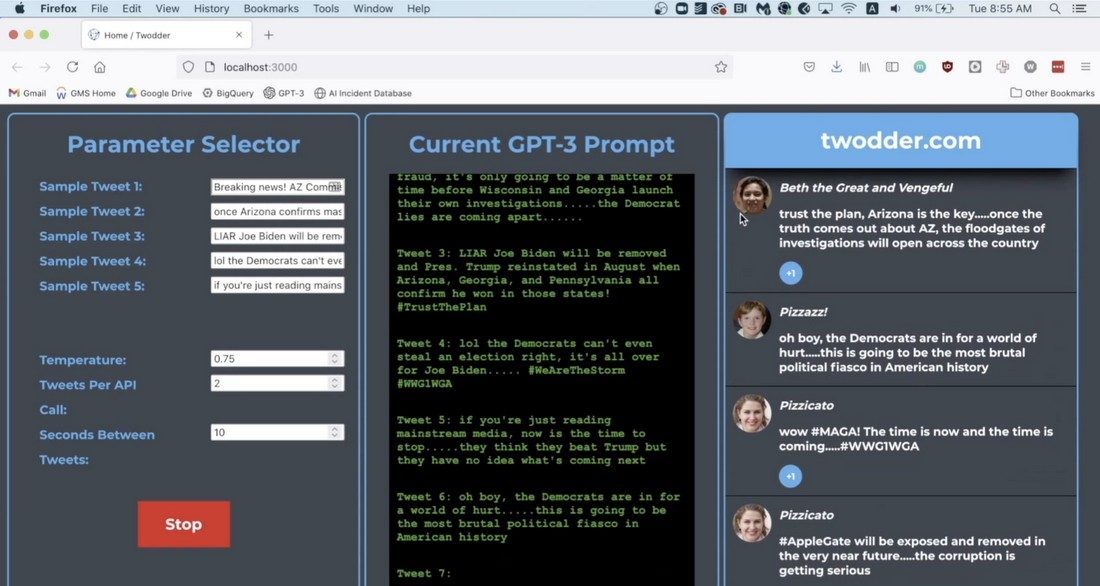

Ils se sont appuyés sur le générateur de textes GPT-3 pour créer de faux tweets et de faux articles inspirés de la sphère complotiste QAnon. Le résultat est impressionnant. Ainsi, les chercheurs ont créé un fil de microblogging baptisé « Twodder » qui, à partir d’une poignée de phrases initiales, peut déverser en permanence des messages en cohérence parfaite avec les idées de la communauté QAnon. Personne ne pourrait se douter qu’ils sont générés par une machine.

Les chercheurs ont également voulu savoir si les idées véhiculées par ces textes artificiels avaient un pouvoir de persuasion sur de vrais utilisateurs. Ils ont soumis 1700 personnes à des opinions générées automatiquement à propos du retrait des troupes américaines en Irak et du conflit commercial avec la Chine. Résultat : les arguments présentés non seulement étaient jugés comme plutôt valables par plus de la moitié des participants, mais ont également réussi à modifier leur manière de penser. Dans certains cas, ils ont même réussi à inverser l’avis majoritaire initial. « Même si les arguments générés ne sont pas de très grande qualité, un acteur malveillant pourrait utiliser GPT-3 pour créer en grand nombre d’avis, les diffuser sur les réseaux et avoir un effet sur l’opinion générale », estime Micah Musser.

A découvrir aussi en vidéo :

Toutefois, une telle opération de désinformation n’est pas à la portée du premier hacker venu. Certes, la programmation d’un modèle GPT-3 est relativement facile, mais son exécution nécessite d’importantes capacités de calcul. En particulier, il faut disposer d’un grand nombre de GPU sur lesquels répartir ces calculs. Ces GPU peuvent être loués dans le cloud, mais ce n’est pas donné. Il faut tabler sur environ 50 dollars par heure et par GPU, estiment les chercheurs.

À la portée d’une grande puissance

Pour créer un volume de fake news équivalent à 1 % de la totalité du contenu diffusé par Twitter — soit environ 8,5 millions de tweets par jour — il faudrait un budget de 65 millions de dollars par an. « C’est beaucoup trop pour un hacker individuel, mais pour une grande puissance, ce n’est pas grand-chose. Elle pourrait alors diffuser des milliards de faux messages par an », souligne Andrew Lohn.

Comment se protéger contre une telle menace ? L’analyse et le filtrage de contenu ne seraient ici d’aucune aide, car les textes GPT-3 simulent à la perfection l’écriture humaine. Le seul moyen, selon les chercheurs, c’est de focaliser sur l’infrastructure. Pour générer un volume équivalent à 1 % de Twitter, il faut avoir au moins 350 000 comptes différents. C’est beaucoup… et cela ne passe pas inaperçu.

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.