Le jeu vidéo va-t-il enfin toucher le photoréalisme ? On peut penser que oui en regardant les vidéos de démonstration d’une unité de recherche d’Intel présentée au salon viennois Eurographics 2021. Point de nouveau jeu ou de simulation irréelle, mais une version améliorée du vénérable GTA V, sorti en 2013.

La technologie s’appelle « Enhancing Photorealism Enhancement », une dénomination un peu tirée par les cheveux qui modifie en profondeur le rendu initial du moteur pour le rendre plus réaliste. Bien plus réaliste : fini les couleurs trop chaudes, les réflexions approximatives et taux de contraste exagérés. Les surfaces sont plus naturelles, plus lisses, mais sans perdre leurs volumes, les effets de lumière moins exagérés, les détails des panneaux et textes plus… vrais.

Et pour cause : l’image calculée par le moteur original du jeu passe dans une moulinette qui va appliquer des algorithmes d’amélioration d’image. Des algos qui sortent de sessions d’entraînement intenses sur des bibliothèques d’images issues de vraies rues allemandes. Mais par rapport aux technologies concurrentes (le set Cityscapes Dataset est la référence du genre) le rendu d’Intel est dépourvu d’artéfacts ou aberrations graphiques, comme en témoignent les vidéos.

Des vidéos qui sortent d’un PC fonctionnant avec une Nvidia RTX3090, le plus puissant GPU « grand public » du monde – oui, ils ont eu de la chance d’en trouver une ! Et même avec ce monstre de puissance, le traitement retarde d’une demi-seconde le rendu de la trame. Mais tout pourrait rapidement fonctionner en temps réel.

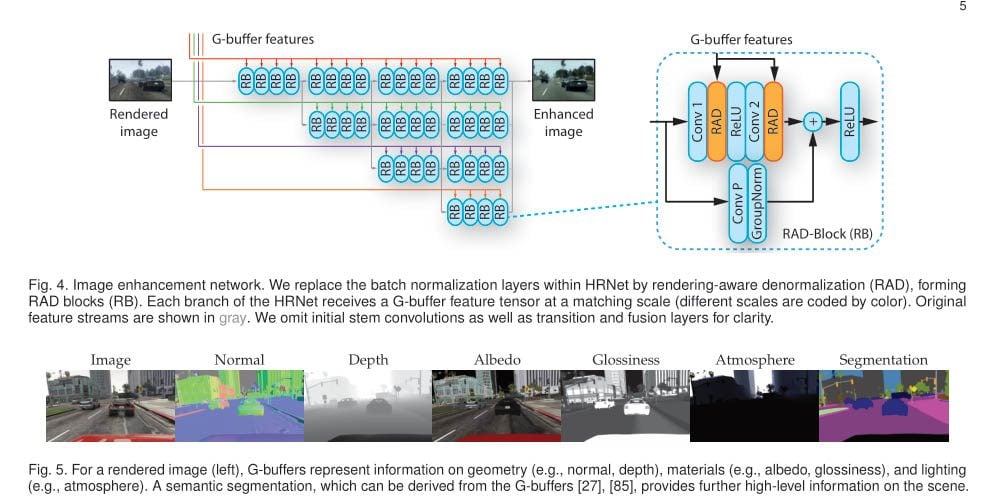

Cette technologie s’exécute côté GPU, plus précisément dans la mémoire tampon du processeur graphique, le G-Buffer. Une sorte de zone transitoire, de « cuisine » où toutes les trames intermédiaires de calcul des effets sont stockées et assemblées. Et les chercheurs d’expliquer que leurs méthodes d’amélioration de l’image pourraient être intégrées directement dans les moteurs de rendu des jeux.

Un contexte graphique d’importance pour Intel

Notre méthode pourrait être intégrée au cœur des moteur de jeux vidéo.

S. R. Richter, H. Abu AlHaija et V. Koltun (Intel)

Cette citation de la fin de l’article a son importance dans le contexte actuel d’Intel. Car le géant du CPU qui a affirmé ses ambitions graphiques il y a un peu plus de deux ans. De grosses ambitions, tant du point de vue des PC portables – Xe a déjà fait ses preuves en bousculant AMD dans les SoC – jusqu’au calcul intensif (Ponte Vecchio est en phase de finalisation) ainsi que de GPU… pour gamers.

Lors de sa présentation de son premier prototype de puce graphique « DG-1 » que nous avons découvert au CES 2020, Intel nous avait confié « travailler main dans la main avec les développeurs depuis un moment ». Logique, quand on sait que nombre de joueurs utilisent les puces graphiques – jadis infâme – intégrées aux vieux CPU mobiles d’Intel.

À découvrir aussi en vidéo :

Or, cette proximité avec les développeurs – qui ont tout intérêt à optimiser leurs jeux pour qu’ils tournent sur le plus de plates-formes possibles –, Intel va sans aucun doute la renforcer dans les années qui arrivent. Et avec l’adoption rapide des cœurs de ray-tracing dans les GPU, chez Nvidia d’abord, puis désormais par AMD, Intel va pouvoir pousser ses briques logicielles qui tirent parti de ce genre d’unité. La question étant de savoir dans combien de temps on verra arriver des effets aussi réalistes dans nos PC de tous les jours.

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.