Vous avez déjà pu vous faire une première idée des performances de la GTX 1080 et commencé à comprendre la constitution de la puce Pascal (GP104). Il est désormais temps d’aller un peu plus loin, car la puissance brute n’est pas le seul atout de cette nouvelle génération de carte NVIDIA.

N’ayez pas peur, il n’est pas question ici de rentrer dans des considérations trop techniques mais simplement de s’attarder – de manière compréhensible -sur l’ensemble des technologies que NVIDIA a placé dans la carte et que l’on retrouvera, aussi, dans la GTX 1070, qui devrait sortir le 10 juin prochain.

La compression des deltas de couleur améliorée

Pour que la mémoire GDDR5X embarquée sur la carte et que le processeur graphique puissent échanger des informations encore plus rapidement, NVIDIA a amélioré le processus de compression du delta des couleurs.

Une couleur est, au même titre qu’un triangle, une donnée informatique pour n’importe quel composant d’une image. Elle transite par différents canaux avant d’atterrir sur l’écran. Et pour éviter d’occuper trop de places dans les canaux, de la mémoire en l’occurrence, NVIDIA est parvenue à mettre au point des algorithmes capables d’analyser plus finement les informations et, en particulier, celles relatives aux différents blocs de couleur.

Ces « travailleurs » compressent les couleurs par teinte voire teinte voisine afin de, premièrement, les faire transiter plus rapidement et, deuxièmement, qu’ils ne prennent pas de place dans les tuyaux pour laisser passer les informations plus importantes ou urgentes.

Une fois arrivés dans les unités sachant les interpréter, les petits paquets sont aisément décompressés et traités plus rapidement. Dans la pratique, les captures ci-dessous (présentées par NVIDIA) montrent la puissance de compression de Pascal (à droite) par rapport à Maxwell (au gauche) qui, déjà, apportait non pas une pierre mais un rocher à l’édifice de la compression.

Dans chacune des deux images, on voit en violet toutes les couleurs compressées et dont le traitement est donc optimisé. Ce qui reste en noir, correspond à toutes les couleurs devant être calculées et gérées par la carte. A gauche, il s’agit du résultat obtenu avec la plate-forme Maxwell, une carte type GeForce GTX 980. A droite, la même image compressée par les algorithmes de Pascal, sur la GTX 1080. On voit que bien plus de couleurs ont pu être compressées pour être traitées plus rapidement.

Pascal GP104 : un petit coup de main, en mode agile

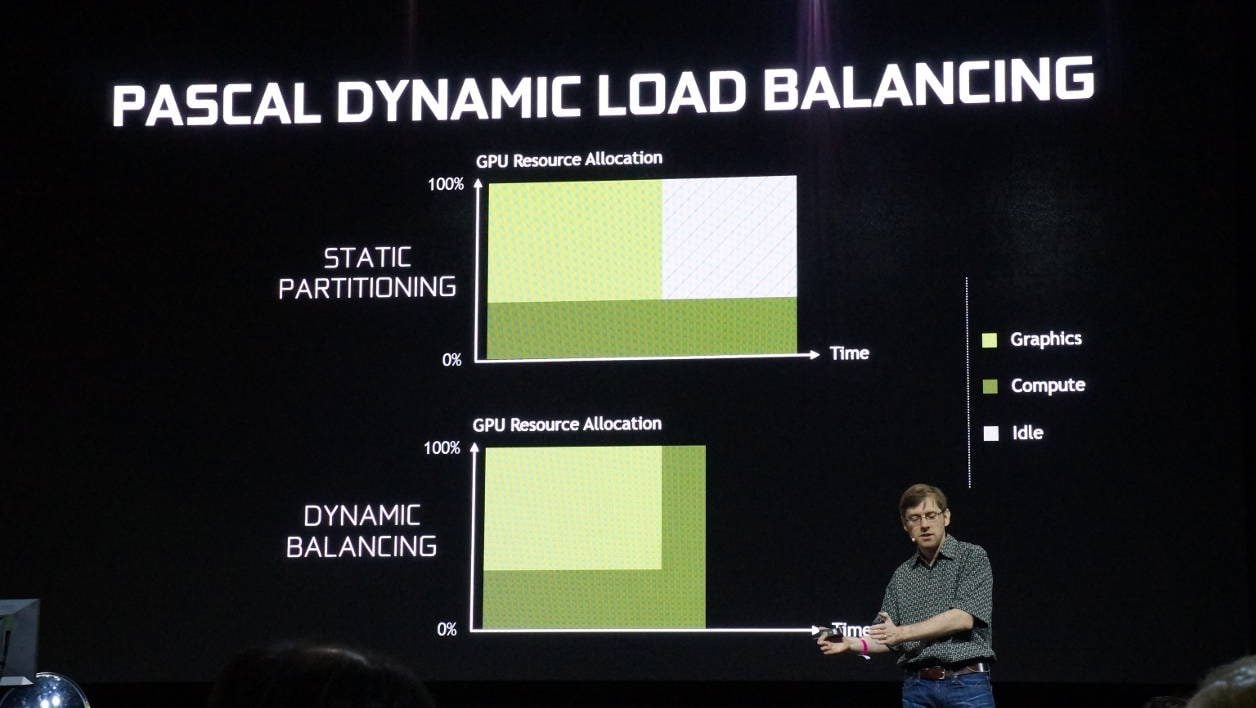

Les jeux vidéo PC actuels sont de plus en plus beaux… et gourmands en ressources. Et pour cause, le matériel PC fait sans cesse des bons en avant et, les développeurs en profitent. De fait, la carte graphique devient de plus en plus multitâche et il lui arrive bien souvent non seulement de calculer un rendu graphique mais aussi de faire d’autres calculs plus ou moins éloignés de ses attributions premières.

Il n’est pas rare que les unités en charge du graphisme aient effectué leur tâche plus rapidement que celles qui sont en charge des autres calculs. Ainsi, le temps que les secondes finissent… les premières se tournaient les pouces. Avec Pascal, l’oisiveté semble être mise au rencard. En effet, selon les ingénieurs NVIDIA, quand la partie graphique a fini son ouvrage, elle vient aider la partie calcul si cette dernière a encore beaucoup de travail devant elle.

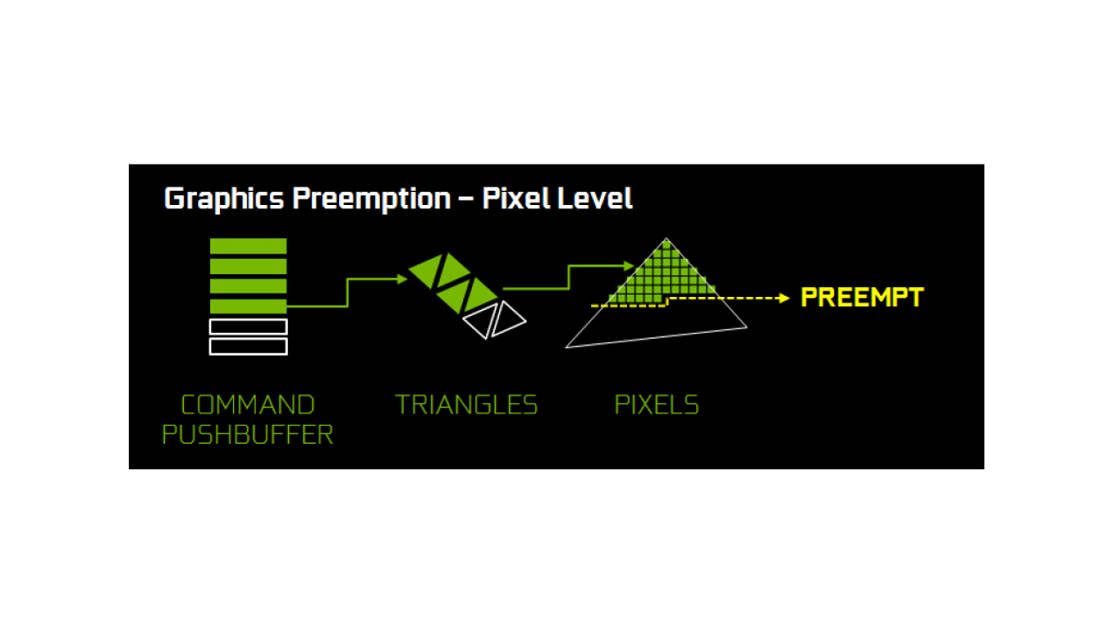

Autre nouvelle technologie permettant à la puce Pascal d’être plus efficace que ses grandes sœurs ou même que la concurrence, la Pixel Level Preemption (PLP).

Une expression bien technique présentée à grand renfort de termes savants pour, au final, quelque chose de facile à comprendre. En fait, la PLP permet aux unités besogneuses de la puce d’interrompre des tâches routinières ou sans priorité particulière aux bénéfices de plus urgentes.

La plupart des processeurs doivent finir de traiter tous les composants d’un même ensemble de données avant de pouvoir prendre l’urgence à bras le corps. Pascal arrive, lui, à dresser un portrait de ce qu’il est en train de faire, au pixel près. Puis il alloue tout ou parti de ses ressources à l’urgence, la traite puis reprend son labeur exactement là où il l’a laissé quelques microsecondes auparavant. Car oui, nous parlons ici en microsecondes et non en secondes ou minutes. La Pixel Level Preemption est complètement invisible pour l’utilisateur mais visible à l’échelle des performances globales de la carte.

Et ce que Pascal peut faire avec des pixels en PLP, il le fait aussi avec des données plus classiques comme les autres processeurs de calcul, graphiques ou non. Le principe de « préemption » a été encore amélioré mais est légèrement différent de celui expliqué ci-dessus.

Et bien entendu, ce qui marche pour les données de calcul s’applique à toutes les tâches compatibles CUDA (GPGPU : utilisation du GPU pour traiter des calculs d’ordinaire effectués par un processeur de type CPU) à un niveau encore plus profond, celle des instructions matérielles gravées en dur sur le processeur.

Toute cette gestion améliorée des tâches urgentes et non urgentes prend son sens non seulement en utilisation classique, mais aussi en configuration multi écrans voire dans le cadre de la réalité virtuelle, où les images sont plus grandes et doivent être générées à la volée, très rapidement.

Des pixels taillés sur mesure pour le multi écran et la VR

Et pour sublimer le rendu sur plusieurs écrans et, surtout, le rendre plus fluide et moins sujet à distorsion, NVIDIA parvient à insérer une nouvelle unité de génération d’image dans le moteur PolyMorph Engine 4.0 en charge de chaque grosse grappe des unités SM (celles qui renferment les unités de calcul). Son nom ? Simultaneous Multi Projection Unit (SMPU) ou unité de projections multiples simultanées. Elle a pour mission de générer jusqu’à 16 projections géométriques (ou 32 dans le cas de la VR) d’une seule et même scène avec un point de vue principal, et deux autres, légèrement décalés mais toujours présent sur l’axe horizontal.

Bien entendu, la puce aura besoin, dans la pratique, d’être épaulée par une application pour que cela fonctionne et il faut bien évidemment que les applis soient –elles aussi – optimisées mais, grossièrement, voici les deux scénarios d’applications possibles.

Écrans surrounds : les possesseurs de système d’affichage à plusieurs écrans ou d’écran incurvé peuvent se frotter les mains. Aujourd’hui, ces derniers ont une projection d’image plane, adaptée à la courbure de la dalle incurvée ou aux deux écrans positionnés de chaque côté du principal afin de donner une impression d’immersion. Mais les déformations d’images ou des réplications de certaines formes induisent, au final, un champ de vision net très restreint. Avec le SMPU, a priori, plus de déformations ! Le moteur est capable d’afficher des images avec un point de vue légèrement différent et, surtout d’éviter de répliquer certains composants de l’image.

Casque VR : Grâce au SMPU, la carte n’est pas obligée de calculer deux images, une par lentille, puis de les adapter (en les déformant selon la courbure).

Comme le point de vue de l’image est le même, le SMP réplique simplement la même image sur les deux lentilles. Et va plus loin encore puisqu’il est capable d’adapter grossièrement la génération de pixels à la taille effective des lentilles d’un casque VR.

Ainsi, au lieu de créer deux images de 2,1 Mpixels puis de les écraser en les déformant pour les afficher sur la lentille, la carte n’en crée qu’une de 2,1 Mpixels. Elle la duplique et la rogne intelligemment pour que l’image ainsi copiée s’affiche au plus proche du rendu original. Soit 1,4 Mpixels en tout, et 50% de pixels en moins à afficher. Ainsi, la GeForce GTX 1080 s’économiserait et se préparerait à traiter d’autres opérations tout en offrant un rendu visuel proche de l’original, sans distorsion ni saccade.

GPU Boost 3.0, Fast Sync et HDR

Trois technologies manquent à l’appel dans notre exposé. Nous avons décidé de leur donner une place à part, dans des articles à venir pour les deux premières et, pour la troisième, de la traiter rapidement ici.

Le GPU Boost 3.0 demande que nous nous penchions sérieusement sur les capacités en overclocking de la carte, chose que nous n’avons pas encore eu le temps de faire.

Le Fast Sync est un nouveau type de synchronisation verticale, différent du G-Sync de NVIDIA et qui, sur le papier, offre tous les avantages du procédé de synchronisation classique (pas de déformation d’images) sans les inconvénients (latence élevée due aux embouteillages d’images dans les buffers). Les résultats les plus probants s’obtiendraient avec des jeux de tir à la première personne comme Counter-Strike : GO. Une bonne séance de frag est donc prévue dans les semaines qui viennent pour apprécier cette fonctionnalité.

Reste la HDR (High Dynamic Range). Selon NVIDIA, Pascal reprend les même compatibilité que Maxwell sur ce domaine. Toutefois, il va plus loin en proposant le support du 4K/60 10/12b HEV Decode (pour la vidéo HDR) et l’Encode (10b HEVC). La compatibilité avec le DisplayPort 1.4 HDR (pour les écrans HDR avec DP) est également assurée. En outre, NVIDIA travaillerait d’arrache-pied avec certains développeurs pour que la HDR soit implantée dans les titres existants ou à venir. On parle notamment de Rise of the Tomb Raider, LawBreakers, Paragon ou encore Shadow Warrior 2.

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.