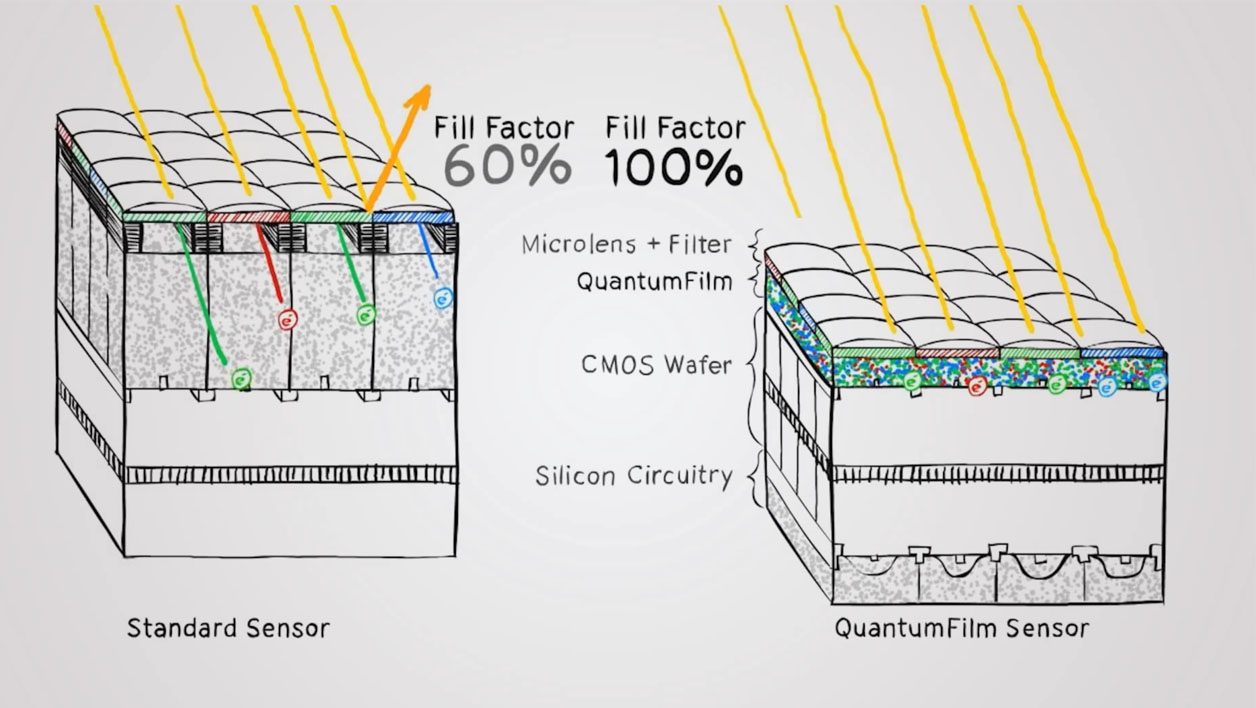

La société Apple prépare-t-elle quelque chose dans le domaine de l’image ? C’est ce qu’on se dit en découvrant, par le biais de TechCrunch, le rachat par Apple de la start-up InVisage, une entreprise américaine qui développe des capteurs d’un nouveau genre. Basés sur des nanoparticules appelées « quantum dots » (comme sur les téléviseurs) qui sont vaporisées en fine couche (appelée, elle, QuantumFilm) juste sous les microlentilles, les capteurs de InVisage seraient, selon les affirmations de la start-up, plus sensibles à la lumières, plus fins (plus besoin de matrice de Bayer), plus réactifs (pas de déformations en vidéo) et disposeraient d’une meilleure plage dynamique – la faculté de voir aussi bien dans les hausses que les basses lumières.

Depuis le rachat, les spéculations vont bon train puisque contrairement à certains géants de la Silicon Valley – n’est-ce pas Mr Microsoft ? – Apple n’achète pas n’importe quoi n’importe comment avec ses milliards. La preuve : la caméra TrueDepth intégrée à l’iPhone X qui permet la reconnaissance faciale est issue du rachat de la startup israélienne Primesense en 2013, laquelle était déjà en partie responsable du développement de Kinnect.

Pourquoi l’entreprise californienne a-t-elle racheté InVisage ? Parce que Apple n’aime pas avoir les mêmes composants que ses concurrents et que, face à la domination de Sony dans la production des capteurs, il lui est difficile de se démarquer de manière très significative. Disposer d’un capteur radicalement différent lui donnerait donc de sérieux avantages (s’il fonctionne bien), en premier lieu en termes de finesse puisque les modules caméras animés par la technologie QuantumFilm seraient plus fins que ceux de la concurrence – et la finesse, c’est le cheval de bataille d’Apple depuis un bon moment.

Apple aime avoir la maîtrise (et l’exclusivité) de ses briques, qu’elles soient logicielles comme Mac OS ou iOS, mais aussi matérielles comme le fameux processeur ARM Ax de ses iPhone (le A11 Bionic de l’iPhone X en est le dernier modèle), de vraies puces maison rendues possibles par le rachat, en 2008 de PA Semi, une entreprise spécialisée dans les puces à basse consommation.

Saut technologique ou amélioration de l’existant ?

https://www.youtube.com/watch?v=WpfIHdn1Df0

Apple a plutôt du succès dans l’intégration des entreprises rachetées. Mais en matière de capteur, des technologies concurrentes de la matrice de Bayer classique ont toujours eu du mal à décoller. On pense notamment au capteur Foveon à 3 couches (R,V,B) de Sigma, certes bon en plein jour, mais dont les performances en basses lumières comme en rapidité de lecture ou en vidéo ne sont pas à la hauteur de ce que peut produire un «bon vieux» capteur CMOS. Un appareil photo comme le Sony RX10 Mark IV en est la preuve.

Dans sa vidéo de présentation de la technologie QuantumFilm, InVisage a raison de préciser que la structure même du CMOS est globalement la même depuis ses débuts – même s’ils ont la mauvaise foi de prendre pour exemple un capteur « classique » et non pas un capteur empilé de Sony type Exmor RS – et qu’une évolution pourrait être intéressante. Notamment dans la faculté de capter la lumière ou la plage dynamique.

Il reste donc aux équipes de InVisage désormais intégrées à Apple de prouver que leur saut technologique vaut mieux que les améliorations continues de toute l’industrie – et de Sony – dans ce domaine.

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.