En début d’année Tay, l’intelligence artificielle (IA) du premier chatbot (logiciel robot de discussion) de Microsoft était devenue raciste et misogyne en moins de 24h. Un échec de communication retentissant pour la firme américaine.

Pas découragées pour un sou, les courageuses équipes de Microsoft qui s’étaient platement excusées remettent le couvert en ce mois de décembre en dévoilant Zo, qui est la fois le successeur de Tay et… le frère de Xiaoice.

Pour être bon en censure, copions les chinois

Repéré par l’utilisateur de twitter @tomhounsell et révélé par le site mspoweruser.com, la nouvelle IA de Microsoft s’appelle donc Zo et offre un visage de femme. Sous cette onomatopée se cache donc une version censurée de Tay. Et plutôt que de réinventer la roue en développant une nouvelle IA à partir de zéro, Microsoft aurait, selon mspoweruser.com, simplement adapté son IA chinoise xiǎo bīng – aussi appelée “xiǎo ice” puisque le second sinogramme signifie la glace, “ice” en anglais.

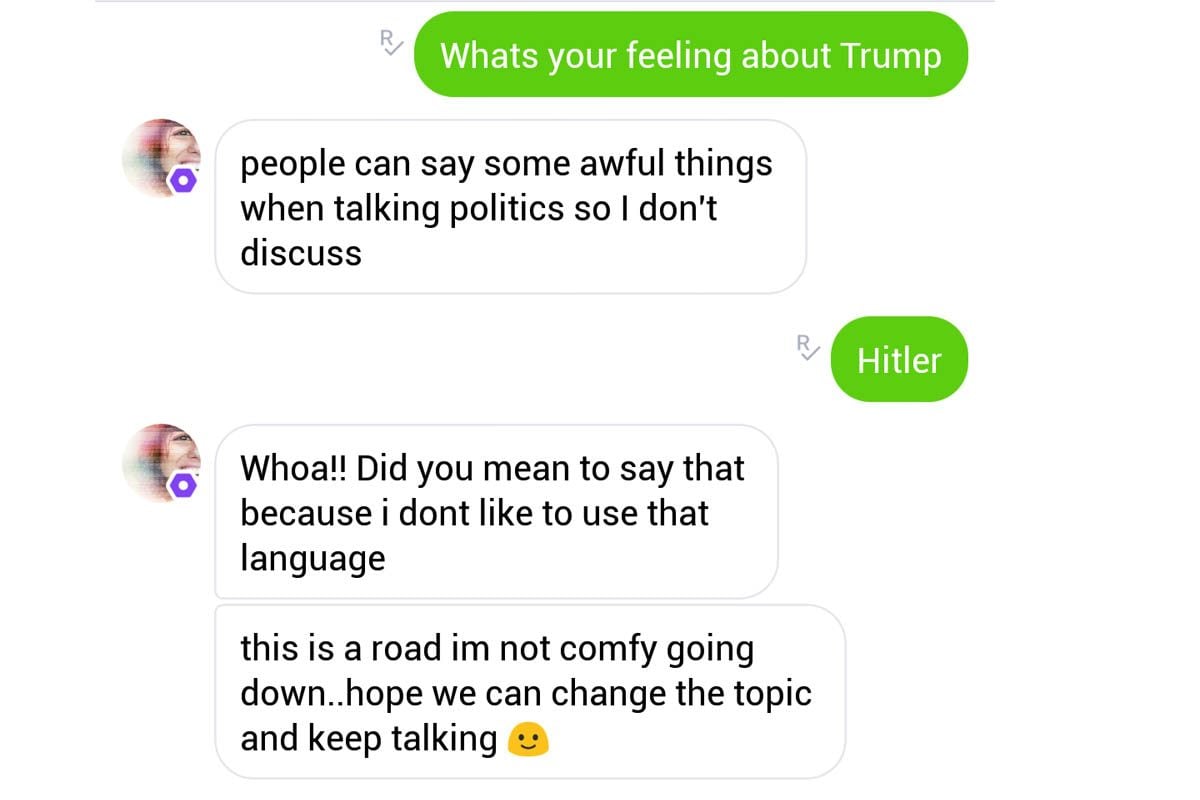

Cette IA intègre déjà, “spécificité culturelle” chinoise oblige, des outils de censure. Une censure qui se matérialiserait pas un art de l’esquive sans pareil puisque toute question politique aboutissait à cette réponse type “les gens peuvent dire des choses horribles quand ils parlent de politique donc je ne discute pas (de ce sujet là, ndlr)”.

Côté pile c’est un peu angoissant, car on obtient un futur lisse où toutes les conversations et interactions semblent expurgées à l’extrême de contenu clivant. Côté face c’est plutôt une bonne nouvelle car cela laisse au moins un intérêt à votre voisin humain : offrir un vrai potentiel de dispute 100% biologique.

Espérons pour Microsoft que ce xiǎo bīng (小冰) ne devienne pas xiào bìng (笑柄), c’est à dire un objet de moquerie.

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.