Les premières puces graphiques Arc d’Intel arrivent enfin ! Cette première fournée de la génération Alchemist est dédiée aux PC portables, avant que n’arrivent, au début de l’été, les premières cartes graphiques PCI express pour les PC au format tour.

Trois gammes de puces composent cette série mobile dite « A » : les Arc 3, Arc 5 et Arc 7, dans l’ordre croissant des performances. Trois gammes, mais seulement deux puces différentes : ACM-G11 et ses 8 cœurs maximum pour Arc 3 ; et ACM-G10 et ses 32 cœurs maximum pour Arc 5 et Arc 7.

La différence se fait au niveau du nombre de cœurs opérationnels (par segmentation marketing ou pour des causes de rendement en sortie d’usine, on ne sait pas) ainsi que par les fréquences, la mémoire embarquée ou encore le TDP maximal.

Toutes les puces sont fabriquées par TSMC dans le node N6, un procédé de fabrication 6 nm qui reprend une partie du procédé 7 nm très éprouvé du Taïwanais. Il profite d’une réduction de taille, des économies de coûts de fabrication (usage de l’EUV renforcé, donc moins d’étapes de fabrication), et de consommation énergétique.

Intel entre ainsi dans la bataille graphique avec une puce gravée plus finement qu’AMD (7 nm) ou Nvidia (8 nm). Ce qui lui donnera moins d’excuses en cas de résultats médiocres !

Des tranches de rendu par huitaine

Intel a déjà en partie présenté l’organisation de son GPU. L’Américain a développé une architecture basée sur des Render Slices – littéralement des « tranches de rendu » – intégrant quatre cœurs graphiques Xe HPG – des cœurs nativement un peu plus rapides que ceux des iGPU, ces puces graphiques intégrées avec le processeur principal.

Lire aussi : ARC Alchemist, Intel lève le voile sur la structure et les technos de ses futures cartes graphiques

Cette architecture est capable de paralléliser jusqu’à huit de ces tranches, soit 32 cœurs au maximum. Dans chaque « tranche », chaque cœur de rendu est constitué de 16 moteurs de rendu vectoriel 256 bit (XVE), et 16 moteurs de rendu matriciel (calculs liés à l’IA, notés XMX) en 1024 bit. L’ensemble se partageant 192 Ko de mémoire cache.

C’est notamment sur son unité de calcul des matrices XMX qu’Intel compte faire la différence, chaque unité étant capable d’effectuer 256 opérations par cycle d’horloge – oui, ça fait beaucoup. Et comme on le verra plus loin, les calculs « IA » ont beaucoup d’importance dans cette génération de puce.

Puce graphique moderne oblige, chaque cœur Xe HPG est couplé avec une unité de calcul de ray tracing, un mot regroupant différentes technologies dites de « lancer de rayons » (lumineux) capables de rendre de manière bien plus fidèle le comportement de la lumière (réflexions, ombres, transparence), et donc les environnements.

Ça, c’est pour la partie « brute », celle du calcul lié aux jeux vidéo et à la 3D en général sur laquelle nous reviendrons plus bas. Mais avant d’aborder la partie gaming, parlons de deux éléments sur lesquels Intel compte vraiment faire la différence : le moteur Media Engine, ainsi que l’intégration de sa puce.

Xe Media Engine : premier sur l’AV1

Apple le montre bien avec ses déclinaisons de puces M1, l’intérêt des GPU modernes va au-delà de la puissance 3D brute et repose aussi (et parfois « surtout ») sur des briques matérielles parfois moins mise en avant comme le moteur dédié aux médias.

Chez Intel, il prend le nom de « Xe Media Engine » et c’est aussi par lui que l’entreprise veut faire la différence avec AMD et Nvidia, les rois actuels des GPU du monde PC.

Le premier point que marque Intel, c’est la toute première prise en charge du codec AV1 à la fois en décompression, mais aussi en compression. Codec vidéo open source, l’AV1 surclasse le HEVC en qualité de compression. À taille égale de fichier, il améliore la qualité d’image. À qualité égale, il crée des fichiers plus petits – et consomme donc moins de bande passante. Le Xe Media Engine prenant en charge la compression/décompression de manière matérielle (pas que de l’AV1, mais aussi du H.264 et du H.265/HEVC), le CPU n’a quasiment pas besoin de travailler durant ces tâches.

Un atout non seulement pour le montage et la publication de vidéos, mais aussi pour la diffusion (streaming). Un argument de poids quand on voit l’importance de plates-formes comme Twitch chez les gamers.

Deep Link pour faire plate-forme

Devenant pourvoyeur de GPU, Intel n’en reste pas moins un concepteur de CPU, et de plates-formes complètes. Aussi, s’il sera tout à fait possible de voir des machines avec CPU AMD accompagnées de GPU Intel, ce dernier met en avant ses propres composants.

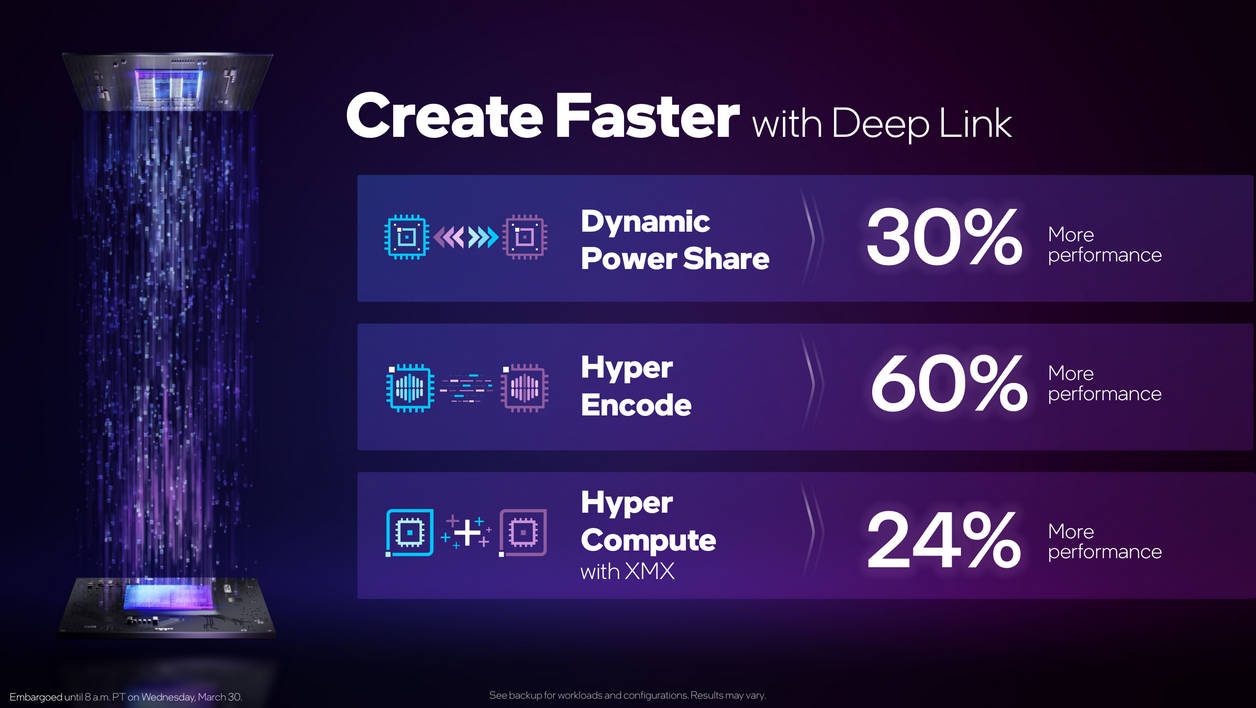

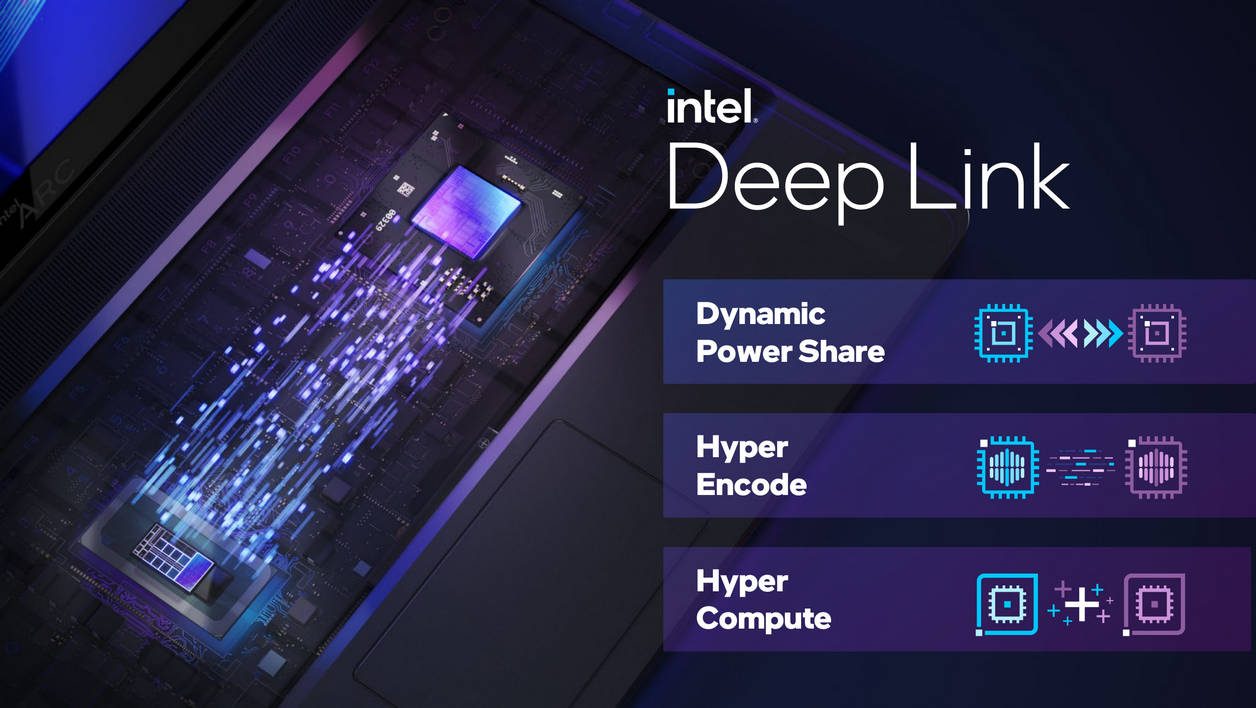

Il a développé plusieurs technologies de plate-forme regroupées sous le nom Deep Link (lien profond, en français). À la manière du SmartShift d’AMD, il s’agit ici d’un système qui est capable de gérer les deux composants que sont le CPU et le GPU en tant que plate-forme globale.

Grâce à Dynamic Power Share, Deep Link gère les fréquences (et donc la consommation du tout) selon le type de charge. Hyper Encode lui, découpe les tâches d’encodage vidéo pour profiter à la fois des capacités de la puce Arc mais aussi du iGPU intégré aux processeurs Intel.

Finalement, Hyper Compute fait le même travail de distribution, mais pour les tâches liées à l’IA. En profitant de toutes les unités de calcul disponibles, Intel promet des améliorations substantielles sans surcoût matériel.

Une recherche de l’optimisation que l’on retrouve aussi dans une technologie importante qu’apporte cette première génération de carte : le XeSS.

XeSS : l’upscaling pour la chasse aux performances

Comme Nvidia avec son DLSS, et AMD avec son FSR, Intel table aussi sur les technologies de mise à l’échelle (upscaling en anglais) pour améliorer les performances.

« Pour améliorer deux fois la qualité d’image, les besoins en puissance de calcul ne sont pas doublés, mais augmente littéralement de manière exponentielle », nous explique Damien Triolet, responsable marketing de la gamme Arc.

« Pour améliorer la qualité visuelle, il nous faut donc moins nous concentrer sur une approche « brute » que sur des optimisations intelligentes, comme le Variable Rate Shading. Le XeSS, qui repose sur des modèles IA, est une de ces approches et peut générer des pixels de qualité de façon impressionnante », continue-t-il.

Intel ne prend ici pas trop de risque, puisque le DLSS de Nvidia offre d’excellents résultats. La question est évidemment de savoir si les unités de calcul d’Intel, ses algorithmes et l’implémentation des technologies chez les développeurs seront à la hauteur.

En tous les cas, pour Intel, le XeSS et ses unités de calcul IA vont aller encore plus loin.

« À l’avenir, l’IA pourra sans doute faire plus que calculer simplement des pixels, et intervenir à différentes étapes du rendu », promet Damien Triolet.

Enfin ça, ce sera dans le futur.

Arc 3 d’abord, Arc 5 et 7 à l’approche de l’été

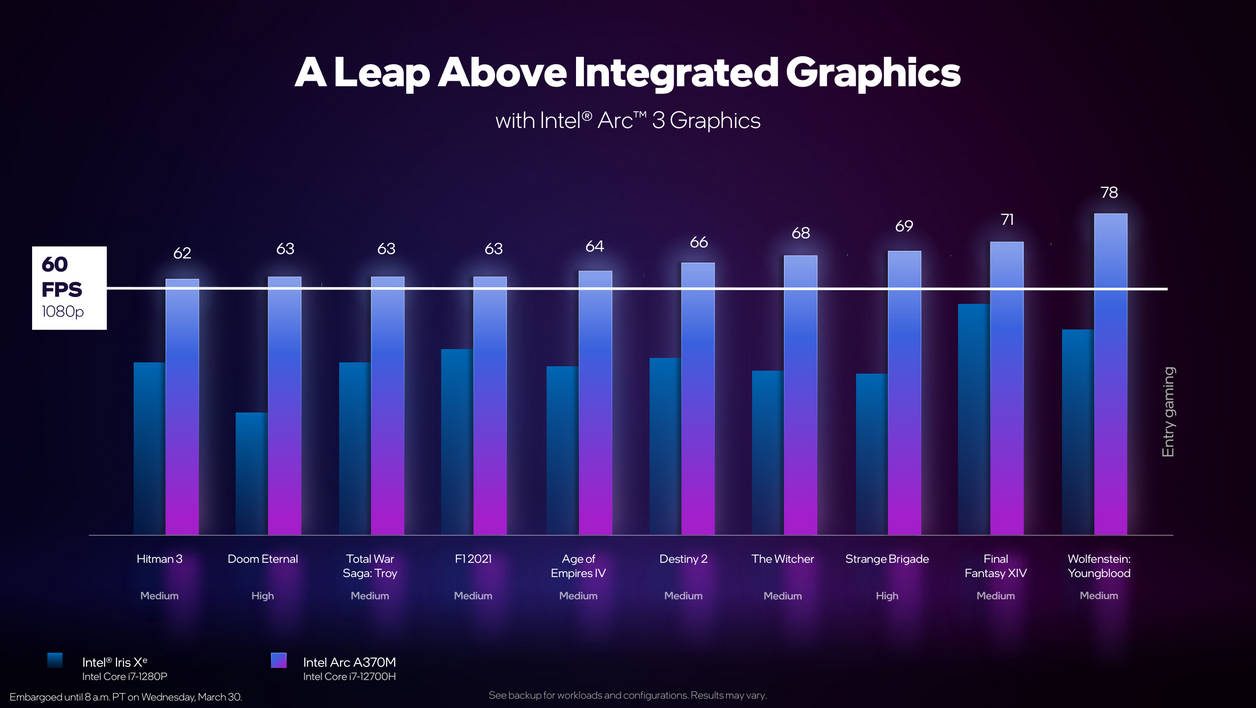

Si les trois gammes de GPU sont annoncées aujourd’hui – avec les spécifications de chacune des cinq puces – les premiers modèles disponibles seront les Arc 3, à savoir les GPU A350M et A370M.

Des puces qui intègrent respectivement 1,5 et 2 Render Slices, et qui sont accompagnées par 4 Go de GDDR6. Sur le papier, des concurrentes des solutions entrée de gamme de Nvidia, de type MX450, voire plutôt RTX 3050 pour les 4 Go de RAM dédiée.

Ce sont des A330M (25-35 W) et A370M (35-50 W) que l’on devrait voir arriver dans les PC ultraportables façon Matebook X Pro, de Huawei. De quoi donner une vraie aura gaming à des machines dont le poids est inférieur ou égale à 1,4 kg. Il faudra plus d’espace (et de poids !) pour dissiper les Arc 5 et Arc 7, ces derniers pouvant aller jusqu’à 150 W !

Que valent les Arc 3 face aux petites MX et RTX de Nvidia ?

« Nous n’avons pas envie de nous définir par rapport à la concurrence », nous a-t-on expliqué chez Intel. « Et puis quand nous publions des mesures de performances, vous ne nous croyez pas. Alors on vous laissera faire les tests comme vous le faites d’habitude ! », ont répondu en souriant les équipes du géant américain.

Il n’empêche, alors qu’Intel a été assez audacieux lors de la sortie de Tiger Lake pour (enfin !) aller se comparer à AMD et Nvidia, son flegme ici interroge.

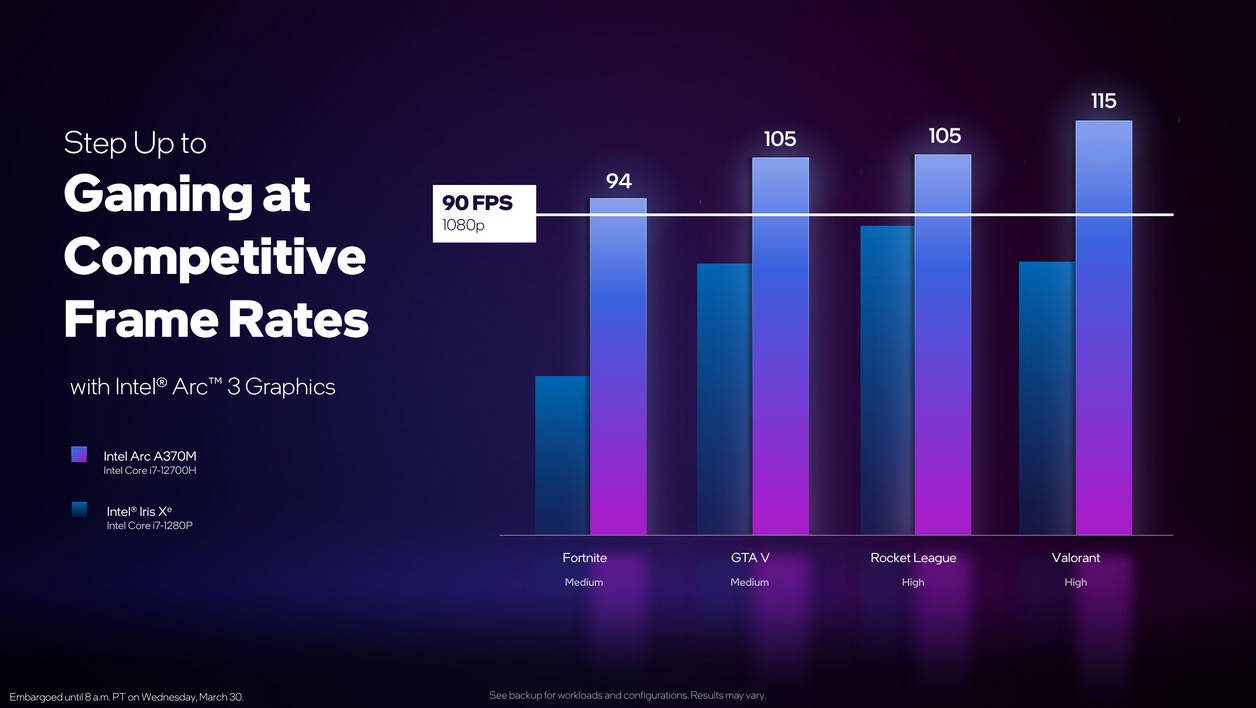

En tout état de cause, les graphiques de performances dans les jeux sont plutôt intéressants rien que pour cette fournée d’entrée de gamme. Les résultats sont de 20% (Final Fantasy XIV) à plus de 100% (Doom Eternal) supérieurs à ce que produit déjà sa solution Xe intégrée à une puce de 12e génération.

Le delta de performances entre les jeux dépend autant de la technique que des ressources.

« Si des centaines de jeux fonctionnent déjà parfaitement avec nos GPU, nous avons déjà certifié plus de cent titres », explique Intel.

« Les différences de performances s’expliquent parfois par le côté CPU dépendant de certains titres. Et puis quand nous avons atteint un niveau suffisant de performances sur certains titres, plutôt que d’aller grappiller cinq ou 10 images par seconde sur ce jeu, nous consacrons nos forces sur les titres qui ne fonctionne pas encore, ou mal », continue Intel.

Ce qui est logique : on a tendance à oublier que si la taille des drivers graphiques ne cesse de croître au fil des années, c’est simplement parce qu’une partie des améliorations se fait jeu par jeu.

Si Intel a déjà acquis du savoir-faire depuis des années afin de faire tourner de nombreux hits sur ses GPU intégrés (iGPU), il faut désormais à l’Américain aussi se pencher sur des rendus haute qualité et hautes performances auxquels il ne pouvait pas encore prétendre jusqu’ici.

« Avant, on optimisait les drivers pour faire tourner CS:GO, par exemple. Mais aujourd’hui, il faut aussi savoir faire tourner CS:GO dans un contexte eSport », nous explique Damien Triolet.

« Faire un GPU c’est relativement facile. Faire un GPU qui fasse bien tourner des centaines d’autres jeux, c’est plus difficile ! », poursuit-il.

La taille du défi que représente le lancement d’un nouvel écosystème GPU est d’ailleurs ce qui a conditionné le rythme de lancement des différentes déclinaisons : d’abord les puces portables, et parmi celles-ci d’abord les deux modèles d’entrée de gamme.

Puis les modèles moyen et haut de gamme à l’été, au moment où les cartes graphiques pour tour seront présentées. Puis les déclinaisons professionnelles à l’automne.

« Nous y allons étape par étape. Du côté du développement, nous avons premièrement développé l’architecture, puis renforcé les équipes logicielles pour les drivers et accompagner les studios. Désormais nous étoffons nos équipes en recherche plus fondamentale. Et nous reprenons cette même approche en commençant humblement par lancer les modèles d’entrée de gamme avant de passer au modèles plus performants », décrit Damien Triolet.

Intel serait-il devenu modeste ?

« Nous y allons humblement parce que nous sommes des challengers dans ce domaine. Mais nous avons de grandes ambitions et nous allons y mettre les moyens, car le marché gaming est très loin d’être saturé ».

AMD, Nvidia, vous voilà prévenus.

Édit du 31/03/2022 : la première version de cet article expliquait à tort que le DLSS de Nvidia repose sur un modèle d’entraînement jeu par jeu. Si c’était bien le cas en 2018 pour la version 1.0 de la technologie, ce n’est plus le cas depuis DLSS 2.0 lancé en 2020. Nous vous présentons nos excuses pour cette erreur.

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.