Dans les prochaines semaines, les principaux fabricants de processeurs vont officiellement abandonner un principe qui les lie depuis plus de cinquante ans, la loi de Moore.

En 1965, Gordon Moore, futur cofondateur d’Intel, publie un bref article dans la revue Electronics magazine. Selon ses observations, la puissance des microprocesseurs double alors tous les ans, et le mouvement est bien parti pour se poursuivre. Une tendance, réajustée pour un renouvellement tous les 24 mois, que l’industrie des semi-conducteurs a respecté durant un demi-siècle. Selon la revue Nature, ce sera bientôt du passé.

Des limites physiques

Malgré la légende, la loi de Moore n’a rien de prophétique, ou alors est-ce une prophétie autoréalisée. Les industriels se sont rapidement donné comme objectif de doubler la puissance des processeurs tous les deux ans.

Au début des années 90, les géants du secteur se sont regroupés en publiant tous les deux ans une feuille de route, la International Technology Roadmap for Semiconductors (ITRS). Et déjà à cette époque, les premières voix se faisaient entendre pour indiquer que suivre ce chemin aboutirait à une voie sans issue. Quoi qu’il en soit, depuis 25 ans, le document se base sur la volonté de maintenir le rythme observé par Gordon Moore.

Véritable révolution, pour la première fois, l’ITRS quittera officiellement des yeux la loi de Moore. L’édition publiée le mois prochain abandonnera cet objectif bientôt inaccessible.

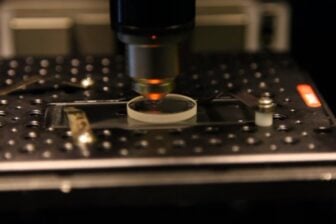

Les différents fabricants admettent que poursuivre dans cette voie deviendra bientôt physiquement impossible. Avec le temps, la puissance des processeurs s’est accrue grâce à une taille de gravure de plus en plus réduite. Actuellement, les meilleures puces commercialisées sont produites à 14 nm – contre 10 000 nm en 1971 et 180 nm en 2000. En 2020, on pourrait passer à 2 nm. Soit tout juste dix atomes de large…

Si la gravure devient techniquement possible, et cela demandera des efforts et investissements considérables, les pièces produites pourraient ne pas être suffisamment stables pour être utilisées. Sans compter que ces puces dégageraient une chaleur bien trop importante. Bref, dans l’état actuel du silicium, la fin de la route est proche.

La puissance n’est plus tout

Mais cela ne veut pas dire que le progrès va s’arrêter. C’est même peut-être tout le contraire. Après des décennies passées dans une sorte de course en avant à la puissance, les industriels ont décidé de se fixer de nouveaux objectifs. Une nouvelle orientation, qui commence par un changement de nom. Il ne faudra plus parler de International Technology Roadmap for Semiconductors, mais d’International Roadmap for Devices and Systems. Adieu le semi-conducteur, bonjour l’appareil et le système embarqué… Vous l’avez compris, le semi-conducteur n’est plus une fin en soi.

Car, face à de nouveaux marchés, avec des objets connectés de plus en plus diversifiés, à des utilisations de plus en plus hétérogènes, le défi est pour les concepteurs de puces de savoir offrir la bonne puce pour le bon usage.

Si on veut schématiser, il fallait auparavant produire des machines toujours plus rapides, il faut désormais concevoir des objets qui doivent répondre à des besoins de légèreté, d’autonomie ou de connectivité pérenne. Ce sont donc ces points qui dessineront les prochains défis et la future roadmap des géants du secteur.

Un nouvel horizon

Evidemment, ce changement de paradigme va bouleverser bien des habitudes. A commencer par l’oeil fasciné qu’on conservait sur la progression linéaire des performances de nos puces.

Mais la loi de Moore est aussi jusqu’à présent une sorte de garantie économique pour le monde de l’innovation et de la high tech. Les entreprises et les développeurs pouvaient se reposer sur des certitudes et se projeter dans le futur avec confiance. Leurs logiciels gourmands pourraient tourner sur la prochaine génération sans trop de mal. Les coûts des puces de leur prochaine machine allaient baisser en suivant l’application de la loi de Moore. Bref, les industries des semi-conducteurs et de la high tech en général vont devoir trouver de nouveaux repères.

Ils pourraient passer par une “nouvelle” loi de Moore… Mais pour cela, il faudra remplacer les évolutions par une révolution technologique. Les pistes dans les laboratoires sont nombreuses. Certaines sont tangibles et presque à portée (graphène, borophène, nanotubes de carbone, etc.), d’autres paraissent plus lointaines et insaisissables comme l’informatique quantique.

Mais dans les tous les cas, une question se pose : faut-il établir une nouvelle loi ou profiter de ce renouveau forcé pour innover pour les utilisateurs ?

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.