Les assistants intelligents sont en train de se généraliser dans notre quotidien. 20% des recherches mobiles auraient même été faites par commande vocale en 2016 aux Etats-Unis, selon le dernier rapport sur les tendances internet de Mary Meeker. Le problème, c’est qu’il semble facile de détourner ces systèmes. Des chercheurs chinois de l’Université de Zhejiang viennent de publier un article prouvant que l’on peut diffuser des ultrasons pour les leurrer.

Au-delà de 20 kHz, les fréquences sont trop hautes pour être entendues par les humains mais elles restent tout à fait perceptibles par des micros et des logiciels d’intelligence artificielle qui ne font pas la distinction avec une voix. On peut donc imaginer une attaque totalement dissimulée aux yeux de l’utilisateur légitime.

L’attaque du dauphin

Nos chercheurs ont baptisé cette technique « l’attaque du dauphin » parce que cet animal a la capacité d’attaquer ses proies en générant une forte impulsion acoustique qui les désoriente.

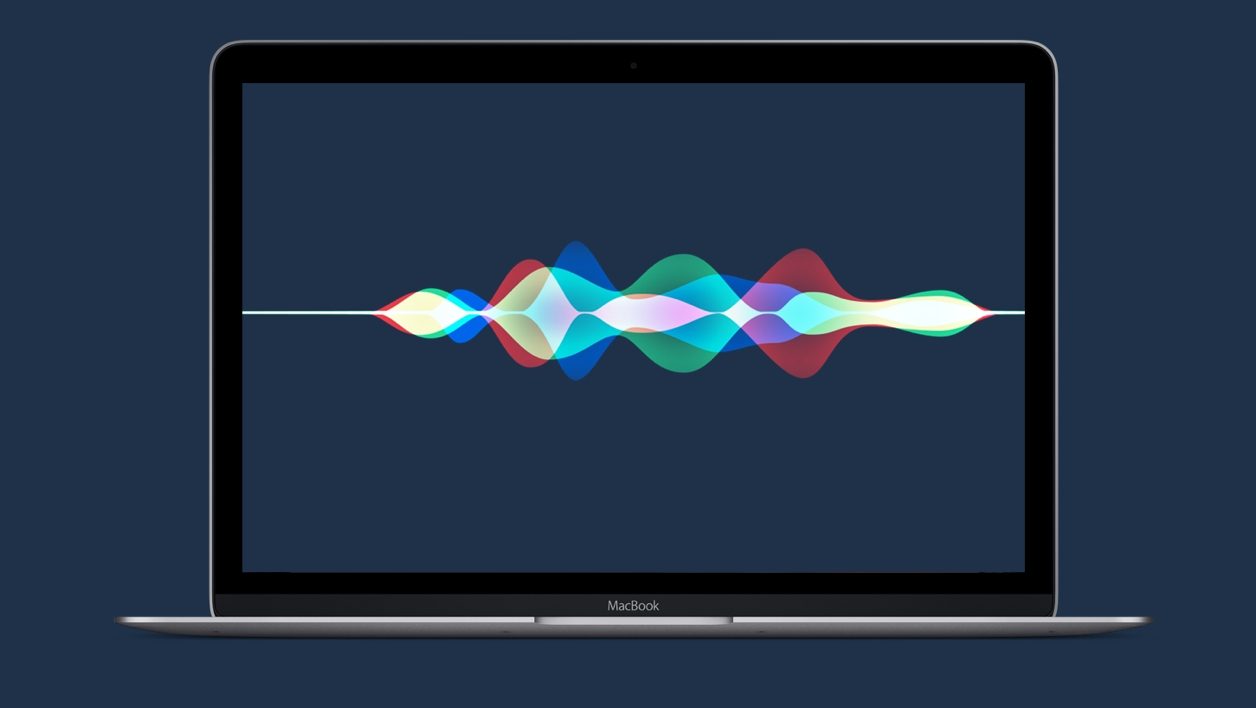

Voir la démonstration en vidéo d’un détournement de Siri :

L’équipe ne s’est pas contentée d’activer des commandes basiques comme « Dis Siri » ou « Ok Google ». Elle a demandé à un iPhone d’appeler des numéros de téléphone ou un à un iPad de lancer un Facetime avec un autre interlocuteur. Elle a aussi forcé un Macbook et une Nexus 7 à ouvrir un site malveillant, ordonné à un Amazon Echo d’ouvrir une porte dérobée. Et même changé la navigation d’une Audi Q3. Plutôt effrayant.

A cette liste, on peut encore ajouter toutes sortes de détournements possibles, comme la diffusion de fausses informations dans les périphériques d’une victime, lui ajoutant, par exemple, des rendez-vous qui n’existent pas dans son calendrier. Ou même la possibilité de se servir de ses terminaux pour envoyer des messages textes, des mails et publier des posts à son insu et en son nom.

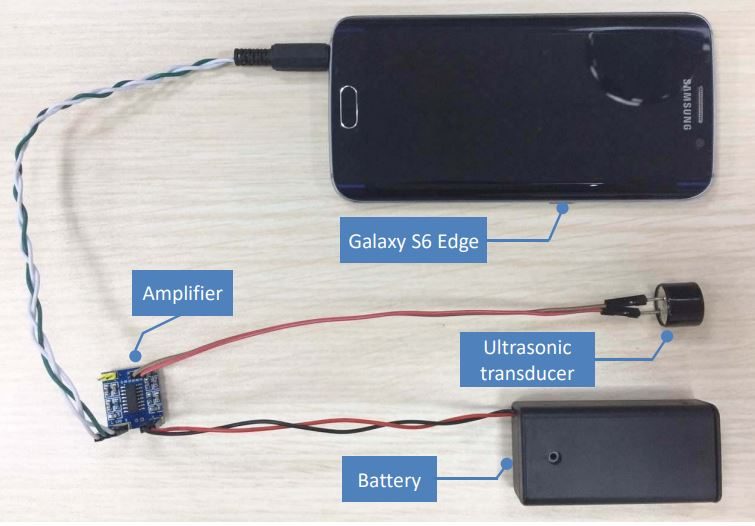

Le tout a été réalisé avec du matériel standard et bon marché, comme on peut le voir ci-dessus. L’achat d’un amplificateur, d’une sonde à ultrason et d’une batterie ayant coûté moins de 3 dollars. A la portée de toutes les bourses, donc.

Heureusement, les chercheurs chinois affirment qu’il est possible de détecter des attaques de ce type. Et qu’une simple mise à jour logicielle et matérielle pourrait rendre les assistants vocaux insensibles aux commandes vocales inaudibles de plus de 20 kHz. Ajoutons aussi que les manipulations ont été réalisées chaque fois à seulement quelques dizaines de centimètres des appareils visés. Ce qui restreint fortement les possibilités d’attaque à distance.

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.