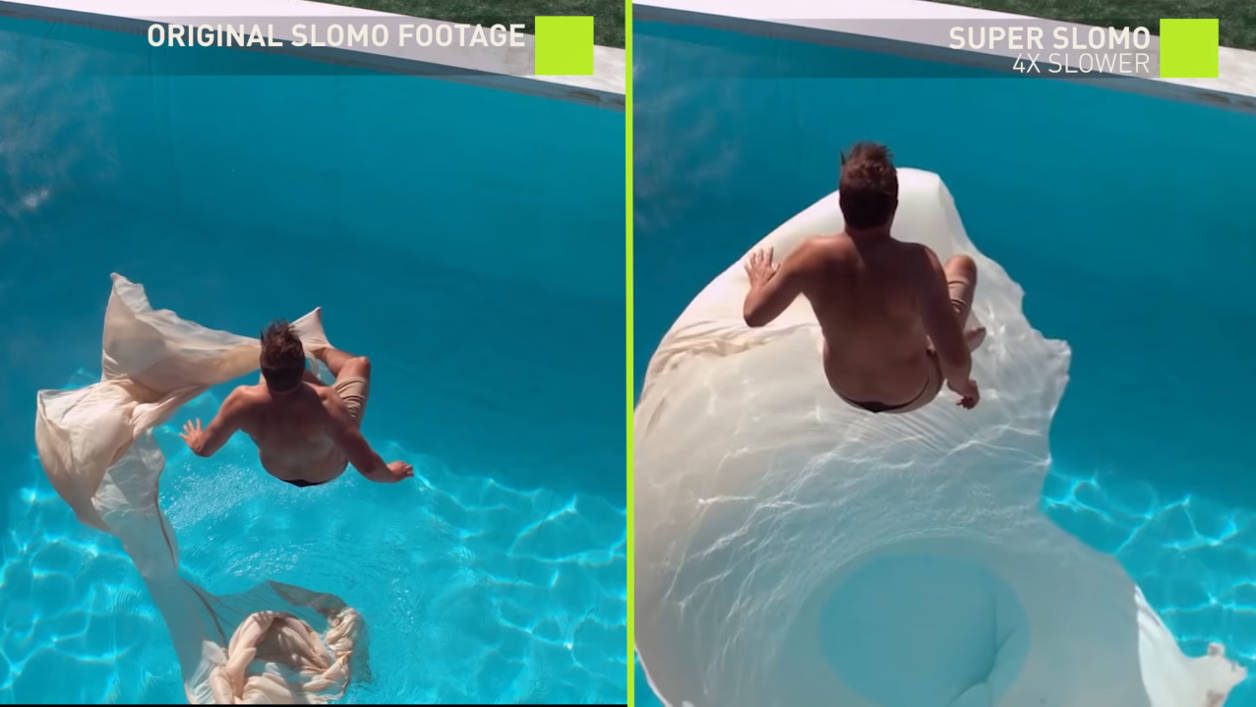

Après l’intelligence artificielle au service de la photo, Nvidia a fait plancher une IA sur la vidéo et, plus particulièrement, sur le Slow Motion ou le ralenti, en bon français.

Le concepteur de processeur graphique vient en effet de dévoiler une vidéo montrant les prouesses de l’une des ses dernières technologies, Super SloMo, boostée à l’intelligence artificielle et qui risque bien de faire son petit effet aux amateurs du genre.

S’il vous plaît, fabrique-moi une vidéo en slow motion

Plusieurs smartphones, appareils photo et caméras grand public proposent des modes de captures au ralenti mais leur qualité et leur prouesse varient énormément en fonction de la puissance des composants électroniques, notamment du processeur. Il faut aussi beaucoup d’espace de stockage pour héberger tous les rushs ainsi filmés.

En définitive, il n’y a qu’avec du matériel professionnel que l’on arrive à obtenir des ralentis de qualité et encore, bien souvent, ils sont retouchés pendant des heures en post-production.

Mais, le plus dur, c’est de créer une vidéo ralentie à partir d’une séquence classique, tournée à 30 ou 60 images par seconde. Généralement, le logiciel utilisé – aussi puissant et professionnel soit-il – va essayer de compenser les images manquantes sans y parvenir proprement. Les mouvements seront alors un peu saccadés et donc pas tout à fait naturels.

Nvidia s’est penché sur la question et, avec plusieurs chercheurs américains, beaucoup de Tesla V100 et un système de deep learning PyTorch (un réseau basé sur CUDA), le concepteur de GPU a entraîné une intelligence artificielle capable de fabriquer du slow motion de qualité.

Un entraînement qui reposait essentiellement sur la visualisation de 11000 vidéos filmées à 240 images par seconde. C’est grâce à elle que l’IA assimile la façon dont les mouvements se succèdent au sein des vidéos pour, ensuite, mieux les décomposer et les anticiper.

Deux réseaux à la manoeuvre

Sur le plan technique, nos confrères du site VentureBeat expliquent que deux réseaux neuronaux convolutifs distincts travaillent de concert. Ils déterminent où sont les objets en mouvement, leur nature, leur position dans la trame vidéo et peuvent ensuite imaginer toutes les trames intermédiaires entre un point A et un point B. Cela leur permet, aussi, de pouvoir anticiper la place des pixels constituant l’image factice à insérer entre deux images réelles.

Les réseaux se chargent ensuite de nettoyer l’image de tout artefact et distorsion et appliquent quelques effets. De la sorte, le mouvement ralenti artificiellement paraît fluide, presque aussi naturel que s’il avait été filmé avec une coûteuse caméra capable de filmer avec brio et qualité plusieurs centaines d’images par seconde.

A l’heure actuelle, Nvidia reste toutefois persuadé que cette technologie n’est pas encore prête pour le marché grand public. Beaucoup d’optimisations restent nécessaires, notamment pour un traitement des vidéos à la volée ou en temps réel. En effet, pour l’instant, tous les calculs s’effectuent dans le Cloud et demandent plusieurs heures…

Sources :

Nvidia

Cornell University Library

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.