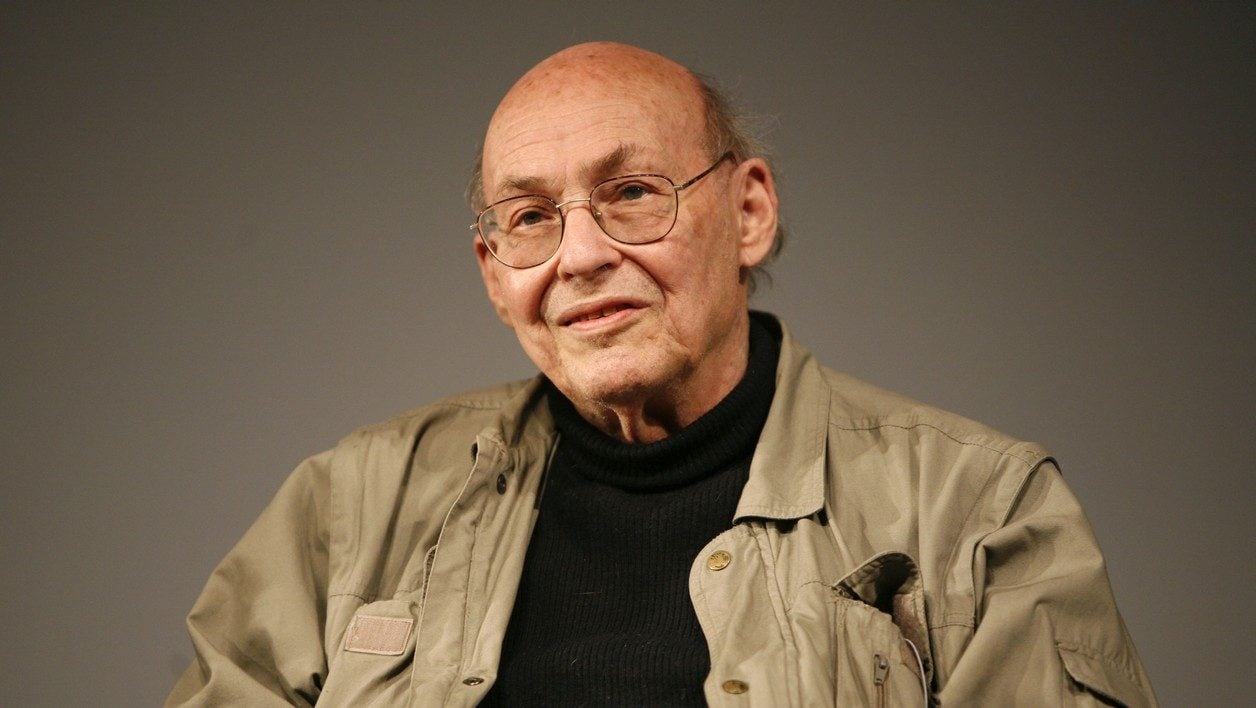

Il est l’homme qui a libéré les ordinateurs de leur condition de machine. C’est en tous cas l’image que l’on gardera de Marvin Minski, ce chercheur qui eut très tôt l’intuition géniale d’une intelligence artificielle douée de capacités de raisonnement analogues à celles de l’homme. Il a succombé à une hémorragie cérébrale ce dimanche 24 janvier au soir, à Boston, à l’âge de 88 ans.

Né le 9 août 1927 à New-York, il grandit dans le Bronx et sert dans l’US Navy à la fin de la seconde guerre mondiale. De retour à la vie civile, il suit un brillant cursus universitaire, passant par Harvard, Princeton où il obtient un doctorat de mathématiques et, enfin, le MIT. C’est là qu’il fonde avec son collègue John McCarthy ce qui est devenu le prestigieux laboratoire d’intelligence artificielle.

Un chercheur éclectique

En 1985, il sort le livre La société de l’esprit, co-écrit avec Seymour Papert. Ils y développent la théorie qu’il n’y aurait pas de différence fondamentale entre le fonctionnement de l’intelligence humaine et celle d’un ordinateur : toutes deux peuvent apprendre de façon autonome à partir d’observations et d’expériences accumulées en lien avec leur environnement. Il va aussi développer plusieurs modèles d’intelligence artificielle avec des réseaux neuronaux, ouvrant la voie à l’apprentissage automatique, puis au deep learning. Les disciplines reines de l’intelligence artificielle d’aujourd’hui sur lesquelles se focalisent des géants comme Facebook ou Google.

Sa pensée va influencer les informaticiens de l’époque et peser sur le développement de l’ordinateur personnel, tout comme le mouvement de logiciel open-source.

Eclectique et pianiste averti, Marvin Minsky s’est aussi illustré en développant du hardware : les premiers scanners, le premier microscope confocal encore utilisé aujourd’hui, ou encore des mains mécaniques avec des capteurs tactiles qui eurent leur incidence sur la robotique.

Il a reçu de nombreuses récompenses dont le célèbre prix Turing en 1970. On sait moins qu’il a été conseiller sur le film de Stanley Kubrick 2001 l’Odyssée de l’espace.

Sources :

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.