- Comparatif : les antivirus 2010 face aux menaces inconnues

- Méthodologie de tests

- Les détections heuristiques en action

- Tentative d’exécution de codes malveillants

- La défense des zones sensibles du système

- Conclusion

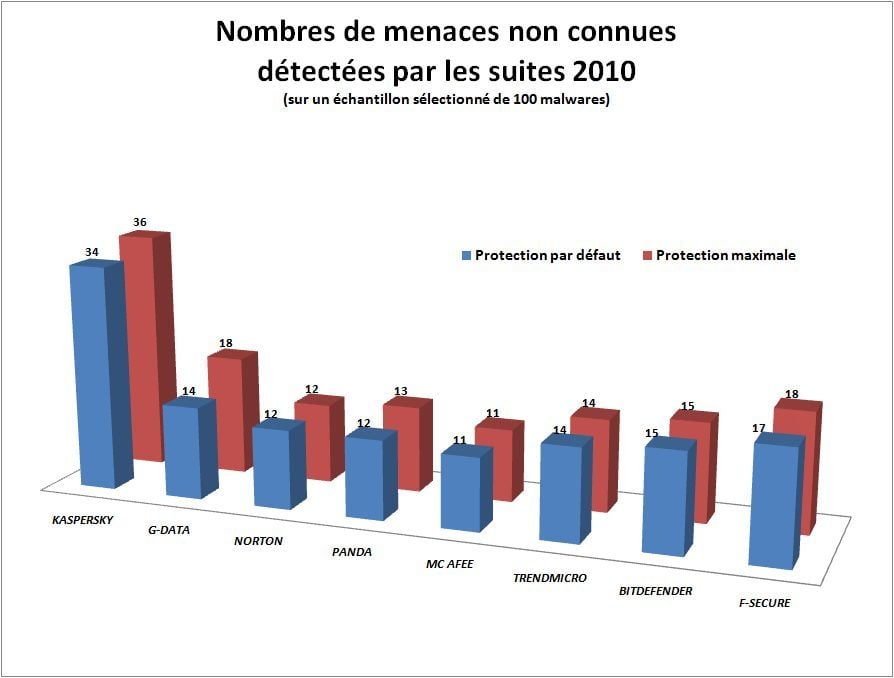

Ce que nous voulions avant tout déterminer avec ce test, c’est si les détections heuristiques avaient une utilité et si les réglages qui les accompagnent avaient une réelle importance. Côté efficacité, comme nous le pressentions, les méthodes heuristiques ne sont pas inutiles. Mais elles sont totalement insuffisantes. Avec des mises à jour vieilles de 15 jours, les taux de détection des suites sur des menaces très récentes (moins de 24 heures) sont faibles, voire trop faibles.

Les scores réalisés sont dans la fourchette attendue (moins de 20 %). Les détections heuristiques (on parle bien de détection, pas de protection) ne se sont jamais montrées efficaces à travers les années. Il n’y avait donc aucune raison pour que les versions 2010 fassent radicalement mieux.

L’heuristique révèle des surprises…

A ce petit jeu, c’est Kaspersky qui s’en tire le mieux, avec un score très étonnant… peut-être trop étonnant pour être significatif. Le résultat de ce test est nécessairement lié aux échantillons retenus. Le test ne reflète une vérité que sur cet échantillon réalisé un jour J. La suite a bénéficié d’une circonstance favorable en reconnaissant une même menace déclinée en 10 binaires très différents que les autres suites n’ont pas attrapés.

L’échantillonnage semble avoir donc porté chance à Kaspersky mais ne retire en rien ses qualités puisque toutes les suites étaient à égalité face à ce jeu de fichiers. Il faudra confirmer ce résultat surprenant par d’autres tests, pour déterminer si cette sensibilité est vraiment exceptionnelle ou si elle se révèle vraie tout au long de l’année. F-Secure surprend également, avec une deuxième place qui positionne la suite à égalité avec la G-Data et ses deux moteurs ! Tous les autres concurrents sont dans une même fourchette, allant de 11 à 15 % des échantillons détectés.

… quand les réglages n’en révèlent pas

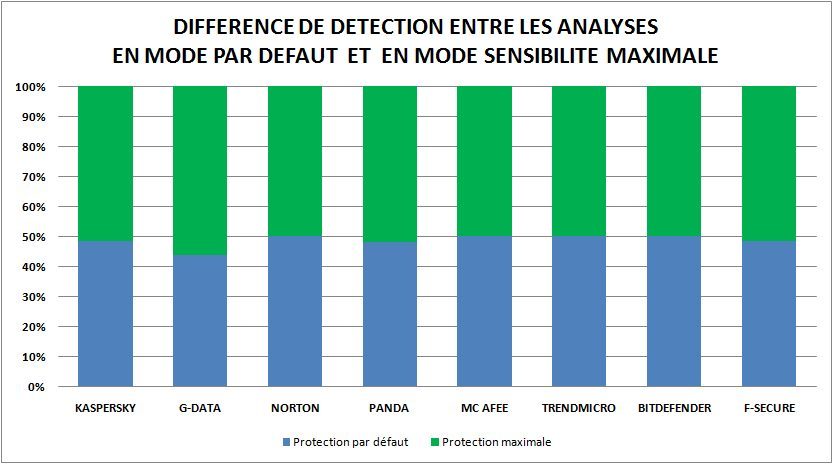

Le deuxième met en évidence la différence de détection entre le mode normal et le mode sensibilité maximale des détections heuristiques. Force est de constater que ce changement de réglage n’engendre généralement pas de grandes différences (pour un temps de scan qui, lui, est parfois doublé).

G-Data ne disposant pas de réglages précis de l’heuristique, nous avons joué avec son double moteur pour retomber sur une configuration similaire à celle des autres suites. Pour le test en mode normal, nous n’avons donc conservé que le moteur le plus rapide. Pour le test en mode maximal, nous avons réactivé les deux. Et comme on peut le constater, le second moteur a fait progresser sa détection de façon significative. Chez Kaspersky aussi, la mise en œuvre de l’heuristique en mode maximal a engendré un résultat significatif. Pour ces deux suites, nous encourageons donc les utilisateurs avancés à rentrer dans les réglages pour les pousser à leur maximum.

Panda et F-Secure ont détecté un échantillon de plus en mode maxi. En outre, les temps de scan étant relativement proches dans les deux modes, et la quantité de faux positifs (que nous avons mesurée hors tests) ne variant pas, il est là aussi intéressant de pousser les réglages. Les autres suites obtiennent le même résultat quel que soit le réglage adopté. Autant les conserver dans leur mode par défaut !

Nous tenons quand même à rappeler que les résultats de ce test ne signifient absolument pas que, dans la réalité, les utilisateurs auraient été en danger. Avec des protections connectées à leur serveur et des mises à jour réalisées plusieurs fois par jour automatiquement, les suites sont heureusement bien plus efficaces dans la réalité !

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.