De nombreux programmes constituent des fichiers de plusieurs gigas, des fichiers de stockage Outlook (PST et ODB), les fichiers vidéo (MKV, AVI, etc.) ou encore certains jeux (MPQ pour World of Warcraft par exemple).

Pour améliorer les performances de votre ordinateur, faites appel à Defraggler : il permet de mettre les fichiers trop gros en fin de disque.

Etape 1

Si ce n’est pas déjà fait, téléchargez Defraggler et installez-le. Une fois le logiciel lancé, rendez-vous dans Paramètres, puis Options.

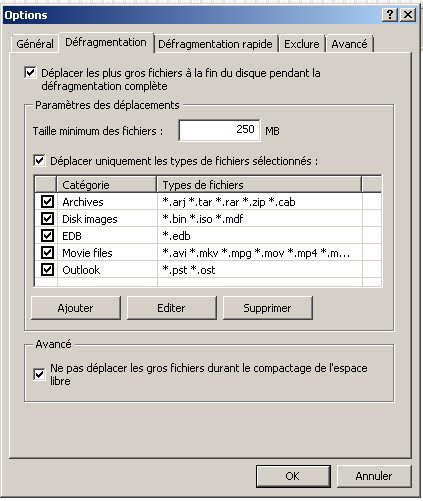

Dans le menu qui apparaît, cliquez sur l’onglet Défragmentation.

Vérifier que les options suivantes sont cochées :

– Déplacer les plus gros fichiers à la fin du disque pendant la défragmentation complète.

– Déplacer uniquement les types de fichiers sélectionnés.

La valeur par défaut de la Taille minimum des fichiers est réglée sur 250 Mo ce qui constitue un paramètre par défaut raisonnable, libre à vous de l’ajuster selon vos besoins.

Etape 2

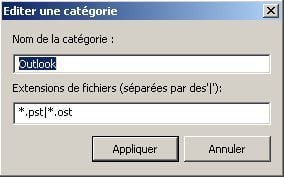

Cliquez sur Ajouter, puis donner un nom au type de fichier sélectionné, Outlook par exemple, pour des fichiers de stockage d’e-mail, puis dans le deuxième champ indiquez *.XXX ou XXX représente le type de fichier à placer en fin de disque. Le caractère * placé avant signifie que tous les fichiers de ce type seront placés à la fin du disque. Pour sélectionner un fichier précis, entrez directement le nom du fichier Ex : Mail_boulot.pst

Validez le type de fichier en cliquant sur Appliquer, puis fermer le menu en cliquant sur OK. Il ne vous reste plus qu’à lancer la défragmentation.

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.