Le Français Yann LeCun est directeur du laboratoire d’intelligence artificielle de Facebook. Il va tenir un séminaire jusqu’au 15 avril au Collège de France sur sa spécialité : l’apprentissage profond (Deep Learning). C’est un ensemble de méthodes permettant aux machines d’apprendre automatiquement et s’inspirant du fonctionnement des réseaux neuronaux. Nous avons pu l’interroger sur les récents événements qui ont marqué l’actualité de la recherche en intelligence artificielle lors d’une conférence de presse.

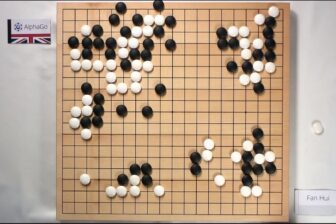

01net : Que pensez-vous de l’exploit de la start-up DeepMind, qui appartient à Google ? Leur algorithme AlphaGo a battu le champion européen de go. Ce résultat vous a-t-il pris de court, alors que vous planchiez aussi sur ce sujet chez Facebook ?

Yann LeCun : C’est un résultat impressionnant et du très bon travail. AlphaGo continue en ce moment même à s’améliorer en s’entraînant contre lui-même grâce à la technique de l’apprentissage renforcé qui est une spécialité de DeepMind.

Mais nous ne pouvons pas vraiment comparer nos démarches. Notre projet est tout petit, chez Facebook, et nous n’y avons alloué qu’une seule personne, alors qu’ils sont 20 ou 30 à plancher dessus chez DeepMind. Par ailleurs, cela ne veut pas dire qu’ils ont battu le meilleur joueur de Go : il ne s’agissait que du meilleur joueur européen, classé 633e au niveau mondial. On va voir maintenant ce que le match du mois de mars va donner contre le meilleur joueur mondial. Mais c’est loin d’être gagné.

Enfin, il y a une différence fondamentale de culture entre nos deux sociétés. Nous, nous avons mis en ligne notre logiciel et chacun peut l’évaluer. Deep Mind a préféré en garder le secret et publier un article sélectionné par un comité, puis en communiquant de façon spectaculaire.

C’est un peu ce que décrit Eric Raymond dans son pamphlet La cathédrale et le bazar. Il y a deux modèles de développement de logiciels. Celui de la cathédrale avec une petite équipe qui travaille en secret et attend patiemment que les résultats soient parfaits, et le modèle du bazar comme le système d’exploitation Linux, un projet de recherche collaboratif. De manière générale je crois beaucoup plus à l’efficacité du modèle du bazar. Les meilleurs logiciels sont open source. C’est notre culture, notre ADN chez Facebook. D’ailleurs mon chef, le directeur technique de Facebook Mike Schroepfer, vient de chez Mozilla.

Mais comment conciliez-vous votre intérêt de chercheur avec les enjeux commerciaux de Facebook ?

Si j’ai rejoint Facebook, c’est principalement parce que j’avais la possibilité de publier de façon ouverte. C’est important parce que je pense que la recherche progresse plus rapidement quand les scientifiques peuvent échanger. Plus la communauté de recherche est grande, plus le progrès est rapide. Il y a d’ailleurs très peu d’intérêt à être significativement en avance dans le domaine de la recherche pure, ce qui n’est pas le cas dans celui de la technologie où la compétition est frontale. Donc quand on écrit un article chez Facebook, on le met ensuite sur le site ouvert ArXiv.org.

Le deuxième avantage à cela, c’est que le chercheur sait qu’il va être soumis au jugement de ses pairs. Donc la rigueur de sa méthode et la qualité de sa publication vont s’en ressentir : les résultats seront plus fiables. Enfin, cela permet d’attirer davantage de talents si on leur garantit qu’ils pourront publier et cela sert aussi le prestige de l’entreprise.

Que pensez-vous des déclarations alarmistes d’Elon Musk au sujet des dérives possibles de l’intelligence artificielle ?

J’ai moi-même signé une lettre ouverte contre les armes offensives autonomes parce que le sujet prête peu à la controverse.

Mais je ne partage pas les opinions alarmistes d’Elon Musk. Vous allez voir qu’il ne fera bientôt plus ce genre de déclarations. J’en ai parlé plusieurs fois avec lui et je pense, même s’il a une personnalité difficile à cerner, qu’il y a une certaine duplicité chez lui. Il utilise les techniques actuelles d’intelligence artificielle pour le pilotage automatique de Tesla. Alors, bien sûr, il déclare que ces systèmes-là ne vont pas détruire l’humanité car ils ne sont faits que pour conduire !

Par ailleurs, il a rencontré, en tant qu’investisseur, des start-up qui promettent un peu la lune dans cinq ans. Il en a conclu que les progrès en intelligence artificielle étaient beaucoup plus rapides qu’on ne le pensait et qu’on aurait d’ici peu de temps des machines d’intelligence surhumaine. Mais il s’est trompé. Il a aussi probablement lu le livre Superintelligence du philosophe Nick Bostrom qui dépeint des scénarios catastrophiques. Ce dernier prend pour exemple des machines à qui l’on demande de fabriquer le plus grand nombre possible de trombones, et qui finissent par transformer tout, y compris les hommes, en trombone. On a déjà eu ce genre de peur avec le démarrage du génie génétique dont les dangers avaient été surévalués. C’est la même chose avec l’intelligence artificielle.

Mais n’y a-t-il pas tout de même des risques potentiels à construire une machine plus intelligente que l’homme ?

On est encore très loin de construire des machines intelligentes similaires ou supérieures à l’humain. Cela va prendre des décennies. Le danger n’est donc certainement pas immédiat, s’il y en a un. Et il ne serait pas aussi inévitable que des gens comme Nick Bostrom veulent bien le penser.

Les chercheurs réfléchissent déjà à la façon d’élaborer un comportement pré-programmé pour qu’elles n’accomplissent rien de problématique, en en gardant le contrôle en dernier recours, par exemple. C’est un problème technologique, pas philosophique. Et si l’on voulait les rendre totalement autonomes, il faudrait les construire de manière à ce que leurs pulsions ne soient pas dangereuses pour l’homme. Mais, évidemment, c’est difficile d’imaginer une intelligence qui ne soit par pourvue des défauts humains, puisque que c’est le seul exemple que l’on connaisse ..

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.