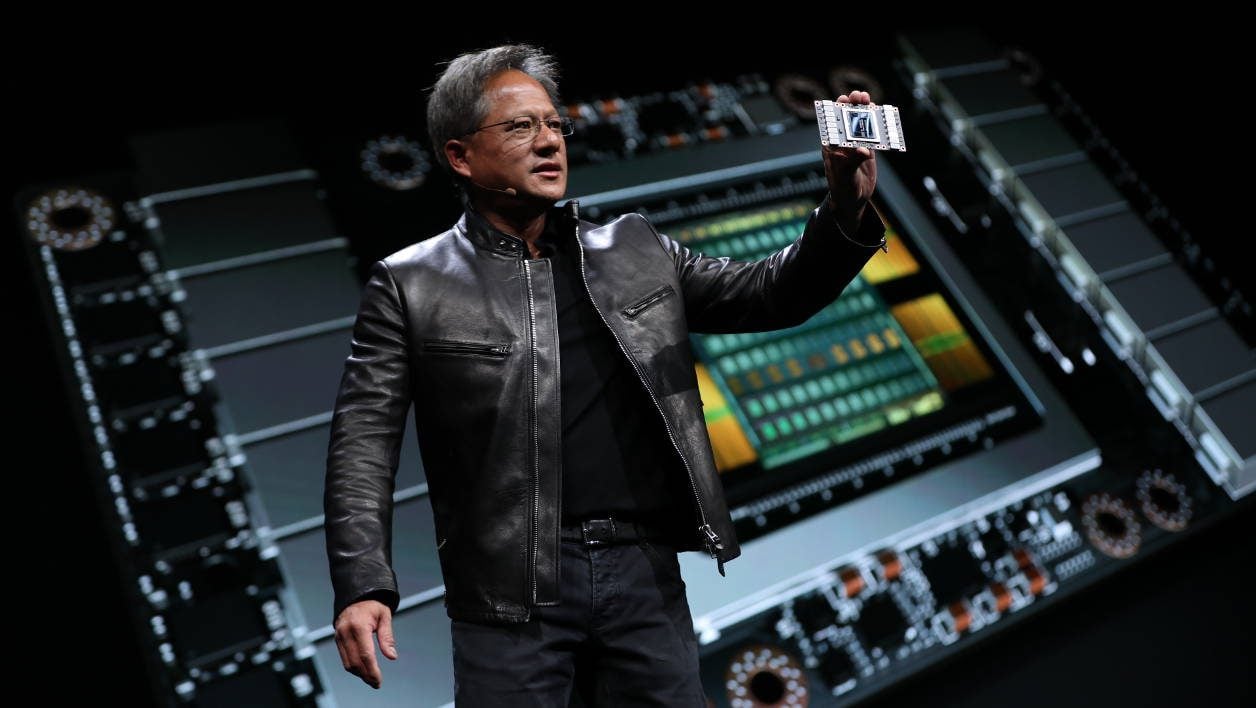

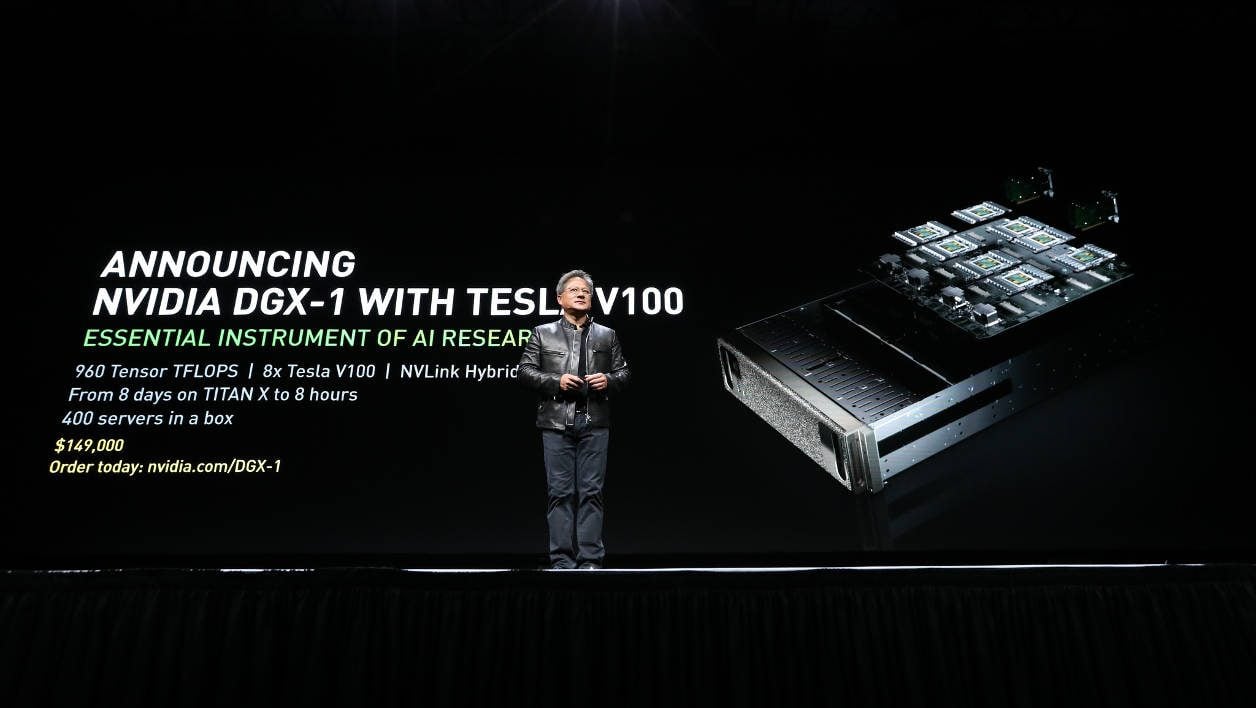

Lors de sa conférence GTC (GPU Technology Conference), Nvidia a enfin dévoilé sa première carte graphique basée sur sa toute nouvelle architecture, Volta. Elle sera toutefois pour l’instant réservée à la très professionnelle Tesla V100 et ne pourra être utilisée qu’au sein de gros serveurs ou stations de travail vendus entre 70 000 et 150 000 dollars.

Tesla V100 : IA, Deep Learning et Cloud Computing

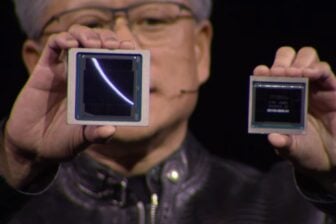

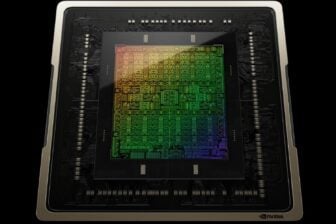

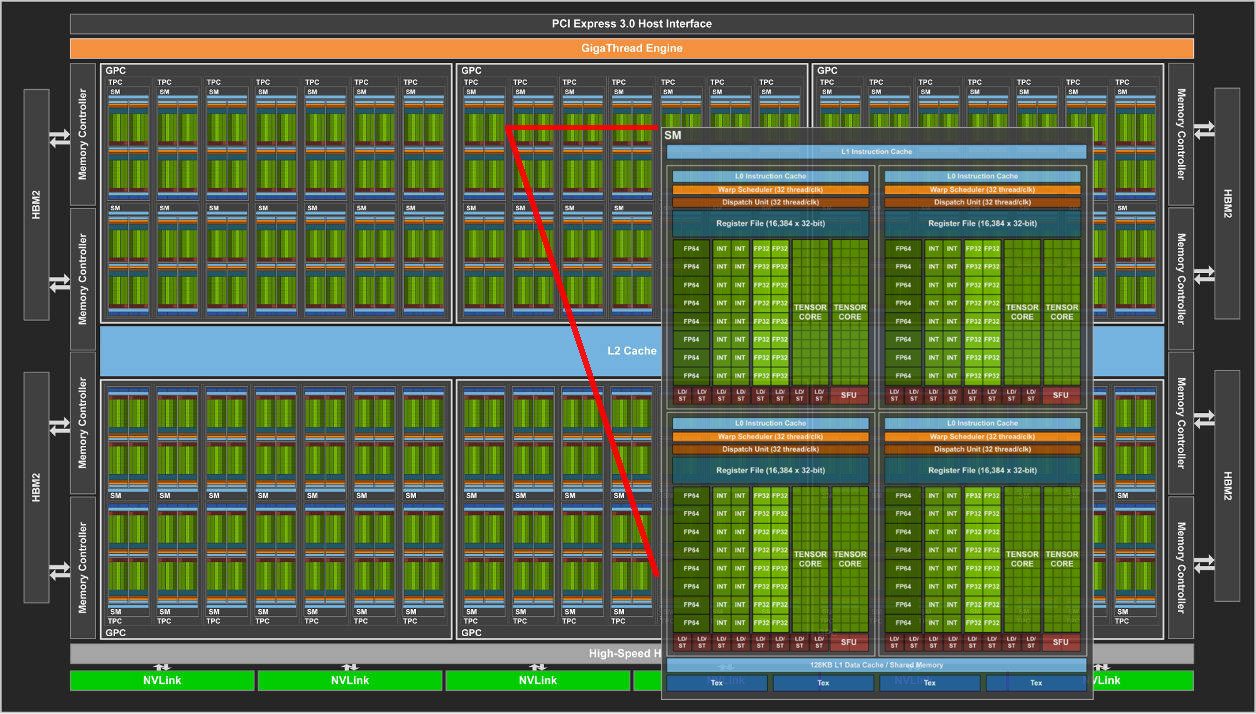

La Tesla V100, c’est d’abord et avant tout une des plus grosses puces jamais produites, et qui aurait coûté un peu plus de trois milliards de dollars de R&D à Nvidia. La puce gravée en 12 nm renferme 21 milliards de transistors sur une surface de 815 mm2. Pour comparaison, son aînée, la P100 embarquait “seulement” 15,3 milliards de transistors sur un die de 610 mm2…

La réduction de la finesse de gravure et l’augmentation de la taille de la puce permettent à Nvidia d’afficher une cascade de chiffres plus impressionnants les uns que les autres.

Ainsi, au sein de cette V100, s’agitent 5120 Cuda Cores, épaulés par 16 Go de mémoire HBM2 (bande passante de 900 Go/sec et interface de 4096 bits) pour une puissance de calcul graphique comprise entre 7,5 (double précision FP64) et 15 TFLOPS (simple précision FP32). Pour rappel, la Titan Xp -la carte la plus haut de gamme grand public actuelle- offre une puissance de calcul de 12 TFLOPS.

Bien entendu, il est possible de cumuler la puissance de plusieurs V100 et pour en tirer parti, Nvidia propose une nouvelle version de son interface (NVLink) permettant de faire dialoguer deux fois plus tant les GPU entre eux que les GPU avec les CPU. La question de l’accès mémoire, si important dans les applications deep learning reste encore en suspens.

Selon son géniteur, la TV100 ferait 5 fois mieux que son homologue Tesla actuel, basé sur l’architecture Pascal (celle des GTX 1080 par exemple), et serait capable d’offrir la puissance de calcul de 100 processeurs haut de gamme d’ordinateurs classiques. Une paille !

Des coeurs pour l’intelligence artificielle

Preuve que la Tesla V100 n’a rien à faire dans nos PC de joueurs, la puce embarque aussi une nouveauté, des Tensor Core (640), des unités de calcul spécialisées dans la mise en oeuvre de réseaux neuronaux pour entraîner des intelligences artificielles.

En clair, les V100 sont pensées pour faire tourner de manière optimale les différentes plates-formes qui sous-tendent le deep learning, on pense notamment à TensorFlow, à MXnet ou à Caffe2. Ces Tensor Core, hyper spécialisés, permettent le traitement bien plus rapide des layers algorithmiques, spécifiques de l’apprentissage profond. Autrement dit, ils traitent bien plus vite chaque étape de l’apprentissage d’une IA. Et comme Nvidia est agnostique en matière de frameworks supportés, ce gain est disponible tant dans le domaine médical, que celui de la recherche, de l’ingénierie de pointe, ou encore des transports autonomes.

La puissance cumulée des Tensor Core et des Cuda Core atteindraient 120 TFLOPS (Mixed Precision FP16I et FP32) quand il s’agit d’effectuer des calculs relatifs au Deep Learning.

Une solution de calcul ultrapuissante qui intéresse évidemment Amazon, Facebook, Baidu, Microsoft ou encore Google. Des représentants de la société de Jeff Bezos et du géant de Redmond sont ainsi montés sur scène lors de la keynote d’ouverture du patron de Nvidia, Jensen Huang, pour prêter allégeance à cette solution.

Mais ceux qui n’ont pas eu droit à la lumière de la scène n’en étaient pas moins omniprésents dans les couloirs du Convention Center de San José, preuve que Nvidia est bien au coeur de la révolution de l’intelligence artificielle.

On comprend facilement cet engouement des géants de la high tech et du Web. Selon Jensen Huang, un seul serveur DGX-1V de Nvidia (150 000 dollars), qui embarque huit exemplaires de la puce Tesla V100, serait capable de remplacer 400 serveurs actuels. L’économie aussi bien en matière d’infrastructure que d’énergie serait alors colossale. D’autant que ce serveur serait capable de délivrer une puissance de calcul telle que les opérations qui prenaient 8 jours sur 8 Titan X ne prendraient plus que 8 heures avec le même nombre de Tesla V100.

Dans un domaine aussi compétitif que l’intelligence artificielle où le temps et les bras manquent, l’argument est considérable. Il est donc fort probable que l’avenir de la Tesla V100 soit radieux.

Plus près de nous

Si la révolution de l’IA a évidemment des répercussions directes sur notre quotidien, tout cela reste assez lointain et parfois vaporeux. Mais derrière cette avalanche de puissance, il ne faut pas oublier que se prépare l’avenir de nos PC de jeux.

Si Nvidia respecte son rythme habituel, Volta ne devrait pas arriver dans nos tours avant l’année prochaine (au mieux). Une chose est certaine, les futures déclinaisons GeForce GTX de cette puce pourraient être, elles aussi, monstrueuses.

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.