A de nombreuses reprises, Facebook a dû s’expliquer sur la suppression de contenus, qu’il s’agisse de la photo d’une petite fille brûlée lors de la guerre du Vietnam ou – dans un tout autre contexte – du tableau L’Origine du monde de Gustave Courbet. A l’inverse, le réseau social a bien du mal à faire face à la violence de certaines vidéos en direct. Le journal britannique The Guardian a mis la main sur plus d’une centaine de documents internes à destination des modérateurs. Facebook y explique clairement les règles à suivre dans les cas de violence ou de propos menaçants.

La violence «d’intérêt public»

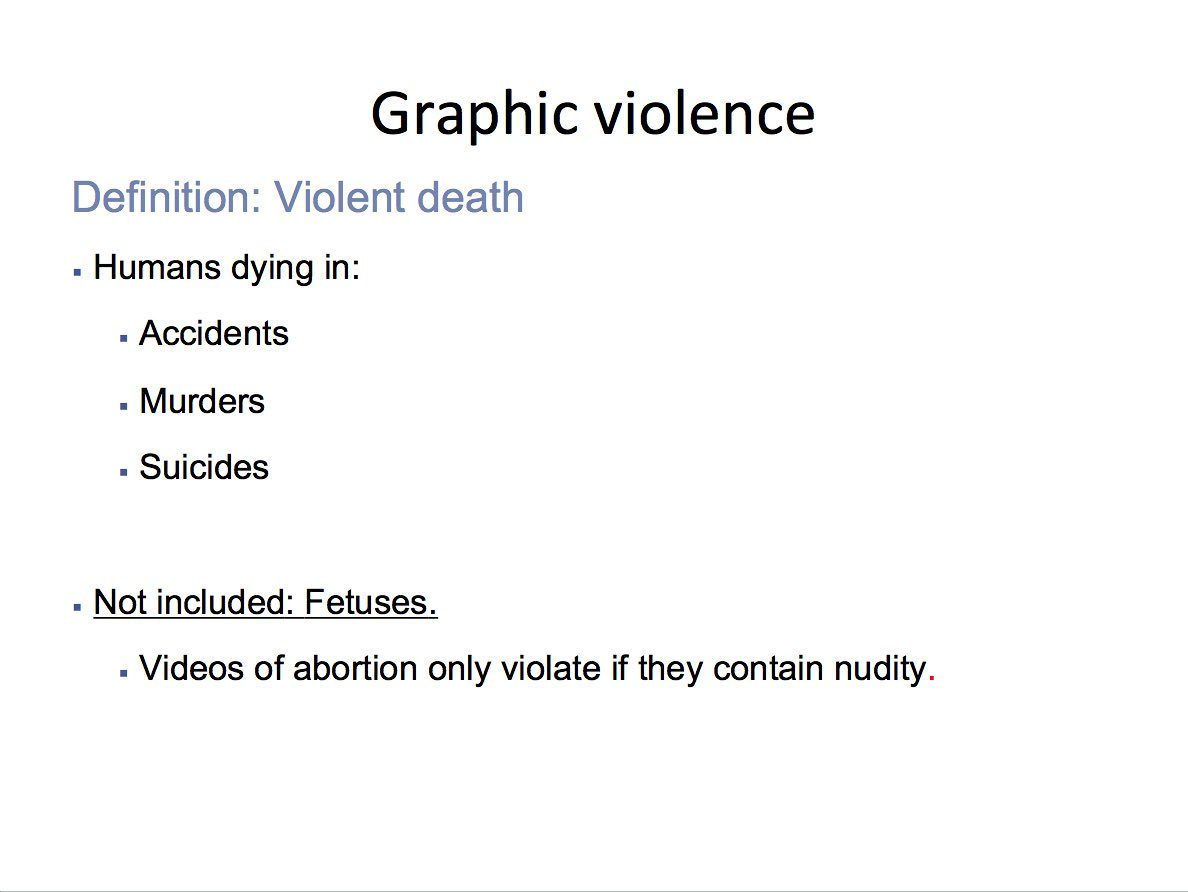

Dans l’un des documents, Facebook évoque le cas des images violentes. On y apprend que les modérateurs doivent censurer les photos et vidéos violentes si elles sont accompagnées de commentaires sadiques ou célébrant la mort d’un individu. Ils doivent également supprimer les vidéos d’accidents mortels, de meurtres ou de suicides. Les vidéos d’avortements peuvent en revanche rester en ligne, sauf si «elles contiennent de la nudité». Parmi les autres contenus jugés acceptables, le soutien à la peine de mort ou les réjouissances concernant une condamnation à mort.

Pour Facebook, toutes les vidéos violentes n’ont donc pas à être supprimées. Au contraire, les documents stipulent qu’elles peuvent parfois aider à des prises de conscience. Plutôt que de les censurer, l’entreprise préfère protéger les mineurs ainsi que tous ceux qui ne désireraient pas les voir. Les vidéos concernées sont précédées de mentions précisant leur nature, avec une interdiction aux moins de 18 ans. Dans ces conditions, la lecture automatique est désactivée.

La maltraitance des enfants peu censurée

Dans un autre document, Facebook aborde la question de la maltraitance des enfants. Là encore, le site est loin de bannir tous les contenus. Dans les faits, seules les photos et vidéos célébrant la maltraitance d’enfants sont systématiquement supprimées. Celles qui montrent un enfant frappé, brûlé ou étranglé par un adulte sont en revanche précédées d’une mention spécifique. Selon Facebook, le but est de pouvoir venir en aide à l’enfant en maintenant en ligne des images permettant de l’identifier.

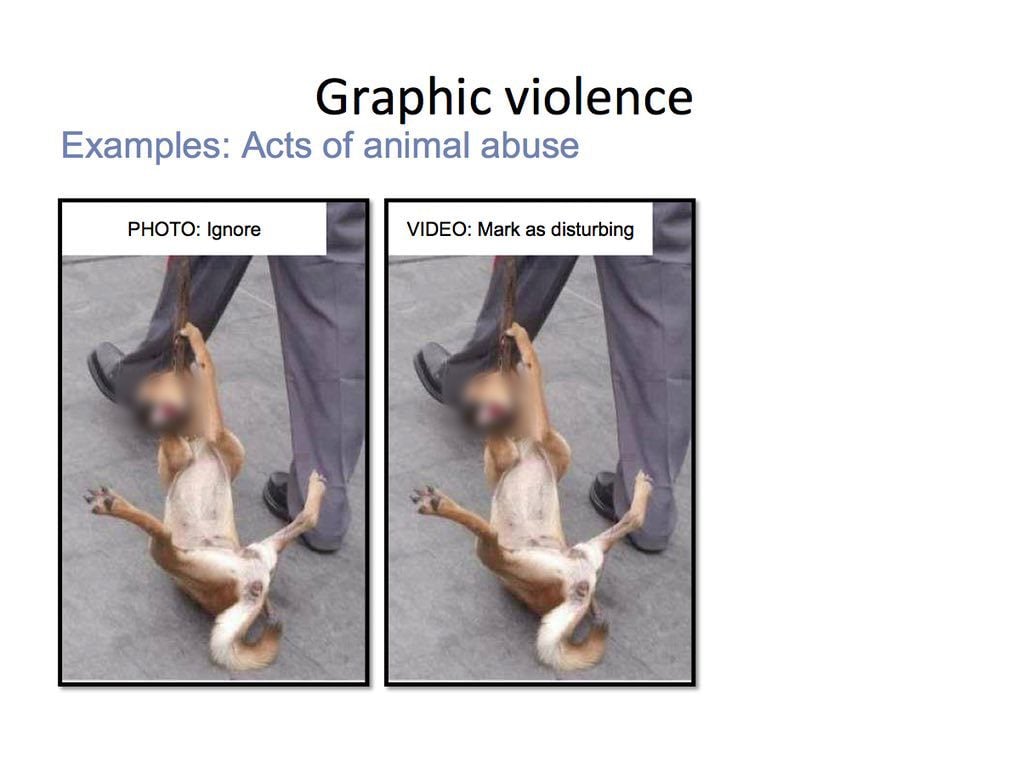

Cette politique s’applique également à la violence faite aux animaux. Dans les documents fournis aux modérateurs, on peut lire que «les images d’abus envers les animaux peuvent généralement être partagées sur le site», bien que les contenus les plus dérangeants soient précédés d’une mention spécifique et que les restrictions concernant le sadisme et la célébration de la violence s’appliquent. Facebook fait toutefois la différence entre photos et vidéos. Une image fixe sera précédée d’une mention spéciale uniquement s’il s’agit d’une «mutilation». La photo d’un chien roué de coups ne sera donc pas concernée par une éventuelle modération, tandis qu’une vidéo le sera.

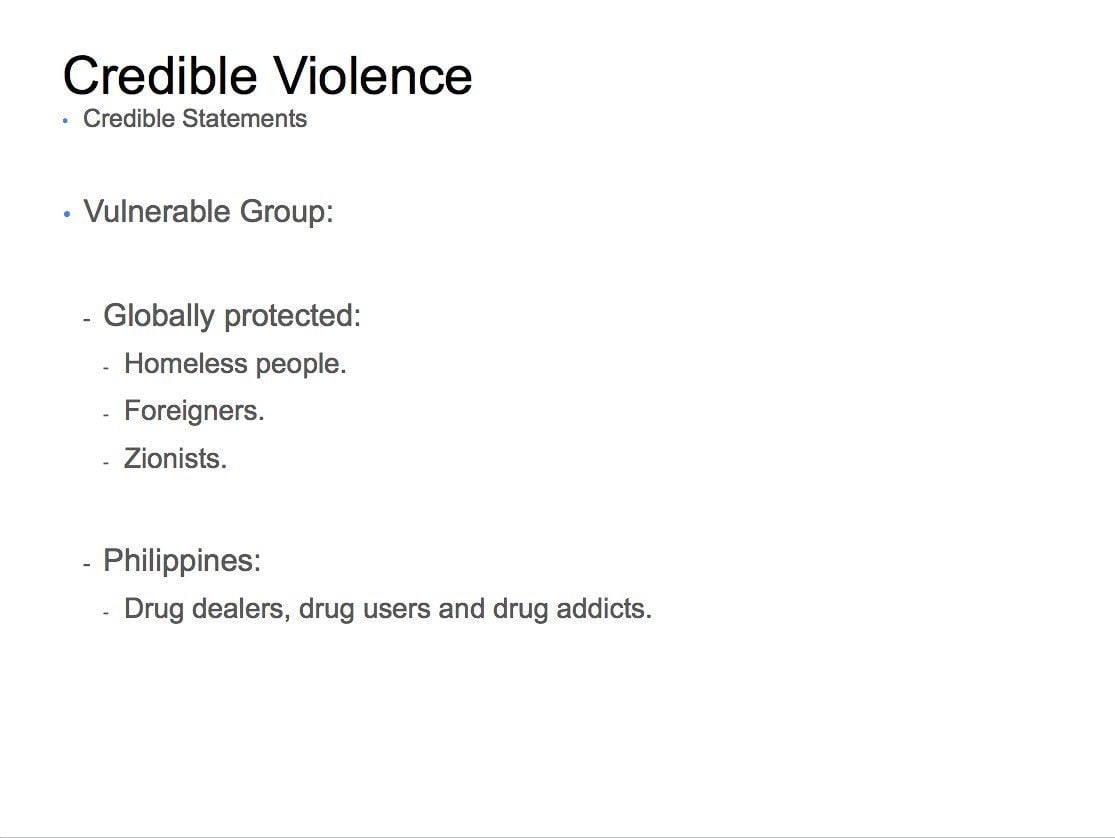

Menaces : Donald Trump protégé, pas les roux

Les documents internes abordent la question des menaces à l’encontre de certains membres. Facebook demande à ses modérateurs de supprimer tout contenu visant explicitement une «personne ou un groupe vulnérable». Parmi les utilisateurs concernés, Facebook évoque les dirigeants politiques, les individus déjà menacés d’assassinat, les activistes ou les journalistes. Le document donne quelques exemples de «groupes vulnérables», incluant «les sans-abris», «les étrangers» ou «les sionistes».

Comme cela avait déjà été évoqué dans une première fuite datant de 2012, Facebook se concentre davantage sur des menaces ciblées que sur des propos plus généraux. «Les gens expriment souvent leur mépris ou leurs désaccords par des menaces ou des appels à la violence qui ne sont pas sérieux dans la majorité des cas» peut-on lire dans l’un des documents. Une publication appelant au meurtre de Donald Trump sera par exemple supprimée, contrairement à un message appelant à «frapper un roux» ou «un enfant en surpoids».

Les documents révélés par The Guardian sont une nouvelle preuve de la difficulté du réseau social à modérer les contenus provenant de près de deux milliards d’internautes. Pour travailler plus efficacement, Mark Zuckerberg a récemment annoncé l’embauche de 3.000 personnes, qui viendront s’ajouter aux 4.500 modérateurs déjà en poste.

Mais l’impressionnante quantité de procédures nécessaires aux équipes de Facebook est à mettre en parallèle avec le temps dont ils bénéficient pour faire un choix : une dizaine de secondes, selon le média anglais. Un rythme difficilement tenable, qui peut parfois générer d’importantes souffrances psychologiques. La complexité des consignes de Facebook montre surtout que le géant américain est condamné à surfer dans une zone grise.

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.